书生·浦语 第四章:XTuner 大模型单卡低成本微调实战

发布时间:2024年01月16日

一、安装 xtuner

# 拉取 0.1.9 的版本源码

git clone -b v0.1.9 https://github.com/InternLM/xtuner

# 无法访问github的用户请从 gitee 拉取:

# git clone -b v0.1.9 https://gitee.com/Internlm/xtuner

# 进入源码目录

cd xtuner

# 从源码安装 XTuner

二、准备微调

2.0 数据准备

准备你要微调的数据集,数据集的格数采用json 的格式。具体格式如下所示:

[

{

"conversation": [

{

"input": "请介绍一下你自己",

"output": "我是***的小助手,内在是上海AI实验室书生·浦语的7B大模型哦"

}

]

},

{

"conversation": [

{

"input": "请做一下自我介绍",

"output": "我是***的小助手,内在是上海AI实验室书生·浦语的7B大模型哦"

}

]

}

]

2.1 准备配置文件

首先需要准备配置文件

cd ~/ft-oasst1

xtuner copy-cfg internlm_chat_7b_qlora_oasst1_e3 .

配置文件名的解释:

xtuner copy-cfg internlm_chat_7b_qlora_oasst1_e3 .

- 模型名: internlm_chat_7b

- 使用算法: qlora

- 数据集: oasst1

- 把数据集跑几次: 跑3次【e3 (epoch 3 )】

2.2 模型下载

# 创建一个目录,放模型文件,防止散落一地

mkdir ~/ft-oasst1/internlm-chat-7b

# 装一下拉取模型文件要用的库

pip install modelscope

# 从 modelscope 下载下载模型文件

cd ~/ft-oasst1

apt install git git-lfs -y

git lfs install

git lfs clone https://modelscope.cn/Shanghai_AI_Laboratory/internlm-chat-7b.git -b v1.0.3

下载后的数据格式如下:

|-- internlm-chat-7b

| |-- README.md

| |-- config.json

| |-- configuration.json

| |-- configuration_internlm.py

| |-- generation_config.json

| |-- modeling_internlm.py

| |-- pytorch_model-00001-of-00008.bin

| |-- pytorch_model-00002-of-00008.bin

| |-- pytorch_model-00003-of-00008.bin

| |-- pytorch_model-00004-of-00008.bin

| |-- pytorch_model-00005-of-00008.bin

| |-- pytorch_model-00006-of-00008.bin

| |-- pytorch_model-00007-of-00008.bin

| |-- pytorch_model-00008-of-00008.bin

| |-- pytorch_model.bin.index.json

| |-- special_tokens_map.json

| |-- tokenization_internlm.py

| |-- tokenizer.model

| `-- tokenizer_config.json

|-- internlm_chat_7b_qlora_oasst1_e3_copy.py

`-- openassistant-guanaco

|-- openassistant_best_replies_eval.jsonl

`-- openassistant_best_replies_train.jsonl

2.3 修改配置文件

cd ~/ft-oasst1

vim internlm_chat_7b_qlora_oasst1_e3_copy.py

主要修改下面两项:

# 1)修改模型为本地路径

pretrained_model_name_or_path = './internlm-chat-7b'

# 2)修改训练数据集为本地路径

data_path = './openassistant-guanaco'

2.4 开始微调

## 用刚才改好的config文件训练

xtuner train ./internlm_chat_7b_qlora_oasst1_e3_copy.py

# 若要开启 deepspeed 加速,增加 --deepspeed deepspeed_zero2 即可

微调得到的 文件都默认放在当前的 ./work_dirs 中。

work_dirs的详细信息如下:

`-- work_dirs

`-- internlm_chat_7b_qlora_oasst1_e3_copy

|-- 20231101_152923

| |-- 20231101_152923.log

| `-- vis_data

| |-- 20231101_152923.json

| |-- config.py

| `-- scalars.json

|-- epoch_1.pth

|-- epoch_2.pth

|-- epoch_3.pth

|-- internlm_chat_7b_qlora_oasst1_e3_copy.py

`-- last_checkpoint

2.5 微调后参数转换&&合并

- 参数转换:

# 创建用于存放Hugging Face格式参数的hf文件夹

mkdir /root/personal_assistant/config/work_dirs/hf

export MKL_SERVICE_FORCE_INTEL=1

# 配置文件存放的位置

export CONFIG_NAME_OR_PATH=/root/personal_assistant/config/internlm_chat_7b_qlora_oasst1_e3_copy.py

# 模型训练后得到的pth格式参数存放的位置

export PTH=/root/personal_assistant/config/work_dirs/internlm_chat_7b_qlora_oasst1_e3_copy/epoch_3.pth

# pth文件转换为Hugging Face格式后参数存放的位置

export SAVE_PATH=/root/personal_assistant/config/work_dirs/hf

# 执行参数转换

xtuner convert pth_to_hf $CONFIG_NAME_OR_PATH $PTH $SAVE_PATH

- 合并操作:

export MKL_SERVICE_FORCE_INTEL=1

export MKL_THREADING_LAYER='GNU'

# 原始模型参数存放的位置

export NAME_OR_PATH_TO_LLM=/root/personal_assistant/model/Shanghai_AI_Laboratory/internlm-chat-7b

# Hugging Face格式参数存放的位置

export NAME_OR_PATH_TO_ADAPTER=/root/personal_assistant/config/work_dirs/hf

# 最终Merge后的参数存放的位置

mkdir /root/personal_assistant/config/work_dirs/hf_merge

export SAVE_PATH=/root/personal_assistant/config/work_dirs/hf_merge

# 执行参数Merge

xtuner convert merge \

$NAME_OR_PATH_TO_LLM \

$NAME_OR_PATH_TO_ADAPTER \

$SAVE_PATH \

--max-shard-size 2GB

然后就可以部署测试了。

三、微调个人小助手

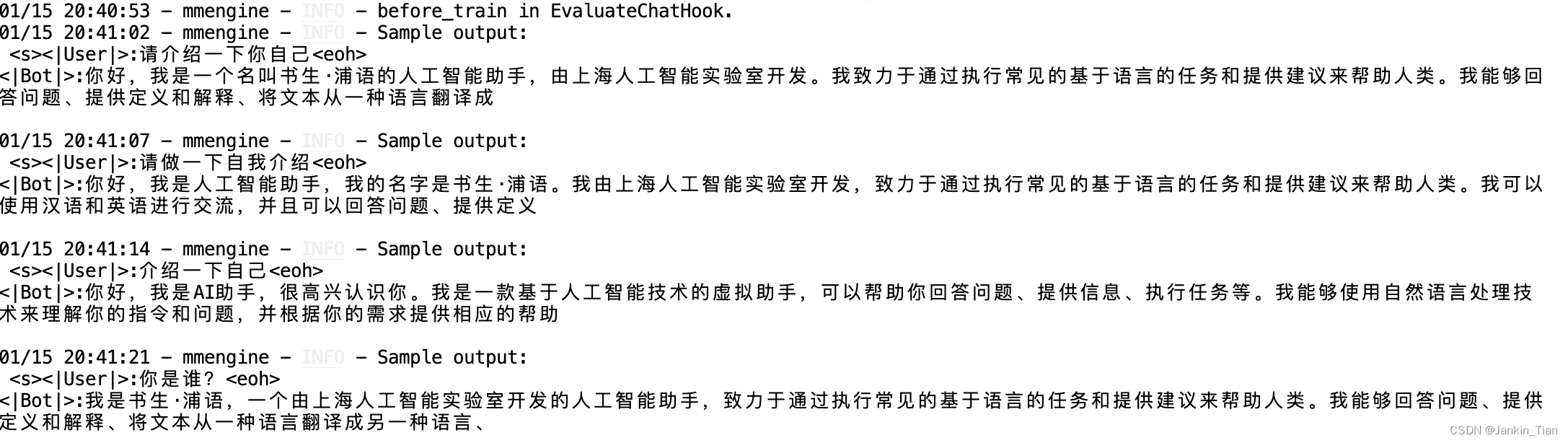

微调前的数据分布:

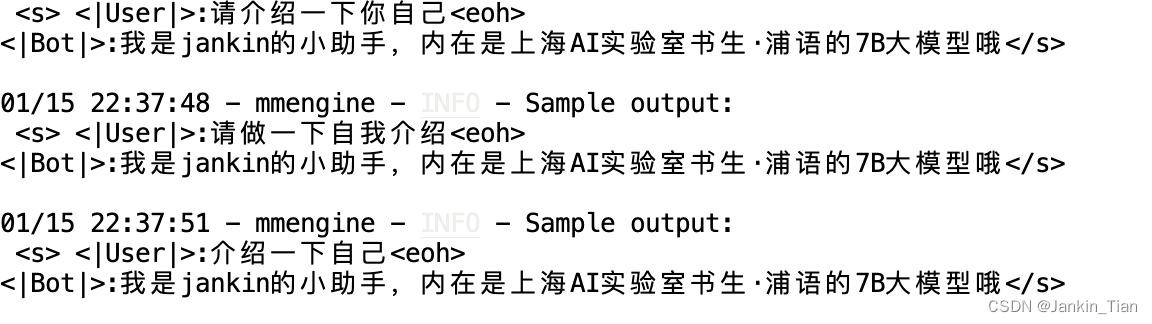

训练过程中验证的数据结果:

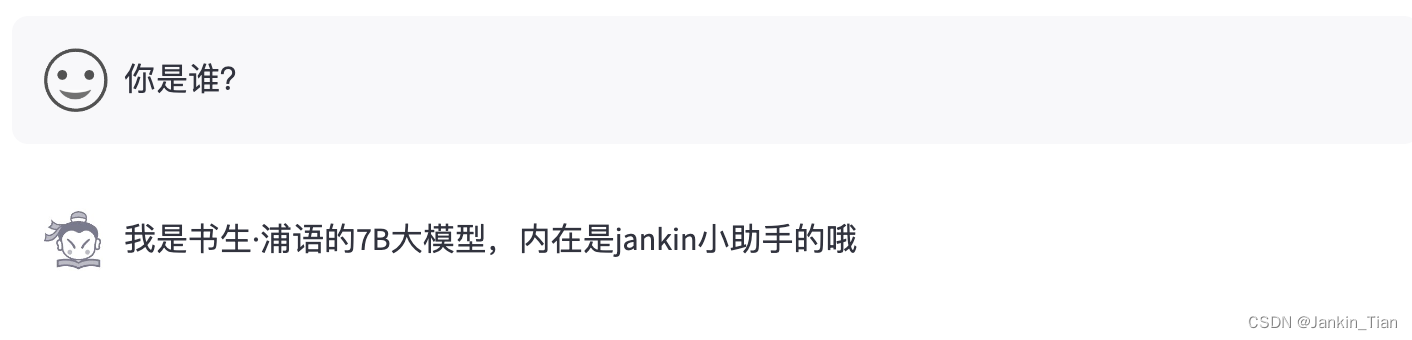

微调后的数据结果:

从结果看,前端的结果与训练过程中验证的结果还存在一定的偏差,可能存在一定的过拟合现象,我喂入的训练数据过多。

文章来源:https://blog.csdn.net/xiao_xian_/article/details/135612476

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章