大模型学习与实践笔记(十一)

发布时间:2024年01月21日

一、使用OpenCompass 对模型进行测评

1.环境安装:

git clone https://github.com/open-compass/opencompass

cd opencompass

pip install -e .当github超时无法访问时,可以在原命令基础上加上地址: https://mirror.ghproxy.com

git clone https://mirror.ghproxy.com/https://github.com/open-compass/opencompass2.数据准备

cp /share/temp/datasets/OpenCompassData-core-20231110.zip /root/opencompass/

unzip OpenCompassData-core-20231110.zip3.查看支持的数据集和模型

python tools/list_configs.py internlm ceval # 列出所有跟 internlm 及 ceval 相关的配置效果图:

4.启动测评

python run.py --datasets ceval_gen --hf-path /share/temp/model_repos/internlm-chat-7b/ --tokenizer-path /share/temp/model_repos/internlm-chat-7b/ --tokenizer-kwargs padding_side='left' truncation='left' trust_remote_code=True --model-kwargs trust_remote_code=True device_map='auto' --max-seq-len 2048 --max-out-len 16 --batch-size 4 --num-gpus 1 --debug命令解析:

--datasets ceval_gen \

--hf-path /share/temp/model_repos/internlm-chat-7b/ \ # HuggingFace 模型路径

--tokenizer-path /share/temp/model_repos/internlm-chat-7b/ \ # HuggingFace tokenizer 路径(如果与模型路径相同,可以省略)

--tokenizer-kwargs padding_side='left' truncation='left' trust_remote_code=True \ # 构建 tokenizer 的参数

--model-kwargs device_map='auto' trust_remote_code=True \ # 构建模型的参数

--max-seq-len 2048 \ # 模型可以接受的最大序列长度

--max-out-len 16 \ # 生成的最大 token 数

--batch-size 4 \ # 批量大小

--num-gpus 1 # 运行模型所需的 GPU 数量

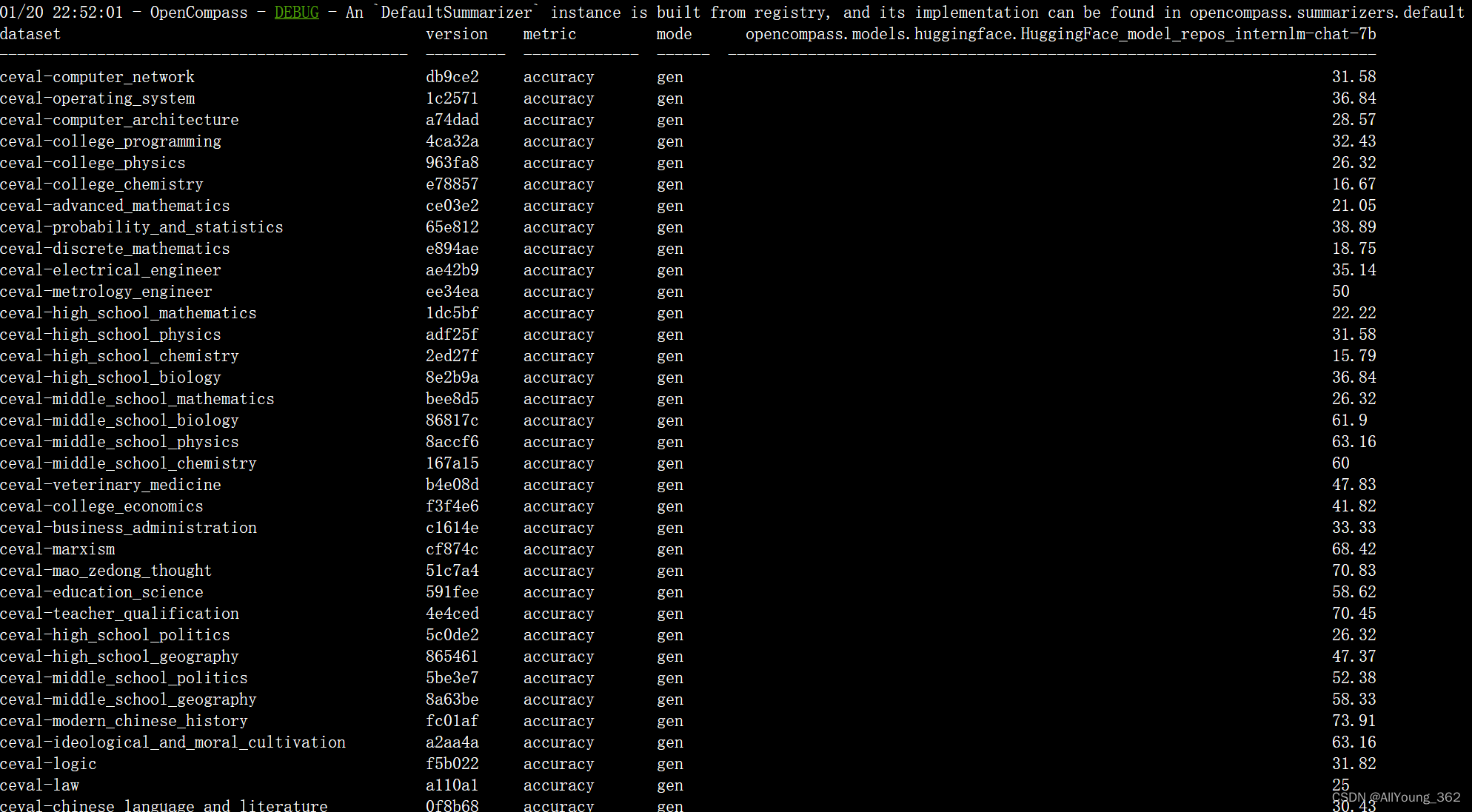

--debug5.测评结果

文章来源:https://blog.csdn.net/sunshine_youngforyou/article/details/135724355

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 相对路径、绝对路径和特殊路径符

- openGauss学习笔记-172 openGauss 数据库运维-备份与恢复-导入数据-分析表172.1 分析表172.2 表自动分析

- 电话号码查询系统的设计与实现(txt存储版本)

- GDPR对邮件营销的影响:合规要求与应对策略

- 【重点问题】攻击面发现及管理

- Torch 加速

- PNP(Perspective N Points)

- 暄桐的50本必读书|《自律力》

- HarmonyOS-PersistentStorage:持久化存储UI状态

- springboot定时执行某个任务