【LangChain学习之旅】—(10) 用RouterChain确定客户意图

发布时间:2024年01月24日

任务设定

首先,还是先看一下今天要完成一个什么样的任务。

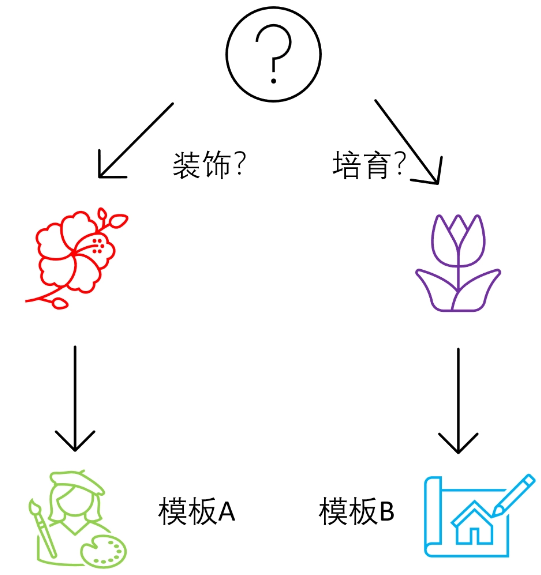

这里假设咱们的鲜花运营智能客服 ChatBot 通常会接到两大类问题。

- 鲜花养护(保持花的健康、如何浇水、施肥等)

- 鲜花装饰(如何搭配花、如何装饰场地等)

你的需求是,如果接到的是第一类问题,你要给 ChatBot A 指示;如果接到第二类的问题,你要给 ChatBot B 指示。

我们可以根据这两个场景来构建两个不同的目标链。遇到不同类型的问题,LangChain 会通过 RouterChain 来自动引导大语言模型选择不同的模板。

当然我们的运营过程会遇到更多种类的问题,你只需要通过同样的方法扩充逻辑即可。

整体框架

RouterChain,也叫路由链,能动态选择用于给定输入的下一个链。我们会根据用户的问题内容,首先使用路由器链确定问题更适合哪个处理模板,然后将问题发送到该处理模板进行回答。如果问题不适合任何已定义的处理模板,它会被发送到默认链。

在这里,我们会用 LLMRouterChain 和 MultiPromptChain(也是一种路由链)组合实现路由功能,该 MultiPromptChain 会调用 LLMRouterChain 选择与给定问题最相关的提示,然后使用该提示回答问题。

具体步骤如下:

- 构建处理模板:为鲜花护理和鲜花装饰分别定义两个字符串模板。

- 提示信息:使用一个列表来组织和存储这两个处理模板的关键信息,如模板的键、描述和实际内容。

- 初始化语言模型:导入并实例化语言模型。

- 构建目标链:根据提示信息中的每个模板构建了对应的 LLMChain,并存储在一个字典中。

- 构建 LLM 路由链:这是决策的核心部分。首先,它根据提示信息构建了一个路由模板,然后使用这个模板创建了一个 LLMRouterChain。

- 构建默认链:如果输入不适合任何已定义的处理模板,这个默认链会被触发。

- 构建多提示链:使用 MultiPromptChain 将 LLM 路由链、目标链和默认链组合在一起,形成一个完整的决策系统。

具体实现

下面,就是用路由链自动选择处理模板的具体代码实现。

构建提示信息的模板

首先,我们针对两种场景,构建两个提示信息的模板。

# 构建两个场景的模板

flower_care_template = """你是一个经验丰富的园丁,擅长解答关于养花育花的问题。

下面是需要你来回答的问题:

{input}"""

flower_deco_template = """你是一位网红插花大师,擅长解答关于鲜花装饰的问题。

下面是需要你来回答的问题:

{input}"""

# 构建提示信息

prompt_infos = [

{

"key": "flower_care",

"description": "适合回答关于鲜花护理的问题",

"template": flower_care_template,

},

{

"key": "flower_decoration",

"description": "适合回答关于鲜花装饰的问题",

"template": flower_deco_template,

}]

构建目标链

下面,我们循环 prompt_infos 这个列表,构建出两个目标链,分别负责处理不同的问题。

# 构建目标链

from langchain.chains.llm import LLMChain

from langchain.prompts import PromptTemplate

chain_map = {}

for info in prompt_infos:

prompt = PromptTemplate(template=info['template'],

input_variables=["input"])

print("目标提示:\n",prompt)

chain = LLMChain(llm=llm, prompt=prompt,verbose=True)

chain_map[info["key"]] = chain

文章来源:https://blog.csdn.net/weixin_56462041/article/details/135826566

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!