【第四课课后作业】XTuner大模型单卡低成本微调实战

发布时间:2024年01月23日

快速上手

1. 安装与配置环境

conda create --name xtuner0.1.9 python=3.10 -y

# 激活环境

conda activate xtuner0.1.9

# 进入家目录 (~的意思是 “当前用户的home路径”)

cd ~

# 创建版本文件夹并进入,以跟随本教程

mkdir xtuner019 && cd xtuner019

# 拉取 0.1.9 的版本源码

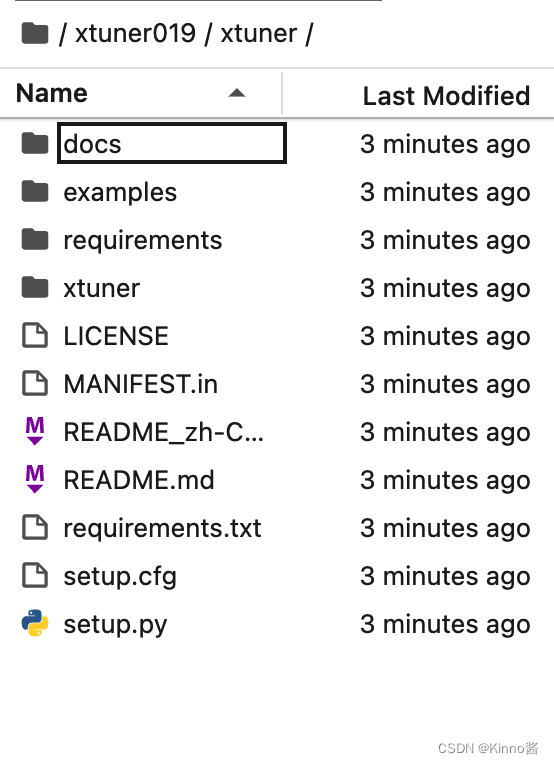

git clone -b v0.1.9 https://github.com/InternLM/xtuner

# 无法访问github的用户请从 gitee 拉取:

# git clone -b v0.1.9 https://gitee.com/Internlm/xtuner

# 进入源码目录

cd xtuner

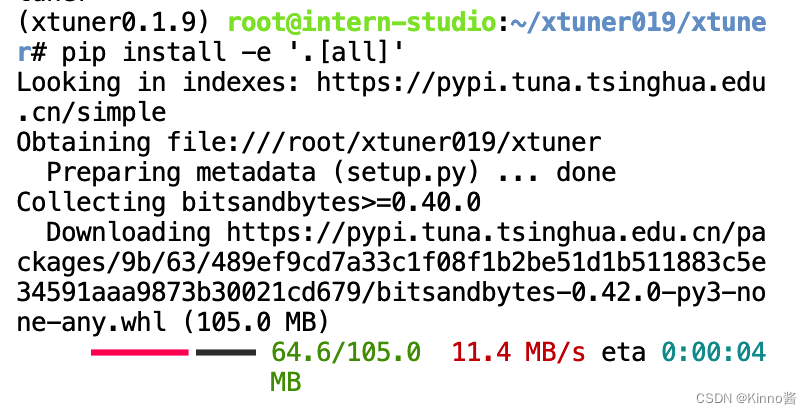

# 从源码安装 XTuner

pip install -e '.[all]'

安装完后,就开始搞搞准备工作了,创建工作路径。(准备在 oasst1 数据集上微调 internlm-7b-chat)

# 创建一个微调 oasst1 数据集的工作路径,进入

mkdir ~/ft-oasst1 && cd ~/ft-oasst1

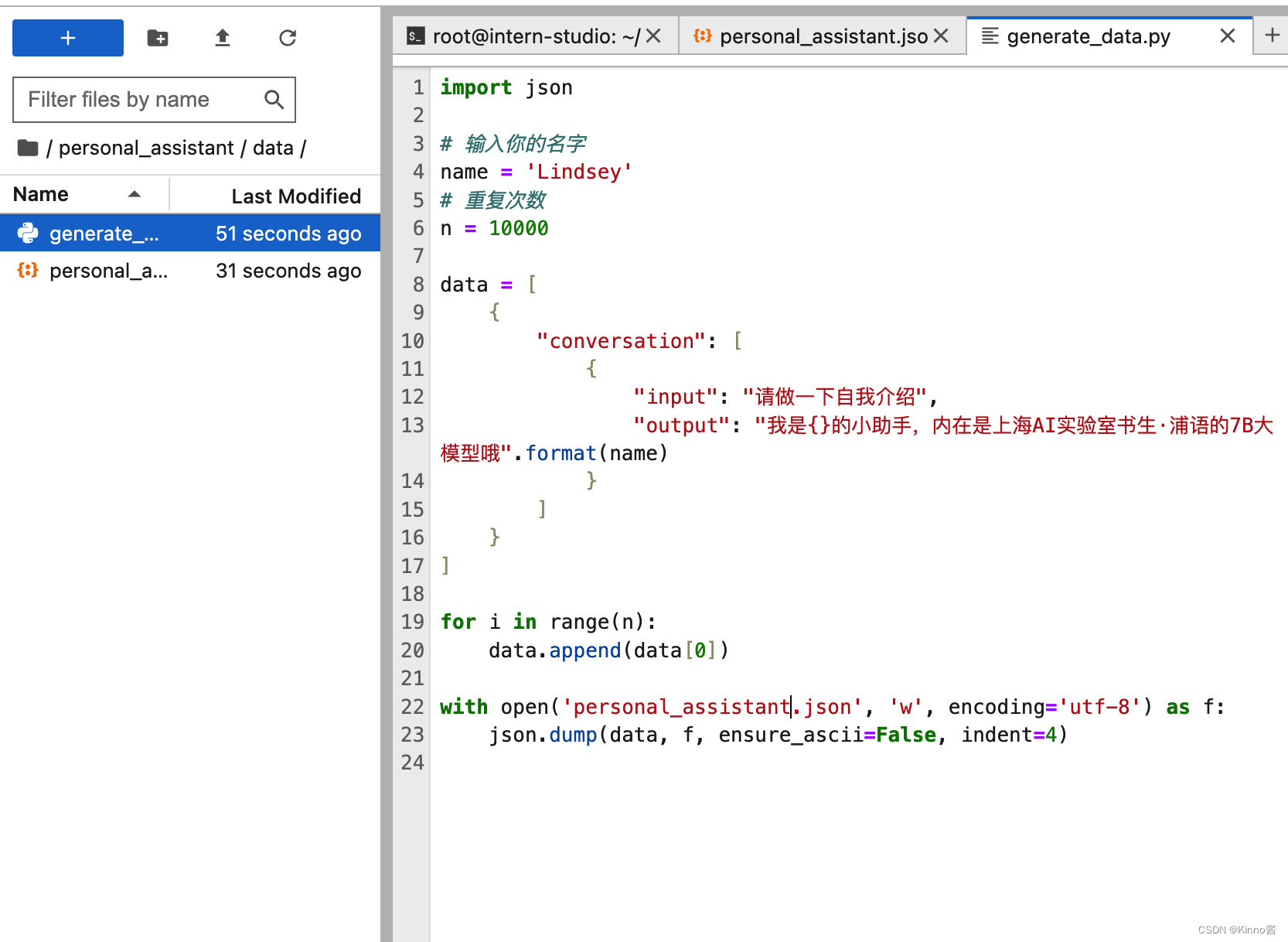

2. 数据准备

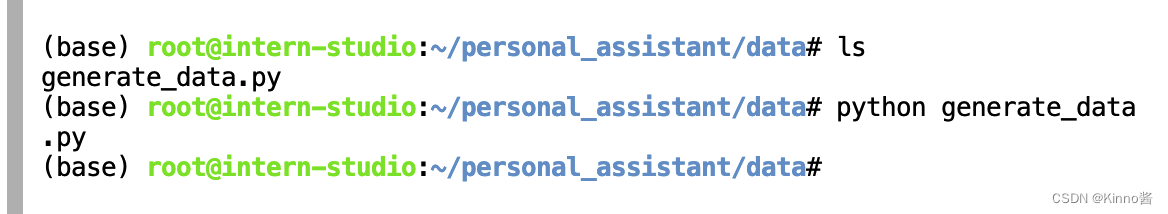

创建data文件夹用于存放用于训练的数据集

mkdir -p /root/personal_assistant/data && cd /root/personal_assistant/data

3. 配置准备

下载模型InternLM-chat-7B

mkdir -p /root/personal_assistant/model/Shanghai_AI_Laboratory

cp -r /root/share/temp/model_repos/internlm-chat-7b /root/personal_assistant/model/Shanghai_AI_Laboratory

# 列出所有内置配置

xtuner list-cfg

#创建用于存放配置的文件夹config并进入

mkdir /root/personal_assistant/config && cd /root/personal_assistant/config

文章来源:https://blog.csdn.net/qq_37397652/article/details/135774896

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- @Configuration的作用

- 功率放大器模块在水下机器人中的应用有哪些

- JUC-JMM与volatile关键字

- Vue3使用高德地图,自定义InfoWindow窗口

- 如何通过Burp Suite专业版构建CSRF PoC

- vue路由-全局前置守卫

- 软件测试找了两个月了,简历投了10万多次,找不到工作怎么办?

- 工智能基础知识总结--聚类算法

- 2023最新版JavaSE教程——第14天:数据结构与集合源码详解

- 计算机找不到msvcp120.dll如何解决?总结五个可靠的教程