如何快速下载huggingface模型

发布时间:2023年12月28日

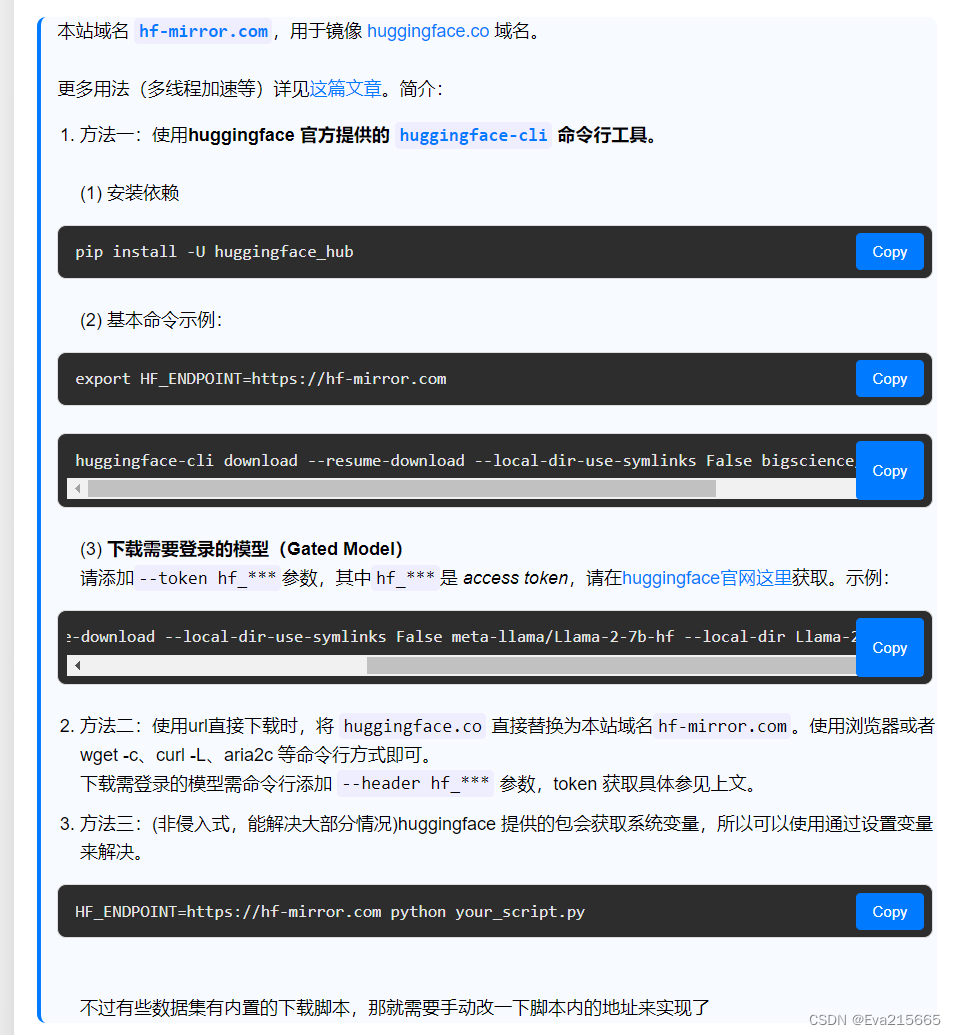

Huggingface国内开源镜像

https://hf-mirror.com/

上面总结了多种从Huggingface上下载模型的方法,如下图。

方法一:使用huggingface官网提供的huggingface-cli工具

官方详解地址https://huggingface.co/docs/huggingface_hub/guides/download

1. 安装依赖

创建项目的虚拟环境后,激活该环境,并执行:

pip install -U huggingface_hub

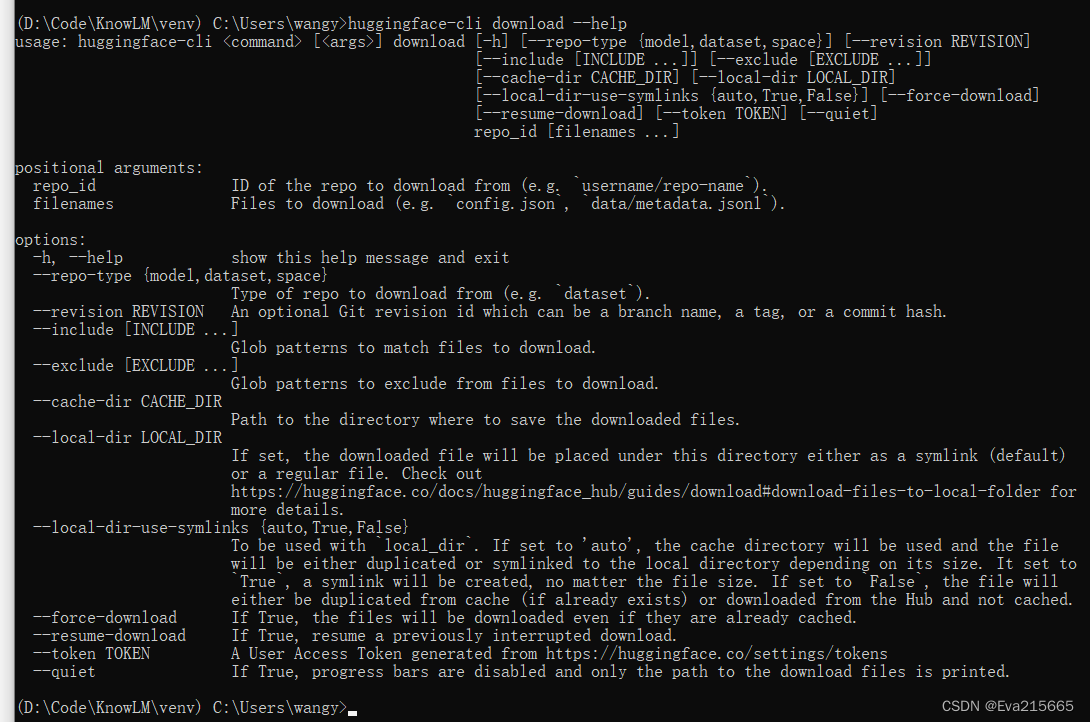

可以运行huggingface-cli download --helps命令来查看download功能的参数,如下图

以下载zjunlp/knowlm-13b-ie模型为例,模型地址:https://huggingface.co/zjunlp/knowlm-13b-ie/tree/main

huggingface-cli download --resume-download

--local-dir-use-symlinks False zjunlp/knowlm-13b-ie

--local-dir D:\Code\KnowLM\test

这条命令会将zjunlp/knowlm-13b-ie模型下载到本地的D:\Code\KnowLM\test路径下

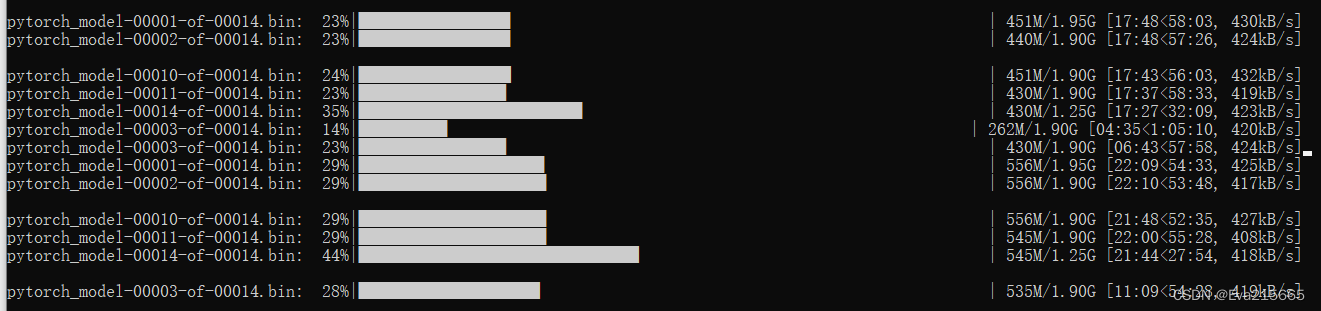

支持多线程下载,如图

比直接从项目地址网页https://huggingface.co/zjunlp/knowlm-13b-ie/tree/main下载方便快捷得多!

2. 基本命令示例

export HF_ENDPOINT=https://hf-mirror.com

3. 下载需要登录的模型

文章来源:https://blog.csdn.net/weixin_43196262/article/details/135268100

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 照着这几步做,轻松搭建企业知识库

- 【C++干货铺】会搜索的二叉树(BSTree)

- 【揭秘】ThreadPoolExecutor全面解析

- Minio数据模型

- Linux驱动学习—输入子系统

- const和#define的区别

- idea中java单元测试报错

- Java SE入门及基础(20)

- ComfyUI报错ModuleNotFoundError: No module named ‘comfy.options‘

- RHCE 练习作业