ETL概念

ETL

在BI项目中ETL会花掉整个项目至少1/3的时间,

ETL设计的好坏直接关接到BI项目的成败。

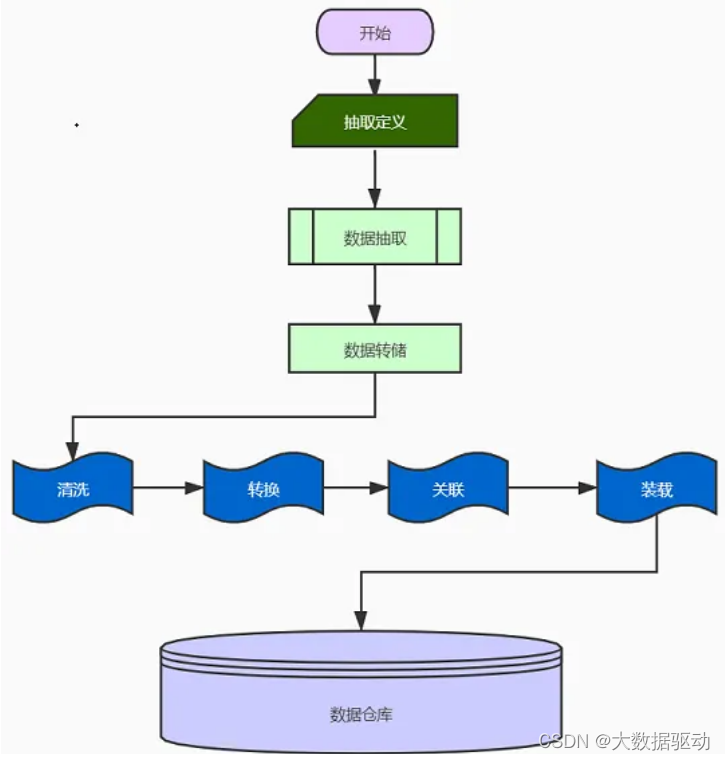

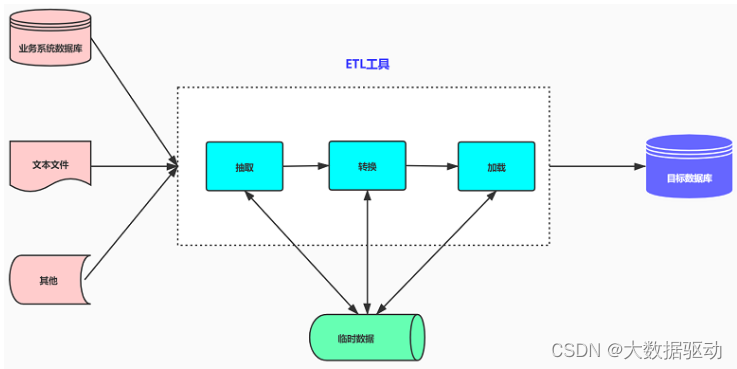

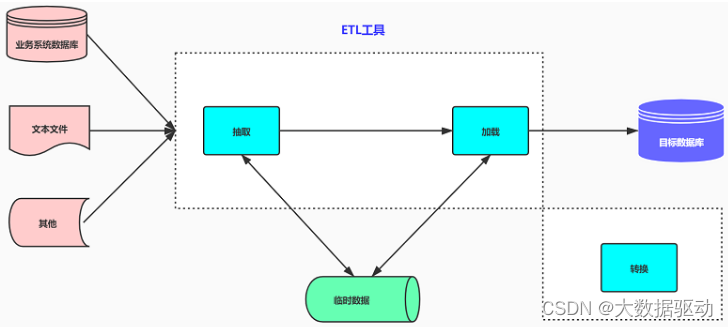

ETL(Extract-Transform-Load) : 用来描述将数据从来源端经过抽取(extract)、转换(transform)、加载(load)至目的端的过程。

- 提取(Extract):从多个来源系统(如ERP、CRM等)中提取数据。

- 转换(Transform):将提取的数据进行转换,包括数据清洗、格式转换、字段映射、计算等处理。

- 加载(Load):将转换后的数据加载到目标系统中,如企业数据仓库或数据集市中。

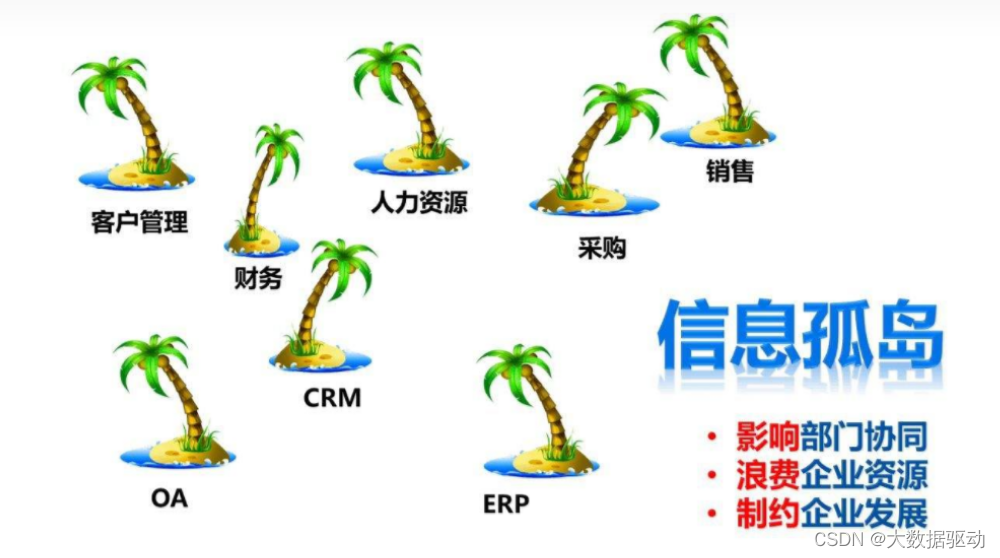

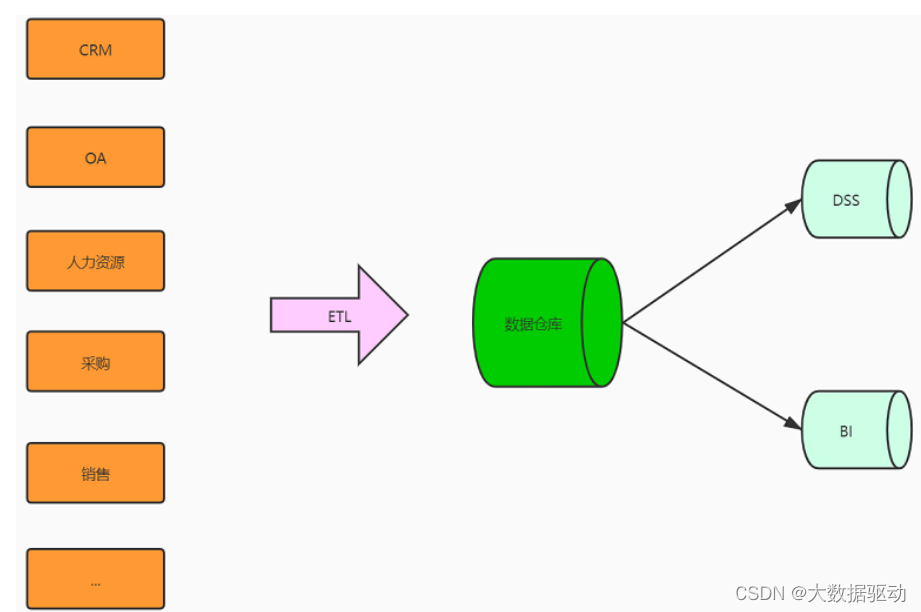

ETL是将业务系统的数据经过抽取、清洗转换之后加载到数据仓库的过程,目的是将企业中的分散、零乱、标准不统一的数据整合到一起,为企业的决策提供分析依据, ETL是BI(商业智能)项目重要的一个环节。

ELT

ETL架构按其字面含义理解就是按照E-T-L这个顺序流程进行处理的架构:先抽取、然后转换、完成后加载到目标数据库中。在ETL架构中,数据的流向是从源数据流到ETL工具,ETL工具是一个单独的数据处理引擎,一般会在单独的硬件服务器上,实现所有数据转化的工作,然后将数据加载到目标数据仓库中。如果要增加整个ETL过程的效率,则只能增强ETL工具服务器的配置,优化系统处理流程(一般可调的东西非常少)。

ETL架构的优势

可以分担数据库系统的负载(采用单独的硬件服务器)

相对于ELT架构可以实现更为复杂的数据转换逻辑

采用单独的硬件服务器

与底层的数据库存储无关

ELT架构则把“L”这一步工作提前到“T”之前来完成:先抽取、然后加载到目标数据库中、在目标数据库中完成转换操作。在ELT架构中,ELT只负责提供图形化的界面来设计业务规则,数据的整个加工过程都在目标和源的数据库之间流动,ELT协调相关的数据库系统来执行相关的应用,数据加工过程既可以在源数据库端执行,也可以在目标数据仓库端执行(主要取决于系统的架构设计和数据属性)。当ETL过程需要提高效率,则可以通过对相关数据库进行调优,或者改变执行加工的服务器就可以达到。

ETL所描述的过程,一般常见的作法包含ETL或是ELT(Extract-Load-Transform),并且混合使用。通常越大量的数据、复杂的转换逻辑、目的端为较强运算能力的数据库,越偏向使用ELT,以便运用目的端数据库的平行处理能力。

可以保持所有的数据始终在数据库当中,避免数据的加载和导出,从而保证效率,提高系统的可监控性

可以根据数据的分布情况进行并行处理优化,并可以利用数据库的固有功能优化磁盘I/O

通过对相关数据库进行性能调优,ELT过程获得3到4倍的效率提升比较容易

技术原理

-

数据源选择:根据企业的实际情况选择从哪些数据源中提取数据。多数情况下,数据源来自企业内部的各种业务系统。

-

数据提取:ETL工具可以从各种数据源中提取数据,包括关系数据库、文件、Web服务、MQ消息队列等。

-

数据清洗:清洗是指去除不符合要求的数据或对缺失数据进行补充。ETL工具可以针对数据中的噪声和冗余信息进行清洗。

-

数据转换:转换过程包括数据格式转换、数据规范化、字段映射、计算等处理。

-

数据加载:将处理后的数据加载到目标系统中,如数据仓库或集市中,以便进行进一步分析和决策。

ETL 模式

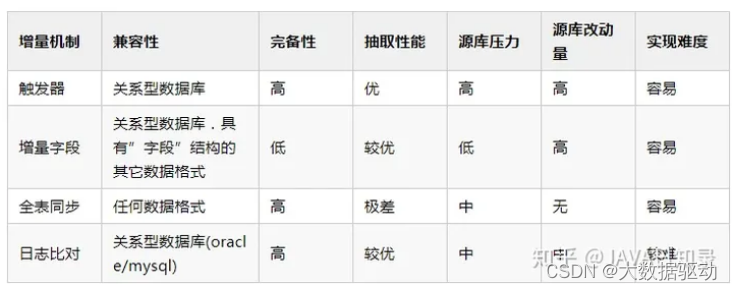

ETL有四种主要实现模式:触发器模式、增量字段、全量同步、日志比对

应用场景

数据整合:企业通常有多个数据源,包括数据库、文件、应用程序等,ETL能够将这些分散的数据整合在一起,为企业提供全面且一致的数据视图。

数据清洗与质量控制:ETL可以清洗和验证数据,排除重复、不完整或不准确的数据,提高数据的质量和可靠性。

决策支持:通过将多个数据源中的数据整合起来,并进行转换和分析,ETL可以为企业提供准确的决策支持信息,帮助管理层做出更明智的决策。

业务流程优化:ETL可以将数据从不同系统中抽取出来,并进行转换和加载,实现数据在不同系统之间的流动,优化业务流程。

- 业务数据管理:ETL可以将多个业务系统中的数据以一种统一的方式整合起来,为企业的数据管理提供支持。

- 业务智能分析:ETL可以将多个来源系统中的数据转化为通用的数据格式,以便进行全面的数据分析和决策。

- 数据备份和迁移:ETL可以将数据从一个系统迁移到另一个系统中。

- 数据转换:ETL可以对数据进行格式转换、计算等处理,以满足特定的业务需求。

ETL可以将散乱的数据整合起来,并加以处理和管理。

常见工具

Apache NiFi:Apache NiFi是一个开源的数据集成工具,提供了可视化的界面和强大的数据流处理功能。它支持实时数据流和批量数据处理,并具有丰富的数据转换和加载能力。

Pentaho Data Integration(Kettle):Pentaho Data Integration,也被称为Kettle,是一个开源的ETL工具。它提供了可视化的开发环境和大量的数据集成和转换组件,支持多种数据源和目标系统。

Talend Open Studio:Talend Open Studio是Talend公司提供的免费开源的ETL工具。它提供了可视化的开发环境和广泛的数据集成和转换功能,适用于各种数据集成项目。

Jaspersoft ETL:Jaspersoft ETL是一个开源的ETL工具,提供了可视化的开发环境和灵活的数据处理功能。它支持多种数据源和目标系统,并具有扩展性和可定制性。

ETLCloud:ETLCloud是一款国产免费的ETL工具,提供了全WEB可视化的开发环境和灵活的数据处理功能,它支持离线和实时数据集成,并具备超过200+的数据处理组件,支持各种主流数据源以及SaaS应用数据的抽取。

ETL未来发展方向

自动化和智能化:未来,ETL的未来发展方向将更加注重自动化和智能化。随着人工智能和机器学习的不断进步,ETL工具和平台将具备更强大的自动化能力,能够自动发现数据源、提取数据,并根据规则和模式进行数据转换和加载。这将大大减少人工干预的需求,提高数据处理的效率和准确性。

实时数据处理:随着业务需求的不断增长,对实时数据的需求也越来越迫切。未来的ETL将更加注重实时数据处理能力,能够对流式数据进行实时抽取、转换和加载,使得企业和个人能够及时获得最新的数据洞察,并做出实时决策。

数据安全与隐私保护:随着数据泄露和隐私问题的日益严重,未来的ETL将更加关注数据安全和隐私保护。ETL工具和平台将加强数据加密、访问控制和匿名化等技术手段,确保数据在抽取、转换和加载的过程中得到充分的保护,同时遵守相关的法规和隐私规范。

多样化数据源支持:未来的ETL将支持更多类型和格式的数据源,包括传统的结构化数据,半结构化数据(如日志文件、XML、JSON等)以及非结构化数据(如图像、音频、视频等)。这将使得ETL能够更好地处理多样化的数据,并从中提取有价值的信息。

云原生和分布式处理:随着云计算和大数据技术的发展,未来的ETL将更多地采用云原生架构和分布式处理模式。通过利用云平台的弹性扩展和分布式计算的能力,ETL可以更好地应对大规模数据处理的挑战,并提供高可用性和高性能的数据处理服务。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- Word2007导出PDF的正确做法

- Spring——Spring AOP1(代理模式Proxy)

- minio 整合springboot

- 2024年香港优才计划新政策变化!看清利弊再做申请!

- 小程序系列-5.WXML 模板语法

- AIGC Chat GPT 4 教你如何快速设置条件格式

- 小说网站返回数据AES加密处理

- 网络广播号角喇叭在智能工地施工现场的应用,以及网络广播在公共广播中的实际作用。

- rhel8安装

- 保留几位小数的函数、全排列函数、?反斜杠的作用、二进制、八进制、十六进制的输入?、求三角形面积的三种方法、求平方根、N次方如何表示