Residual network残差网络中的恒等连接是什么?

发布时间:2023年12月17日

文章目录

一、残差网络是什么?

残差网络是一种深度神经网络体系结构,旨在解决深层网络训练时的梯度消失和梯度爆炸问题。它通过引入残差或跳跃连接来允许网络跨层直接传递信息,从而使得网络更加容易训练且提高了网络性能。

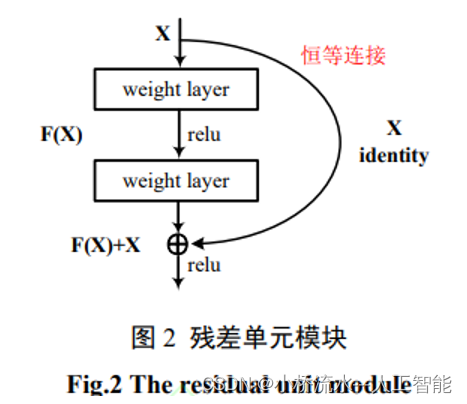

在传统的神经网络中,输入数据通过一系列的层逐层传递,每个层都将数据进行线性变换和非线性变换。而在残差网络中,每个网络块再加上未经过变换的输入作为输入,称为“恒等连接(identity connection)”。这意味着输出可以直接添加到输入中,以产生残差。这个残差能够传递到后面的层中,使得网络更加容易优化和训练。

例如,假设我们有一个输入x需要经过两层变换(每层都采用ReLU激活函数),如下所示:

y = ReLU(W2 * ReLU(W1*x))

现在,我们在每个块中添加一个跳过连接,得到以下残差块的形式:

y = ReLU(W2 * (ReLU(W1*x) + x))

这里,(ReLU(W1*x) + x) 就是输入x和网络块的输出之和,意味着我们从前面的输出上“跳过”了一层。通过这样的跳跃连接,我们能够将信息直接跨越网络层级,防止梯度在一些深层神经元上消失,从而加快训练速度并提高特征提取能力。

文章来源:https://blog.csdn.net/qlkaicx/article/details/134965128

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- HCIP-BGP实验4

- vray注册表怎么删除干净?

- python flask学生管理系统

- 如何使用 Typora 进行效率写作

- 低代码配置-列表页组件设计

- KAFKA

- josef约瑟 剩余电流动作继电器CLJ3-200A+互感器LH80

- 点云从入门到精通技术详解100篇-基于多传感器融合的智能汽车 环境感知

- RK3566 linux加入uvc app

- 显卡在线测试网站,毒蘑菇在线测试网站,摩尔线程S80网页显卡性能测试