优化测试稳定性的失败重试工具:pytest-rerunfailures详解!

一.前言

笔者在执行自动化测试用例时,会发现有时候用例失败并非代码问题,而是由于服务正在发版,导致请求失败,从而降低了自动化用例的稳定性,最后还要花时间定位到底是自身case的原因还是业务逻辑问题,还是其他原因,增加了定位成本。增加容错机制,失败重试,会解决大部分由于网络原因、服务重启等原因造成的case失败问题。那该如何增加失败重试机制呢?带着问题我们一起探索。

pytest-rerunfailures插件 先给出答案,我们将使用pytest-rerunfailures插件来实现失败重试功能。

二.什么是pytest-rerunfailures

pytest-rerunfailures是一个基于pytest框架的插件,它允许我们对测试用例进行失败重试。当一个测试用例失败时,插件会自动重新运行失败的测试用例,直到达到预定的重试次数或测试用例通过为止。这样可以增加用例的稳定性,并减少因为偶发性问题导致的测试失败。

三.如何使用pytest-rerunfailures

1.方式一

首先,确保已经安装了pytest-rerunfailures插件。可以使用以下命令进行安装

pip?install?pytest-rerunfailures

安装完成后,在项目中使用pytest运行测试用例时,pytest-rerunfailures插件会自动生效。

接下来,在编写测试用例时,可以通过添加@pytest.mark.flaky装饰器将需要重试的测试用例标记起来。例如:

import?pytest

@pytest.mark.flaky(reruns=3,?reruns_delay=2)

def?test_case():

????assert?1?==?2

在上述示例中,我们使用了@pytest.mark.flaky装饰器来标记测试用例test_case为可重试的。参数reruns指定了重试次数,而?reruns_delay则指定了每次重试之间的延迟时间(以秒为单位)。

我们来运行case,看一下执行结果:

执行命令:

pytest?-s?-v?test_demo.py::test_case

会看到如下结果:

RERUN

test_dir/test_demo.py::test_case?RERUN

test_dir/test_demo.py::test_case?RERUN

test_dir/test_demo.py::test_case?FAILED

可以看到,重试了3次,最终结果为失败。

注意:如果你是在pycharm中点击绿色三角形直接运行是不生效的

现在我也找了很多测试的朋友,做了一个分享技术的交流群,共享了很多我们收集的技术文档和视频教程。

如果你不想再体验自学时找不到资源,没人解答问题,坚持几天便放弃的感受

可以加入我们一起交流。而且还有很多在自动化,性能,安全,测试开发等等方面有一定建树的技术大牛

分享他们的经验,还会分享很多直播讲座和技术沙龙

可以免费学习!划重点!开源的!!!

qq群号:691998057【暗号:csdn999】

总结一下

当运行测试时,如果测试用例失败,pytest-rerunfailures插件会根据我们配置的重试次数和延迟时间自动重新运行该测试用例,直到达到最大重试次数或测试通过为止。

2.方式二

除了使用装饰器来标记测试用例外,pytest-rerunfailures还支持使用命令行选项和配置文件的方式进行配置。

命令行执行的话,可以这样写:

pytest?-s?-v?--reruns?3?--reruns-delay?2?test_demo.py::test_case

或者代码运行的话,可以这样写:

pytest.main(["-s",?"-v",?"--reruns",?"3",?"--reruns-delay",?"2",?"test_demo.py::test_case"])

四.运行机制

到这里,应该会使用了。我们简单概括一下它的运行机制:

pytest通过插件系统加载pytest-rerunfailures插件,并启用其功能。

当pytest运行测试时,对每个测试用例的执行进行监控。

如果一个测试用例执行失败,pytest-rerunfailures插件会捕获该失败,并判断是否需要进行重试。

如果该测试用例被标记为可重试(使用了@pytest.mark.flaky装饰器),插件会根据配置的重试次数和延迟时间重新运行该测试用例。

在每次重试之前,插件会根据设置的延迟时间暂停一段时间。

如果测试用例在重试次数达到上限之前通过了,即成功执行,则插件会将该测试用例标记为通过。

如果测试用例在达到最大重试次数后仍然失败,则插件会返回最后一次失败的结果作为最终的结果。

总结起来,pytest-rerunfailures插件在测试执行失败时,根据配置的重试次数和延迟时间重新运行测试用例,并根据重试结果判断最终的测试结果。这样可以提高测试用例的稳定性,并减少偶发性问题导致的测试失败。

五.源码解读:

https://github.com/pytest-dev/pytest-rerunfailures/blob/master/pytest_rerunfailures.py

使用阶段,我们使用mark标记,那源码中应该添加了该标记

def?pytest_configure(config):

????#?add?flaky?marker

????config.addinivalue_line(

????????"markers",

????????"flaky(reruns=1,?reruns_delay=0):?mark?test?to?re-run?up?"

????????"to?'reruns'?times.?Add?a?delay?of?'reruns_delay'?seconds?"

????????"between?re-runs.",

????)

????......

简单解释一下:pytest_configure(config)是pytest的一个钩子函数,用于在pytest配置阶段对配置进行自定义操作。

config.addinivalue_line()是pytest的配置方法,用于向配置中添加新的配置项或配置信息。

在这段代码中,通过config.addinivalue_line()方法,插件向pytest的配置中加入了一行字符串。

这行字符串指定了标记名称为flaky,并使用参数reruns和reruns_delay来说明重试次数和延迟时间的默认值。

标记的含义是将被标记的测试用例重新运行最多?reruns次,每次重试之间间隔reruns_delay秒。

通过这个自定义的标记,就可以使用@pytest.mark.flaky装饰器来标记需要进行重试的测试用例,并且可以在装饰器中指定具体的重试次数和延迟时间。

我们看看实现失败重试的源码,这才是重点

def?pytest_runtest_protocol(item,?nextitem):

????"""

????Run?the?test?protocol.

????Note:?when?teardown?fails,?two?reports?are?generated?for?the?case,?one?for

????the?test?case?and?the?other?for?the?teardown?error.

????"""

????reruns?=?get_reruns_count(item)

????if?reruns?is?None:

????????#?global?setting?is?not?specified,?and?this?test?is?not?marked?with

????????#?flaky

????????return

????#?while?this?doesn't?need?to?be?run?with?every?item,?it?will?fail?on?the

????#?first?item?if?necessary

????check_options(item.session.config)

????delay?=?get_reruns_delay(item)

????parallel?=?not?is_master(item.config)

????db?=?item.session.config.failures_db

????item.execution_count?=?db.get_test_failures(item.nodeid)

????db.set_test_reruns(item.nodeid,?reruns)

????if?item.execution_count?>?reruns:

????????return?True

????need_to_run?=?True

????while?need_to_run:

????????item.execution_count?+=?1

????????item.ihook.pytest_runtest_logstart(nodeid=item.nodeid,?location=item.location)

????????reports?=?runtestprotocol(item,?nextitem=nextitem,?log=False)

????????for?report?in?reports:??#?3?reports:?setup,?call,?teardown

????????????report.rerun?=?item.execution_count?-?1

????????????if?_should_not_rerun(item,?report,?reruns):

????????????????#?last?run?or?no?failure?detected,?log?normally

????????????????item.ihook.pytest_runtest_logreport(report=report)

????????????else:

????????????????#?failure?detected?and?reruns?not?exhausted,?since?i?<?reruns

????????????????report.outcome?=?"rerun"

????????????????time.sleep(delay)

????????????????if?not?parallel?or?works_with_current_xdist():

????????????????????#?will?rerun?test,?log?intermediate?result

????????????????????item.ihook.pytest_runtest_logreport(report=report)

????????????????#?cleanin?item's?cashed?results?from?any?level?of?setups

????????????????_remove_cached_results_from_failed_fixtures(item)

????????????????_remove_failed_setup_state_from_session(item)

????????????????break??#?trigger?rerun

????????else:

????????????need_to_run?=?False

????????item.ihook.pytest_runtest_logfinish(nodeid=item.nodeid,?location=item.location)

????return?True

简单解释一下:首先,通过函数get_reruns_count(item)获取当前测试用例需要重试的次数。如果没有设置重试次数,则直接返回。

然后,检查配置选项并获取重试的延迟时间,并确定是否运行在并行模式下。还会获取失败记录数据库对象,并获取当前测试用例已经执行的次数。

接下来,通过比较已执行次数和设定的重试次数,判断是否需要进行重试。如果已执行次数大于等于设定的重试次数,则不再进行重试,直接返回。

如果需要重试,会进入一个循环,每次重试会增加已执行次数。在重试过程中,会调用pytest_runtest_logstart函数记录测试用例开始执行的日志。

然后,通过调用runtestprotocol函数执行测试用例,并获取测试结果。在这里,生成的报告会被标记为执行次数减一,以便区分原始执行和重试执行的报告。

接着,通过_should_not_rerun函数判断当前报告是否满足不需要重试的条件。如果满足,则继续执行后续操作。

如果报告表明需要重试,并且重试次数未达到设定的次数,会将报告的结果设置为rerun,并根据设定的延迟时间暂停一段时间。

然后,根据并行模式和当前使用的xdist版本,决定是否记录中间结果。同时,会清除缓存的结果和执行状态。

之后,重试循环会继续,直到不满足重试条件为止。最后,会调用pytest_runtest_logfinish函数记录测试用例结束执行的日志。

最后,函数返回True,表示已经实现重试机制。

总结起来,这段代码通过循环执行测试用例,并在满足重试条件时进行重试,直到满足退出条件为止。在重试过程中,会记录日志、生成报告,并根据设定的重试次数和延迟时间进行控制。

六.最后

失败重试功能并不是解决所有测试问题的法宝,它应该被视为一种提高测试稳定性的辅助手段。在使用pytest-rerunfailures进行失败重试时,我们应该仔细分析失败的原因,确保重试次数和延迟时间设置合理,并与团队成员共同讨论和决定是否需要重试测试用例。

总结起来,pytest-rerunfailures是一个非常有用的工具,可以提高测试用例的稳定性。通过使用它,我们可以轻松地实现失败重试功能,并减少由于偶发性问题导致的测试失败。

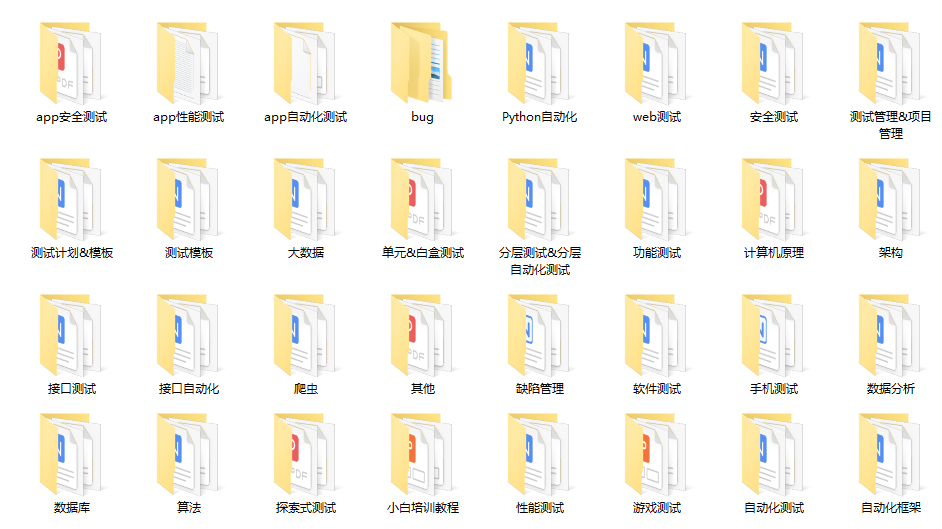

下面是配套资料,对于做【软件测试】的朋友来说应该是最全面最完整的备战仓库,这个仓库也陪伴我走过了最艰难的路程,希望也能帮助到你!

最后: 可以在公众号:程序员小濠 ! 免费领取一份216页软件测试工程师面试宝典文档资料。以及相对应的视频学习教程免费分享!,其中包括了有基础知识、Linux必备、Shell、互联网程序原理、Mysql数据库、抓包工具专题、接口测试工具、测试进阶-Python编程、Web自动化测试、APP自动化测试、接口自动化测试、测试高级持续集成、测试架构开发测试框架、性能测试、安全测试等。

如果我的博客对你有帮助、如果你喜欢我的博客内容,请 “点赞” “评论” “收藏” 一键三连哦!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 【ArduinoOTA无线(OTA)更新的EASY指南】

- MySQL运维实战(4.6) SQL_MODE之NO_BACKSLASH_ESCAPES

- 鸿蒙原生应用的“朋友圈”正在进一步扩大!

- Spring MVC 之 Restful 风格请求?持

- ansible ( 2 )

- 医疗领域:合成数据、生成对抗网络、数字孪生的应用

- 七、HTML 文本格式化

- springboot实现微信小程序授权登录前后端代码完整版

- 开启golang学习之路

- Lombok遇到的问题