BERT(从理论到实践): Bidirectional Encoder Representations from Transformers【1】

发布时间:2024年01月02日

预训练模型:A pre-trained model is a saved network that was previously trained on a large dataset, typically on a large-scale image-classification task. You either use the pretrained model as is or use transfer learning to customize this model to a given task.

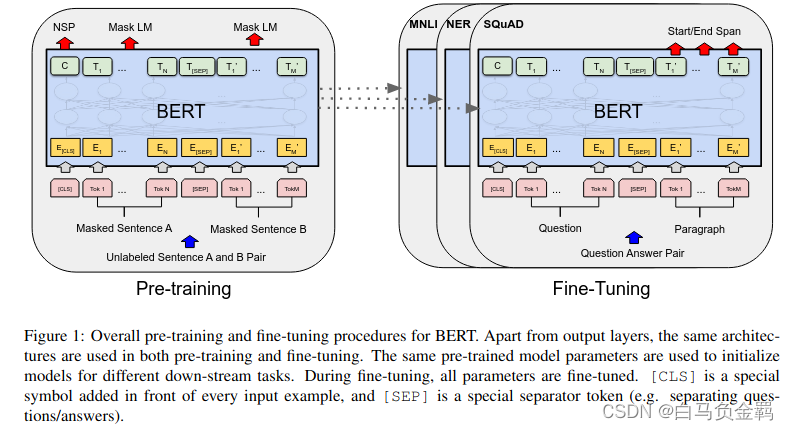

BERT是Google提出的一个基于Transformer的自然语言处理领域的预训练模型。它之所以被称为这个名字,一方面它是Bidirectional Encoder Representations from Transformers首字母的缩写。另一方面,还是为了致敬之前的一个模型ELMO。《Sesame Street》是由美国芝麻街工作室制作的一档儿童教育电视节目,其中的两个卡通人物分别是ELMO和BERT,如下图所示。

ELMO的基本概念就是利用上下文信息来生成一个单词的表达/Embedding(Contextualized word represen

文章来源:https://blog.csdn.net/baimafujinji/article/details/135337389

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- Automate Spreadsheet Tasks in .NET 8

- JavaSE-习题-认识运算符等

- 力扣(leetcode)第28题找出字符串中第一个匹配项的下标(Python)

- 并发编程之CAS&Atomic原子操作

- 一文了解VR全景技术如何运用在景区旅游宣传

- SQL server学习

- 什么叫反范式?数据库反范式设计

- Linux/Haystack

- vs code go环境安装调试

- 基于SpringBoot+Vue助农管理系统的设计与实现