国产DeepSeek Coder 33B开源:创新代码AI,性能优于CodeLlama

引言

近日,国产AI领域迎来了一项重大突破:DeepSeek团队正式发布了DeepSeek Coder 33B模型,这一基于最新人工智能技术的代码生成模型不仅完全开源,而且在多项评测中显示出优于同类产品CodeLlama的卓越性能。

-

Huggingface模型下载: https://huggingface.co/deepseek-ai

-

AI快站模型免费加速下载: https://aifasthub.com/models/deepseek-ai

模型概述

DeepSeek Coder系列包括1B、5.7B、6.7B及33B多个版本,涵盖广泛的代码和自然语言处理任务。这些模型均在包含大量代码和自然语言的数据集上进行训练,特别是33B版本,在多语言编程评测中表现出色。

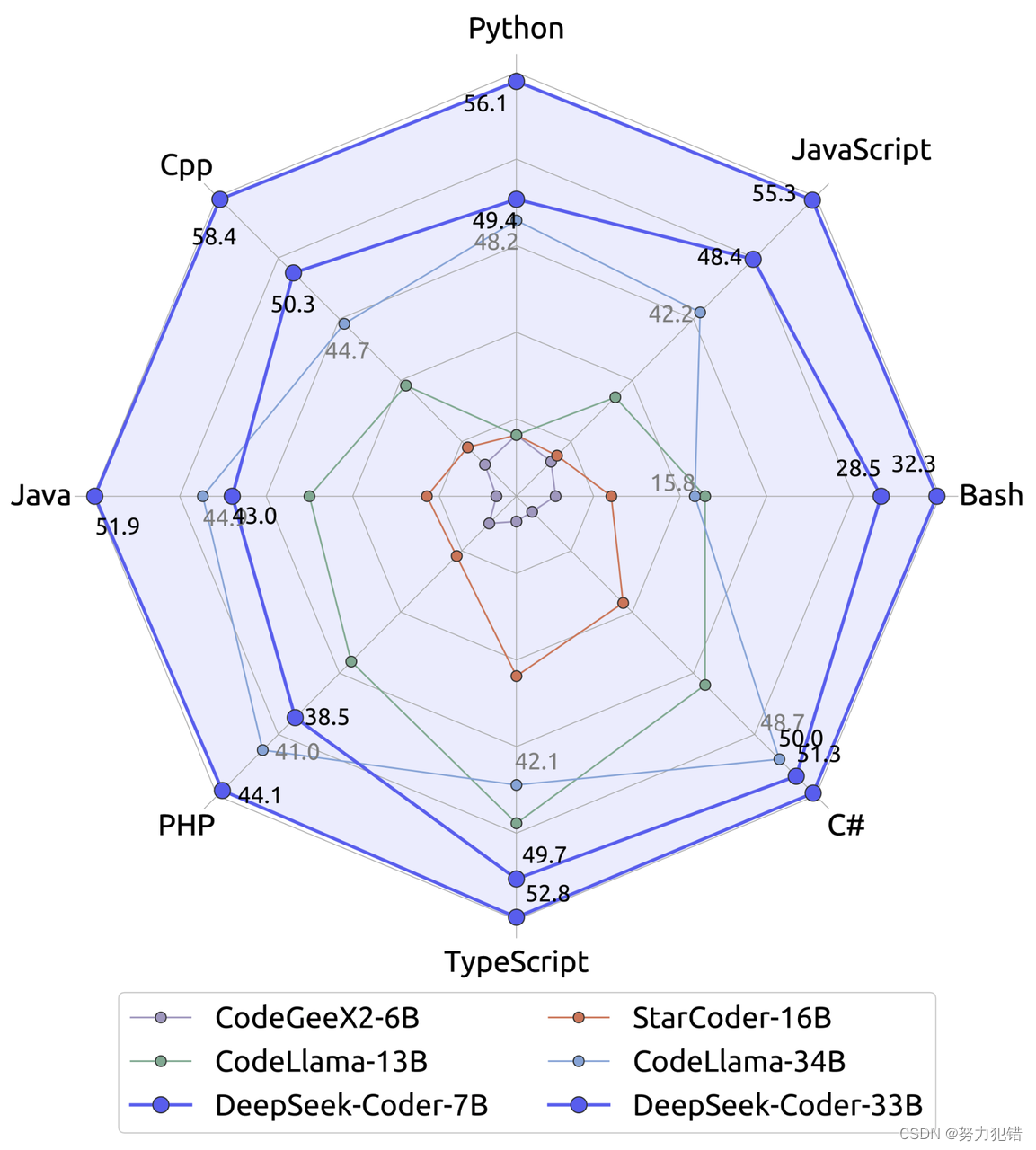

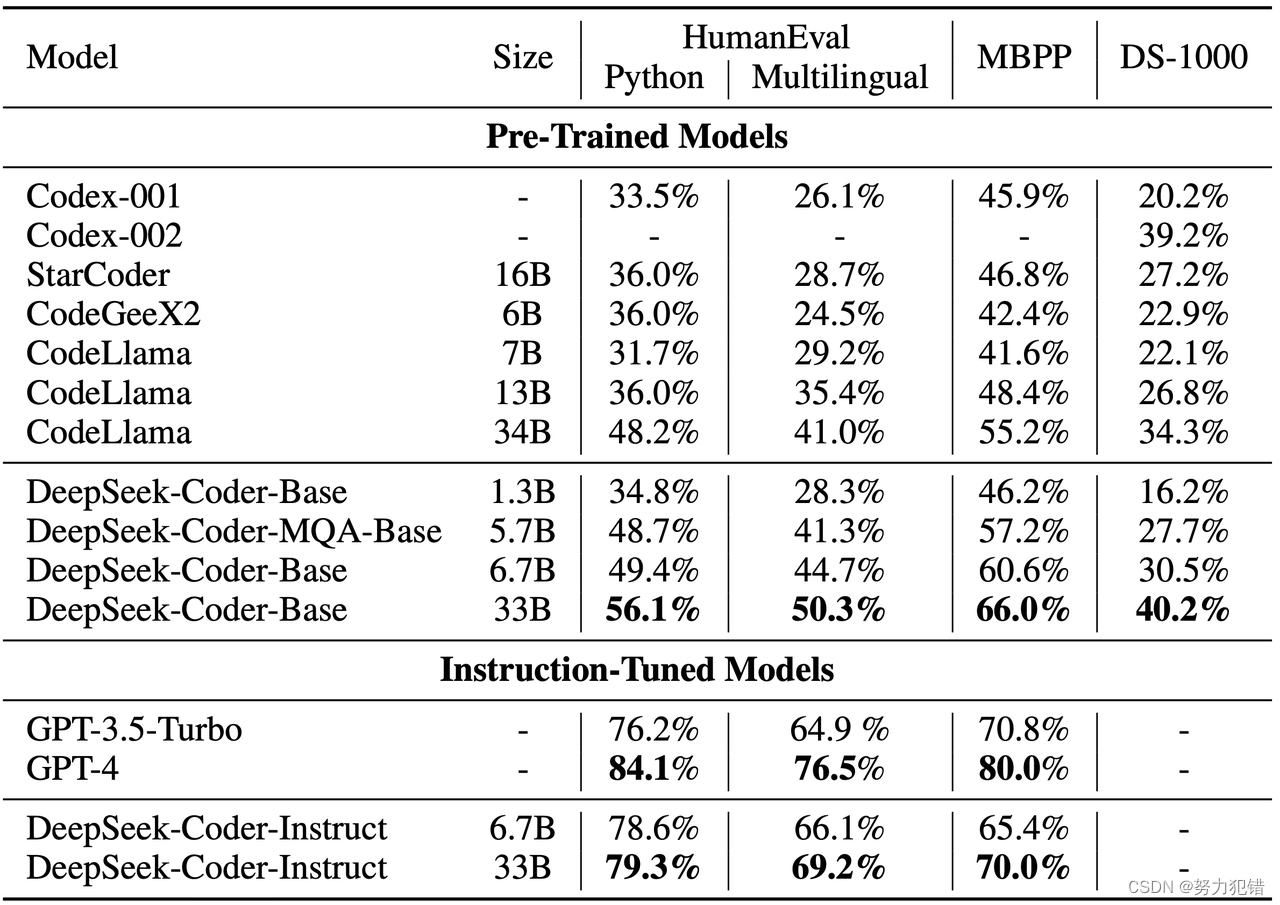

性能评估

在包括HumanEval、MultiPL-E、MBPP、DS-1000和APPS等多个权威编程基准上,DeepSeek Coder 33B展现了非凡的性能。特别是在33B版本中,该模型在HumanEval Python、HumanEval多语言、MBPP和DS-1000上的性能分别超过了CodeLlama 34B模型7.9%、9.3%、10.8%和5.9%。

训练数据与模型结构

DeepSeek Coder 33B在包含2万亿(2T)tokens的大型数据集上训练,其中87%为代码,13%为中英文自然语言。模型采用项目级代码语料库,引入16K窗口大小和填空任务,支持项目级代码补全和内嵌任务。该模型使用自回归Transformer解码器架构,7B模型采用多头注意力机制,而33B模型则使用分组查询注意力机制。

数学和编码能力

DeepSeek Coder不仅在代码生成上表现出色,还在数学和推理评测中展示了强大的能力。

数据处理与模型训练流程

DeepSeek Coder的数据处理流程包括从GitHub收集代码数据、解析代码文件依赖关系、组织依赖文件等步骤,以确保数据质量和多样性。模型训练过程包括初步预训练、扩展窗口大小的进一步预训练以及指令微调。

开源与应用前景

作为完全开源的模型,DeepSeek Coder为开发者社区提供了前所未有的灵活性和应用可能性。从复杂的代码生成到项目级代码补全,从数据分析到Bug修复,DeepSeek Coder都展示了强大的应用潜力。

结论

DeepSeek Coder 33B的发布,不仅标志着国产人工智能技术的一个重要进步,也为全球的开发者和研究者提供了一个强大的工具。其在性能上超越CodeLlama的成就,预示着更广泛的应用场景和更深远的技术影响。随着AI技术的不断发展,DeepSeek Coder无疑将在代码AI领域扮演越来越重要的角色。

模型下载

Huggingface模型下载

https://huggingface.co/deepseek-ai

AI快站模型免费加速下载

https://aifasthub.com/models/deepseek-ai

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 【JavaEE】认识网络的工作原理

- java日期时间操作

- python观察图像的直流分量——冈萨雷斯数字图像处理

- 学习stm32第二天

- 实验室推理和训练用4090就够了,何必用H100浪费算力资源-猿界算力租赁

- Midjourney NIJI5制作动漫风格作品保姆级教程

- 【C++】异常

- flowable-startEvent[开始事件]相关配置[表单、执行监听器]

- 阿里云高性能云服务器_云主机_云服务器详解

- NodeMCU ESP8266 读取按键外部输入信号详解(图文并茂)