机器人中的数值优化之线性共轭梯度法

发布时间:2023年12月28日

欢迎大家关注我的B站:

偷吃薯片的Zheng同学的个人空间-偷吃薯片的Zheng同学个人主页-哔哩哔哩视频 (bilibili.com)

本文ppt来自深蓝学院《机器人中的数值优化》

目录

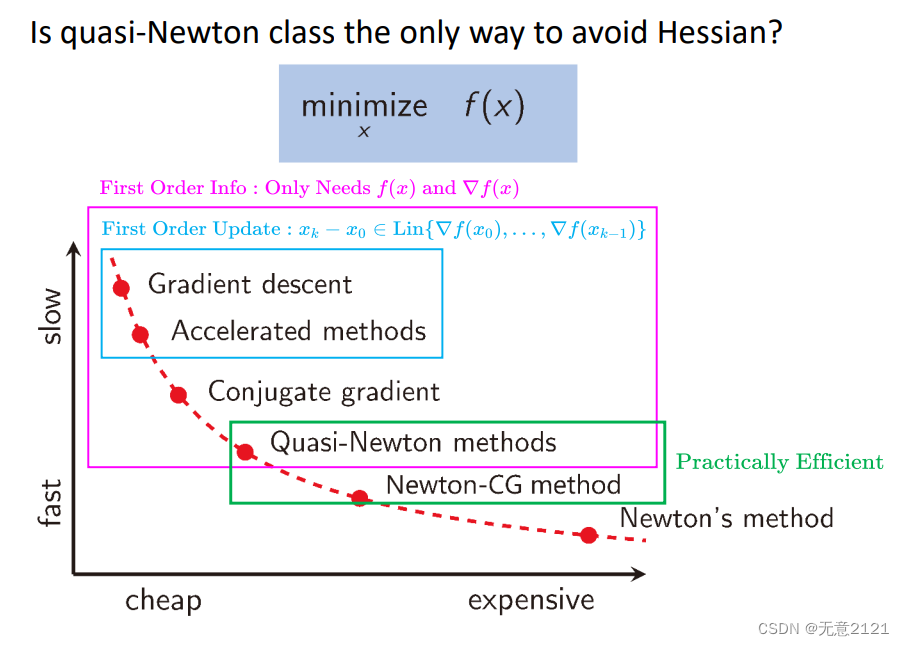

1.无约束优化方法对比

拟牛顿方法和牛顿共轭梯度方法是最优的,实现收敛速率与iteration work之间的平衡

2.Hessian-vec product

?hessian矩阵需要n方的复杂度,逆需要n三次方的复杂度,我们求解d需要hessian矩阵的逆

hessian与向量的乘积经过泰勒展开的简化可以变为只需求两次梯度

3.线性共轭梯度方法的步长

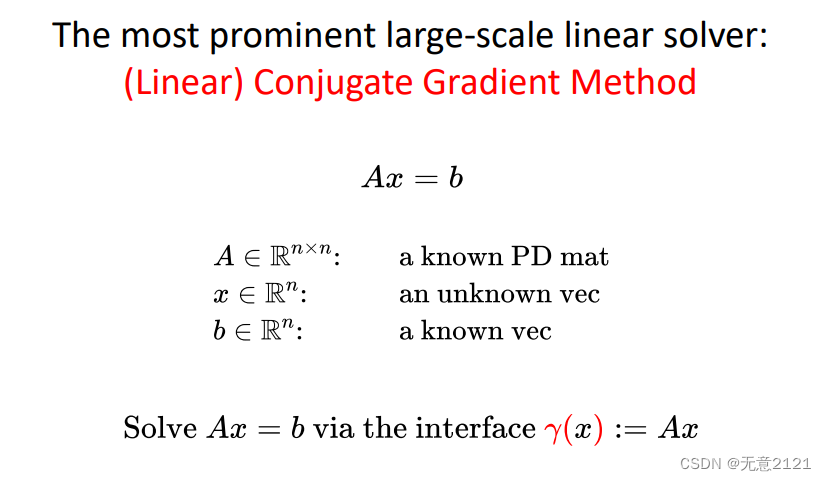

?A应该也是未知的,我们只能输入x得到Ax的值

?

?求解线性方程这个任务转化为求二次函数的最小值

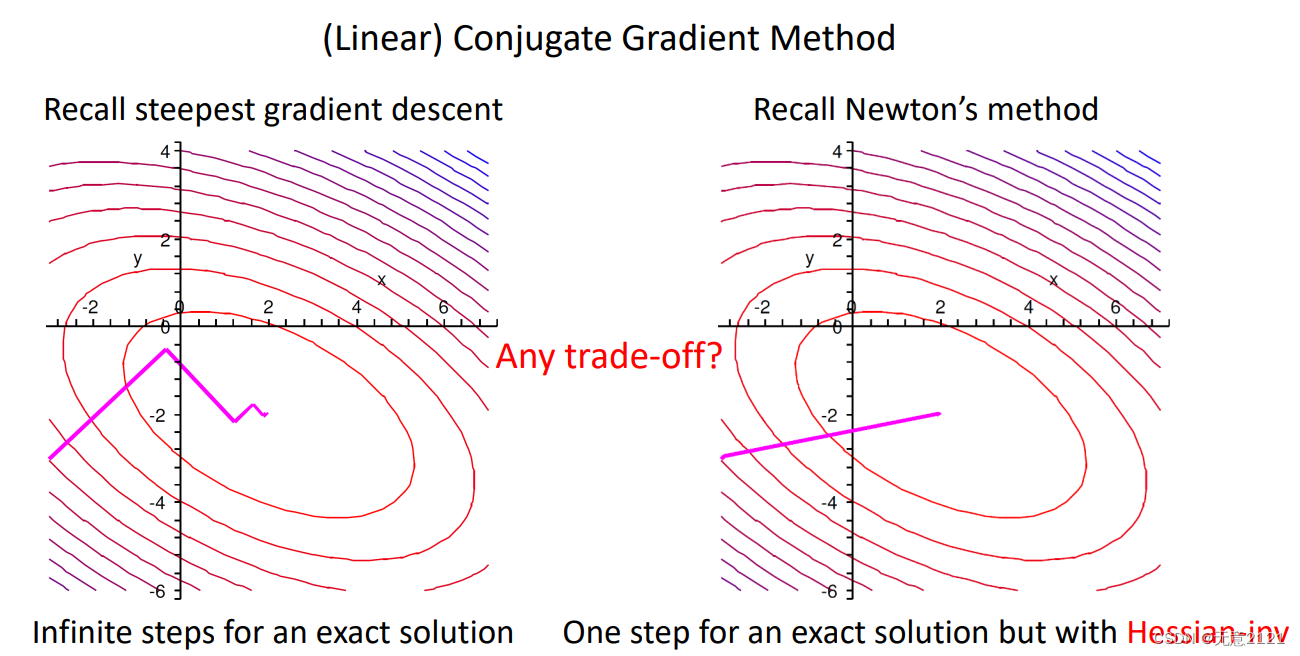

最速下降法收敛比较慢

牛顿方法需要涉及Hessian求逆

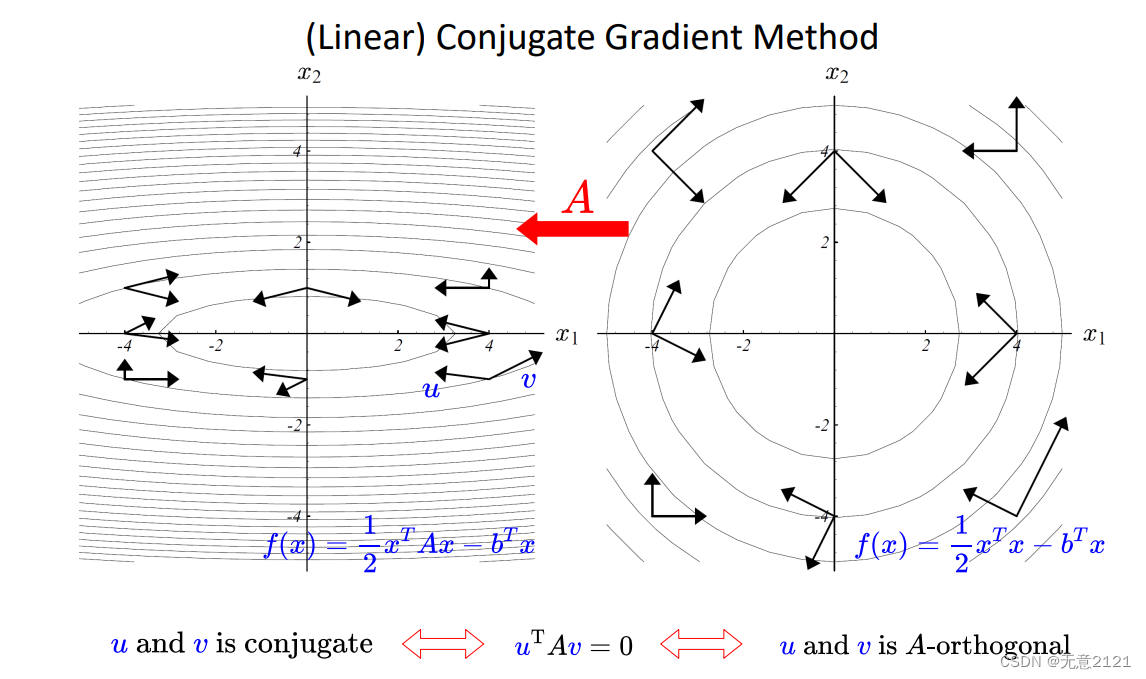

如果A=I,那么等高线是圆,n维则是对应超球,但是每次的迭代都是相互垂直的,只要n步这样正交的方向迭代搜索就能获得精确的最小值?

对于A!=I时,等高线为椭球,相当于做了仿射变换,原来的正交,现在则是共轭,定义如上

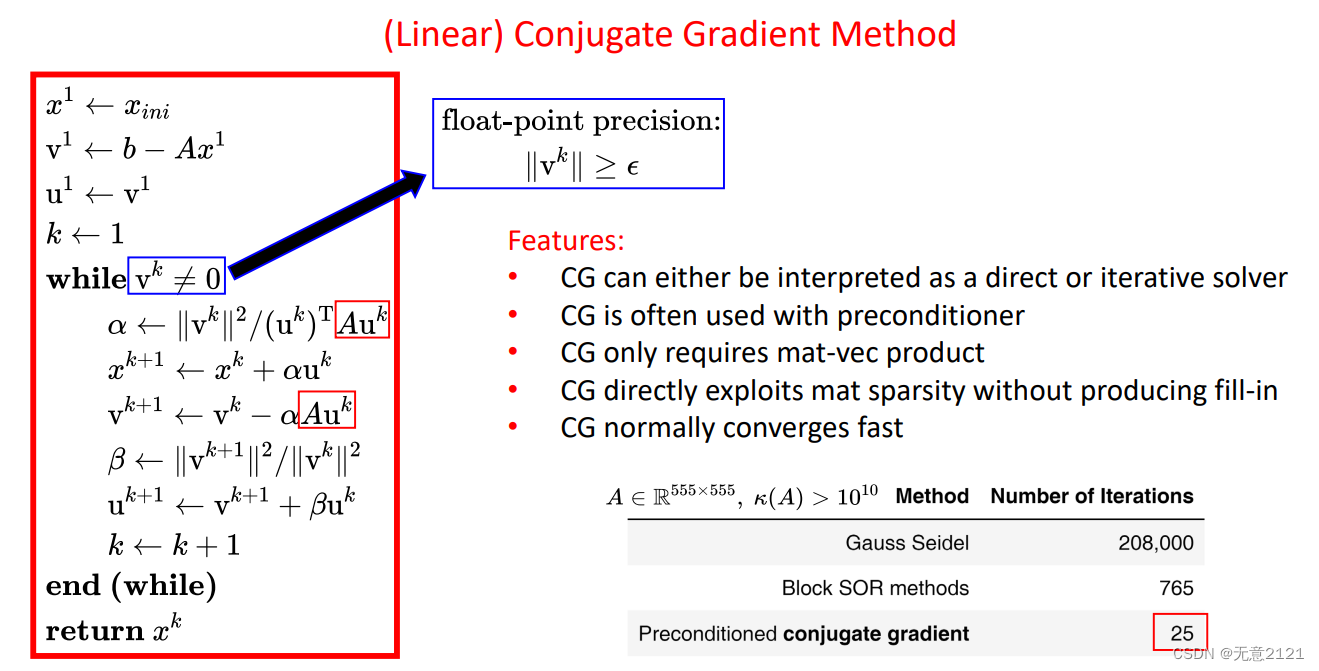

这里对步长进行求导则可以得到步长的闭式解,并且由其形式可看出我们只需要知道Ax这样输入x得出Ax的值的接口就行

4.共轭梯度方向的求解

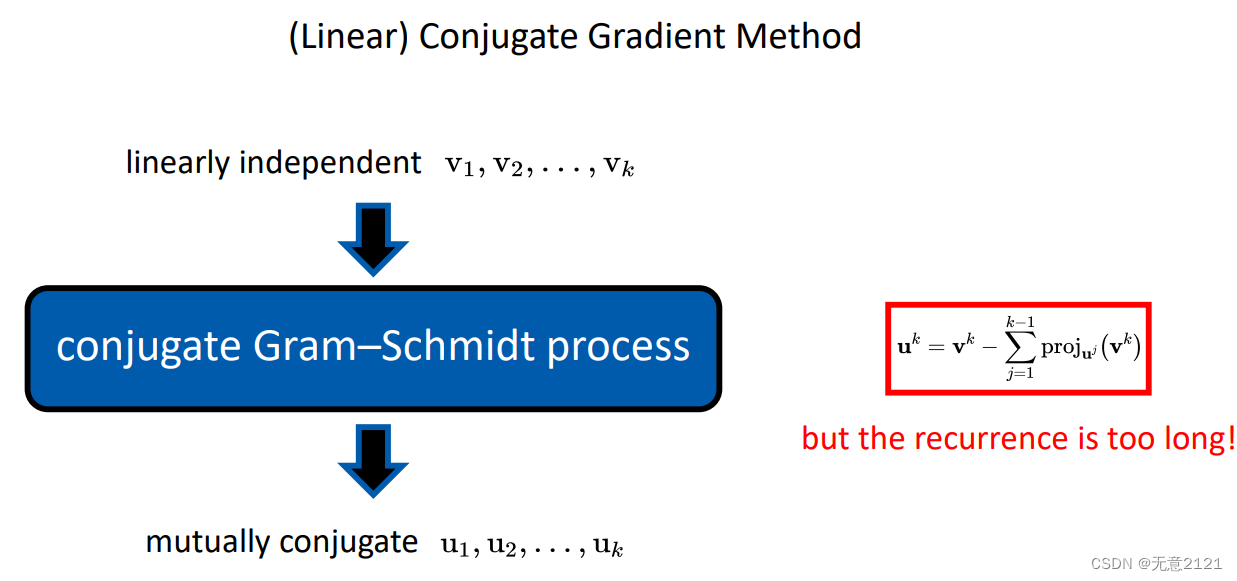

施密特正交化就是不断把基底方向的分量减掉,剩下的就是和已经存在的基底正交的另一个基底?

共轭的施密特正交化与一般的施密特正交化的区别就是内积中间有系数矩阵A

按部就班来还是k方的复杂度,实际上可以增量式地计算

这里令每一次Vk是残差,但这个残差已经把在之前的共轭投影上都是零了

5.线性共轭梯度方法整体流程

文章来源:https://blog.csdn.net/weixin_65089713/article/details/135274518

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 深度学习——R-CNN目标检测原理

- mysql+关掉密码过期

- TypeScript学习笔记(13)-命名空间

- 【游戏篇】Scratch之饥饿的鱼

- Windows下 VS2022 编译OpenSSL 库

- 医院信息系统集成平台—后台运维管理系统

- 几分钟,教你搭个 AI 绘画平台~

- 【Linux API 揭秘】container_of函数详解

- 【PostgreSQL在线创建索引(CIC)功能的锁分析以及使用注意】

- 这个插件厉害了!助你一键生成网页、视频总结!