AIGC的底层核心结构Transformer是如何彻底改变NLP游戏规则的?OJAC近屿智能带你一探究竟

没有Transformer,就没有NLP的突破,听起来有些夸张,但事实确实如此。什么是Transformer?Transformer是一种基于注意力机制的神经网络架构。可以用于处理序列数据,被广泛应用于翻译、识别等任务。这种模型的主要特点是使用自注意力机制和位置Embedding来提升语言的表达能力。Transformer模型由编码器和解码器层的堆栈构成,同时包括了自注意力层和前馈层。这种架构使得Transformer可以捕捉序列中元素之间的关系,从而更好地处理长序列数据。Transformer的出现带来了NLP领域的突破。

据统计,自2017年Transformer模型首次提出以来,已经有超过300篇研究论文引用了这个模型。研究人员发现,在多个自然语言处理任务中,使用Transformer比传统模型效果更好。根据2019年的一项研究,使用Transformer模型进行机器翻译的效果比传统的RNN模型提高了35%。而在2020年的另一项研究中,使用Transformer模型进行文本摘要的效果比传统的LSTM模型提高了27%。这些数据表明,Transformer模型在NLP领域中具有非常强的应用能力。

Transformer已经成为了NLP领域的主流架构之一。

现在,越来越多的企业和机构开始使用Transformer模型来解决各种自然语言处理问题。谷歌的BERT模型就是基于Transformer构建的,它已经被广泛应用于各种NLP任务中。可以说,没有Transformer,就没有NLP领域的这些突破性进展。

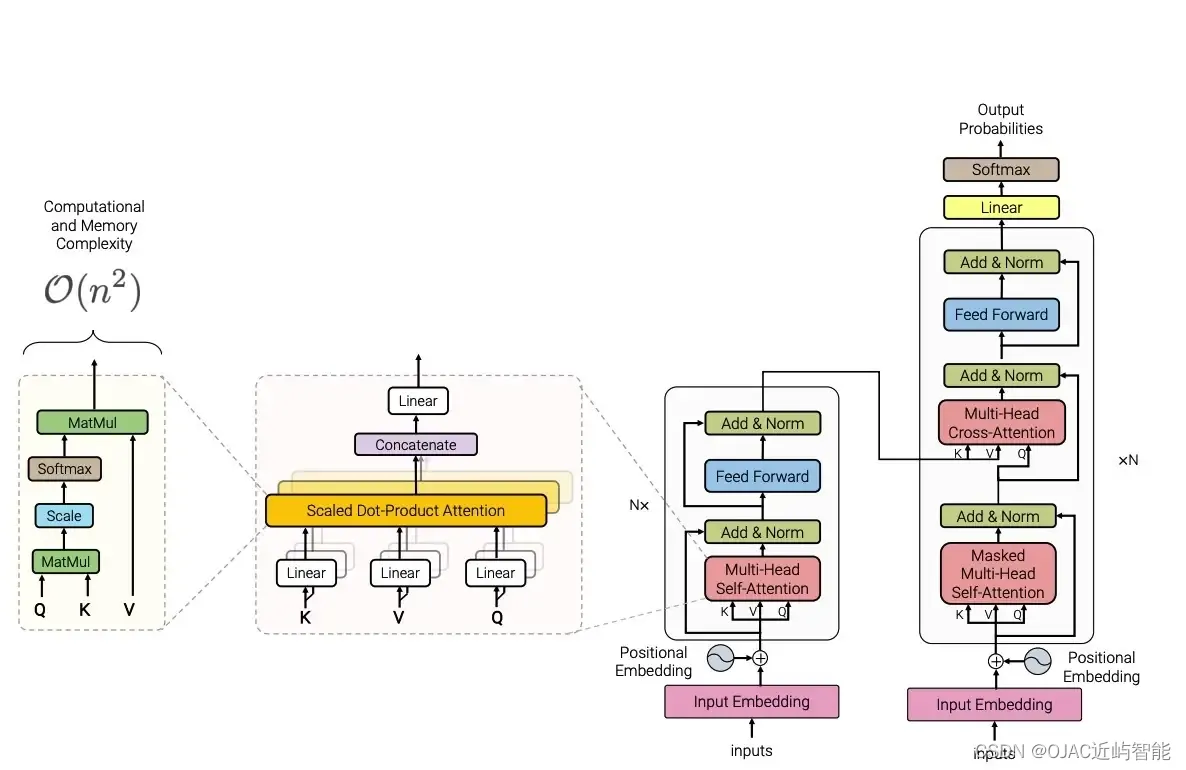

当然,让我们更详细地探讨Transformer模型的结构。Transformer模型早在2017年由Vaswani等人在论文《Attention is All You Need》中首次提出,其主要目的是处理序列到序列的任务,如机器翻译。它完全基于注意力机制,没有使用传统的循环网络(RNN)或卷积网络(CNN)。这部分内容我们其他文章也有详细的解读

Transformer的主要组成部分

编码器和解码器:

a.编码器:Transformer模型包含多个相同的编码器层堆叠而成。每个编码器层包含两个核心子层:多头自注意力(Multi-Head Self-Attention)机制和前馈神经网络(Feed Forward Neural Network。

b. 解码器:解码器同样由多个解码器层组成,每个解码器层有三个子层:一个是多头自注意力机制,一个是多头编码器-解码器注意力机制,最后一个是前馈神经网络。

自注意力机制(Self-Attention):

自注意力机制是Transformer模型的核心,它允许输入序列的每个元素同时与序列中的其他所有元素交互,从而能够捕捉序列内部的依赖关系。这种机制使模型能够并行处理整个序列,提高了效率。

多头注意力(Multi-Head Attention):

在多头注意力机制中,注意力机制被复制多次。每个“头”独立学习输入数据的不同部分的表示,然后将这些表示合并起来。这样做可以让模型在不同位置捕获序列的不同特征,从而提升了模型的学习能力。

前馈神经网络:

每个编码器和解码器层中的前馈网络都是简单的全连接层,其作用是对自注意. 力层的输出进行非线性变换。

位置编码(Positional Encoding):

由于Transformer完全丢弃了循环和卷积结构,因此需要一种方式来利用输入序列中的位置信息。位置编码通过将一个相对或绝对的位置信息添加到每个输入元素中来实现。

层归一化和残差连接:

每个子层(自注意力层和前馈网络)的输出都通过一个残差连接 followed by 层归一化。这种设计有助于避免在深层网络中出现梯度消失的问题。

整体结构:

- 输入首先通过编码器层的序列进行处理,每个编码器层内部的自注意力子层使得模型能够关注输入序列中不同部分的内部关系。经过一系列编码器层的处理后,编码器输出的信息传递给解码器。

- 解码器在生成输出序列时,除了自注意力和前馈网络,还引入了编码器-解码器注意力子层。这一层使得解码器能够关注编码器输出的相关部分,这在任务如机器翻译中尤为关键。

- 为了使模型能够理解序列中元素的顺序,Transformer引入了位置编码。位置编码有多种实现方式,但通常是一种固定的、可以与输入嵌入相加的编码。这样,模型即便在处理每个元素时具有并行性,也能够利用序列中的位置信息。

- 在每个子层之后,Transformer模型采用残差连接(即将输入直接加到子层输出上),然后进行层归一化。这种设计有助于缓解深层网络训练中的困难,提高模型的训练速度和效果。

总的来说,Transformer的这种独特架构使其在处理长序列数据时更加高效,同时能够更好地捕捉长距离依赖关系。这些特性使得Transformer成为当今自然语言处理领域的主流架构之一,广泛应用于各类NLP任务中。

关于transfomer结构自注意力机制,还有self- attention的详解,我们近屿智能OJAC推出的《AIGC星辰大海:大模型工程师和产品专家深度训练营》就是学习这部分知识的最好选择。我们的课程是一场结合了线上与线下的双轨合流式学习体验。

别人教您使用AIGC产品,例如ChatGPT和MidJourney,我们教您增量预训练,精调大模型,和创造属于自己的AI产品!

您是否想利用AIGC为您打破职业与薪资的天花板?您是否想成为那个在行业里脱颖而出的AI专家?我们的培训计划,将是您实现这些梦想的起点。

让我带您了解一下近屿智能OJAC如何帮您开启AI的大门。

首先,为了让零基础的您也能轻松上手,我们特别设计了“Python强化双周学”这个先修课程。在两周的时间里,我们将通过在线强化学习,把大模型相关的Python编程技术娓娓道来。就算您现在对编程一窍不通,也不要担心,我们会带您一步步走进编程的世界。

然后,是我们的“AIGC星辰大海:大模型工程师与AIGC产品经理启航班”。这个课程包含6节精彩的直播课,不仅能让您深入了解ChatGPT等大模型的奥秘,还会带您领略至少20个来自全球的成功AIGC产品案例。想象一下,未来您同样有机会利用这些先进技术打造出热门AI产品!

更深层次的学习,则在“AIGC星辰大海:大模型工程师和产品专家深度训练营”中进行。这个深度训练营覆盖了从理论基础到实际操作的全过程,让您不仅学会理论,更能将知识应用到实际项目中。如果您想要深挖大模型的秘密?这里就是您的实验室!

如果您选择加入我们的OJAC标准会员,我们的"AI职场导航"项目,还将为您提供量身定制的职业机会,这些职位来自于我们广泛的行业网络,包括初创企业、中型企业以及全球知名公司。我们会根据您的技能、经验和职业发展愿景,为您筛选合适的机会。此外,我们也提供简历修改建议、面试准备指导和职业规划咨询,帮助您在竞争激烈的市场中脱颖而出。

同时您也可以享受到未来景观AI讲座暨每月技术洞见”系列讲座,获得最新的技术洞见。这不仅是一个学习的机会,更是一个与行业顶尖大咖直接交流的平台。

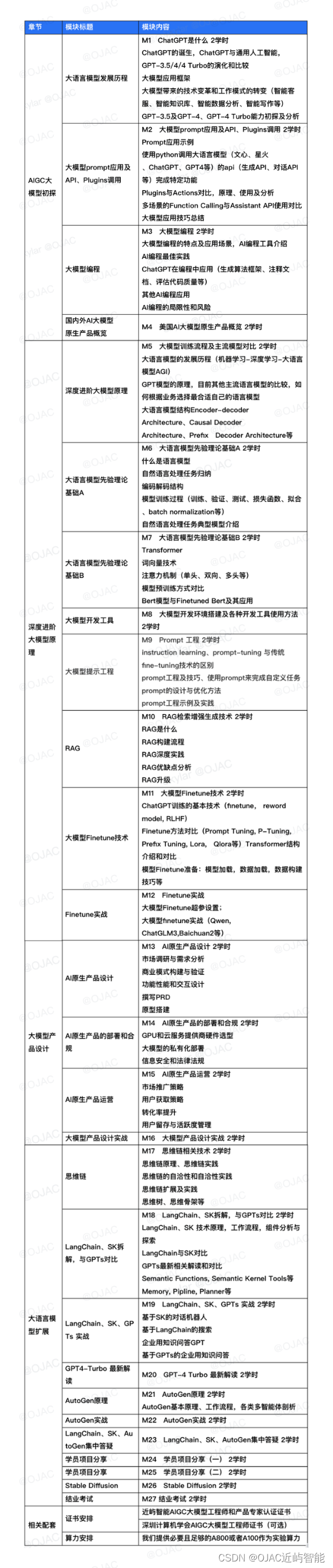

以下是我们大模型工程师和产品专家深度训练营的课程内容:

除此之外,现在报名我们即将开班的第六期AIGC星辰大海大模型工程师和产品经理训练营,您将可以参与到以下三个创新实战项目中的任意一个,这些项目不仅能够锻炼您的实战能力,还能让您在AIGC领域脱颖而出。

项目1:企业级知识问答GPT

这个项目将教您如何打造一个智能机器人,它能够接入企业内部的知识库,如技术文档、HR政策、销售指南等。您将学会如何使其具备强大的自然语言处理能力,进行复杂查询的理解和精确答案的提供。此外,该项目还包括教您如何让机器人保持对话上下文、支持多语言交流,并具备反馈学习机制,以不断提升服务质量。

项目2:行业级AI Agent

在这个项目中,您将学习如何为特定行业定制化AI Agent。您将被指导如何让它理解行业专有术语和工作流程,并训练它自动执行任务,如预约设置、数据输入和报告生成。这个项目不仅帮助您构建一个决策支持系统,还教您如何进行用户行为预测和性能监控与优化。

项目3:论文翻译

如果您对语言学习和学术研究有浓厚兴趣,这个项目将是您的理想选择。您将探索如何实现从英语到中文或其他目标语言的精准学术翻译,确保保留学术文献的深层含义。本项目还包括学术格式定制、专业词汇精确匹配以及广泛语言选项的训练,最后通过翻译效果评价系统,您将能够持续提升翻译质量。

无论您选择哪个项目,都将是您职业生涯中不可多得的实战经历。

我们诚邀您继续与我们携手前行。在未来的职业道路上,让我们共同探索AI的更多奥秘,共创辉煌。如果您还有任何疑问或者想要深入了解更多课程内容,请随时联系我们。我们期待着与您共同开启下一阶段的AI探索之旅。

加入我们的“AIGC星辰大海”训练营,让我们一起在AI的世界里创造不凡!立刻加入我们,开启您的AI大模型旅程,将梦想转变为现实。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- Jmeter相关概念

- Redis内存淘汰策略

- 信息系统安全——Linux 访问控制机制分析

- python基础教程九 抽象二(函数参数)

- 数据结构:图文详解 树与二叉树(树与二叉树的概念和性质,存储,遍历)

- 克服大模型(LLM)部署障碍,全面理解LLM当前状态

- Elasticsearch 7.8.0从入门到精通

- 43-函数的声明定义,函数表达式定义,函数的调用,声明提升,参数,形参,实参

- 【后端那些事儿】Redis设计与实现(三)慢查询日志,耐心看完你比Redis还懂Redis!

- 关于边缘云的认识