Flink on K8S生产集群使用StreamPark管理

(一)直接部署(手动测试用,不推荐)

Flink on Native Kubernetes 目前支持 Application 模式和 Session 模式,两者对比 Application 模式部署规避了 Session 模式的资源隔离问题、以及客户端资源消耗问题,因此生产环境更推荐采用 Application Mode 部署 Flink 任务。下面我们分别看看使用原始脚本的方式和使用 StreamPark 开发部署一个 Flink on Native Kubernetes 作业的流程。

使用脚本方式部署Kubernetes

- 在 Flink 客户端节点准备 kubectl 和 Docker 命令运行环境,创建部署 Flink 作业使用的 Kubernetes Namespace 和 Service Account 以及进行 RBAC

- 编写 Dockerfile 文件,将 Flink 基础镜像和用户的作业 Jar 打包到一起

Explain

FROM flink:1.13.6-scala_2.11

RUN mkdir -p $FLINK_HOME/usrlib

COPY my-flink-job.jar $FLINK_HOME/usrlib/my-flink-job.jar

- 使用 Flink 客户端脚本启动 Flink 任务

./bin/flink run-application \

--target kubernetes-application \

-Dkubernetes.namespace=flink-cluster \

-Dkubernetes.jobmanager.service-account=default \

-Dkubernetes.cluster-id=my-first-application-cluster \

-Dkubernetes.container.image=relx_docker_url/streamx/relx_flink_1.13.6-scala_2.11:latest \

-Dkubernetes.rest-service.exposed.type=NodePort \

local:///opt/flink/usrlib/my-flink-job.jar

- 使用 Kubectl 命令获取到 Flink 作业的 WebUI 访问地址和 JobId

kubectl -n flink-cluster get svc

- 使用Flink命令停止作业

./bin/flink cancel

--target kubernetes-application

-Dkubernetes.cluster-id=my-first-application-cluster

-Dkubernetes.namespace=flink-cluster <jobId

以上就是使用 Flink 提供的最原始的脚本方式把一个 Flink 任务部署到 Kubernetes 上的过程,只做到了最基本的任务提交,如果要达到生产使用级别,还有一系列的问题需要解决,如:方式过于原始无法适配大批量任务、无法记录任务checkpoint 和实时状态跟踪、任务运维和监控困难、无告警机制、 无法集中化管理等等。

(二)使StreamPark平台(推荐)

官网:https://streampark.apache.org/docs/intro/

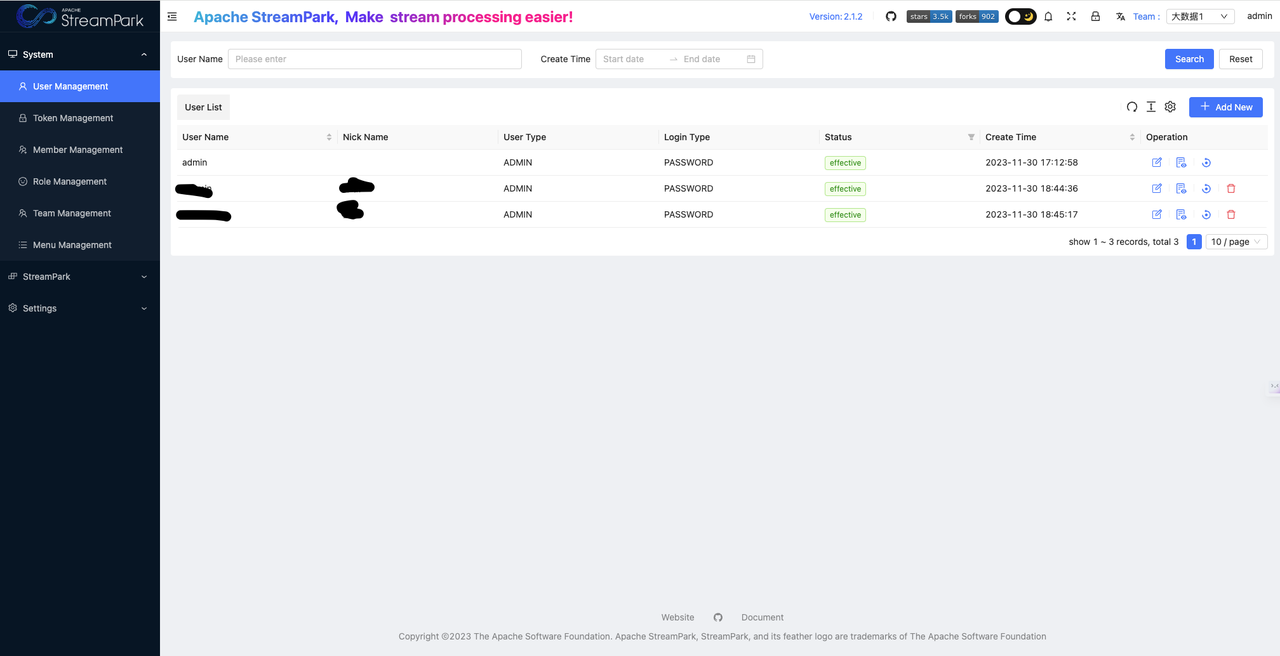

一、登陆

二、 平台初始化配置

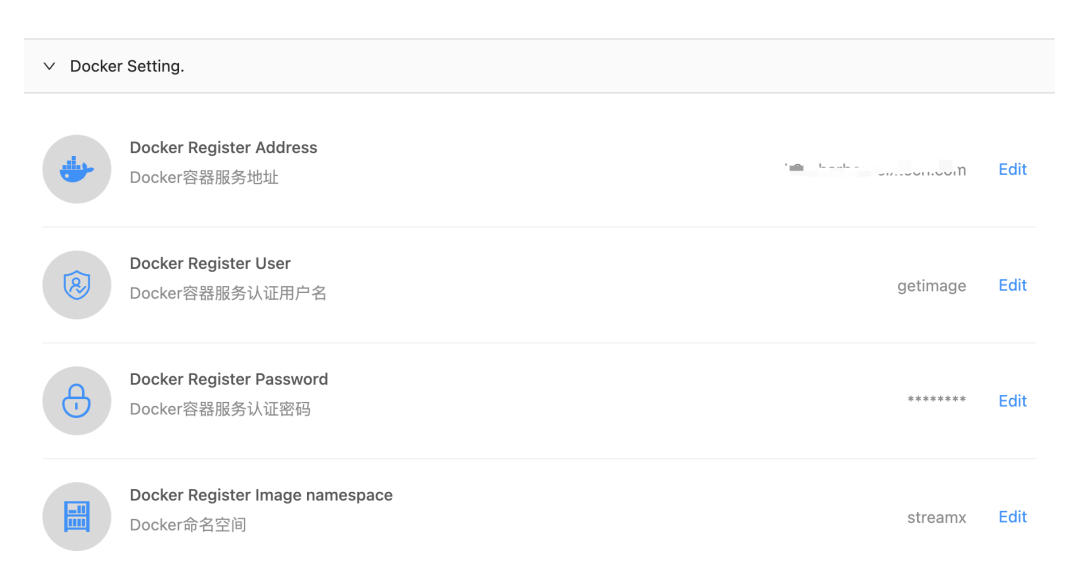

2.1 配置Docker Register

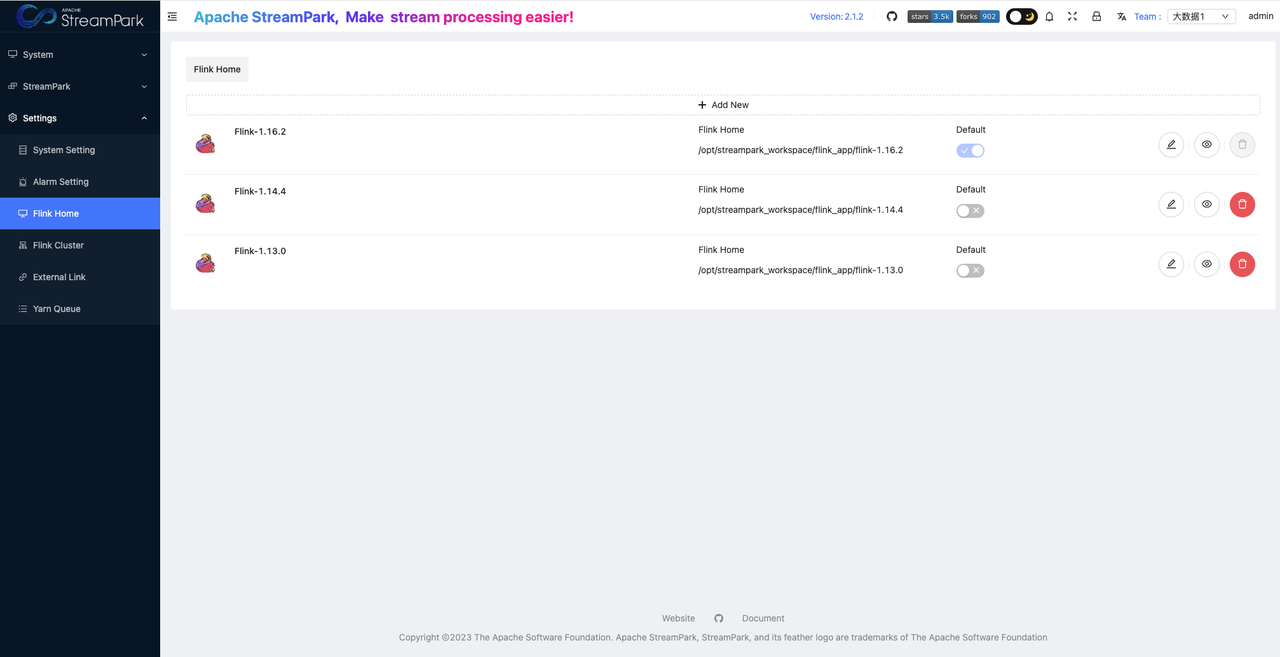

2.2 配置Flink Home

注:按需配置,需要下载好flink的安装包,建议放到nfs共享文件夹中,即使streampark宕机恢复也不影响

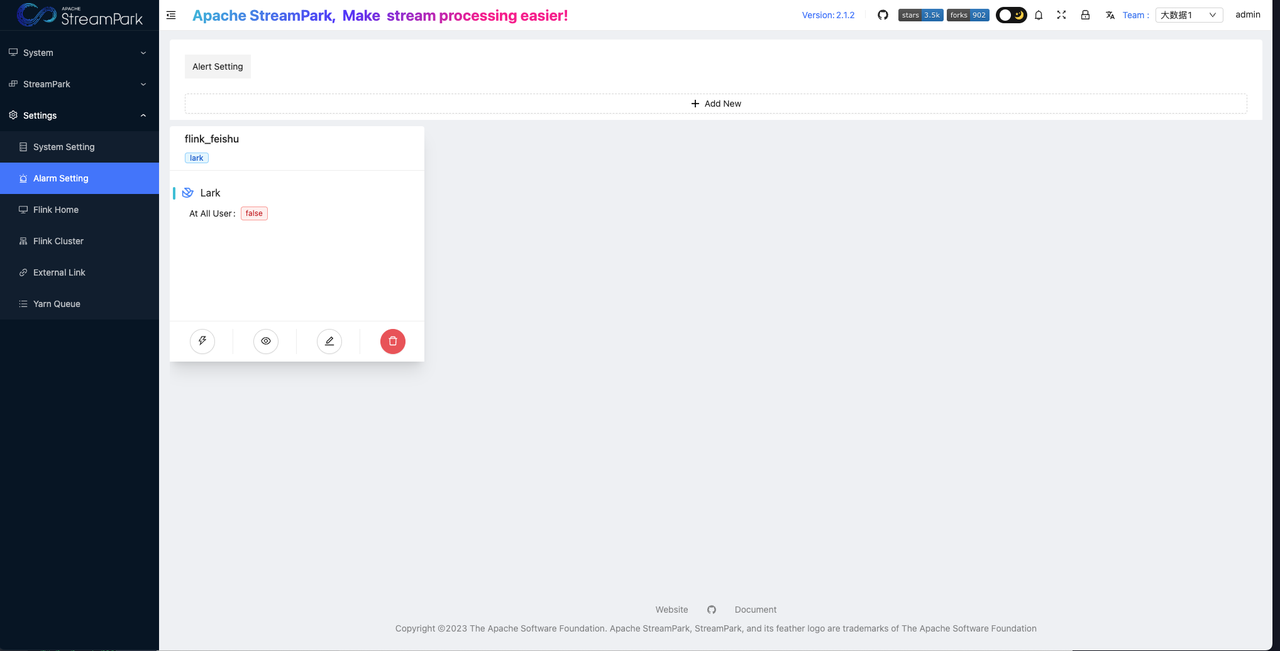

2.3 告警配置

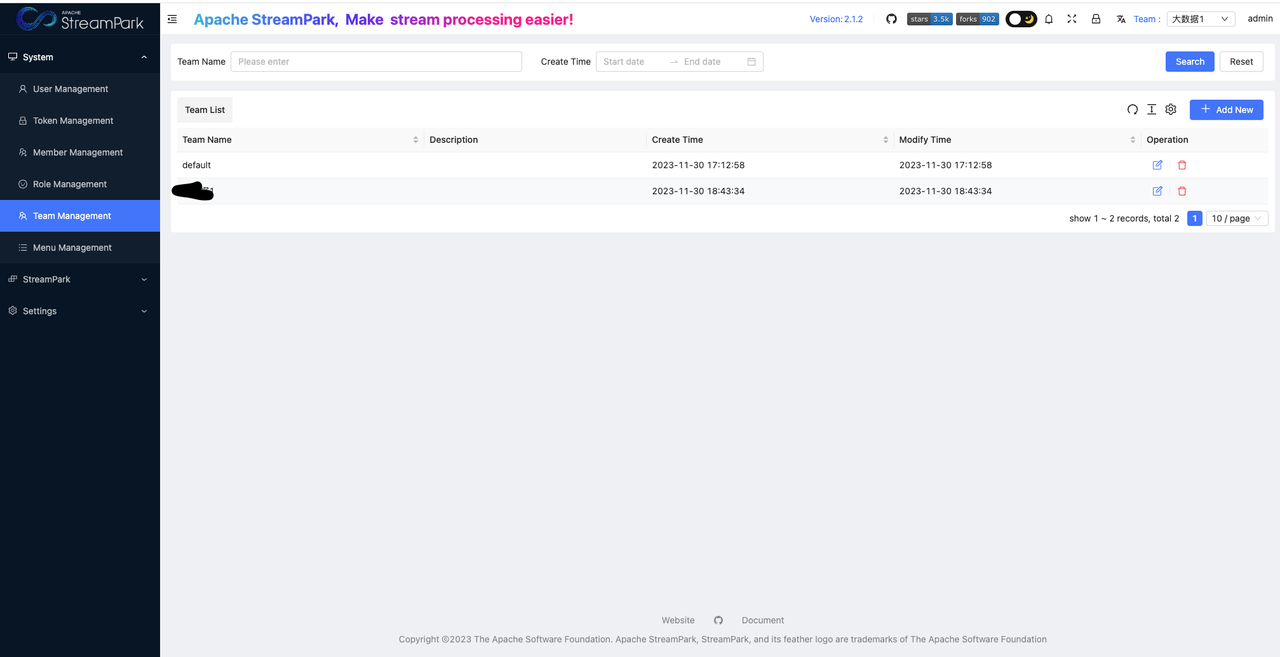

2.4 团队管理

为了方便管理公司内不同部门的作业,StreamPark 支持了团队管理。系统管理员可以在 StreamPark 上为不同部门创建不同的团队。

团队类似于工作空间的概念,当选择团队后平台只会展示当前团队的作业和项目。如果用户在多个团队有权限,切换到其他团队即可查看或操作相应团队的作业。

2.5 权限配置

注:

ADMIN 创建或修改用户时可以指定用户类型,用户类型有 ADMIN 和 USER 两种。

- ADMIN 表示系统管理员,即:StreamPark 的超级管理员,有 StreamPark 管理页面以及各个团队的所有权限。

- USER 表示平台的普通用户。创建 USER 只是创建账号的过程,默认普通用户在平台没有任何权限。创建 USER 后且系统管理员给 USER 在一些团队绑定角色后,USER 才会在相应团队有权限。

三、k8s集群初始化配置

基础环境配置包括 Kubernetes 和 Docker 仓库信息以及 Flink 客户端的信息配置。对于 Kubernetes 基础环境最为简单的方式是直接拷贝 Kubernetes 节点的 .kube/config 到 StreamPark 节点用户目录,之后使用 kubectl 命令创建 Flink 专用的 Kubernetes Namespace 以及进行 RBAC 配置。

# 创建Flink作业使用的k8s namespace

kubectl create namespace flink

kubectl create serviceaccount flink

# 对flink用户进行RBAC资源绑定

kubectl create clusterrolebinding flink-role-bind --clusterrole=edit --serviceaccount=flink:flink

四、任务发布

StreamPark 做好基础环境配置之后只需要三步即可开发部署一个 Flink 作业:

StreamPark 既支持 Upload Jar 也支持直接编写 Flink SQL 作业, Flink SQL 作业只需要输入SQL 和 依赖项即可, 该方式大大提升了开发体验, 并且规避了依赖冲突等问题,对此部分本文不重点介绍。

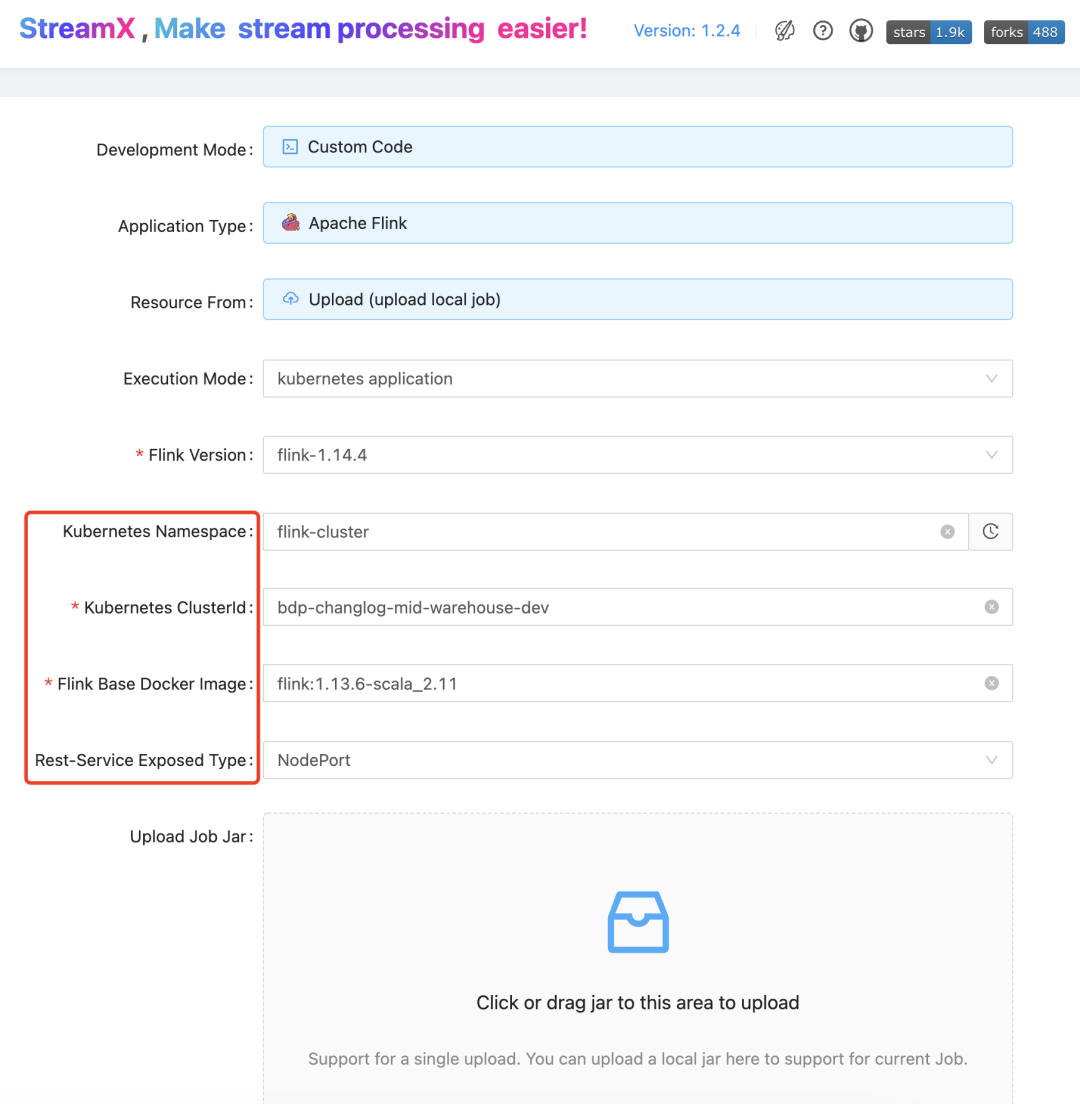

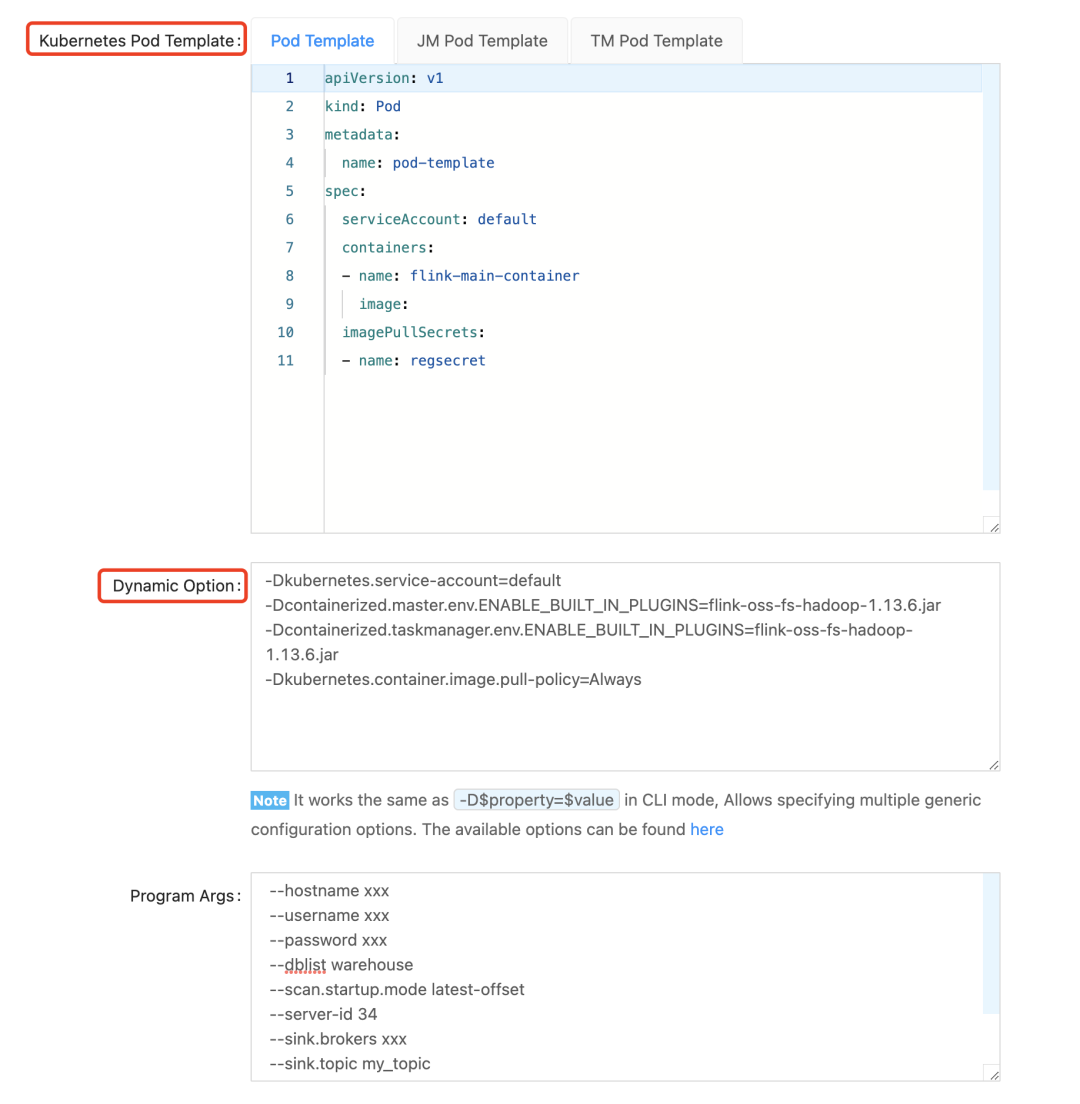

这里需要选择部署模式为 kubernetes application, 并且需要在作业开发页面进行以下参数的配置:红框中参数为 Flink on Kubernetes 基础参数。

配置说明:

Kubernetes Namespace:flink任务建议统一放入flink命名空间内

Kubernetes ClusterId:任务名自定义即可

Flink Base Docker Image :storage/bigdata/flink:1.13.0-scala_2.12-java8s、torage/bigdata/flink:1.14.4-scala_2.12-java8、storage/bigdata/flink:1.16.2-scala_2.12-java8(如需新的版本可自行添加)

Rest-Service Exposed Type:如需进入flink的网页端页面选用NodePort,不需要进入则选用ClusterIp,不要用loadbalancer,会进入公网ip

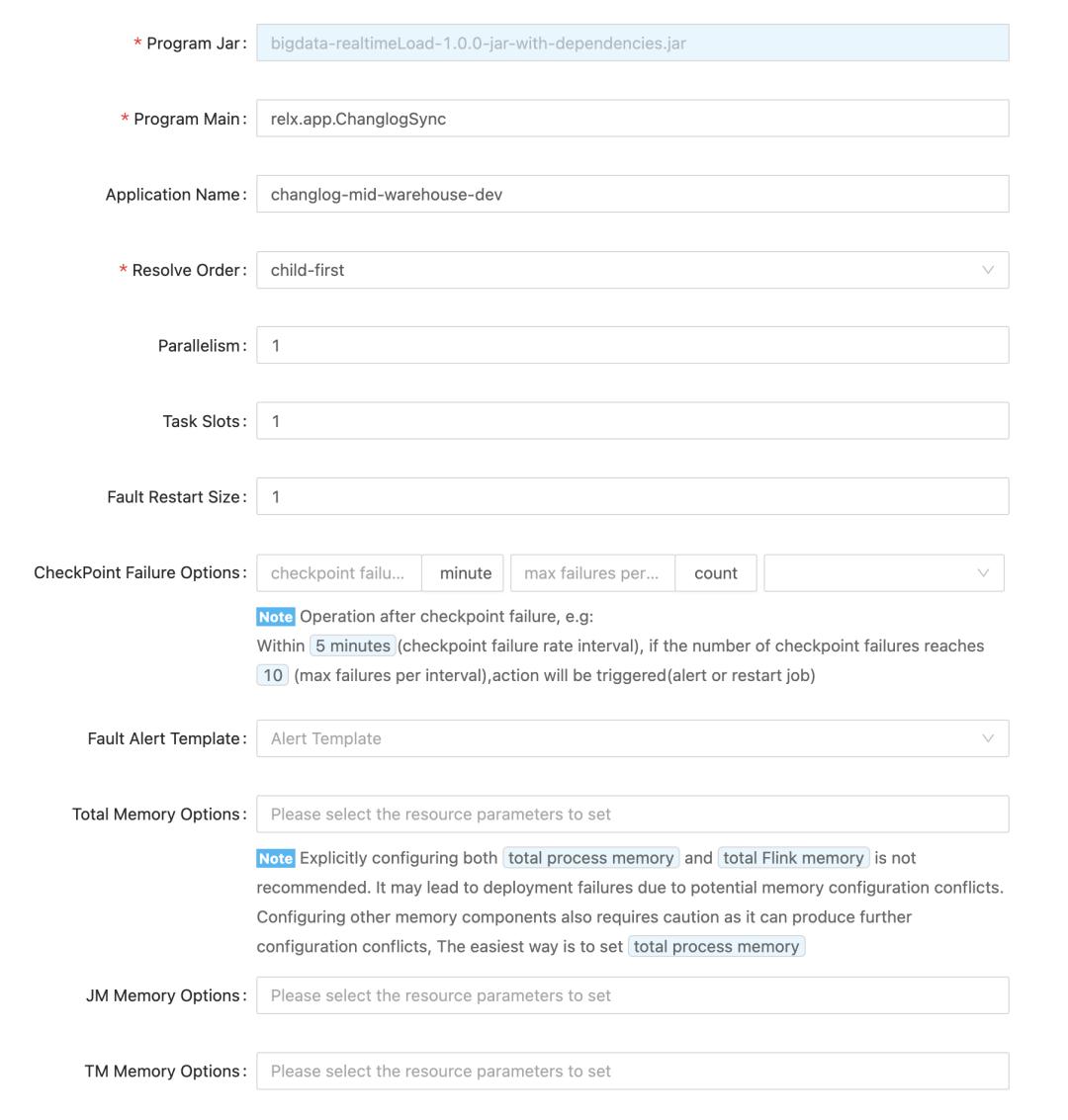

下面参数为 Flink 作业和资源相关的参数,Resolve Order 的选择与代码加载模式有关,对于 DataStream API 开发的 Upload Jar上传的作业选择使用 Child-first,Flink SQL 作业选择使用 Parent-first 加载。

最后就是下面这两个重量级参数了,对于 Native Kubernetes 而言,k8s-pod-template 一般只需要进行 pod-template 配置即可,Dynamic Option 是 pod-template 参数的补充,对于一些个性化配置可以在 Dynamic Option 中配置。更多 Dynamic Option 直接参考 Flink 官网即可。

测试用:

生产用

Pod Template配置

apiVersion: v1

kind: Pod

metadata:

#pod配置名称,不需要修改

name: pod-template

spec:

#选择k8s的namespace,与界面配置要一致

serviceAccount: flink

containers:

#flink启动的默认名称,不可更改

- name: flink-main-container

env:

#时区配置,默认时区与中国地区时区不一致

- name: TZ

value: Asia/Shanghai

image:

#持久化保存,容器内地址与nfs地址的映射

volumeMounts:

- name: data-flink

#容器内的地址

mountPath: /opt/flink/job

- name: data-streampark

mountPath: /log/streampark

imagePullSecrets:

- name: regsecret

#配置容器内的host,可自己调整,格式不要改

hostAliases:

- ip: "xxx"

hostnames:

- "xxx"

- ip: "xxx"

hostnames:

- "xxx"

- ip: "xxx"

hostnames:

- "xxx"

#与上述volumeMounts对应,配置实际的分布式或者本地地址

volumes:

- name: data-flink

#公司nfs地址配置,配置前需要检查nfs中是否有该文件夹

nfs:

path: /data_flink

server: xxx

- name: data-streampark

nfs:

path: /data_streampark

server: xxx

Dynamic Properties

#K8s的service账户,flink命令空间使用flink即可

-Dkubernetes.service-account=flink

#容器镜像拉取策略,建议是always(否则更新配置会不生效)。(Always 总是拉取镜像;IfNotPresent 本地有则使用本地镜像,不拉取;Never 只使用本地镜像,从不拉取,即使本地没有)

-Dkubernetes.container.image.pull-policy=Always

#checkpoint及savepoints持久化时配置

-Dstate.checkpoint-storage=filesystem

-Dstate.checkpoints.dir=file:///opt/flink/job/checkpoints/test

-Dstate.savepoints.dir=file:///opt/flink/job/savepoints/test

#log日志持久化时配置

-Dkubernetes.flink.log.dir=/opt/flink/job/logs/test

#与界面配置保持一致

-Dkubernetes.cluster-id=test

#flink任务高可用配置

-Dhigh-availability.type=kubernetes

-Dhigh-availability=org.apache.flink.kubernetes.highavailability.KubernetesHaServicesFactory

-Dhigh-availability.storageDir=file:///opt/flink/job/recovery/test

-Drestart-strategy=fixed-delay

-Drestart-strategy.fixed-delay.attempts=3

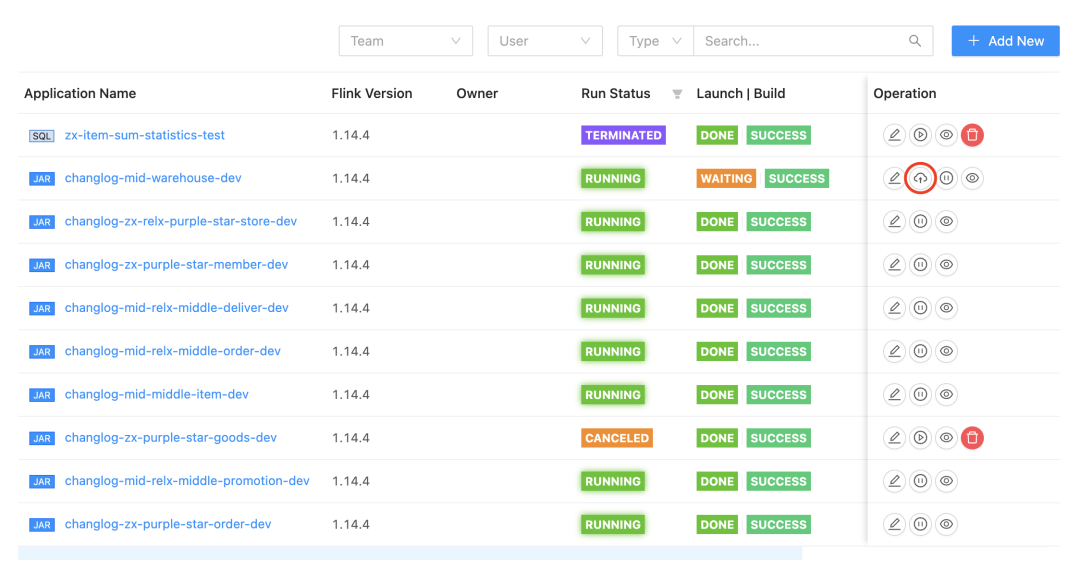

五、作业上线

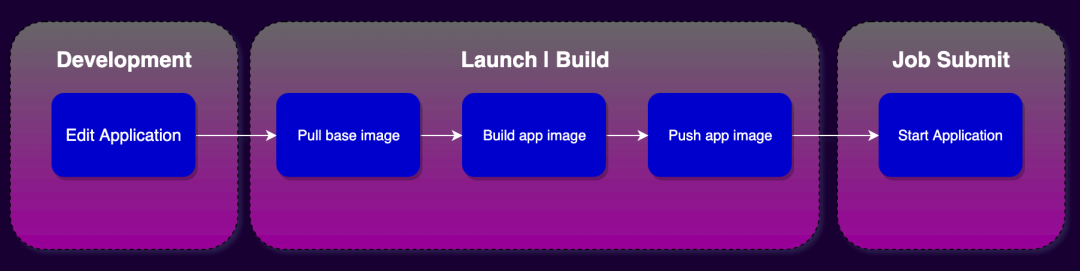

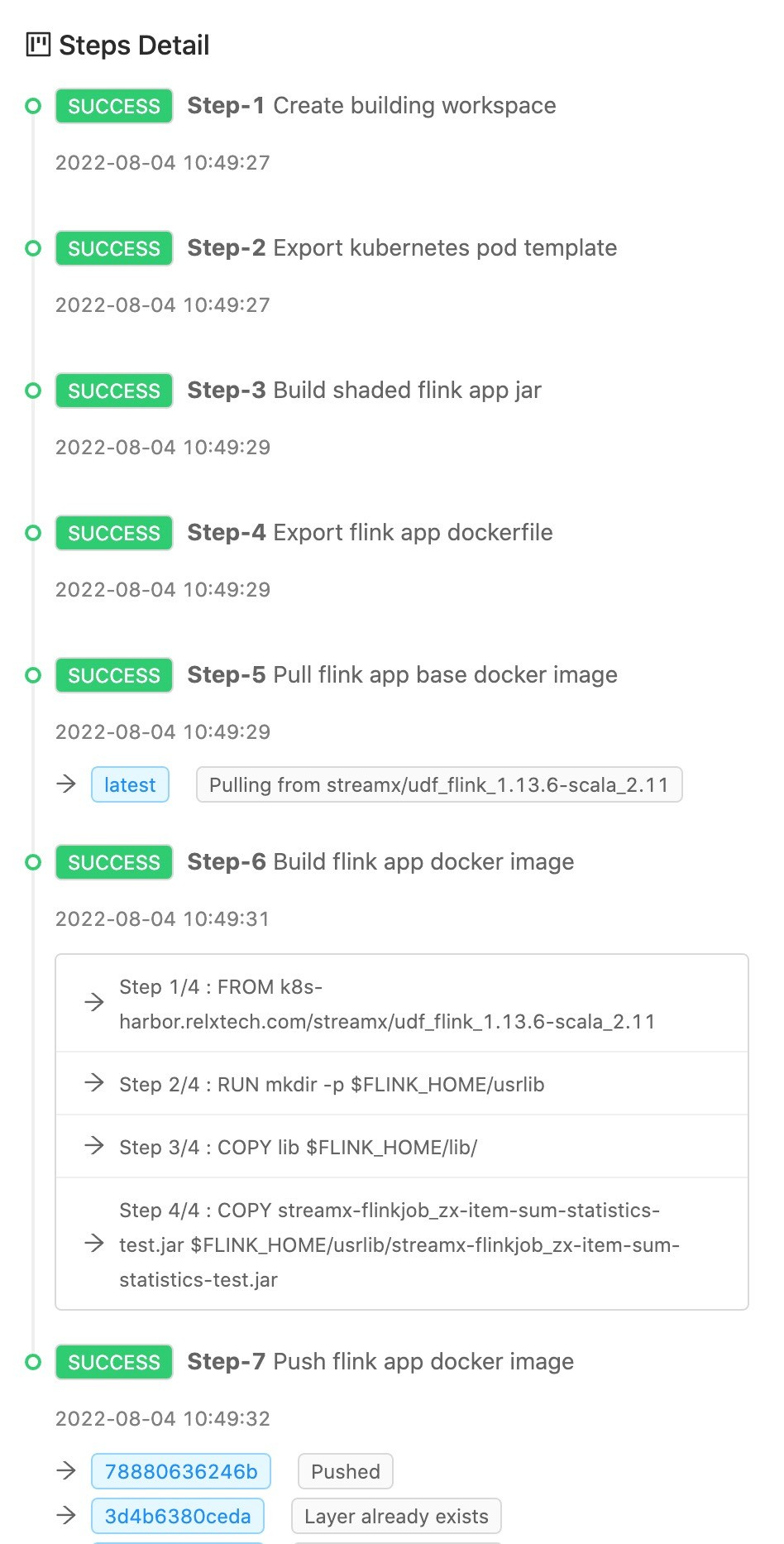

作业开发完成之后是作业上线环节,在这一环节中 StreamPark 做了大量的工作,具体如下:

- 准备环境

- 作业中的依赖下载

- 构建作业(打JAR包)

- 构建镜像

- 推送镜像到远程仓库

对于用户来说: 只需要点击任务列表中的云状的上线按钮即可。

在镜像构建和推送的时候我们可以看到 StreamPark 做的一系列工作: 读取配置、构建镜像、推送镜像到远程仓库…

六、作业提交

最后只需要点击 Operation 里 start Application 按钮便可启动一个 Flink on Kubernetes 作业,作业启动成功之后点击作业名便可跳转到 Jobmanager WebUI 页面、整个过程非常简单丝滑。

整个过程仅需上述三步,即可完成在 StreamPark 上开发和部署一个Flink on Kubernetes 作业。而 StreamPark 对于 Flink on Kubernetes 的支持远远不止提交个任务这么简单。

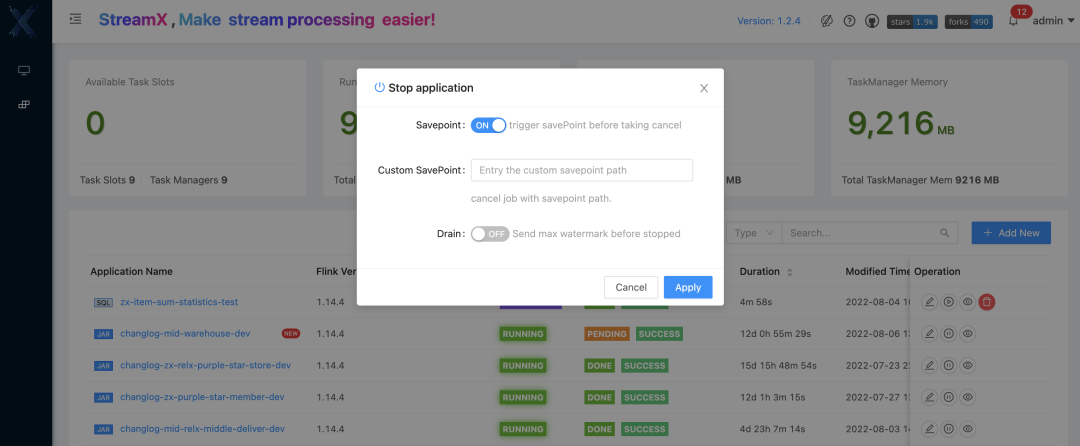

七、作业管理

任务恢复:

savepoint选择Dynamic Properties配置的地址+启动时创建的文件夹名(文件夹名需要去挂载的nfs上查看,且需要具体的chk名),

如配置为:-Dstate.checkpoints.dir=file:///opt/flink/job/checkpoints/test

此处应填写:/opt/flink/job/checkpoints/test/6b73526ea07b1c6b84b9aae159b05aaa/chk-32

八、StreamPark不足

- StreamPark不支持 Flink 作业 Metric 监控

- 每次增加作业都会形成一个新的镜像,镜像过大

- streampark:2.1.2版本腾讯k8s(TKE)安装存在bug,运行状态一直显示starting

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- Mac 下载 nvm 后执行nvm -v 命令报错 nvm: command not found

- 给自己创建的GPTs添加Action(查天气)

- Liunx Top命令

- 9. 总结

- 代码随想录算法训练营第五十三天|1143.最长公共子序列、1035.不相交的线、53.最大子序和(动态规划)

- RabbitMQ(不完整版)

- 工具系列:TensorFlow决策森林_(5)使用文本和神经网络特征

- 基于iOS真机的Appium自动化测试

- xtu oj 1055 整数分类

- sed流文本编辑器!一个linux下高效率处理文本的强大工具