QA 团队基于 DataLeap 开放平台能力的数据测试实践

背景 &痛点

随着生态体系扩展和业务发展,数据在业务中承担的决策场景越来越多样化,一部分数据已应用在资损、高客诉等高风险场景,因此对数据质量的要求,尤其是高风险场景的质量要求非常之高。但在保障过程中往往面临以下痛点:

-

无标准化流程,管控能力较弱

-

研发 QA 人力比高达 20:1,因此 QA 采用分级保障策略,QA 人力向高风险需求、资产变更倾斜,但是各业务对分级保障流程各有定义,且落地方式多为线下沟通人工约束,缺少标准化流程;

-

基于需求的研发测试在风险识别、提测内容、QA 测试等环节依赖人工判断和互相通知,有高风险需求遗漏出错的风险;资产的变更管控策略各有不同,复查人随意可选,且复查人判断的依据只有 CodeRview 信息,整体来看管控能力较弱。

-

2.?测试过程低效,测试管理杂乱

-

研发自测、QA 测试过程多为手动写 sql 模式,效率低下且测试过程分散,需要在等多个平台操作切换,缺乏一站式的测试工具;

-

测试用例设计多为个人经验,分散在各个测试报告中,无统一的用例管理;各业务测试报告各有不同,大多按照研发、QA 的个人经验输出,可读性不高,缺乏统一的测试管理。

解法

方案

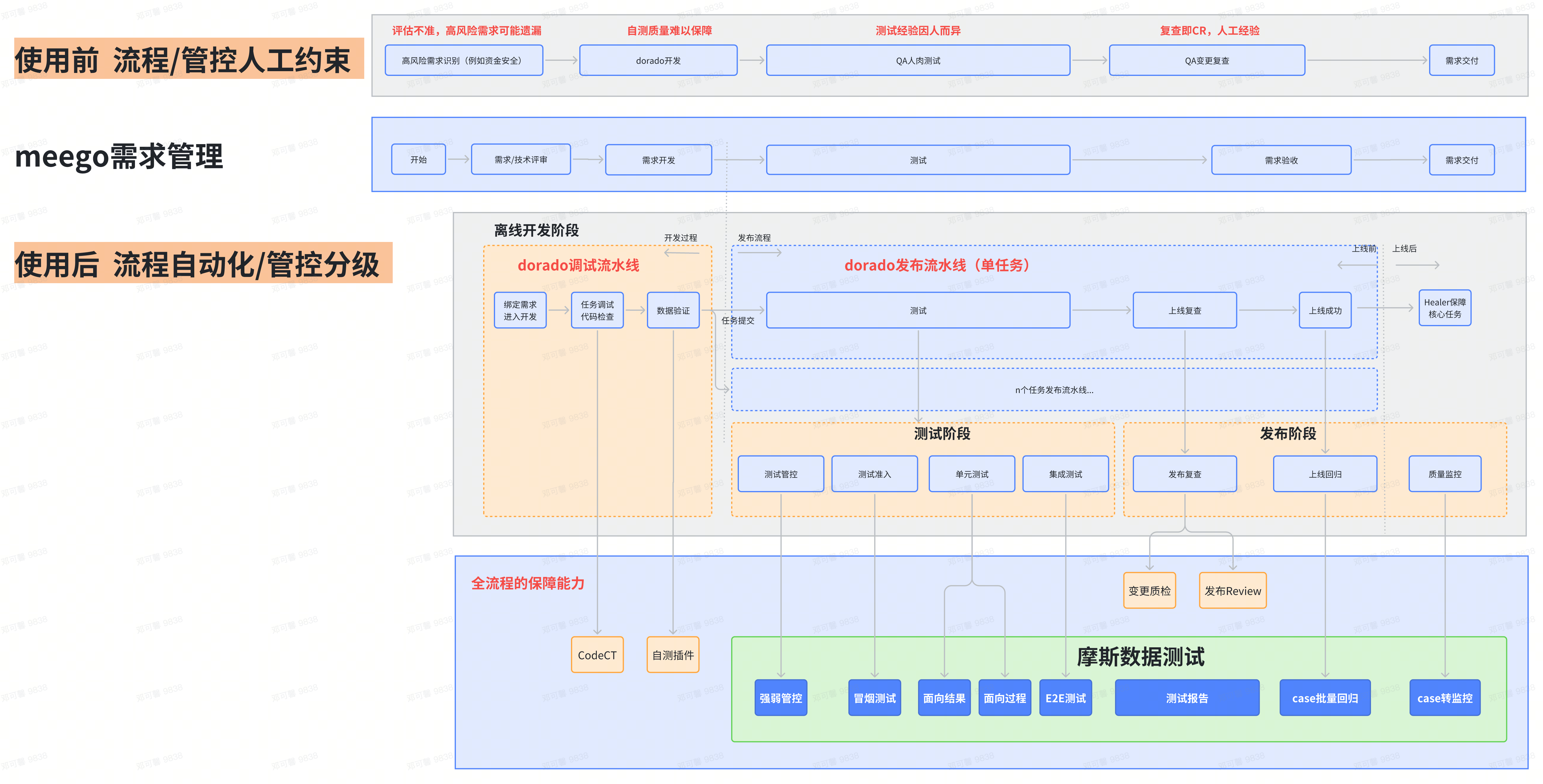

流程标准化

整体设计

DataLeap 开放平台支持用户自定义扩展程序能力,扩展程序可以订阅 DataLeap 侧 OpenEvent 监听用户操作、通过 OpenAPI 与 DataLeap 开放平台进行丰富的交互实现用户行为管控;还提供将 N 个扩展程序以流水线的形式编排的能力。基于此,QA 测试环节以扩展程序「摩斯数据测试」落地,并且通过流水线的能力接入:

-

研发测试流程

-

使用前:人工约束,需求和资产变更的研发测试流程靠人判断、登记、通知、协同;

使用后:全自动化的分级保障,从开发、自测、QA 测试、发布过程全自动化模式。

-

2.?管控能力

-

使用前:人工判断管控粒度;

使用后:拓展程序自动决策管控粒度,通过对项目管理平台(meego)需求、任务的风险识别,自动判断管控分级策略,分为 QA 测试的强管控和研发自测 QA 验收的弱管控。

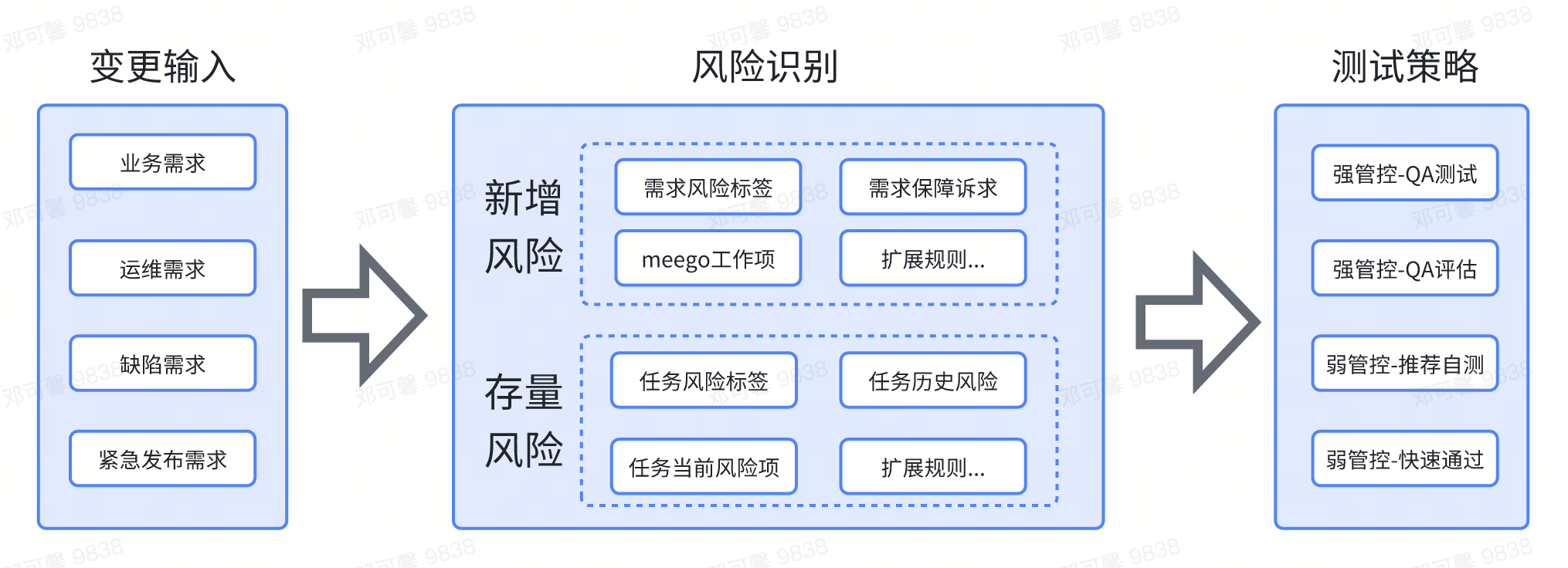

风险识别

「摩斯数据测试」拓展程序接入流水线可实现研发测试流程自动化和管控分级,但是对强弱管控的判断依据,如何比人工判断精准度更高?这就是接下来要思考的如何做风险识别?我们围绕「新增风险」和「存量风险」,设计以下风险识别规则:

-

新增风险:基于 Dataops 中需求管理功能的设定,所有变更的风险都来源于项目管理平台,我们把项目管理平台信息抽象成代码可识别的规则项;

-

存量风险:围绕「资产」从质量角度对资产分级打标、风险盘点,并把任务标签、当前风险项、历史风险等作为代码可识别的规则项,作为风险识别的依据之一。

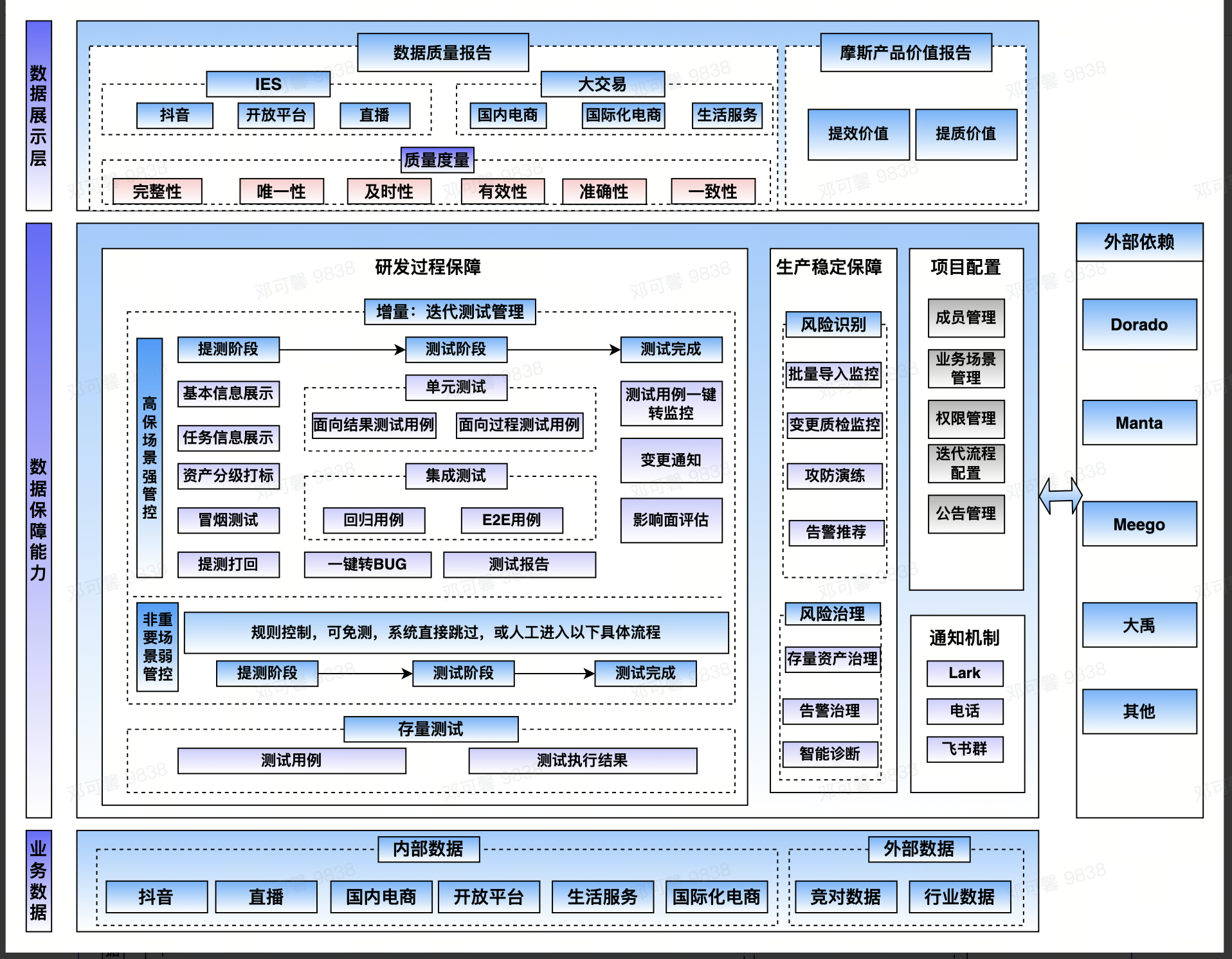

测试平台化

架构设计

从全流程测试管理能力要求出发,我们把测试过程总结为以下几个部分:

Step 1 :测试准入,提测内容,冒烟测试

Step 2:测试过程,case 生成、单元测试,集成测试,回归测试

Step 3:测试准出,测试报告,影响面评估

Step 4:上线保障,case 转监控

基于这个过程,「摩斯数据测试平台」架构设计如下:

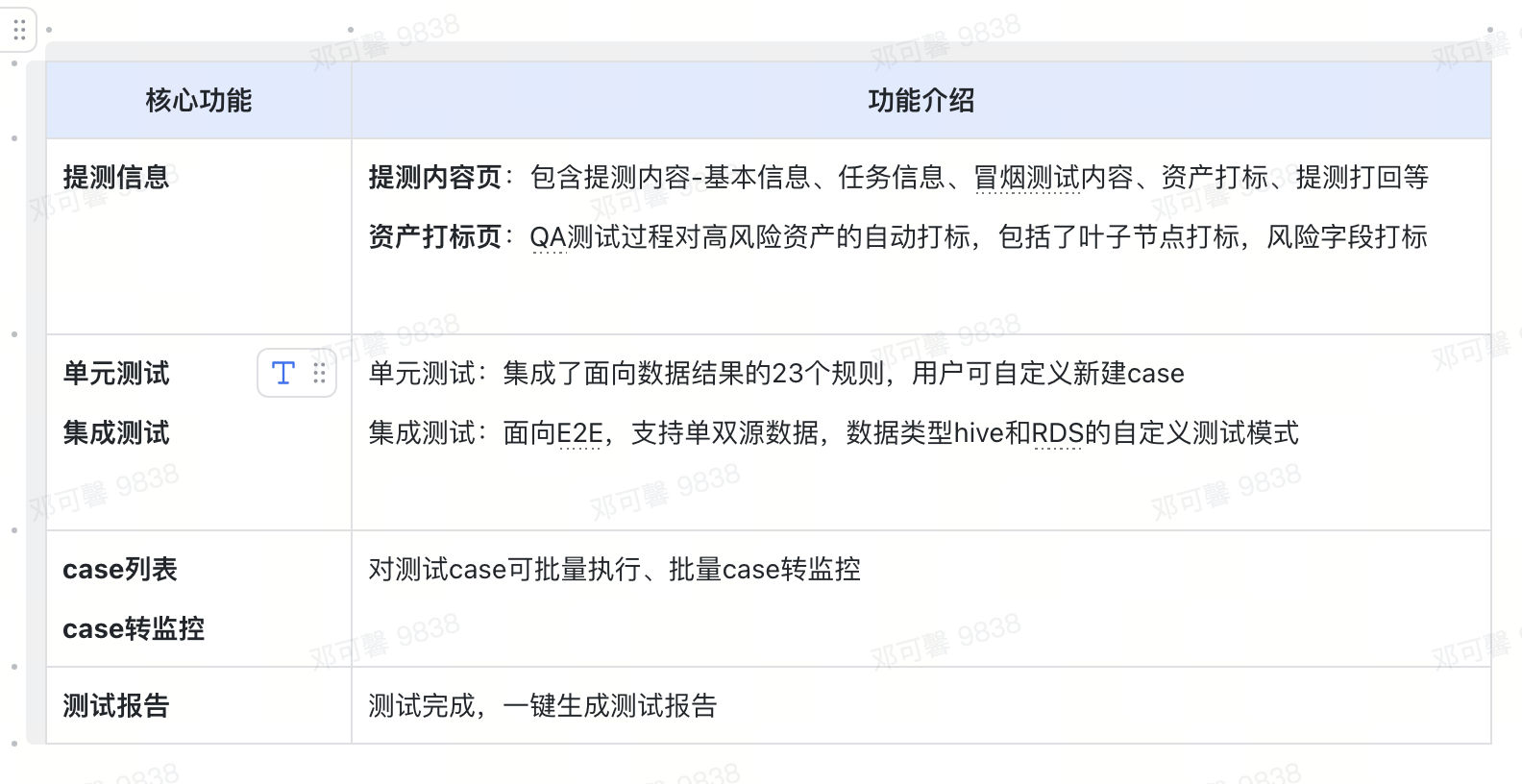

落地实现

「摩斯数据测试平台」1.0 版本已上线,基本实现了 QA 测试全过程的自动化能力,目前落地实现效果如下:

业务案例

背景

以 QA 团队在某直播业务中参与质量保障过程为例,QA 同学面临高风险需求多、高风险资产多、变更频次多的情况,以 2023 Q3 为例,高风险需求 55+个,高风险资产 296+个(占比 2.6%),变更次数 503+次;QA 同学面临如何保障高风险变更可管控无遗漏,同时又解决 QA 人力负载高测试成本高的问题?

应用

Step 1 :基于项目管理平台、任务的高风险标签流程落地

高风险标签流程:

-

项目管理平台要求业务提需时明确高风险场景,规范项目管理平台标签

-

直播任务标签,由 QA 统一推进,落地「资损」「高客诉」标签

Step 2: 协同研发,共建流水线流程

直播数仓流水线采用分级管控的策略,QA 节点对变更任务全面覆盖:

-

D1~D3 任务,调试管控,提交管控 codeCT/自测检查/ QA 测试

-

D4 D5 任务快速发布,提交管控 codeCT/QA 测试

Step 3:明确高风险规则,明确 QA 触达规则

-

高风险规则的自定义配置:

项目管理平台需求高风险标签

-

命中风险标签,均走流水线 QA 测试管控

-

未命中强管控规则,自动快速跳过

任务高风险标签

-

发布变更管控,使用发布复查能力,QA 参与变更复查

-

QA 触达规则:明确 QA 接口人信息

同一需求任务变更过程,包括提测、修复信息全部集成流水线、机器人触达消息到指定 QA 同学

Step 4:研发团队宣讲流程,推进落地;QA 团队落地使用,助力测试提效

-

QA 同学在直播数仓方向多个小组宣讲,推进基于流水线能力的研发测试流程落地

-

直播 QA 同学的测试过程由线下转向平台,节省了编写 case、case 执行、报告编写、监控配置的人工执行过程,对测试效率提升有一定帮助

收益和规划

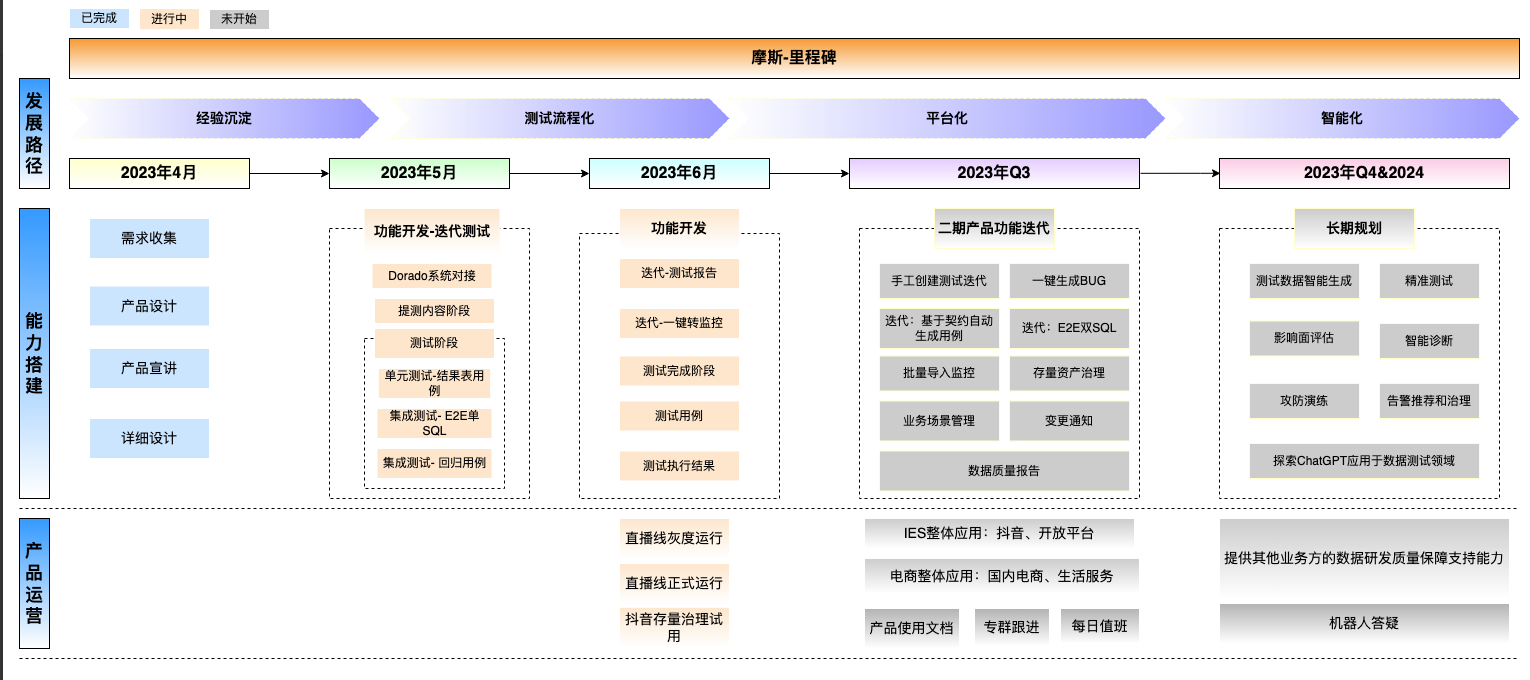

基于扩展程序的「摩斯数据测试」1.0 版本在 7 月初上线以来,已初步具备流程标准化、测试平台化能力;截止 8 月底平台已覆盖了 DataLeap 8 个项目空间,1334 个任务管控,QA 强管控 470 例,自动转监控 380 例,粗略统计目前已经在测试过程节省 QA 同学约 30%的人力投入。

未来将围绕平台的稳定性建设,实时数据测试的支持能力,基于通用经验、语义分析和代码契约智能生成测试场景等能力等继续推进,未来向测试智能化发展。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- vivado 平台板流程

- 阿里云服务器经济型e实例和云服务器u1实例区别?哪个性能优?

- 架构师的36项修炼-09架构实战案例分析

- H5ke15--1--文本管理器拖进来

- Kubernetes - Dashboard Token 访问登录永不过期配置

- 极智一周 | AI大模型应用、AI发展系列、Animate Anyone、自动驾驶芯片、DRIVE And so on

- AWTK 开源串口屏开发(5) - MCU端 SDK 用法

- SCI一区级 |【GWO-Attention-CNN-GRU】基于灰狼算法优化注意力机制卷积神经网络结合门控循环单元实现数据多维输入单输出预测附matlab代码

- Spring ‘24:不容错过的Salesforce Flow 10大新功能!

- 【华为OD机试真题2023C&D卷 JAVA&JS】执行任务赚积分