基于随机颜色反转合成和双分支学习的单模态内镜息肉分割

Single-Modality Endoscopic Polyp Segmentation via Random Color Reversal Synthesis and Two-Branched Learning

基于随机颜色反转合成和双分支学习的单模态内镜息肉分割

2022 IEEE International Conference on Bioinformatics and Biomedicine (BIBM)

背景

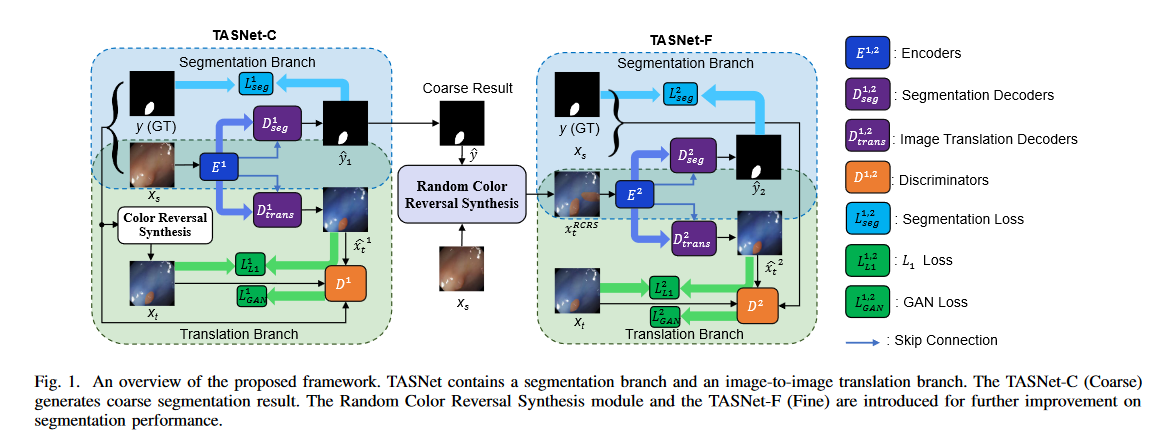

内镜下息肉分割在癌症的诊断和治疗中起着重要作用。然而,由于息肉的外观变化大、边界模糊和光照严重不平衡,其分割精度往往有限。在本文中,我们提出了一种新的翻译辅助分割网络(TASNet),用于单模态内窥镜图像的息肉分割。它由两个分支组成,即图像到图像转换分支和图像分割分支。这两个分支通过共享编码器进行通信。对于图像到图像的转换分支,建立了一种颜色反转策略,将原始图像作为源图像并合成目标图像。此外,我们还介绍了一个用于渐进分割的随机颜色反转合成模块。大量实验表明,在五个广泛使用的内窥镜图像数据集上,我们的框架比最先进的方法实现了更高的性能。

难点

现有的分割方法在息肉分割中往往存在精度低的问题,主要有三个原因。

首先,息肉的外观,包括质地、大小、形状和颜色,随着不同类型和内镜摄像机角度的不断变化而有很大的差异。

其次,在某些情况下,息肉和背景组织之间的边界可能非常模糊和难以区分。

第三,内窥镜图像可能涉及高度不平衡的照明。这些问题极大地影响了现有方法的适用性,从而导致息肉分割结果不令人满意。

贡献

本文的主要贡献如下

- 我们提出了一种新的用于内镜息肉分割的双分支网络。有了所提出的TASNet,特别是图像到图像翻译分支的帮助,单模态医学图像的分割变得可行和有效。

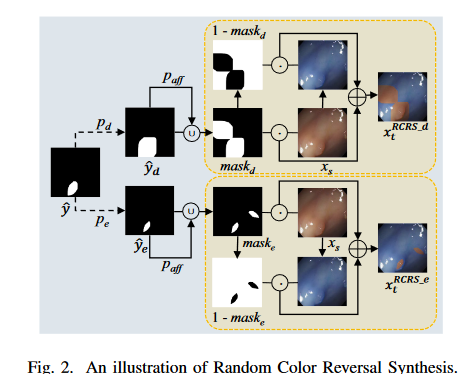

- 我们设计了一个随机颜色反转合成模块来合成TASNet的目标图像。该模块与TASNet一起,能够进一步改进息肉分割。

- 在五个广泛使用的内窥镜图像数据集上进行了广泛的实验。与最先进的方法相比,在所有数据集上都取得了有希望的结果。

实验

方法

两个双分支的网络,第一个双分支为粗分割和合成,第二个双分支为精细分割和合成

Color Reversal Strategy(颜色反转策略)

单一模态,通过颜色翻转策略生成辅助模态,以突出病灶区域,鼓励编码器更好的学习病灶特征

颜色反转背后的动机是在内窥镜图像中突出息肉区域。由于内窥镜图像的整体颜色是红色或其他暖色,因此红色通道中的像素值通常较高。颜色反转后,相反的颜色最大程度地突出息肉,同时保留了图像的原始纹理和照明信息

损失函数

合成损失、GAN损失、分割损失

Thinking

使用物理方法生成一个能清晰观察到病灶的模态,再通过合成、分割联合框架学习与病灶相关的特征,以增强语义分割的效果,在五个内窥镜图像数据集上测试均有提升,可见这种方式可以增强内窥镜图像中病灶的分割。是否有可能是隐式的多了数据增强?

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- LeetCode Hot100 215.数组中的第k个最大元素

- window的OPen方法,弹窗的特征

- 力扣40. 组合总和 II(java 回溯法)

- 2024年重磅第一篇----------------------““打造自己的赚钱机器!!!““

- bilibili深入理解计算机系统笔记(3):使用C语言实现静态链接器

- js字符串替换

- 多喜爱家纺升级BI系统:顺应时代潮流,提升企业竞争力

- 【Java SE语法篇】6.数组

- arm芯片安装lxml报错 libxslt.so.1: cannot open shared object file

- Git保姆级安装教程