将Llama2上下文长度扩展100倍;效率更高的SeTformer;LLM准确度基本不变加速1.56×;FreeTalker

本文首发于公众号:机器感知

将Llama2上下文长度扩展100倍;效率更高的SeTformer;LLM准确度基本不变加速1.56×;FreeTalker

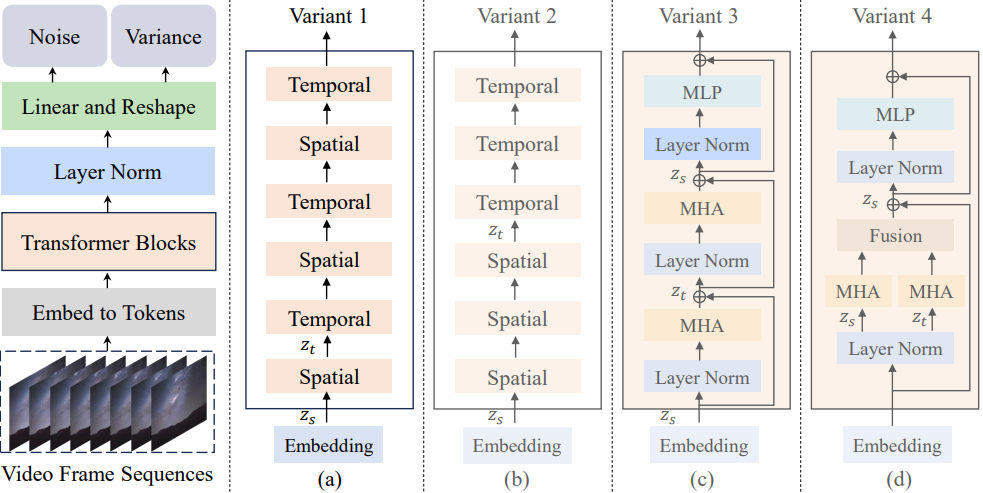

Latte: Latent Diffusion Transformer for Video Generation

本文使用Latent Diffusion Transformer(Latte)做视频,首先从输入视频中提取时空tokens,然后采用一系列Transformer块来建模潜在空间中的视频分布。为了建模从视频中提取的大量tokens,作者从输入视频的空间和时间的角度引入了四种高效变体。实验结果表明,Latte在四个标准视频生成数据集(FaceForensics、SkyTimelapse、UCF101和Taichi-HD)上实现了SOTA性能。此外,作者还将Latte扩展到文本到视频生成(T2V)任务,且Latte取得了与最近的T2V模型相当的结果。

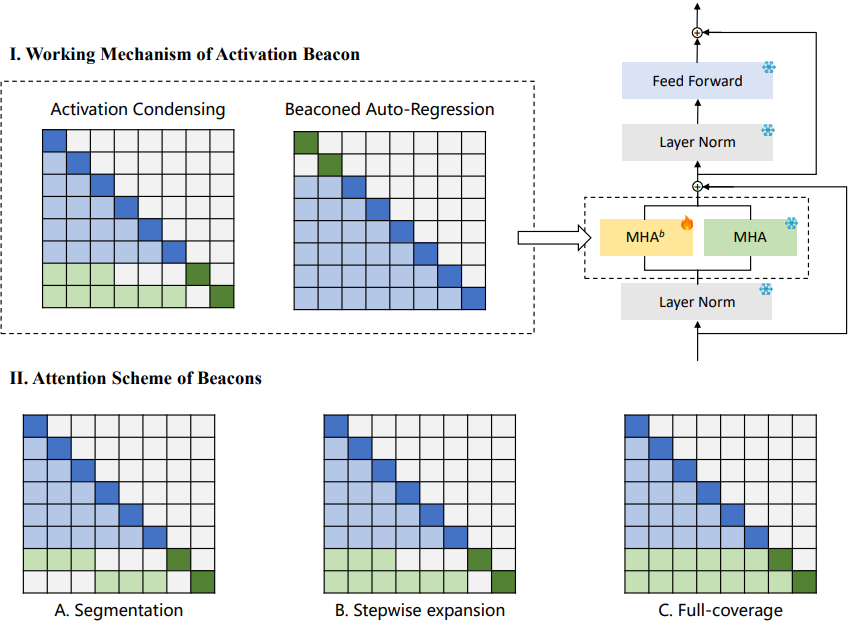

Soaring from 4K to 400K: Extending LLM's Context with Activation Beacon

本文提出了一种名为Activation Beacon的模块,可以用于扩展大语言模型(LLM)处理长上下文的能力。该模块通过压缩LLM的原始激活来感知更长的上下文,与此同时保持LLM在处理短上下文时的原始能力。此外,该模块使用短滑动窗口处理长上下文,提高了在训练和推理时的内存和时间效率。该模块通过自回归任务进行训练,仅需10K步和少量GPU时间即可完成训练。实验结果表明,Activation Beacon可以将Llama-2-7B的上下文长度扩展100倍(从4K扩展到400K),同时在长上下文生成和理解任务上取得了很好的结果。

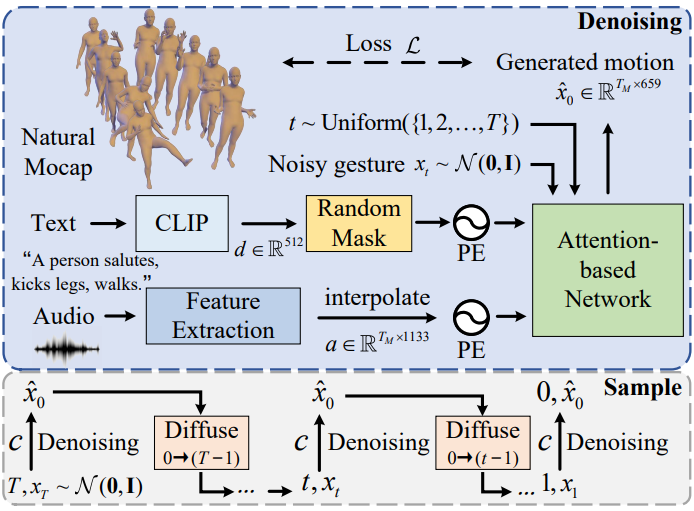

Freetalker: Controllable Speech and Text-Driven Gesture Generation Based on Diffusion Models for Enhanced Speaker Naturalness

本文提出了一种名为FreeTalker的框架,用于生成自发(如伴随言语的手势)和非自发(如演讲者在讲台上的移动)的演讲者动作。该框架利用了来自不同动作数据集的异构数据,训练了一个基于扩散模型的演讲者动作生成器,该模型使用统一的表示形式来驱动言语手势和文本动作。在推理过程中,使用CFG来控制clips的风格。此外,为了创建clips之间的平滑过渡,作者使用了DoubleTake方法,该方法利用生成先验并确保无缝的运动混合。实验结果表明,该方法能够生成自然且可控的演讲者动作。

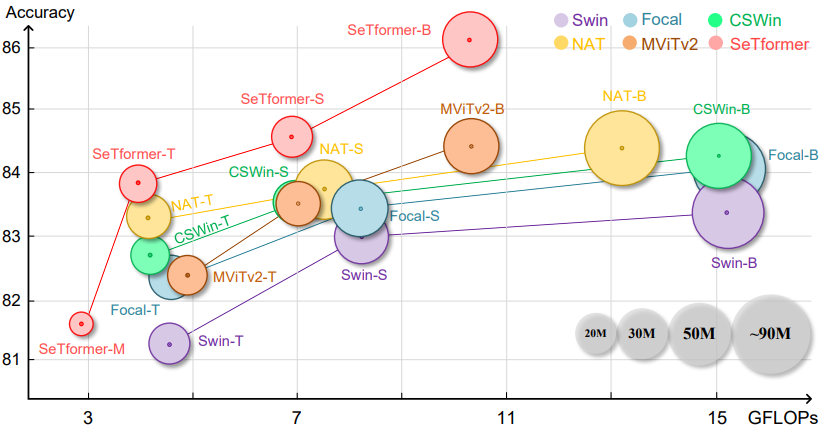

SeTformer is What You Need for Vision and Language

本文提出了一种名为SeTformer的新型Transformer,该模型通过将点积自注意力(DPSA)完全替换为自我最优传输(SeT)来提高性能和计算效率。SeT基于两个重要的softmax属性,并通过引入核代价函数来实现这些属性。在小型和基础模型上,SeTformer在ImageNet-1K上实现了84.7%和86.2%的top-1准确率。在目标检测中,SeTformer-base比FocalNet高出2.2 mAP,参数和FLOPs分别减少了38%和29%;在语义分割中,基础模型比NAT高出3.5 mIoU,参数减少了33%;SeTformer还在GLUE语言建模任务中取得了最佳结果;这说明SeTformer适用于视觉和语言任务中。

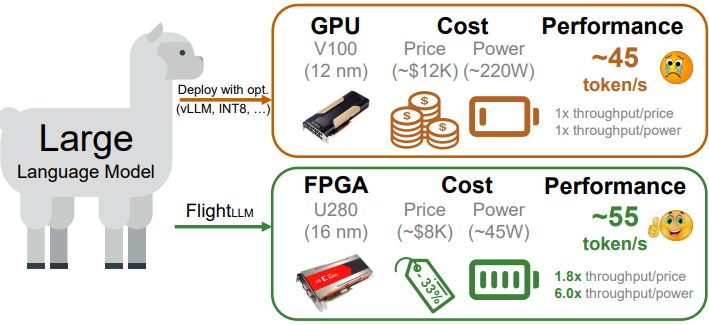

FlightLLM: Efficient Large Language Model Inference with a Complete Mapping Flow on FPGA

Transformer-based大语言模型(LLMs)在多个领域产生了重大影响,但计算和内存开销过大。常用的压缩技术缓解了LLM计算/内存开销与硬件限制的差距,但现有的GPU和transformer加速器无法高效处理压缩的LLM,因为存在计算效率低、内存带宽未充分利用和编译开销大等问题。本文提出了FlightLLM,通过在FPGA上实现完整的映射流实现LLM的高效推理。在FlightLLM中,作者利用FPGA特有的资源(如DSP48和异构内存层次结构)来解决LLM的计算和内存开销问题。还提出了一种可配置的稀疏DSP链,以高计算效率支持不同的稀疏模式。其次,还提出了一种always-on-chip的解码方案,以支持混合精度并提高内存带宽。

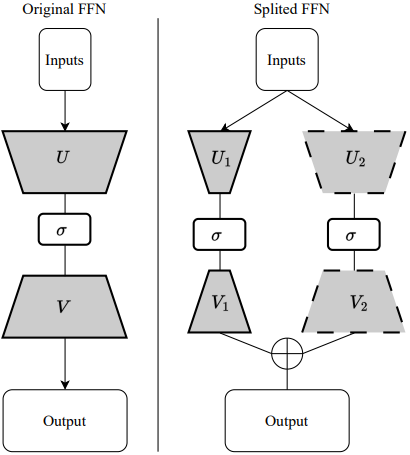

FFSplit: Split Feed-Forward Network For Optimizing Accuracy-Efficiency Trade-off in Language Model Inference

预训练语言模型(LLM)性能强大,但参数众多,难以在单GPU等硬件上部署。为降低模型大小和推理延迟,常采用模型压缩技术,但会影响模型准确性和效率。作者发现前馈网络(FFN)只有少数神经元对输入有大的输出范数(heavy hitters),据此,将FFN分为两部分,并为heavy hitters部分分配更多资源,从而平衡优化效率和准确性。此方法可使模型大小减少43.1%,加速1.25~1.56×,同时几乎不降低准确性。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- c语言之goto语句

- 【教程】React-Native代码规范与加固详解

- 异步http接口调用库:httpx

- 深入了解:5G技术将如何大规模影响安防视频监控领域

- matlab字符串标量或字符向量必须具备有效的解释器语法

- 【单片机】四种烧写方式简介

- 网络安全A模块(最全详解)

- CentOS查看修改时间

- 基于Java SSM框架实现学生综合考评作业成绩管理系统项目【项目源码+论文说明】计算机毕业设计

- 软件测试|深入理解Python中的re.search()和re.findall()区别