复杂背景下的低空无人机检测与跟踪算法

发布时间:2023年12月19日

doi:10.11884/HPLPB202335.230026

-

大视场中的目标丢失后需要再次检测,但是大视场的检测比较耗时。但是根据实验发现丢失目标通常发生在无人机运动区域的320x320范围内,所以设计辅助网络,当目标丢失后,以320x320区域图像作为输入,使用辅助网络进行目标检测,加快了检测速度。

-

主网络因为负责大视场的检测,其优化目标为对小目标的检测。主网络的输入尺寸为1024x1024。在SPPF前添加SE注意力;在预测部分增加小目标检测层提高小目标检测效果;设计特征图融合提高对8x8目标的检测。

-

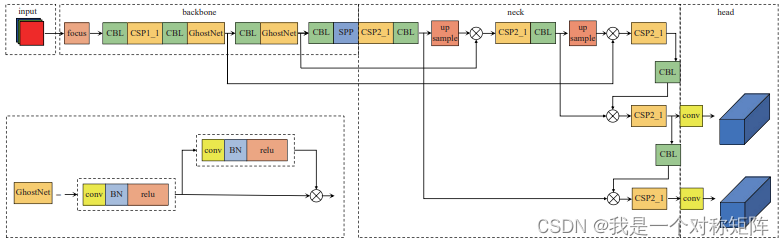

辅助网络用于在丢失点附近区域快速检测再次出目标,所以输入图像是实验总结出来的320x320,其优化目标为快。使用GhostNet替换大参数量的C3结构;去除了40x40的特征图;

特征图分辨率 最小检测目标(其映射到特征图至少需要1个像素点表示) 320x320 - 40x40 8x8,及以上 20x20 16x16,及以上 根据文中描述,无人机尺寸都在16x16以上,所以40x40检测8x8~16x16部分的没有使用到,而16x16以上的也可以从其他特征图被解码出来,所以其功能重合了,为追求速度舍去了40x40的特征图分支。

当然以上的前提是基于其映射到特征图至少需要1个像素点表示这样的认知,否则其信息就会没淹没在该特征图的背景中,不利于解码。 -

优化CSRT算法。该算法使用HOG特征进行匹配,而HOG中涉及金字塔算法,所以借助GPU并行能力进行速度优化。

-

特征点(打击点)提取算法:(a)起火时有非常明亮的光斑,直接二值化质心提取;(b)捕获时,OTSU二值化-先开后闭(去噪)-拉普拉斯边缘检测得到轮廓-求轮廓质心

值得借鉴的是:1)大小分辨率捕获模式,兼顾速度和性能;2)特征点的提取方法(虽然能够想到,但是看到大家都这么干证明该方法可行)。

文章来源:https://blog.csdn.net/qq_40243750/article/details/134997310

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- vue2自创项目——饭搭子项目总结

- 明基、书客、松下护眼台灯怎么样?三款热门台灯真实测评

- 基于鲸鱼优化算法优化VMD实现数据去噪附Matlab代码

- 算法通关村第一关——黄金挑战 | 环与双向链表

- 西电期末1003.奇偶数之和

- SolidUI Gitee GVP

- Redis-Day3实战篇-商户查询缓存(缓存的添加和更新, 缓存穿透/雪崩/击穿, 缓存工具封装)

- XTuner 大模型单卡低成本微调实战

- GitHub Copilot 快速入门

- 如何监控电脑屏幕-对电脑屏幕进行监控有什么方法?如何实现电脑屏幕监控?