kakfa实战指引-实时海量流式数据处理

前言

我们最终决定从头开始构建一些东西。我们的想法是,与其专注于保存成堆的数据,如关系数据库、键值存储、搜索索引或缓存,不如专注于将数据视为不断发展和不断增长的流,并围绕这个想法构建一个数据系统——实际上是一个数据架构。 ? 事实证明,这个想法的适用范围比我们预期的要广泛。尽管 Kafka 最初是在社交网络的幕后为实时应用程序和数据流提供支持的,但现在您可以在每个可以想象的行业中看到它成为下一代架构的核心。大型零售商正在围绕连续的数据流重新设计其基本业务流程;汽车公司正在收集和处理来自联网汽车的实时数据流;银行也在围绕 Kafka 重新思考其基本流程和系统。 ? 我们开始将 Kafka 视为一个流式处理平台:一个允许您发布和订阅数据流、存储它们并处理它们的系统,而这正是 Apache Kafka 的构建目的。习惯这种思考数据的方式可能与你习惯的方式略有不同,但事实证明,它是构建应用程序和架构的一个非常强大的抽象。Kafka 经常被拿来与现有的几个技术类别进行比较:企业消息传递系统、大数据系统(如 Hadoop)以及数据集成或 ETL 工具。这些比较中的每一个都有一定的道理,但也有些不足。 ? Kafka 就像一个消息传递系统,它允许您发布和订阅消息流。这样,它类似于 ActiveMQ、RabbitMQ、IBM 的 MQSeries 和其他产品等产品。但即使有这些相似之处,Kafka 与传统消息传递系统也有许多核心差异,这使它完全是另一种动物。这里有三个很大的区别:首先,它作为一个现代分布式系统工作,作为一个集群运行,可以扩展以处理即使是最大型公司的所有应用程序。这让您拥有一个可以弹性扩展以处理公司所有数据流的中央平台,而不是运行数十个单独的消息传递代理,手动连接到不同的应用程序。其次,Kafka 是一个真正的存储系统,可以随心所欲地存储数据。这在将其用作连接层方面具有巨大的优势,因为它提供了真正的交付保证——它的数据是复制的、持久的,并且可以随心所欲地保留。最后,流处理领域显著提高了抽象级别。消息传递系统大多只是分发消息。借助 Kafka 中的流处理功能,您可以使用更少的代码从流中动态计算派生流和数据集。这些差异使 Kafka 本身就足够了,以至于将其视为“又一个队列”是没有意义的。 ? 关于Kafka的另一种观点,也是我们设计和构建Kafka的动机之一,是将其视为Hadoop的一种实时版本。Hadoop 允许您以非常大规模的方式存储和定期处理文件数据。Kafka 允许您存储和持续处理数据流,也可以大规模存储和处理。在技术层面上,肯定有相似之处,许多人将流处理的新兴领域视为人们使用Hadoop及其各种处理层所做的批处理的超集。这种比较忽略了连续、低延迟处理所开启的用例与批处理系统自然产生的用例完全不同。虽然Hadoop和大数据以分析应用程序为目标,通常在数据仓库领域,但Kafka的低延迟特性使其适用于直接为业务提供动力的核心应用程序。这是有道理的:企业中的事件一直在发生,并且能够在事件发生时对它们做出反应,从而更容易构建直接为企业运营提供动力的服务,反馈到客户体验中,等等。

第一章 遇见Kafka

每个企业都由数据驱动。我们接收信息,分析它,操纵它,并创造更多的输出。每个应用程序都会创建数据,无论是日志消息、指标、用户活动、传出消息还是其他内容。每个字节的数据都有一个故事要讲,一些重要的东西将为接下来要做的事情提供信息。为了知道那是什么,我们需要将数据从创建位置获取到可以分析的位置。我们每天都在亚马逊等网站上看到这种情况,我们对感兴趣的商品的点击会转化为稍后向我们展示的推荐。

我们做得越快,我们的组织就越敏捷,响应速度就越快。我们在移动数据上花费的精力越少,我们就越能专注于手头的核心业务。这就是为什么管道是数据驱动型企业中的关键组件。我们如何移动数据变得几乎与数据本身一样重要。

每当科学家不同意时,都是因为我们没有足够的数据。然后,我们可以就获取什么样的数据达成一致;我们获取数据;数据解决了问题。要么我是对的,要么你是对的,要么我们都错了。我们继续前进。

—Neil deGrasse Tys

1 发布和订阅消息Publish/Subscribe Message

在讨论Apache Kafka 的细节之前,我们有必要了解发布/订阅消息传递的概念以及它的重要性。发布/订阅消息传递是一种模式,其特征是一段数据(消息)的发送者(发布者)不专门将其定向到接收者。相反,发布者以某种方式对消息进行分类,并且接收者(订阅者)订阅以接收某些类别的消息。发布/订阅系统通常有一个代理,一个发布消息的中心点,以促进这一点。

1.1 How It Starts

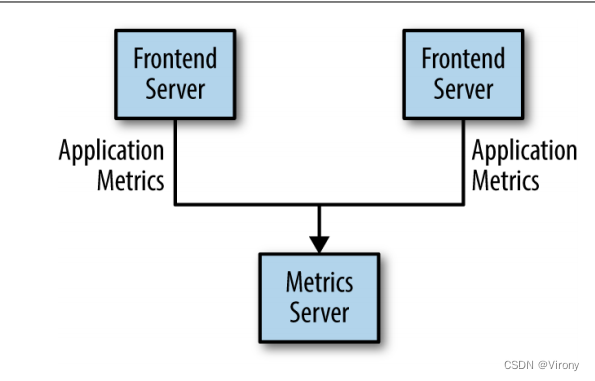

发布/订阅的许多用例都是以相同的方式开始的:使用简单的消息队列或进程间通信通道。例如,您创建一个需要在某处发送监视信息的应用程序,因此您将应用程序与在仪表板上显示指标的应用的直接连接写入其中,并通过该连接推送指标,如图 1-1 所示.

Figure 1-1. A single, direct metrics publisher

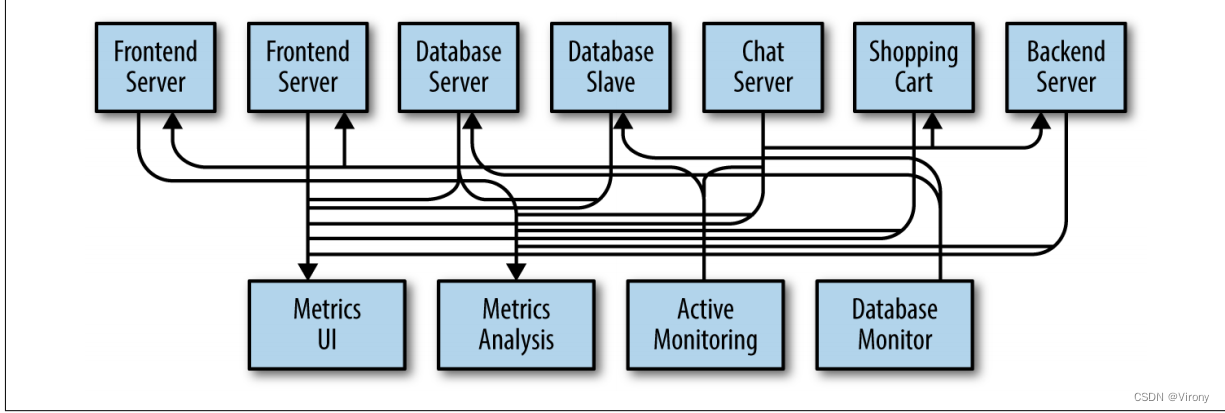

这是一个简单问题的简单解决方案,在您开始监视时有效。不久之后,您决定要长期分析指标,但这在仪表板中效果不佳。您启动一个新服务,该服务可以接收指标、存储指标并对其进行分析。为了支持这一点,您可以修改应用程序以将指标写入两个系统。到现在为止,您又有三个正在生成指标的应用程序,它们都与这两个服务建立相同的连接。您的同事认为对服务进行主动轮询以发出警报也是一个好主意,因此您可以在每个应用程序上添加一个服务器,以根据请求提供指标。一段时间后,您就会有更多的应用程序使用这些服务器来获取单个指标并将其用于各种目的。此体系结构可能看起来很像图 1-2,但连接更难跟踪。

????????????????????????Figure 1-2. Many metrics publishers, using direct connection

这里积累的技术债务是显而易见的,所以你决定偿还其中的一部分。您可以设置一个应用程序,该应用程序从所有应用程序接收指标,并提供一个服务器来查询这些指标,以便为需要它们的任何系统查询这些指标。这将体系结构的复杂性降低到类似于图 1-3 的水平。恭喜你,你已经构建了一个发布-订阅消息传递系统!

????????????????????????????????????????????????Figure 1-3. A metrics publish/subscribe system

1.2 个人队列系统

在你用指标发动这场战争的同时,你的一位同事也在用日志消息做类似的工作。另一个公司一直致力于跟踪前端网站上的用户行为,并将这些信息提供给从事机器学习的开发人员,并创建一些报告以供管理。你们都遵循了类似的路径,即构建系统,将信息的发布者与该信息的订阅者分离。图 1-4 显示了这样一个基础结构,其中包含三个独立的发布/订阅系统。

????????????????????????????????????????Figure 1-4. Multiple publish/subscribe systems

这当然比使用点对点连接(如图 1-2 所示)要好得多,但存在大量重复。您的公司正在维护多个用于对数据进行排队的系统,所有这些系统都有其各自的错误和限制。您还知道,即将推出更多消息传递用例。您想要的是一个单一的集中式系统,允许发布通用类型的数据,这些数据将随着您的业务增长而增长.

2 进入Kafka(Enter Kafka)

Apache Kafka 是一个发布/订阅消息传递系统,旨在解决这个问题。它通常被描述为“分布式提交日志”,或者最近被描述为“分布式流媒体平台”。文件系统或数据库提交日志旨在提供所有事务的持久记录,以便可以重放它们以一致地构建系统状态。同样,Kafka 中的数据是持久、有序地存储的,并且可以确定性地读取。此外,数据可以在系统内分发,以提供针对故障的额外保护,以及扩展性能的重要机会。

2.1 消息和批处理

Kafka 中的数据单位称为消息。如果你从数据库背景接近 Kafka,你可以把它看作是类似于一行或一条记录。就 Kafka 而言,消息只是一个字节数组,因此其中包含的数据对 Kafka 没有特定的格式或含义。消息可以有一个可选的元数据位,称为密钥。密钥也是一个字节数组,与消息一样,对 Kafka 没有特定的含义。当以更可控的方式将消息写入分区时,将使用密钥。最简单的此类方案是生成密钥的一致哈希值,然后通过获取哈希模的结果(主题中的分区总数)来选择该消息的分区号。这可确保具有相同密钥的消息始终写入同一分区。第 3 章将更详细地讨论密钥。

为了提高效率,消息会批量写入 Kafka。批处理只是消息的集合,所有这些消息都生成到同一个主题和分区。每条消息在网络上的单独往返将导致过多的开销,将消息收集到一个批处理中可减少这种情况。当然,这是延迟和吞吐量之间的权衡:批处理越大,每单位时间可以处理的消息就越多,但传播单个消息所需的时间就越长。批处理通常也会被压缩,以牺牲一些处理能力为代价提供更高效的数据传输和存储。

2.2 模式

虽然消息是 Kafka 本身的不透明字节数组,但建议对消息内容施加额外的结构或模式,以便易于理解。有许多选项可用于消息架构,具体取决于应用程序的个性化需求。Javascript 对象表示法 (JSON) 和可扩展标记语言 (XML) 等简单系统易于使用且易于阅读。但是,它们缺少可靠的类型处理和架构版本之间的兼容性等功能。许多 Kafka 开发人员倾向于使用 Apache Avro,这是一个最初为 Hadoop 开发的序列化框架。Avro 提供紧凑的序列化格式;与消息有效负载分开且不需要在更改时生成代码的架构;以及强大的数据类型和模式演进,具有向后和向前兼容性。

一致的数据格式在 Kafka 中很重要,因为它允许将写入和读取消息解耦。当这些任务紧密耦合时,必须更新订阅消息的应用程序,以便与旧格式并行处理新数据格式。只有这样,才能更新发布消息的应用程序以利用新格式。通过使用定义良好的模式并将它们存储在一个公共存储库中,可以在没有协调的情况下理解 Kafka 中的消息。第 3 章更详细地介绍了模式和序列化。

2.3 主题和分区

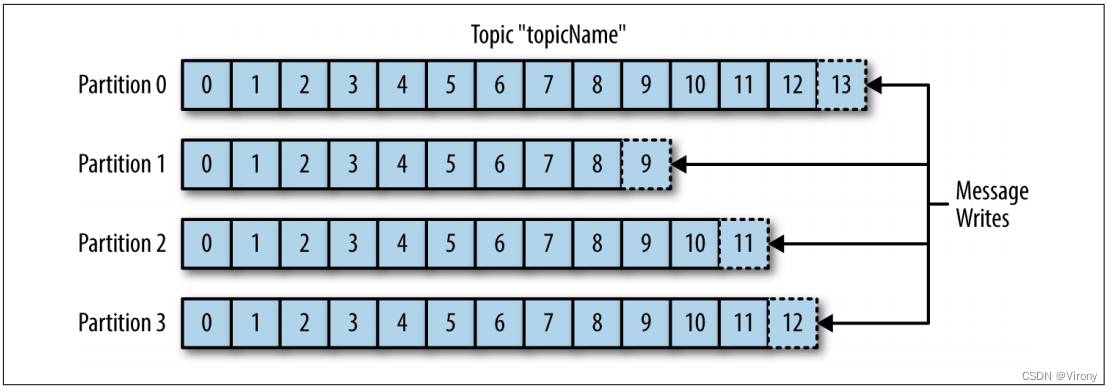

Kafka 中的消息分为多个主题。主题最接近的类比是数据库表或文件系统中的文件夹。此外,主题还细分为多个分区。回到“提交日志”描述,分区是单个日志。消息以仅追加的方式写入其中,并按从头到尾的顺序读取。请注意,由于一个主题通常具有多个分区,因此无法保证整个主题中的消息时间顺序,仅在单个分区内。图 1-5 显示了一个具有四个分区的主题,每个分区的末尾都附加了写入。分区也是 Kafka 提供冗余和可伸缩性的方式。每个分区可以托管在不同的服务器上,这意味着单个主题可以在多个服务器上水平扩展,以提供远远超出单个服务器能力的性能。

????????????????????????????????????????????????????????图1-5 具有多个分区的主题的表示形式

在讨论 Kafka 等系统中的数据时,经常使用术语 stream。大多数情况下,无论分区数如何,流都被视为单个数据主题。这表示从生产者到使用者的单一数据流。在讨论流处理时,这种引用消息的方式最为常见,即框架(其中一些是 Kafka Streams、Apache Samza 和 Storm)实时对消息进行操作。这种操作方法可以与离线框架(即 Hadoop)设计为在以后处理批量数据的方式进行比较。第11章提供了流处理的概述。

2.4 生产者和消费者

Kafka 客户端是系统的用户,有两种基本类型:生产者和消费者。还有用于数据集成的高级客户端 API、Kafka Connect API 和用于流处理的 Kafka Streams。高级客户端使用生产者和使用者作为构建块,并在其上提供更高级别的功能。

生产者创建新消息。在其他发布/订阅系统中,这些可能被称为发布者或编写者。通常,将生成针对特定主题的消息。默认情况下,生产者不关心特定消息写入哪个分区,而是将消息均匀地平衡到主题的所有分区。在某些情况下,生产者会将消息定向到特定分区。这通常是使用消息键和分区程序完成的,分区程序将生成密钥的哈希值并将其映射到特定分区。这确保了使用给定密钥生成的所有消息都将写入同一分区。生产者还可以使用遵循其他业务规则的自定义分区程序将消息映射到分区。第3章更详细地介绍了生产者。

消费者阅读消息。在其他发布/订阅系统中,这些客户端可能称为订阅者或读取器。使用者订阅一个或多个主题,并按照消息的生成顺序读取消息。使用者通过跟踪消息的偏移量来跟踪它已经使用了哪些消息。偏移量是 Kafka 在生成每条消息时添加到每条消息的另一位元数据(一个不断增加的整数值)。给定分区中的每条消息都有一个唯一的偏移量。通过将每个分区的最后消耗消息的偏移量存储在 Zookeeper 或 Kafka 本身中,使用者可以在不丢失其位置的情况下停止和重新启动。

消费者是消费者组的一部分,消费者组是一个或多个共同消费主题的消费者。该组确保每个分区仅由一个成员使用。在图 1-6 中,单个组中有三个使用者使用一个主题。其中两个使用者分别从一个分区工作,而第三个使用者从两个分区工作。使用者到分区的映射通常称为使用者对分区的所有权。

这样,消费者可以横向扩展以消费具有大量消息的主题。此外,如果单个使用者发生故障,组的其余成员将重新平衡正在使用的分区,以接管缺少的成员。第 4 章将更详细地讨论消费者和消费者群体。

????????????????????????????????????????????????????????图1-6 从主题中读取的消费者组

2.5 代理和集群

单个 Kafka 服务器称为代理。代理从生产者接收消息,为它们分配偏移量,并将消息提交到磁盘上的存储。它还为使用者提供服务,响应分区的提取请求,并使用已提交到磁盘的消息进行响应。根据特定的硬件及其性能特征,单个代理可以轻松处理数千个分区和每秒数百万条消息。

Kafka 代理被设计为作为集群的一部分运行。在代理集群中,一个代理还将充当集群控制器(从集群的活动成员中自动选出)。控制器负责管理操作,包括将分区分配给代理和监视代理故障。分区由集群中的单个代理拥有,该代理称为分区的领导者。一个分区可能会分配给多个代理,这将导致该分区被复制(如图 1-7 所示)。这提供了分区中消息的冗余,以便在代理发生故障时,另一个代理可以接管领导权。但是,在该分区上运行的所有使用者和生产者都必须连接到领导者。第 6 章详细介绍了群集操作,包括分区复制。

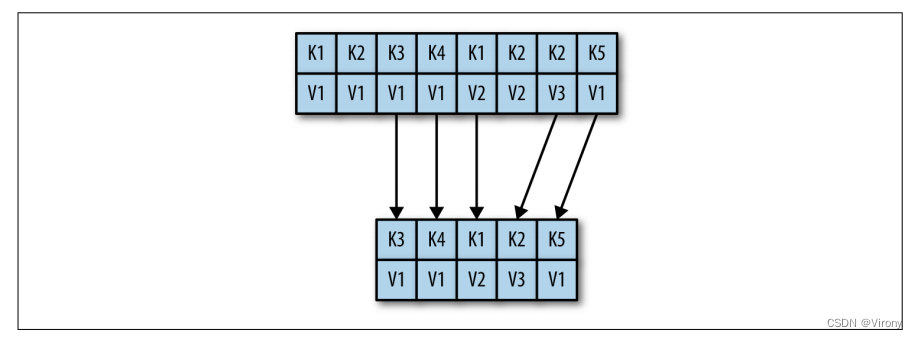

Apache Kafka 的一个关键特性是保留,即在一段时间内持久存储消息。Kafka 代理配置了主题的默认保留设置,可以将消息保留一段时间(例如 7 天),或者直到主题达到特定大小(以字节为单位)(例如 1 GB)。达到这些限制后,邮件将过期并删除,以便保留配置是随时可用的最小数据量。还可以使用自己的保留设置来配置各个主题,以便仅存储消息,只要它们有用。例如,跟踪主题可能会保留几天,而应用程序指标可能只保留几个小时。主题也可以配置为日志压缩,这意味着 Kafka 将只保留使用特定键生成的最后一条消息。这对于更改日志类型的数据很有用,其中只有上次更新才有意义。

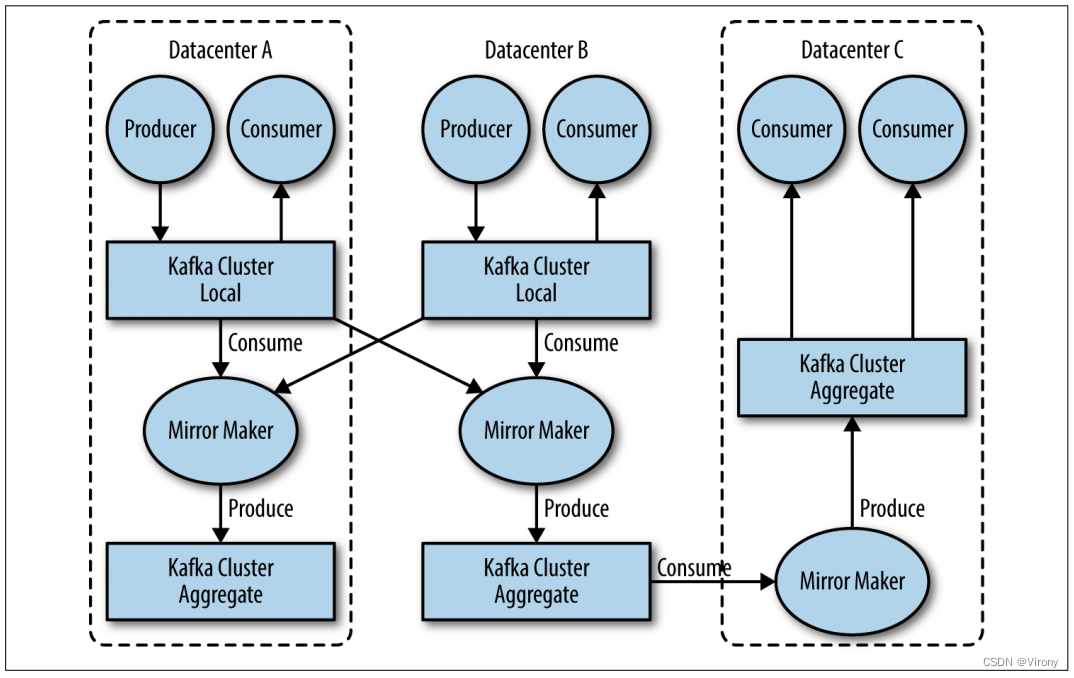

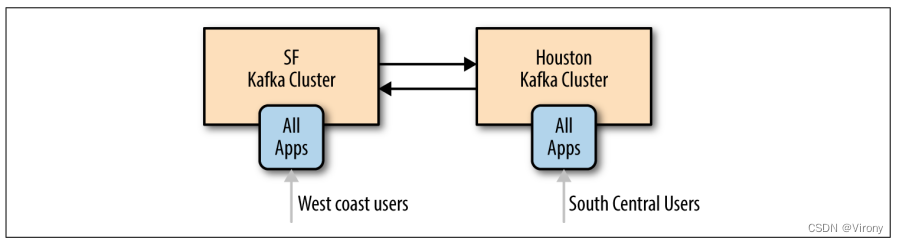

2.6 多集群

随着 Kafka 部署的增长,拥有多个集群通常是有利的。这有几个原因可能有用:

-

数据类型的隔离

-

隔离满足安全要求

-

多个数据中心(灾难恢复)

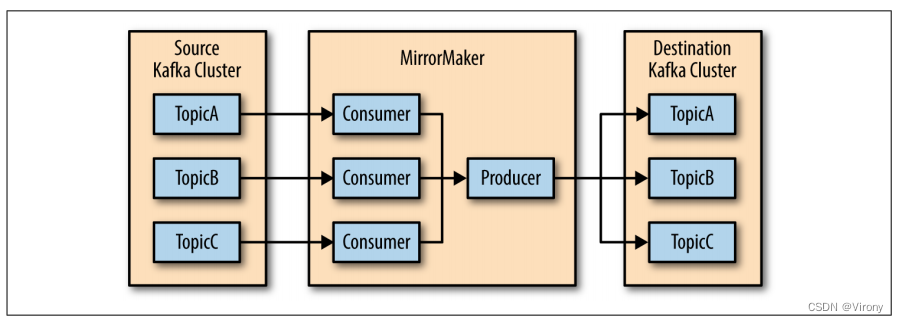

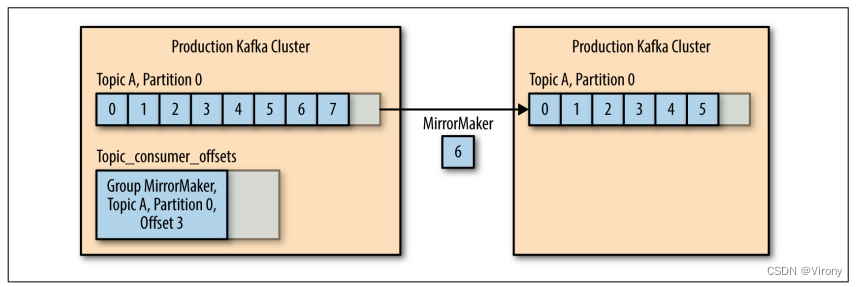

特别是在使用多个数据中心时,通常需要在它们之间复制消息。这样,在线应用程序就可以访问两个站点上的用户活动。例如,如果用户更改了其配置文件中的公共信息,则无论搜索结果显示在哪个数据中心,该更改都需要可见。或者,可以将监控数据从多个站点收集到托管分析和警报系统的单个中心位置。Kafka 集群中的复制机制设计为仅在单个集群内工作,而不是在多个集群之间工作。 ? Kafka 项目包括一个名为 MirrorMaker 的工具,用于此目的。从本质上讲,MirrorMaker 只是一个 Kafka 消费者和生产者,通过队列链接在一起。消息从一个 Kafka 集群使用,并为另一个 Kafka 集群生成。图 1-8 显示了使用 MirrorMaker 的体系结构示例,该体系结构将来自两个本地群集的消息聚合到一个聚合群集中,然后将该群集复制到其他数据中心。该应用程序的简单性掩盖了它在创建复杂数据管道方面的能力,这将在第 7 章中进一步详细介绍。

????????????????????????????????????????????????????????????????????????图 1-8 多数据中心结构

3 为什么是kafka?(Why Kafka?)

发布/订阅消息传递系统有很多选择,那么是什么让 Apache Kafka 成为一个不错的选择呢?

3.1 多生产者

Kafka 能够无缝地处理多个生产者,无论这些客户端使用多个主题还是同一个主题。这使得该系统非常适合聚合来自许多前端系统的数据并使其保持一致。例如,通过多个微服务向用户提供内容的网站可以具有单个页面视图主题,所有服务都可以使用通用格式写入该主题。然后,使用者应用程序可以接收网站上所有应用程序的单个页面视图流,而无需协调来自多个主题的使用,每个主题一个主题。

3.2 多消费者

除了多个生产者之外,Kafka 还设计用于多个使用者读取任何单个消息流而不会相互干扰。这与许多队列系统形成鲜明对比,在许多队列系统中,一旦消息被一个客户端使用,任何其他客户端就无法使用它。多个 Kafka 使用者可以选择作为组的一部分运行并共享流,从而确保整个组只处理一次给定的消息。

3.4 基于磁盘的保留

Kafka 不仅可以处理多个使用者,而且持久的消息保留意味着使用者并不总是需要实时工作。邮件将提交到磁盘,并将使用可配置的保留规则进行存储。这些选项可以按主题进行选择,从而允许不同的消息流具有不同的保留量,具体取决于使用者的需求。持久保留意味着,如果消费者因处理速度慢或流量激增而落后,则不会有丢失数据的危险。这也意味着可以对使用者执行维护,使应用程序在短时间内脱机,而不必担心消息在生产者上备份或丢失。消费者可以停止,消息将保留在 Kafka 中。这使他们能够重新启动并从中断的地方继续处理消息,而不会丢失数据。

3.5 可伸缩

Kafka 灵活的可扩展性使其可以轻松处理任何数量的数据。用户可以从单个代理开始作为概念验证,扩展到由三个代理组成的小型开发集群,然后使用包含数十甚至数百个代理的更大集群进入生产环境,随着数据规模的扩大,该集群会随着时间的推移而增长。可以在集群联机时执行扩展,而不会影响整个系统的可用性。这也意味着由多个代理组成的集群可以处理单个代理的故障,并继续为客户端提供服务。对于需要容忍更多同时故障的群集,可以配置更高的复制因子。第 6 章将更详细地讨论复制。

3.6 高性能

所有这些功能结合在一起,使 Apache Kafka 成为在高负载下具有出色性能的发布/订阅消息传递系统。生产者、使用者和代理都可以横向扩展,以便轻松处理非常大的消息流。这可以在完成此操作的同时,仍然提供从生成消息到向使用者提供的亚秒级消息延迟。

4 数据生态系统(The Data Ecosystem)

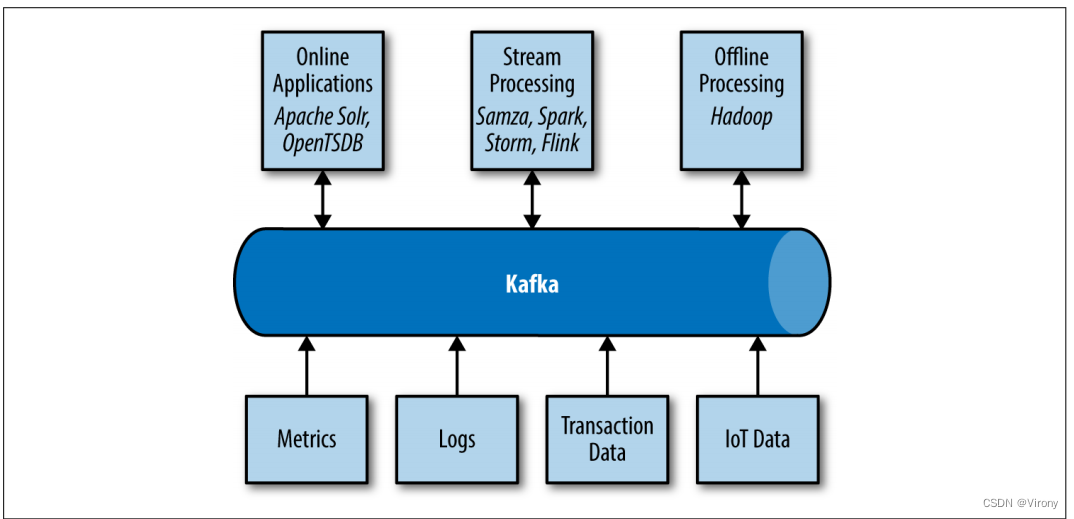

许多应用程序都参与到我们为数据处理而构建的环境中。我们以应用程序的形式定义了输入,这些应用程序创建数据或以其他方式将其引入系统。我们以指标、报告和其他数据产品的形式定义了输出。我们创建循环,一些组件从系统中读取数据,使用来自其他来源的数据对其进行转换,然后将其引入数据基础架构以在其他地方使用。这是针对多种类型的数据完成的,每种类型的数据都具有独特的内容、大小和使用质量。

Apache Kafka 为数据生态系统提供了循环系统,如图 1-9 所示。它在基础结构的各个成员之间传输消息,为所有客户端提供一致的接口。当与提供消息模式的系统结合使用时,生产者和使用者不再需要任何类型的紧密耦合或直接连接。随着业务案例的创建和解散,可以添加和删除组件,生产者无需担心谁在使用数据或使用应用程序的数量。

????????????????????????????????????????????????????????????????????????图1-9 大数据生态系统

4.1 用例

4.1.1 活动跟踪

Kafka的原始用例,正如它在LinkedIn上设计的那样,是用户活动跟踪。网站的用户与前端应用程序交互,前端应用程序会生成有关用户正在执行的操作的消息。这可以是被动信息,例如页面浏览量和点击跟踪,也可以是更复杂的操作,例如用户添加到其配置文件中的信息。这些消息将发布到一个或多个主题,然后由后端的应用程序使用。这些应用程序可能会生成报告、提供机器学习系统、更新搜索结果或执行提供丰富用户体验所需的其他操作。

4.1.2 消息

Kafka 还用于消息传递,其中应用程序需要向用户发送通知(例如电子邮件)。这些应用程序可以生成消息,而无需担心消息的格式或实际发送方式。然后,单个应用程序可以读取要发送的所有消息并一致地处理它们,包括: ? 使用通用外观设置消息格式(也称为装饰) ? 将多条消息收集到要发送的单个通知中 ? 应用用户对接收消息方式的首选项 为此,使用单个应用程序可以避免在多个应用程序中复制功能的需要,并允许进行聚合等操作,否则这是不可能的。

4.1.3 指标和日志记录

Kafka 也是收集应用程序和系统指标和日志的理想选择。在这个用例中,让多个应用程序生成相同类型的消息的能力大放异彩。应用程序会定期将指标发布到 Kafka 主题,这些指标可供系统用于监控和告警。它们还可以在Hadoop等离线系统中使用,以执行长期分析,例如增长预测。日志消息可以以相同的方式发布,并且可以路由到专用的日志搜索系统,如 Elastisearch 或安全分析应用程序。Kafka 的另一个额外好处是,当目标系统需要更改时(例如,需要更新日志存储系统),无需更改前端应用程序或聚合方式。

4.1.4 提交日志

由于 Kafka 基于提交日志的概念,因此可以将数据库更改发布到 Kafka,并且应用程序可以轻松监控此流以在发生实时更新时接收实时更新。此更改日志流还可用于将数据库更新复制到远程系统,或将来自多个应用程序的更改合并到单个数据库视图中。持久保留在这里对于为更改日志提供缓冲区非常有用,这意味着在使用应用程序发生故障时可以重播它。或者,日志压缩主题可用于通过仅保留每个键的单个更改来提供更长的保留期。

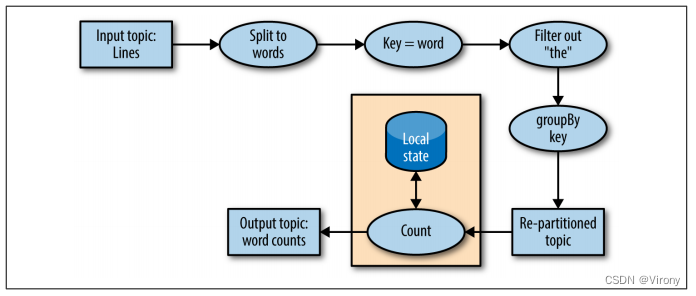

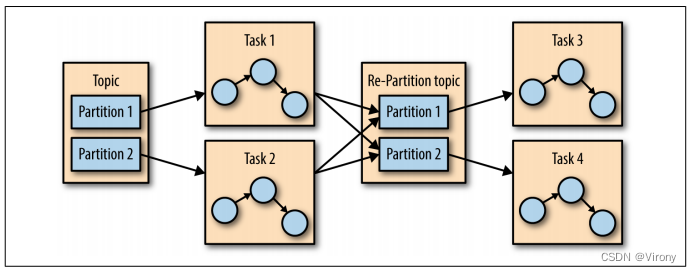

4.1.5 流处理

另一个提供多种类型应用程序的领域是流处理。虽然几乎所有 Kafka 的使用都可以被认为是流处理,但该术语通常用于指代在 Hadoop 中提供类似功能以映射/减少处理的应用程序。Hadoop通常依赖于长时间(数小时或数天)的数据聚合。流处理对数据进行实时操作,与生成消息一样快。流框架允许用户编写小型应用程序来操作 Kafka 消息,执行诸如计数指标、对消息进行分区以供其他应用程序高效处理或使用来自多个源的数据转换消息等任务。第 11 章介绍了流处理。

5 Kakfa的起源(Kafka’s Origin)

Kafka 的创建是为了解决 LinkedIn 的数据管道问题。它旨在提供一个高性能的消息传递系统,该系统可以处理多种类型的数据,并实时提供有关用户活动和系统指标的干净、结构化的数据。 ? 数据确实为我们所做的一切提供了动力。 ? ——Jeff Weiner,LinkedIn 首席执行官

5.1 LinkedIn的问题

与本章开头描述的示例类似,LinkedIn 有一个用于收集系统和应用程序指标的系统,该系统使用自定义收集器和开源工具在内部存储和呈现数据。除了 CPU 使用率和应用程序性能等传统指标外,还有一个复杂的指标请求跟踪功能,该功能使用监视系统,可以自省单个用户请求如何通过内部应用程序传播。然而,监控系统存在许多故障。这包括基于轮询的指标收集、指标之间的较大间隔,以及应用程序所有者无法管理自己的指标。该系统是高接触的,大多数简单的任务都需要人工干预,并且不一致,不同系统中同一测量的指标名称不同。

同时,创建了一个用于跟踪用户活动信息的系统。这是一个 HTTP 服务,前端服务器将定期连接到该服务,并将一批消息(XML 格式)发布到 HTTP 服务。然后,这些批处理被移至脱机处理,这是解析和整理文件的位置。这个系统有很多缺陷。XML 格式不一致,解析它的计算成本很高。更改跟踪的用户活动类型需要在前端和离线处理之间进行大量协调工作。即便如此,系统也会因架构的变化而不断中断。跟踪建立在每小时批处理的基础上,因此无法实时使用。

监视和用户活动跟踪不能使用相同的后端服务。监控服务过于笨拙,数据格式不适合活动跟踪,用于监控的轮询模型与用于跟踪的推送模型不兼容。同时,跟踪服务过于脆弱,无法用于指标,而面向批处理的处理也不是实时监控和警报的正确模型。但是,监视和跟踪数据具有许多共同特征,并且信息的相关性(例如特定类型的用户活动如何影响应用程序性能)是非常可取的。特定类型的用户活动的下降可能表明为其提供服务的应用程序存在问题,但处理活动批处理的延迟数小时意味着对这些类型问题的响应缓慢。

首先,对现有的现成开源解决方案进行了彻底调查,以找到一种新系统,该系统将提供对数据的实时访问,并横向扩展以处理所需的消息流量。原型系统是使用 ActiveMQ 建立的,但当时它无法处理规模。对于LinkedIn使用它的方式来说,这也是一个脆弱的解决方案,在ActiveMQ中发现了许多缺陷,这些缺陷会导致经纪人暂停。这将备份与客户端的连接,并干扰应用程序向用户提供请求的能力。我们决定继续为数据管道使用自定义基础结构。

5.2 Kafka的诞生

LinkedIn的开发团队由首席软件工程师Jay Kreps领导,他之前负责分布式键值存储系统Voldemort的开发和开源发布。最初的团队还包括 Neha Narkhede 和后来的 Jun Rao。他们共同着手创建一个消息传递系统,该系统可以满足监视和跟踪系统的需求,并为未来进行扩展。主要目标是:

? 使用推挽模型将生产者和消费者解耦

? 在消息传递系统中为消息数据提供持久性,以允许多个使用者

? 针对消息的高吞吐量进行优化

? 允许系统的水平扩展随着数据流的增长而增长 ?

?????????结果是一个发布/订阅消息传递系统,它有一个典型的消息传递系统接口,但存储层更像是一个日志聚合系统。结合采用 Apache Avro 进行消息序列化,Kafka 可以有效地处理每天数十亿条消息的指标和用户活动跟踪。Kafka 的可扩展性帮助 LinkedIn 的使用量增长超过 1 万亿条消息(截至 2015 年 8 月),每天消耗超过 1 PB 的数据。

5.3 开源

Kafka 于 2010 年底在 GitHub 上作为开源项目发布。随着它开始在开源社区中受到关注,它于 2011 年 7 月被提议并被接受为 Apache 软件基金会孵化器项目。Apache Kafka 于 2012 年 10 月从孵化器毕业。从那时起,它一直在不断工作,并在LinkedIn之外找到了一个强大的贡献者和提交者社区。Kafka 现在被用于世界上一些最大的数据管道中。2014 年秋天,Jay Kreps、Neha Narkhede 和 Jun Rao 离开了 LinkedIn,创立了 Confluent,这是一家专注于为 Apache Kafka 提供开发、企业支持和培训的公司。这两家公司,以及开源社区中其他公司不断增长的贡献,继续开发和维护 Kafka,使其成为大数据管道的首选。

5.4 名称

人们经常问 Kafka 是如何得名的,以及它是否与应用程序本身有关。杰伊·克雷普斯(Jay Kreps)提出了以下见解: ? 我认为,既然 Kafka 是一个针对写作而优化的系统,那么使用作家的名字是有意义的。我在大学里上过很多点亮的课,喜欢弗朗茨·卡夫卡。另外,对于一个开源项目来说,这个名字听起来很酷。 ? 所以基本上没有太多的关系。

6 开始kafka(Getting Started with Kafka)

现在我们已经了解了 Kafka 及其历史,我们可以设置它并构建我们自己的数据管道。在下一章中,我们将探讨如何安装和配置 Kafka。 ? 我们还将介绍选择运行 Kafka 的正确硬件,以及在迁移到生产操作时要记住的一些事项。

第二章 安装Kafka

本章介绍如何开始使用 Apache Kafka 代理,包括如何设置 Apache Zookeeper,Kafka 使用它来存储代理的元数据。本章还将介绍 Kafka 部署的基本配置选项,以及选择运行代理的正确硬件的标准。最后,我们将介绍如何将多个 Kafka 代理作为单个集群的一部分安装,以及在生产环境中使用 Kafka 时的一些具体问题.

1 First Things First

2 代理配置(Broker Configuration)

Kafka 发行版提供的示例配置足以运行独立服务器作为概念证明,但对于大多数安装来说还不够。Kafka 有许多配置选项,可以控制设置和调整的所有方面。许多选项可以保留为默认设置,因为它们涉及 Kafka 代理的调优方面,除非您有特定的用例要使用,并且需要调整这些设置的特定用例.

2.1 常用代理

在单个服务器上为独立代理以外的任何环境部署 Kafka 时,应检查多个代理配置。这些参数处理代理的基本配置,并且必须更改其中的大多数参数才能在与其他代理的集群中正常运行。

2.1.1 broker.id

每个 Kafka 代理都必须有一个整数标识符,该标识符是使用 broker.id 配置设置的。默认情况下,此整数设置为 0,但可以是任何值。最重要的是,整数在单个 Kafka 集群中必须是唯一的。此数字的选择是任意的,如果需要,可以在代理之间移动以执行维护任务。一个好的准则是将此值设置为主机固有的值,以便在执行维护时,将代理 ID 号映射到主机就不费力了。例如,如果主机名包含唯一编号(如 host1.example.com、host2.example.com 等),则对于 broker.id 值来说,这是一个不错的选择。

2.1.2 port

示例配置文件在 TCP 端口 9092 上使用侦听器启动 Kafka。可以通过更改端口配置参数将其设置为任何可用端口。请记住,如果选择低于 1024 的端口,则必须以 root 身份启动 Kafka。不建议以 root 身份运行 Kafka。

2.1.3 zookeeper.connect

用于存储代理元数据的 Zookeeper 的位置是使用 zookeeper.connect 配置参数设置的。示例配置使用在本地主机上的端口 2181 上运行的 Zookeeper,该端口指定为 localhost:2181。此参数的格式是以分号分隔的 hostname:port/path 字符串列表,其中包括: ? hostname,Zookeeper 服务器的主机名或 IP 地址。 ? 端口,服务器的客户端端口号。 ? /path,一个可选的 Zookeeper 路径,用作 Kafka 集群的 chroot 环境。如果省略,则使用根路径。 如果指定了 chroot 路径且不存在,那么它将在启动时在代理中创建。

2.1.4 log.dirs

Kafka 将所有消息持久化到磁盘,这些日志段存储在 log.dirs 配置中指定的目录中。这是本地系统上以逗号分隔的路径列表。如果指定了多个路径,那么代理将以“最少使用”的方式将分区存储在这些路径上,并将一个分区的日志段存储在同一个路径中。请注意,在以下情况下,代理会将一个新分区放置在当前存储的分区数最少的路径中,而不是使用的最少磁盘空间量:

-

num.recovery.threads.per.data.dir

Kafka 使用可配置的线程池来处理日志段。目前,此线程池用于: ? 正常启动时,打开每个分区的日志段 ? 在发生故障后启动时,检查并截断每个分区的日志段 ? 关闭时,要干净地关闭日志段 默认情况下,每个日志目录仅使用一个线程。由于这些线程仅在启动和关闭期间使用,因此设置更多线程以并行化操作是合理的。具体来说,当从不干净的关闭中恢复时,这可能意味着在重新启动具有大量分区的代理时相差几个小时!设置此参数时,请记住,配置的数字是使用 log.dirs 指定的每个日志目录。这意味着,如果 num.recovery.threads.per.data.dir 设置为 8,并且在 log.dirs 中指定了 3 个路径,则总共有 24 个线程。

2.1.6 auto.create.topics.enable

默认的 Kafka 配置指定在以下情况下,代理应自动创建主题: ? ? 当制作者开始向主题写入消息时 ? ? 当消费者开始阅读来自主题的消息时 ? ? 当任何客户端请求主题的元数据时 ? 在许多情况下,这可能是不希望的行为,特别是因为无法通过 Kafka 协议验证主题的存在而不导致它被创建。如果要显式管理主题创建(无论是手动还是通过预配系统),则可以将 auto.create.topics.enable 配置设置为 false。

2.2 默认主题

Kafka 服务器配置为创建的主题指定了许多默认配置。其中几个参数(包括分区计数和消息保留)可以使用管理工具(在第 9 章中介绍)按主题进行设置。服务器配置中的默认值应设置为适用于群集中大多数主题的基线值.

2.2.1 num.partitions

num.partitions 参数确定创建新主题时使用的分区数,主要是在启用自动主题创建(默认设置)时。此参数默认为一个分区。请记住,主题的分区数只能增加,不能减少。这意味着,如果一个主题需要的分区数少于 num.partitions,则需要注意手动创建该主题(在第 9 章中讨论)。 ? 如第 1 章所述,分区是在 Kafka 集群中扩展主题的方式,因此使用分区计数非常重要,该分区计数将在添加代理时平衡整个集群中的消息负载。许多用户的分区计数等于集群中代理数的倍数。这允许分区均匀地分配给代理,代理将均匀地分配消息负载。但是,这不是必需的,因为您还可以通过具有多个主题来平衡消息负载。

2.2.2 log.retention.ms

Kafka 保留消息多长时间的最常见配置是按时间。默认值在配置文件中使用 log.retention.hours 参数指定,并设置为 168 小时或一周。但是,允许使用另外两个参数:log.retention.minutes 和 log.retention.ms。这三者都指定了相同的配置,即可以删除邮件的时间量,但建议使用的参数是 log.retention.ms,因为如果指定了多个单位,则较小的单位大小将优先。这将确保为 log.retention.ms 设置的值始终是使用的值。如果指定了多个单位,则较小的单位大小将优先。

2.2.3 log.retention.bytes

使消息过期的另一种方法是基于保留的消息的总字节数。此值是使用 log.retention.bytes 参数设置的,并且按分区应用。这意味着,如果您有一个包含 8 个分区的主题,并且 log.retention.bytes 设置为 1 GB,则为该主题保留的数据量最多为 8 GB。请注意,所有保留都是针对单个分区执行的,而不是针对主题执行的。这意味着,如果一个主题的分区数被扩展,如果使用 log.retention.bytes,保留期也会增加。

2.2.4 log.segment.bytes

前面提到的日志保留设置对日志段进行操作,而不是对单个消息进行操作。当消息生成到 Kafka 代理时,它们将附加到分区的当前日志段中。一旦日志段达到 log.segment.bytes 参数指定的大小(默认为 1 GB),将关闭该日志段并打开一个新日志段。关闭日志段后,可以考虑将其过期。较小的日志段大小意味着必须更频繁地关闭和分配文件,这会降低磁盘写入的整体效率。

如果主题的生成率较低,则调整日志段的大小可能很重要。例如,如果一个主题每天只接收 100 MB 的消息,并且 log.segment.bytes 设置为默认值,则填充一个段需要 10 天。由于消息在日志段关闭之前不会过期,因此如果 log.retention.ms 设置为 604800000(1 周),则实际上最多会保留 17 天的消息,直到关闭的日志段过期。这是因为,一旦日志段使用当前 10 天的消息关闭,该日志段必须保留 7 天,然后才能根据时间策略过期(因为在段中的最后一条消息过期之前,无法删除该段)。

2.2.5 log.segment.ms

控制何时关闭日志段的另一种方法是使用 log.segment.ms 参数,该参数指定应关闭日志段的时间量。与 log.retention.bytes 和 log.retention.ms 参数一样,log.segment.bytes 和 log.segment.ms 不是互斥属性。Kafka 将在达到大小限制或达到时间限制时关闭日志段,以先到者为准。默认情况下,log.seg ment.ms 没有设置,这导致仅按大小关闭日志段。

2.2.6 message.max.bytes

Kafka 代理限制可生成消息的最大大小,由 message.max.bytes 参数配置,默认为 1000000 或 1 MB。尝试发送大于此值的消息的生产者将收到来自代理的错误,并且该消息将不被接受。与代理上指定的所有字节大小一样,此配置处理压缩的消息大小,这意味着生产者可以发送远大于此值的未压缩消息,前提是它们压缩到配置的消息.max.bytes 大小以下。 ? 增加允许的消息大小会对性能产生明显影响。较大的消息意味着处理网络连接和请求的代理线程将在每个请求上工作更长时间。较大的消息也会增加磁盘写入的大小,这将影响 I/O 吞吐量。

3 Hardware Selection

为 Kafka 代理选择合适的硬件配置与其说是科学,不如说是一门艺术。Kafka 本身对特定的硬件配置没有严格的要求,并且可以在任何系统上运行而不会出现问题。但是,一旦性能成为一个问题,有几个因素会影响整体性能:磁盘吞吐量和容量、内存、网络和 CPU。一旦确定了哪些类型的性能对你的环境最关键,你将能够选择符合你预算的优化硬件配置。

3.1 磁盘吞吐量

生产者客户机的性能将最直接地受到用于存储日志段的代理磁盘的吞吐量的影响。Kafka 消息在生成时必须提交到本地存储,大多数客户端会等到至少一个代理确认消息已提交后,才会考虑发送成功。这意味着更快的磁盘写入将等于更低的生成延迟。

在磁盘吞吐量方面,显而易见的决定是使用传统的旋转硬盘驱动器 (HDD) 还是固态磁盘 (SSD)。SSD 的寻道和访问时间大大缩短,并将提供最佳性能。另一方面,HDD 更经济,每单位提供更多容量。您还可以通过在代理中使用更多 HDD 来提高 HDD 的性能,无论是通过具有多个数据目录,还是在独立磁盘冗余阵列 (RAID) 配置中设置驱动器。其他因素,例如特定的驱动器技术(例如,串行连接存储或串行 ATA)以及驱动器控制器的质量,都会影响吞吐量。

3.2 磁盘容量

容量是存储讨论的另一面。所需的磁盘容量取决于任何时候需要保留的消息数。如果代理预计每天接收 1 TB 的流量,保留期为 7 天,则代理将需要至少 7 TB 的可用存储空间用于日志段。除了希望为流量波动或随时间增长而维护的任何缓冲区外,还应考虑其他文件至少 10% 的开销。

存储容量是调整 Kafka 集群大小和确定何时扩展集群时要考虑的因素之一。集群的总流量可以通过每个主题具有多个分区来平衡,这将允许额外的代理在单个代理上的密度不足以增加可用容量。关于需要多少磁盘容量的决策也将由为群集选择的复制策略来决定(第 6 章将对此进行更详细的讨论)。

3.3 内存

Kafka 消费者的正常操作模式是从分区的末尾读取,消费者被赶上并落后于生产者,如果有的话。在这种情况下,使用者正在读取的消息以最佳方式存储在系统的页面缓存中,因此读取速度比代理必须从磁盘重新读取消息的速度更快。因此,为系统提供更多可用于页面缓存的内存将提高使用者客户端的性能。

Kafka 本身不需要为 Java 虚拟机 (JVM) 配置太多堆内存。即使是每秒处理 X 条消息和每秒 X 兆比特数据速率的代理也可以使用 5 GB 的堆运行。系统内存的其余部分将由页面缓存使用,并且通过允许系统缓存正在使用的日志段,使 Kafka 受益。这是不建议将 Kafka 与任何其他重要应用程序并置在系统上的主要原因,因为它们必须共享页面缓存的使用。这将降低 Kafka 的使用者性能。

3.4 网络

可用的网络吞吐量将指定 Kafka 可以处理的最大流量。这通常是群集大小调整的控制因素,与磁盘存储相结合。由于 Kafka 对多个消费者的支持,入站和出站网络使用之间固有的不平衡,使情况变得复杂。生产者可以每秒为给定主题写入 1 MB,但可以有任意数量的使用者在出站网络使用量上创建乘数。其他操作,如群集复制(在第 6 章中介绍)和镜像(在第 8 章中讨论)也会增加要求。如果网络接口达到饱和,群集复制滞后的情况并不少见,这可能会使群集处于易受攻击的状态。

3.5 CPU

处理能力不如磁盘和内存重要,但会在一定程度上影响代理的整体性能。理想情况下,客户端应压缩消息以优化网络和磁盘使用率。但是,Kafka 代理必须解压缩所有消息批次,以便验证单个消息的校验和并分配偏移量。然后,它需要重新压缩消息批处理,以便将其存储在磁盘上。这就是 Kafka 对处理能力的大部分要求的来源。然而,这不应该是选择硬件的主要因素。

4 Kafka in the Clould

Kafka 的常见安装是在云计算环境中,例如 Amazon Web Services (AWS)。AWS 提供了许多计算实例,每个实例都有不同的 CPU、内存和磁盘组合,因此必须优先考虑 Kafka 的各种性能特征,以便选择要使用的正确实例配置。一个好的起点是所需的数据保留量,其次是生产者所需的性能。如果需要非常低的延迟,则可能需要具有本地 SSD 存储的 I/O 优化实例。否则,临时存储(如 AWS Elastic Block Store)可能就足够了。做出这些决定后,可用的 CPU 和内存选项将适合性能。

实际上,这意味着对于 AWS 来说,m4 或 r3 实例类型都是常见的选择。m4 实例将允许更长的保留期,但磁盘的吞吐量会更低,因为它位于弹性块存储上。使用本地 SSD 驱动器时,r3 实例将具有更好的吞吐量,但这些驱动器将限制可保留的数据量。为了两全其美,有必要升级到 i2 或 d2 实例类型,它们的成本要高得多。

5 Kafka Cluster

单个 Kafka 服务器非常适合本地开发工作或概念验证系统,但将多个代理配置为一个集群具有显著的好处,如图 2-2 所示。最大的好处是能够跨多个服务器扩展负载。紧随其后的是使用复制来防止由于单个系统故障而导致的数据丢失。复制还允许在 Kafka 或底层系统上执行维护工作,同时仍保持客户端的可用性。本节重点介绍如何仅配置 Kafka 集群。第 6 章包含有关数据复制的更多详细信息。

????????????????????????????????????????????????????????????????图2-2 一个简单的kafka集群

5.1 多少个代理?

Kafka 集群的适当大小由多个因素决定。要考虑的第一个因素是保留消息需要多少磁盘容量,以及单个代理上有多少可用存储空间。如果集群需要保留 10 TB 的数据,并且单个代理可以存储 2 TB,则最小集群大小为 5 个代理。此外,使用复制将使存储需求至少增加 100%,具体取决于所选的复制因子(参见第 6 章)。这意味着配置了复制的同一集群现在需要包含至少 10 个代理。 ? 另一个要考虑的因素是集群处理请求的能力。例如,网络接口的容量是多少,如果数据有多个使用者,或者流量在数据保留期内不一致(例如,高峰时段的流量突发),它们是否可以处理客户端流量。如果单个代理上的网络接口在高峰期使用到 80% 的容量,并且该数据有两个使用者,则除非有两个代理,否则使用者将无法跟上峰值流量。如果在群集中使用复制,则这是必须考虑的数据的附加使用者。还可能希望横向扩展到集群中的更多代理,以处理由较少的磁盘吞吐量或可用系统内存引起的性能问题.

5.2 代理配置

代理配置中只有两个要求允许多个 Kafka 代理加入单个集群。首先,所有代理必须对 zookeeper.connect 参数具有相同的配置。这指定了群集存储元数据的 Zookeeper 集合和路径。第二个要求是集群中的所有代理都必须具有唯一的 broker.id 参数值。如果两个代理尝试使用相同的 broker.id 加入同一集群,则第二个代理将记录错误并无法启动。运行群集时还使用了其他配置参数,具体来说,就是控制复制的参数,这些参数将在后面的章节中介绍。

5.3 操作系统调优

虽然大多数 Linux 发行版都具有开箱即用的内核调优参数配置,这些配置对于大多数应用程序来说都相当有效,但可以对 Kafka 代理进行一些更改以提高性能。这些主要围绕虚拟内存和网络子系统,以及用于存储日志段的磁盘挂载点的特定问题。这些参数通常在 /etc/sysctl.conf 文件中配置,但您应该参考 Linux 发行版的文档,了解有关如何调整内核配置的具体详细信息。

-

虚拟内存

通常,Linux 虚拟内存系统会自动针对系统的工作负载进行自我调整。我们可以对交换空间的处理方式以及脏内存页进行一些调整,以针对 Kafka 的工作负载进行调整。 ? 与大多数应用程序(特别是那些关注吞吐量的应用程序)一样,最好避免以(几乎)所有成本进行交换。将内存页交换到磁盘所产生的成本将对 Kafka 性能的各个方面产生明显影响。此外,Kafka 大量使用系统页面缓存,如果 VM 系统交换到磁盘,则没有足够的内存分配给页面缓存。 ? 避免交换的一种方法是根本不配置任何交换空间。交换不是必需的,但如果系统上发生灾难性事件,它确实提供了一个安全网。交换可以防止操作系统由于内存不足而突然终止进程。因此,建议将 vm.swappiness 参数设置为一个非常低的值,例如 1。该参数是 VM 子系统使用交换空间而不是从页面缓存中删除页面的可能性的百分比。最好是减小页面缓存的大小而不是交换。

调整内核处理必须刷新到磁盘的脏页的方式也有好处。Kafka 依靠磁盘 I/O 性能为生产者提供良好的响应时间。这也是日志段通常放在快速磁盘上的原因,无论是具有快速响应时间的单个磁盘(例如,SSD)还是具有大量 NVRAM 用于缓存的磁盘子系统(例如,RAID)。结果是,在刷新后台进程开始将脏页写入磁盘之前,可以减少允许的脏页数。这是通过将 =vm.dirty_background_ratio 值设置为低于默认值 10 来实现的。该值是系统内存总量的百分比,在许多情况下,将此值设置为 5 是合适的。但是,此设置不应设置为零,因为这将导致内核不断刷新页面,从而消除内核缓冲磁盘写入以抵御底层设备性能临时峰值的能力。

在内核强制同步操作将其刷新到磁盘之前允许的脏页总数也可以通过更改 vm.dirty_ratio 的值来增加,将其增加到默认值 20 以上(也是系统总内存的百分比)。此设置的可能值范围很广,但 60 到 80 之间是一个合理的数字。此设置确实会带来少量风险,无论是在未刷新的磁盘活动量方面,还是在强制同步刷新时可能导致长时间的 I/O 暂停方面。如果选择了更高的vm.dirty_ratio设置,强烈建议在 Kafka 集群中使用复制来防止系统故障。 在为这些参数选择值时,明智的做法是查看 Kafka 集群在负载下运行时随时间推移的脏页数,无论是在生产环境中还是在模拟环境中。可以通过检查 /proc/vmstat 文件来确定当前的脏页数:

?# cat /proc/vmstat | egrep "dirty|writeback" ?nr_dirty 3875 ?nr_writeback 29 ?nr_writeback_temp 0 ?#

-

磁盘

除了选择磁盘设备硬件以及 RAID 的配置(如果使用)之外,选择用于此磁盘的文件系统可能会对性能产生下一个最大的影响。有许多不同的文件系统可用,但本地文件系统最常见的选择是 EXT4(第四个扩展文件系统)或扩展文件系统 (XFS)。最近,XFS 已成为许多 Linux 发行版的默认文件系统,这是有充分理由的——对于大多数工作负载,它的性能优于 EXT4,并且需要最少的调整。EXT4 可以很好地执行,但它需要使用被认为不太安全的调整参数。这包括将提交间隔设置为比默认值 5 更长的时间,以强制降低刷新频率。EXT4 还引入了块的延迟分配,这在系统故障的情况下带来了更大的数据丢失和文件系统损坏的可能性。XFS 文件系统也使用延迟分配算法,但它通常比 EXT4 使用的算法更安全。XFS 还为 Kafka 的工作负载提供了更好的性能,而无需在文件系统执行的自动调优之外进行调优。在批处理磁盘写入时,它的效率也更高,所有这些因素结合在一起,可提供更好的整体 I/O 吞吐量。 ? 无论为保存日志段的挂载选择哪种文件系统,都建议为挂载点设置 noatime 挂载选项。文件元数据包含三个时间戳:创建时间 (ctime)、上次修改时间 (mtime) 和上次访问时间 (atime)。默认情况下,每次读取文件时都会更新 atime。这将生成大量磁盘写入。atime 属性通常被认为没什么用处,除非应用程序需要知道文件自上次修改以来是否被访问过(在这种情况下,可以使用实时选项)。Kafka 根本不使用 atime,因此禁用它是安全的。在挂载上设置 noatime 将阻止这些时间戳更新发生,但不会影响对 ctime 和 mtime 属性的正确处理。

-

网络

对于任何生成大量网络流量的应用程序来说,调整 Linux 网络堆栈的默认调整都很常见,因为默认情况下不会针对大型高速数据传输调整内核。事实上,Kafka 的建议更改与大多数 Web 服务器和其他网络应用程序的建议更改相同。第一个调整是更改为每个套接字的发送和接收缓冲区分配的默认内存量和最大内存量。这将显著提高大型传输的性能。每个套接字的发送和接收缓冲区默认大小的相关参数是 net.core.wmem_default 和 net.core.rmem_default,这些参数的合理设置为 131072,即 128 KiB。发送和接收缓冲区最大大小的参数为 net.core.wmem_max 和 net.core.rmem_max,合理的设置为 2097152 或 2 MiB。请记住,最大大小并不表示每个套接字都会分配这么多缓冲区空间;如果需要,它只允许这么多。除了套接字设置之外,还必须使用 net.ipv4.tcp_wmem 和 net.ipv4.tcp_rmem 参数分别设置 TCP 套接字的发送和接收缓冲区大小。它们使用三个空格分隔的整数进行设置,这些整数分别指定最小、默认和最大大小。最大大小不能大于使用 net.core.wmem_max 和 net.core.rmem_max为所有套接字指定的值。每个参数的示例设置是“4096 65536 2048000”,即最小 4 KiB、默认值 64 KiB 和最大缓冲区 2 MiB。根据 Kafka 代理的实际工作负载,您可能希望增加最大大小,以允许更大的网络连接缓冲。

还有其他几个网络调整参数可供设置。通过将 net.ipv4.tcp_window_scaling 设置为 1 来启用 TCP 窗口扩展将允许客户端更有效地传输数据,并允许在代理端缓冲该数据。将 net.ipv4.tcp_max_syn_backlog 的值增加到默认值 1024 以上将允许接受更多数量的同时连接。将 net.core.netdev_max_backlog 的值增加到大于默认值 1000 可以帮助突发网络流量,特别是在使用多千兆位网络连接速度时,允许更多数据包排队等待内核处理它们。

6 Production Concerns(生产问题)

一旦您准备好将 Kafka 环境从测试中移出并进入生产操作,还需要考虑一些事情,这将有助于设置可靠的消息传递服务。

6.1 垃圾回收器选项

调整应用程序的 Java 垃圾回收选项一直是一门艺术,需要有关应用程序如何使用内存的详细信息,以及大量的观察和试错。值得庆幸的是,随着 Java 7 和 Garbage First(或 G1)垃圾回收器的引入,这种情况发生了变化。G1 旨在自动适应不同的工作负载,并在应用程序的整个生命周期内为垃圾回收提供一致的暂停时间。它还通过将堆分割成较小的区域,而不是在每次暂停时收集整个堆,从而轻松处理大型堆大小。 G1 在正常操作中以最少的配置完成所有这些工作。G1 有两个配置选项用于调整其性能:

-

MaxGCPauseMillis 此选项指定每个垃圾回收周期的首选暂停时间。它不是固定的最大值 - 如果需要,G1 可以并且将超过此时间。此值默认为 200 毫秒。这意味着 G1 将尝试安排 GC 循环的频率,以及每个循环中收集的区域数,因此每个循环大约需要 200 毫秒。

-

启动HeapOccupancyPercent 此选项指定在 G1 开始收集周期之前可能正在使用的总堆的百分比。默认值为 45。这意味着 G1 在使用 45% 的堆之前不会启动收集周期。这包括新 (Eden) 和旧区域的总使用量。

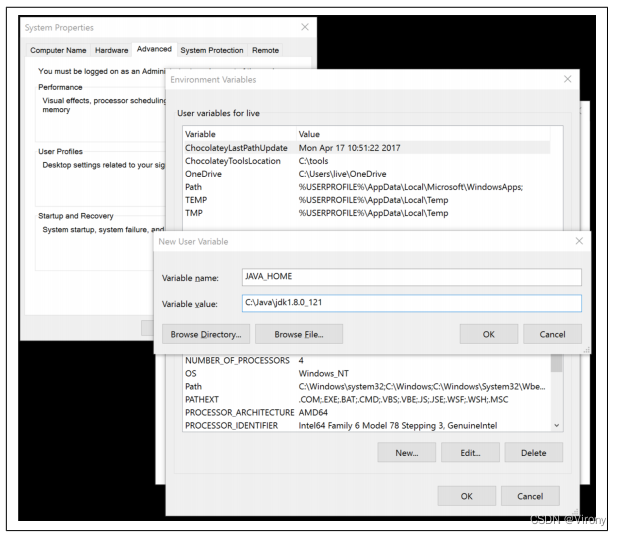

Kafka 代理在利用堆内存和创建垃圾对象方面相当高效,因此可以将这些选项设置得更低。已发现本节中提供的 GC 优化选项适用于具有 64 GB 内存的服务器,在 5GB 堆中运行 Kafka。对于 MaxGCPauseMillis,此代理可以配置为 20 毫秒的值。InitiatingHeapOccupancyPercent 的值设置为 35,这会导致垃圾回收的运行时间略早于默认值。 ? Kafka 的启动脚本不使用 G1 收集器,而是默认使用并行的 new 和 confary 标记和清除垃圾回收。通过环境变量可以很容易地进行更改。使用本章前面的 start 命令,按如下方式对其进行修改:

?# export JAVA_HOME=/usr/java/jdk1.8.0_51 ?# export KAFKA_JVM_PERFORMANCE_OPTS="-server -XX:+UseG1GC ?-XX:MaxGCPauseMillis=20 -XX:InitiatingHeapOccupancyPercent=35 ?-XX:+DisableExplicitGC -Djava.awt.headless=true" ?# /usr/local/kafka/bin/kafka-server-start.sh -daemon ?/usr/local/kafka/config/server.properties ?#

6.2 数据中心布局

对于开发系统,Kafka 代理在数据中心内的物理位置并不是一个大问题,因为如果集群在短时间内部分或完全不可用,则不会产生那么严重的影响。然而,在提供生产流量时,停机意味着损失,无论是由于用户服务丢失还是用户所操作的遥测丢失。这时,在 Kafka 集群中配置复制变得至关重要(参见第 6 章),这也是考虑代理在数据中心机架中的物理位置很重要的时候。如果在部署 Kafka 之前没有解决,则可能需要昂贵的维护来移动服务器。 Kafka 代理在将新分区分配给代理时没有机架感知。这意味着它不能考虑到两个代理可能位于同一个物理机架中,或位于同一个可用区中(如果在 AWS 等云服务中运行),因此可以轻松地将分区的所有副本分配给在同一机架中共享相同电源和网络连接的代理。如果该机架发生故障,这些分区将脱机且客户端无法访问。此外,由于不干净的领导人选举,它可能导致额外的恢复数据丢失(第 6 章中对此有更多介绍)。 ? 最佳做法是将集群中的每个 Kafka 代理安装在不同的机架中,或者至少不共享基础设施服务(如电源和网络)的单点故障。这通常意味着至少部署将运行具有双电源连接(到两个不同电路)和双网络交换机(服务器本身具有绑定接口以实现无缝故障转移)的代理的服务器。即使使用双连接,将代理放在完全独立的机架中也有好处。有时,可能需要对需要脱机的机架或机柜执行物理维护(例如移动服务器或重新布线电源连接)。

6.3 在 Zookeeper 上共置应用程序

Kafka 利用 Zookeeper 来存储有关代理、主题和分区的元数据信息。对 Zookeeper 的写入仅在对消费者组成员身份的更改或对 Kafka 集群本身的更改时执行。这个流量是最小的,它并不能证明对单个 Kafka 集群使用专用的 Zookeeper 集合是合理的。事实上,许多部署将对多个 Kafka 集群使用单个 Zookeeper 集合(对每个集群使用 chroot Zookeeper 路径,如本章前面所述)。 ? 但是,在某些配置下,消费者和 Zookeeper 存在问题。使用者可以选择使用 Zookeeper 或 Kafka 进行提交偏移量,还可以配置提交之间的间隔。如果使用者使用 Zookeeper 进行偏移,则每个使用者将每隔一段时间对其使用的每个分区执行一次 Zookeeper 写入。偏移提交的合理间隔为 1 分钟,因为这是使用者组在使用者失败时读取重复消息的时间段。这些提交可能是 Zookeeper 流量的大量,尤其是在具有许多使用者的集群中,需要考虑在内。如果 Zookeeper 集合体无法处理流量,则可能需要使用更长的提交间隔。但是,建议使用最新 Kafka 库的使用者使用 Kafka 进行偏移,从而消除对 Zookeeper 的依赖。 除了对多个 Kafka 集群使用单个集成之外,如果可以避免,不建议与其他应用程序共享集成。Kafka 对 Zookeeper 延迟和超时很敏感,与集合的通信中断将导致代理的行为不可预测。这很容易导致多个代理同时脱机,如果它们失去 Zookeeper 连接,这将导致脱机分区。它还会给集群控制器带来压力,在中断过去很久之后,例如在尝试执行代理的受控关闭时,可能会显示为细微的错误。其他可能因大量使用或操作不当而给 Zookeeper 集成带来压力的应用程序应隔离到它们自己的集成中。

7 总结

在本章中,我们学习了如何启动和运行 Apache Kafka。我们还介绍了为您的经纪商选择合适的硬件,以及在生产环境中进行设置的具体问题。现在,您已经有了一个 Kafka 集群,我们将逐步了解 Kafka 客户端应用程序的基础知识。接下来的两章将介绍如何创建客户端,以便向 Kafka 生成消息(第 3 章),以及再次使用这些消息(第 4 章)

第三章 Kafka 生产者:向 Kafka 写入消息

无论您将 Kafka 用作队列、消息总线还是数据存储平台,您都将始终通过编写将数据写入 Kafka 的生产者、从 Kafka 读取数据的使用者或充当这两个角色的应用程序来使用 Kafka。

例如,在信用卡交易处理系统中,将有一个客户端应用程序,可能是一个在线商店,负责在付款时立即将每笔交易发送到 Kafka。另一个应用程序负责立即根据规则引擎检查此事务,并确定该事务是被批准还是被拒绝。然后,可以将批准/拒绝响应写回 Kafka,并将响应传播回发起事务的在线商店。第三个应用程序可以从 Kafka 读取交易和审批状态,并将它们存储在数据库中,分析师可以在以后查看决策并可能改进规则引擎。

Apache Kafka 附带了内置的客户端 API,开发人员可以在开发与 Kafka 交互的应用程序时使用这些 API。

在本章中,我们将学习如何使用 Kafka 生产器,首先概述其设计和组件。我们将展示如何创建 KafkaProducer 和 ProducerRecord 对象,如何向 Kafka 发送记录,以及如何处理 Kafka 可能返回的错误。然后,我们将回顾用于控制生产者行为的最重要的配置选项。最后,我们将更深入地了解如何使用不同的分区方法和序列化程序,以及如何编写自己的序列化程序和分区程序。

在第 4 章中,我们将研究 Kafka 的消费者客户端和从 Kafka 读取数据。

1. 生产者概览

应用程序可能需要将消息写入 Kafka 的原因有很多:记录用户活动以进行审计或分析、记录指标、存储日志消息、记录来自智能设备的信息、与其他应用程序异步通信、在写入数据库之前缓冲信息等等。

这些不同的用例也意味着不同的要求:是每条消息都至关重要,还是我们可以容忍消息丢失?我们可以不小心复制消息吗?是否有任何严格的延迟或吞吐量要求需要支持?

在我们前面介绍的信用卡交易处理示例中,我们可以看到,永远不要丢失一条消息或重复任何一条消息至关重要。延迟应该很低,但可以容忍高达 500 毫秒的延迟,并且吞吐量应该非常高 - 我们预计每秒处理多达 100 万条消息。 ? 另一个用例可能是存储来自网站的点击信息。在这种情况下,可以容忍一些消息丢失或一些重复项;只要不影响用户体验,延迟就可能很高。换句话说,我们不介意消息到达 Kafka 是否需要几秒钟的时间,只要在用户点击链接后立即加载下一页即可。吞吐量将取决于我们预期的网站活动水平。 ? 不同的要求将影响您使用创建者 API 将消息写入 Kafka 的方式以及您使用的配置。 ? 虽然生产者 API 非常简单,但当我们发送数据时,生产者会进行更多的事情。向 Kafka 发送数据的主要步骤如图 3-1 所示。

????????????????????????????????????????????????????????????????图3-1 Kafka 生产者组件的高级概述

我们通过创建一个 ProducerRecord 来开始向 Kafka 生成消息,该记录必须包含我们想要将记录发送到的主题和一个值。或者,我们还可以指定键和/或分区。发送 ProducerRecord 后,生产者要做的第一件事就是将键和值对象序列化为 ByteArrays,以便它们可以通过网络发送。

接下来,将数据发送到分区程序。如果我们在 ProducerRecord 中指定了一个分区,则分区程序不会执行任何操作,而只是返回我们指定的分区。如果我们没有这样做,分区程序将为我们选择一个分区,通常基于 ProducerRecord 键。选择分区后,创建者就知道记录将转到哪个主题和分区。然后,它将记录添加到一批记录中,这些记录也将发送到同一主题和分区。一个单独的线程负责将这些批次的记录发送到相应的 Kafka 代理。

当代理收到消息时,它会发回响应。如果消息已成功写入 Kafka,它将返回一个 RecordMetadata 对象,其中包含主题、分区和分区内记录的偏移量。如果代理未能写入消息,它将返回错误。当生产者收到错误时,它可能会再重试发送消息几次,然后放弃并返回错误。

2. 构建 Kafka 生产者

将消息写入 Kafka 的第一步是创建一个生产者对象,其中包含要传递给生产者的属性。Kafka 生产者有三个必需属性:

-

bootstrap.servers

生产者将用于与 Kafka 集群建立初始连接的代理的主机:端口对列表。此列表不需要包含所有代理,因为生产者将在初始连接后获得更多信息。但建议至少包含两个,这样如果一个代理出现故障,生产者仍然可以连接到集群。

-

key.serializer

一个类的名称,该类将用于将我们将生成的记录的密钥序列化到 Kafka。Kafka 代理期望字节数组作为消息的键和值。但是,生产者接口允许使用参数化类型将任何 Java 对象作为键和值发送。这使得代码非常可读,但这也意味着生产者必须知道如何将这些对象转换为字节数组。key.serializer 应设置为实现org.apache.kafka.common.serialization.Serializer 接口的类的名称。生产者将使用此类将键对象序列化为字节数组。Kafka 客户端包包括 ByteArraySerializer(它的作用不大)、StringSerializer 和 IntegerSerializer,因此如果您使用通用类型,则无需实现自己的序列化程序。即使您打算只发送值,也需要设置 key.serializer。

-

value.serializer

一个类的名称,该类将用于将我们将生成的记录的值序列化为 Kafka。将 key.serializer 设置为将消息键对象序列化为字节数组的类的名称,将 value.serializer 设置为将序列化消息值对象的类。

以下代码片段演示如何通过仅设置必需参数并对其他所有内容使用默认值来创建新的生产者:

?private Properties kafkaProps = new Properties(); ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? (1)

?kafkaProps.put("bootstrap.servers", "broker1:9092,broker2:9092");

?kafkaProps.put("key.serializer",

? ? ? ? ? ? ? ? "org.apache.kafka.common.serialization.StringSerializer"); ? ? ? (2)

?kafkaProps.put("value.serializer",

? ? ? ? ? ? ? ? "org.apache.kafka.common.serialization.StringSerializer");

?producer = new KafkaProducer<String, String>(kafkaProps) ? ? ? ? ? ? ? ? ? ? ? (3)

(1) 我们从 Properties 对象开始。

(2) 由于我们计划使用字符串作为消息键和值,因此我们使用内置的 StringSerializer。

(3) 在这里,我们通过设置适当的键和值类型并传递 Properties 对象来创建一个新的生产者。

通过如此简单的界面,很明显,对生产者行为的大部分控制都是通过设置正确的配置属性来完成的。Apache Kafka 文档涵盖了所有配置选项,我们将在本章后面介绍重要的选项。

一旦我们实例化了一个生产者,就该开始发送消息了。发送消息的主要方法有三种:

-

即发即弃(Fire-and-forget)

我们向服务器发送消息,并不真正关心它是否成功到达。大多数情况下,它会成功到达,因为 Kafka 是高可用性的,生产者将自动重试发送消息。但是,使用此方法,某些消息会丢失。

-

同步发送(Synchronous send)

我们发送一条消息,send() 方法返回一个 Future 对象,我们使用 get() 等待 future 并查看 send() 是否成功。

-

异步发送(Asynchronous send)

我们使用回调函数调用 send() 方法,当它收到来自 Kafka 代理的响应时会触发该函数。

在下面的示例中,我们将了解如何使用这些方法发送消息,以及如何处理可能发生的不同类型的错误。

虽然本章中的所有示例都是单线程的,但多个线程可以使用一个生产者对象来发送消息。您可能希望从一个生产者和一个线程开始。如果需要更高的吞吐量,可以添加更多使用同一生产者的线程。一旦这不再增加吞吐量,您可以向应用程序添加更多生产者以实现更高的吞吐量。

3. 向 Kafka 发送消息

发送消息的最简单方法如下:

?ProducerRecord<String, String> record =

? new ProducerRecord<>("CustomerCountry", "Precision Products",

? "France"); ? (1)

?try {

? producer.send(record); (2)

?} catch (Exception e) {

? e.printStackTrace(); ? (3)

?}

(1)生产者接受 ProducerRecord 对象,因此我们首先创建一个对象。ProducerRecord 有多个构造函数,我们将在后面讨论。在这里,我们使用一个需要我们向其发送数据的主题的名称(始终是一个字符串)以及我们发送到 Kafka 的键和值(在本例中也是字符串)。键和值的类型必须与序列化程序和创建者对象匹配。

(2)我们使用生产者对象 send() 方法来发送 ProducerRecord。正如我们在图 3-1 的创建者体系结构图中看到的那样,消息将放置在缓冲区中,并将在单独的线程中发送到代理。send() 方法返回一个带有 RecordMetadata 的 Java Future 对象,但由于我们只是忽略了返回的值,因此我们无法知道消息是否成功发送。当以静默方式丢弃消息是可以接受的时,可以使用这种发送消息的方法。在生产应用程序中,情况通常并非如此。

3.1 同步发送消息

同步发送消息的最简单方法如下:

?ProducerRecord<String, String> record =

? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ?new ProducerRecord<>("CustomerCountry", "Precision Products", "France");

?try {

? producer.send(record).get(); ? (1)

?} catch (Exception e) {

? ? ? e.printStackTrace(); ? ? (2)

?}

(1) 在这里,我们使用 Future.get() 来等待 Kafka 的回复。如果记录未成功发送到 Kafka,此方法将引发异常。如果没有错误,我们将得到一个 RecordMetadata 对象,我们可以使用它来检索消息写入到的偏移量。

(2) 如果在向 Kafka 发送数据之前出现任何错误,在发送时,如果 Kafka 代理返回了不可重试的异常,或者我们用尽了可用的重试次数,我们将遇到异常。在这种情况下,我们只打印我们遇到的任何异常。

KafkaProducer 有两种类型的错误。可重试的错误是可以通过再次发送消息来解决的错误。例如,可以解决连接错误,因为可能会重新建立连接。当为分区选择新的领导者时,可以解决“无领导者”错误。KafkaProducer 可以配置为自动重试这些错误,因此仅当重试次数用尽且错误未解决时,应用程序代码才会获得可重试的异常。重试无法解决某些错误。例如,“邮件大小过大”。在这些情况下,KafkaProducer 不会尝试重试,而是会立即返回异常。

3.2 异步发送消息

假设我们的应用程序和 Kafka 集群之间的网络往返时间为 10 毫秒。如果我们在发送每条消息后等待回复,发送 100 条消息大约需要 1 秒。另一方面,如果我们只是发送所有消息而不等待任何回复,那么发送 100 条消息几乎不需要任何时间。在大多数情况下,我们真的不需要回复 - Kafka 在写入记录后发回记录的主题、分区和偏移量,而发送应用程序通常不需要这样做。另一方面,我们确实需要知道何时未能完全发送消息,以便我们可以抛出异常、记录错误,或者将消息写入“错误”文件以供以后分析。

为了异步发送消息并仍然处理错误场景,生产者支持在发送记录时添加回调。以下是我们如何使用回调的示例:

?private class DemoProducerCallback implements Callback { ? (1)

? @Override

? public void onCompletion(RecordMetadata recordMetadata, Exception e) {

? if (e != null) {

? e.printStackTrace(); ? ?(2)

? }

? }

?}

?ProducerRecord<String, String> record =

? new ProducerRecord<>("CustomerCountry", "Biomedical Materials", "USA"); ? (3)

?producer.send(record, new DemoProducerCallback()); ? ? (4)

(1)要使用回调,您需要一个实现 org.apache.kafka 的类。clients.producer.Callback 接口,该接口具有单个函数 onCompletion()

(2)如果 Kafka 返回错误,则 onCompletion() 将出现非 null 异常。这里我们通过打印来“处理”它,但生产代码可能会有更健壮的错误处理功能。

(3)记录与以前相同。

(4)记录与以前相同。

(5)我们在发送记录时传递一个 Callback 对象。

4.配置生产者

到目前为止,我们看到的生产者的配置参数很少,只有必需的 bootstrap.servers、URI 和序列化程序。 ? 生产者有大量的配置参数;大多数都记录在 Apache Kafka 文档中,并且许多具有合理的默认值,因此没有理由修改每个参数。但是,某些参数对生产者的内存使用、性能和可靠性有重大影响。我们将在这里回顾这些内容。

-

acks ? acks 参数控制在生产者认为写入成功之前必须接收记录的分区副本数。此选项对邮件丢失的可能性有重大影响。acks 参数有三个允许的值:

-

如果 acks=0,则生产者不会等待代理的回复,然后假设消息已成功发送。这意味着,如果出现问题并且经纪人没有收到消息,生产者将不知道它,并且消息将丢失。但是,由于生产者不等待来自服务器的任何响应,因此它可以以网络支持的速度发送消息,因此此设置可用于实现非常高的吞吐量。

-

如果 acks=1,则生产者将在主副本收到消息的那一刻收到来自代理的成功响应。如果无法将消息写入领导者(例如,如果领导者崩溃并且尚未选出新的领导者),则生产者将收到错误响应,并可以重试发送消息,从而避免潜在的数据丢失。如果领导者崩溃,并且没有此消息的副本被选为新的领导者(通过不干净的领导者选举),则消息仍可能丢失。在这种情况下,吞吐量取决于我们是同步发送消息还是异步发送消息。如果我们的客户端代码等待来自服务器的回复(通过调用发送消息时返回的 Future 对象的 get() 方法),它显然会显着增加延迟(至少通过网络往返)。如果客户端使用回调,则延迟将被隐藏,但吞吐量将受到正在进行的消息数量的限制(即,在从服务器接收回复之前,生产者将发送多少条消息)。

-

如果 acks=all,则一旦所有同步副本都收到消息,生产者将收到来自代理的成功响应。这是最安全的模式,因为您可以确保多个代理拥有该消息,并且即使在崩溃的情况下,该消息也会继续存在(第 5 章中有关此内容的更多信息)。但是,我们在 acks=1 案例中讨论的延迟会更高,因为我们将等待多个代理接收消息。

-

-

buffer.memoery

这将设置生产者将用于缓冲等待发送到代理的消息的内存量。如果应用程序发送消息的速度快于传递到服务器的速度,则生产者可能会耗尽空间,并且根据 block.on.buffer.full 参数(在版本 0.9.0.0 中替换为 max.block.ms),允许阻塞一段时间然后抛出异常,则其他 send() 调用将阻止或抛出异常。

-

compression.type

默认情况下,邮件是以未压缩的方式发送的。此参数可以设置为 snappy、gzip 或 lz4,在这种情况下,在将数据发送到代理之前,将使用相应的压缩算法来压缩数据。Snappy 压缩是由 Google 发明的,旨在提供不错的压缩比、低 CPU 开销和良好的性能,因此建议在性能和带宽都受到关注的情况下使用。Gzip 压缩通常会使用更多的 CPU 和时间,但会产生更好的压缩率,因此建议在网络带宽受到更多限制的情况下进行压缩。通过启用压缩,可以降低网络利用率和存储,这通常是向 Kafka 发送消息时的瓶颈。

-

retries

当生产者从服务器收到错误消息时,该错误可能是暂时的(例如,缺少分区的领导者)。在这种情况下,retries 参数的值将控制生产者在放弃并通知客户端问题之前重试发送消息的次数。默认情况下,生产者将在两次重试之间等待 100 毫秒,但您可以使用 retry.backoff.ms 参数进行控制。我们建议测试从崩溃的代理中恢复所需的时间(即,所有分区获得新领导者的时间),并设置重试次数和它们之间的延迟,以便重试所花费的总时间将长于 Kafka 集群从崩溃中恢复所需的时间,否则, 制片人会过早放弃。并非所有错误都会由生产者重试。有些错误不是暂时性的,不会导致重试(例如,“消息太大”错误)。通常,由于生产者会为您处理重试,因此在您自己的应用程序逻辑中处理重试是没有意义的。您需要将精力集中在处理不可重试的错误或重试尝试已用尽的情况上。

-

batch.size

当多条记录发送到同一分区时,生产者会将它们批处理在一起。此参数控制将用于每个批处理的内存量(以字节为单位,而不是消息数)。当批处理已满时,将发送批处理中的所有消息。但是,这并不意味着生产者将等待批次装满。生产者将发送半满批次,甚至只发送一条消息的批次。因此,将批处理大小设置得太大不会导致发送消息延迟;它只会为批处理使用更多内存。将批大小设置得太小会增加一些开销,因为生产者需要更频繁地发送消息。

-

linger.ms

linger.ms 控制在发送当前批处理之前等待其他消息的时间。KafkaProducer 在当前批次已满或达到 linger.ms 限制时发送一批消息。默认情况下,只要有发送方线程可用于发送消息,生产者就会发送消息,即使批处理中只有一条消息也是如此。通过将 linger.ms 设置为高于 0,我们指示生产者等待几毫秒,在将其他消息发送到代理之前向批处理添加其他消息。这会增加延迟,但也会增加吞吐量(因为我们一次发送更多消息,因此每条消息的开销更少)

-

client.id

这可以是任何字符串,代理将使用它来标识从客户端发送的消息。它用于日志记录和指标,以及配额。

-

max.in.flight.requests.per.connection

这控制了生产者在不收到响应的情况下向服务器发送的消息数。设置此高值可以增加内存使用率,同时提高吞吐量,但设置得太高会降低吞吐量,因为批处理效率会降低。将此值设置为 1 将保证消息将按照发送消息的顺序写入代理,即使发生重试也是如此。

-

timeout.ms, request.timeout.ms, and metadata.fetch.timeout.ms

这些参数控制生产者在发送数据 (request.timeout.ms) 和请求元数据(例如我们正在写入的分区的当前领导者 (metadata.fetch.timeout.ms))时等待服务器回复的时间。如果达到超时而没有回复,生产者将重试发送或以错误(通过异常或发送回调)进行响应。timeout.ms 控制代理等待同步副本确认消息以满足 acks 配置的时间 - 如果时间过去而没有必要的确认,代理将返回错误。

-

max.block.ms

此参数控制生产者在调用 send() 和通过 partitionsFor() 显式请求元数据时将阻塞多长时间。当生成者的发送缓冲区已满或元数据不可用时,这些方法将阻止。当达到 max.block.ms 时,将引发超时异常。

-

max.request.size

此设置控制生产者发送的生产请求的大小。它限制了可以发送的最大消息的大小和生产者可以在一个请求中发送的消息数。例如,如果默认最大请求大小为 1 MB,则您可以发送的最大消息为 1 MB,或者生产者可以将 1,000 条大小为 1 K 的消息批处理到一个请求中。此外,代理对它将接受的最大消息的大小 (message.max.bytes) 有自己的限制。通常最好让这些配置匹配,这样生产者就不会尝试发送被代理拒绝的大小的消息。

-

receive.buffer.bytes and send.buffer.bytes

这些是套接字在写入和读取数据时使用的 TCP 发送和接收缓冲区的大小。如果这些值设置为 -1,则将使用 OS 默认值。当生产者或使用者与不同数据中心的代理通信时,增加这些链接是一个好主意,因为这些网络链接通常具有更高的延迟和更低的带宽。

5. 序列化程序

如前面的示例所示,生产者配置包括强制序列化程序。我们已经了解了如何使用默认的 String 序列化程序。Kafka 还包括整数和 ByteArray 的序列化器,但这并不涵盖大多数用例。最终,您将希望能够序列化更通用的记录。 ? 我们将首先展示如何编写自己的序列化程序,然后介绍Avro序列化程序作为推荐的替代方案。

5.1 自定义序列化程序

当您需要发送到Kafka 的对象不是简单的字符串或整数时,您可以选择使用 Avro、Thrift 或 Protobuf等通用序列化库来创建记录,或者为已使用的对象创建自定义序列化。强烈建议使用泛型序列化库。为了了解序列化程序的工作原理以及为什么使用序列化库是个好主意,让我们看看编写自己的自定义序列化程序需要什么。 ? 假设您不是只记录客户名称,而是创建一个简单的类来表示客户:

?public class Customer {

? ? ? private int customerID;

? ? ? private String customerName;

? ? ? public Customer(int ID, String name) {

? ? ? ? ? ? ? this.customerID = ID;

? ? ? ? ? ? ? this.customerName = name;

? ? ? }

? ? ? public int getID() {

? ? ? ? ?return customerID;

? ? ? }

? ? ? public String getName() {

? ? ? ? ? ? ?return customerName;

? ? ? }

?}

现在假设我们要为此类创建一个自定义序列化程序。它看起来像这样:

?import org.apache.kafka.common.errors.SerializationException;

?import java.nio.ByteBuffer;

?import java.util.Map;

?public class CustomerSerializer implements Serializer<Customer> {

? @Override

? public void configure(Map configs, boolean isKey) {

? // nothing to configure

? }

? @Override

? /**

? We are serializing Customer as:

? 4 byte int representing customerId

? 4 byte int representing length of customerName in UTF-8 bytes (0 if name is

?Null)

? N bytes representing customerName in UTF-8

? */

? public byte[] serialize(String topic, Customer data) {

? try {

? ? ? ? ? byte[] serializedName;

? ? ? ? ? int stringSize;

? ? ? ? ? if (data == null)

? ? ? ? ? ? ? ? ?return null;

? ? ? ? ?else {

? ? ? ? ? ? ? if (data.getName() != null) {

? ? ? ? ? ? ? serializeName = data.getName().getBytes("UTF-8");

? ? ? ? ? ? ? stringSize = serializedName.length;

? ? ? ? ? ? ? } else {

? ? ? ? ? ? ? serializedName = new byte[0];

? ? ? ? ? ? ? stringSize = 0;

? ? ? ? ? ? ? }

? ? ? }

? ? ? ? ? ByteBuffer buffer = ByteBuffer.allocate(4 + 4 + stringSize);

? ? ? ? ? buffer.putInt(data.getID());

? ? ? ? ? buffer.putInt(stringSize);

? ? ? ? ? buffer.put(serializedName);

? ? ? ? ? return buffer.array();

? ? ? } catch (Exception e) {

? ? ? ? ? ? ?throw new SerializationException("Error when serializing Customer to byte[] " + e);

? ? ? }

? ? ? }

? ? ? @Override

? ? ? public void close() {

? ? ? ? ? ? ?// nothing to close

? ? ? ? }

?} ? ?

使用此 CustomerSerializer 配置生产者将允许您定义 ProducerRecord<String、Customer>,并发送 Customer 数据并将 Customer 对象直接传递给生产者。这个例子非常简单,但你可以看到代码是多么脆弱。例如,如果我们有太多的客户,并且需要将 customerID 更改为 Long,或者如果我们决定向 Customer 添加 startDate 字段,那么在维护新旧消息之间的兼容性方面将遇到严重问题。调试不同版本的序列化程序和解串程序之间的兼容性问题相当具有挑战性,需要比较原始字节数组。更糟糕的是,如果同一家公司的多个团队最终将客户数据写入 Kafka,他们都需要使用相同的序列化程序并同时修改代码。

出于这些原因,我们建议使用现有的序列化程序和反序列化程序,例如 JSON、Apache Avro、Thrift 或 Protobuf。在下一节中,我们将介绍 Apache Avro,然后展示如何序列化 Avro 记录并将它们发送到 Kafka。

5.2 使用 Apache Avro 进行序列化

Apache Avro 是一种与语言无关的数据序列化格式。该项目由 Doug Cutting 创建,旨在提供一种与大量受众共享数据文件的方法。

Avro 数据在与语言无关的架构中描述。架构通常以 JSON 描述,序列化通常为二进制文件,但也支持序列化为 JSON。Avro 假定在读取和写入文件时存在架构,通常是通过将架构嵌入到文件本身中。

Avro 最有趣的功能之一,也是它非常适合在 Kafka 等消息传递系统中使用的原因之一是,当写入消息的应用程序切换到新架构时,读取数据的应用程序可以继续处理消息,而无需进行任何更改或更新。 假设原始架构为:

?{"namespace": "customerManagement.avro",

? "type": "record",

? "name": "Customer",

? "fields": [

? ? ? ? ? {"name": "id", "type": "int"},

? ? ? ? ? {"name": "name", "type": "string""},

? ? ? ? ? {"name": "faxNumber", "type": ["null", "string"], "default": "null"} ? (1)

? ]

?}

(1) id 和 name 字段是必填字段,而传真号码是可选的,默认为 null。

我们使用了这个模式几个月,并以这种格式生成了几TB的数据。现在假设我们决定在新版本中,我们将升级到二十一世纪,并且将不再包含传真号码字段,而是使用电子邮件字段。

新架构为:

?{"namespace": "customerManagement.avro",

? "type": "record",

? "name": "Customer",

? "fields": [

? ? ? {"name": "id", "type": "int"},

? ? ? {"name": "name", "type": "string"},

? ? ? {"name": "email", "type": ["null", "string"], "default": "null"}

? ? ? ]

? }

现在,升级到新版本后,旧记录将包含“faxNumber”,新记录将包含“email”。在许多组织中,升级过程缓慢且需要数月时间。因此,我们需要考虑仍然使用传真号码的升级前应用程序和使用电子邮件的升级后应用程序将如何能够处理 Kafka 中的所有事件。

读取应用程序将包含对类似于 getName()、getId() 和 getFaxNumber 的方法的调用。如果遇到使用新模式编写的消息,get Name() 和 getId() 将继续工作,无需修改,但 getFax Number() 将返回 null,因为消息将不包含传真号码。

现在假设我们升级了我们的阅读应用程序,它不再具有 getFax Number() 方法,而是 getEmail()。如果它遇到使用旧模式编写的消息,getEmail() 将返回 null,因为旧消息不包含电子邮件地址。

此示例说明了使用 Avro 的好处:即使我们更改了消息中的架构,但未更改读取数据的所有应用程序,也不会出现异常或中断性错误,也无需对现有数据进行昂贵的更新。

但是,此方案有两个注意事项: ? ? 用于写入数据的架构和读取应用程序预期的架构必须兼容。Avro 文档包含兼容性规则。 ? ? 反序列化程序将需要访问写入数据时使用的架构,即使它与访问数据的应用程序预期的架构不同。在 Avro 文件中,写入架构包含在文件本身中,但对于 Kafka 消息,有一种更好的方法来处理这个问题。我们接下来会看看。

5.3 将 Avro Records 与 Kafka 配合使用

与 Avro 文件不同,在 Avro 文件中存储整个架构与相当合理的开销相关联,将整个架构存储在每条记录中通常会使记录大小增加一倍以上。但是,Avro 在读取记录时仍要求存在整个架构,因此我们需要将架构定位到其他位置。为了实现这一点,我们遵循一个通用的架构模式,并使用一个架构注册表。Schema Registry 不是 Apache Kafka 的一部分,但有几个开源选项可供选择。在此示例中,我们将使用 Confluent 架构注册表。您可以在 GitHub 上找到架构注册表代码,也可以将其作为 Confluent Platform 的一部分进行安装。如果您决定使用架构注册表,那么我们建议您查看文档。 ? 这个想法是将用于将数据写入 Kafka 的所有模式存储在注册表中。然后,我们只需将模式的标识符存储在我们生成给 Kafka 的记录中。然后,使用者可以使用标识符将记录从架构注册表中提取出来,并反序列化数据。关键是所有这些工作(将架构存储在注册表中并在需要时将其拉出)都是在序列化程序和反序列化程序中完成的。向 Kafka 生成数据的代码只是使用 Avro 序列化程序,就像使用任何其他序列化程序一样。图 3-2 演示了此过程。

????????????????????????????????????????????????图3-2 Avro 记录序列化和反序列化的流程图

下面是如何向 Kafka 生成生成的 Avro 对象的示例(有关如何在 Avro 中使用代码生成,请参阅 Avro 文档):

?Properties props = new Properties();

?props.put("bootstrap.servers", "localhost:9092");

?props.put("key.serializer",

? "io.confluent.kafka.serializers.KafkaAvroSerializer");

?props.put("value.serializer",

? "io.confluent.kafka.serializers.KafkaAvroSerializer"); ? ?(1)

?props.put("schema.registry.url", schemaUrl); ? (2)

?String topic = "customerContacts";

?int wait = 500;

?Producer<String, Customer> producer = new KafkaProducer<String,

? Customer>(props); ? ? (3)

?// We keep producing new events until someone ctrl-c

?while (true) {

? ? ? ? ? Customer customer = CustomerGenerator.getNext();

? ? ? ? ? System.out.println("Generated customer " +

? ? ? ? ? customer.toString());

? ? ? ? ? ProducerRecord<String, Customer> record =

? ? ? ? ? new ProducerRecord<>(topic, customer.getId(), cus?tomer); ? ?(4)

? ? ? ? ? producer.send(record); ? ?(5)

?}

(1)我们使用 KafkaAvroSerializer 通过 Avro 序列化我们的对象。请注意,AvroSerializer 也可以处理原语,这就是为什么我们以后可以使用 String 作为记录键,而使用 Customer 对象作为值。

(2)schema.registry.url 是一个新参数。这仅指向我们存储架构的位置。

(3)客户是我们生成的对象。我们告诉生产者,我们的记录将包含 Customer 作为值。

(4)我们还实例化 ProducerRecord,将 Customer 作为值类型,并在创建新记录时传递 Customer 对象。

(5)就是这样。我们将记录与 Customer 对象一起发送,KafkaAvroSerializer 将处理其余的工作。

如果更喜欢使用泛型 Avro 对象而不是生成的 Avro 对象,该怎么办?不用担心。在这种情况下,您只需要提供架构:

?Properties props = new Properties();

?props.put("bootstrap.servers", "localhost:9092");

?props.put("key.serializer",

? "io.confluent.kafka.serializers.KafkaAvroSerializer"); ? ? ?(1)

?props.put("value.serializer",

? "io.confluent.kafka.serializers.KafkaAvroSerializer");

?props.put("schema.registry.url", url); ? ? ? (2)

? String schemaString = "{\"namespace\": \"customerManagement.avro\",

? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ?\"type\": \"record\", " + ? ? (3)

? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? "\"name\": \"Customer\"," +

? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? "\"fields\": [" +

? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? "{\"name\": \"id\", \"type\": \"int\"}," +

? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? "{\"name\": \"name\", \"type\": \"string\"}," +

? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? "{\"name\": \"email\", \"type\": [\"null\",\"string

? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ?\"], \"default\":\"null\" }" +

? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? "]}";

? Producer<String, GenericRecord> producer =

? new KafkaProducer<String, GenericRecord>(props); ? (4)

? Schema.Parser parser = new Schema.Parser();

? Schema schema = parser.parse(schemaString);

? for (int nCustomers = 0; nCustomers < customers; nCustomers++) {

? ? ? ? ? String name = "exampleCustomer" + nCustomers;

? ? ? ? ? String email = "example " + nCustomers + "@example.com"

? ? ? ? ? GenericRecord customer = new GenericData.Record(schema); ? ?(5)

? ? ? ? ? customer.put("id", nCustomer);

? ? ? ? ? customer.put("name", name);

? ? ? ? ? customer.put("email", email);

? ? ? ? ? ProducerRecord<String, GenericRecord> data =

? ? ? ? ? ? ? ? ? new ProducerRecord<String,

? ? ? ? ? ? ? ? ? GenericRecord>("customerContacts",

? ? ? ? ? ? ? ? ?name, customer);

? ? ? ? ? ? ? ? ? producer.send(data);

? ? ? ? ? ? ? }

? }

??

(1)我们仍然使用相同的 KafkaAvroSerializer。

(2)我们提供同一架构注册表的 URI。

(3)但现在我们还需要提供 Avro 架构,因为它不是由 Avro 生成的对象提供的。

(4)我们的对象类型是 Avro GenericRecord,我们使用架构和要写入的数据对其进行初始化。

(5)然后,ProducerRecord 的值只是一个 GenericRecord,它计算我们的架构和数据。序列化程序将知道如何从此记录中获取架构,将其存储在架构注册表中,并序列化对象数据。

6.分区

在前面的示例中,我们创建的 ProducerRecord 对象包括主题名称、键和值。Kafka 消息是键值对,虽然可以创建仅包含主题和值的 ProducerRecord,但默认情况下键设置为 null,但大多数应用程序都会使用键生成记录。密钥有两个目标:它们是与消息一起存储的附加信息,它们还用于确定将消息写入哪个主题分区。具有相同密钥的所有消息都将转到同一分区。这意味着,如果一个进程只读取主题中分区的子集(第 4 章将详细介绍),则单个键的所有记录都将由同一进程读取。若要创建键值记录,只需创建 ProducerRecord,如下所示:

?ProducerRecord<Integer, String> record =

? ? ? ? ? ? ? ? ? ?new ProducerRecord<>("CustomerCountry", "Laboratory Equipment", "USA");

使用 null 键创建消息时,只需将键省略即可:

?ProducerRecord<Integer, String> record =

? ? ? ? ? ? ? ? ? ? new ProducerRecord<>("CustomerCountry", "USA"); ? ? (1)

(1)在这里,键将简单地设置为 null,这可能表示窗体上缺少客户名称。

当键为 null 并使用默认分区程序时,记录将随机发送到主题的可用分区之一。循环算法将用于在分区之间平衡消息。 ? 如果存在密钥并使用默认分区程序,则 Kafka 将对密钥进行哈希处理(使用自己的哈希算法,因此在升级 Java 时哈希值不会更改),并使用结果将消息映射到特定分区。由于始终将键映射到同一分区非常重要,因此我们使用本主题中的所有分区来计算映射,而不仅仅是可用分区。这意味着,如果在向特定分区写入数据时该分区不可用,则可能会出现错误。这是相当罕见的,正如您将在第 6 章讨论 Kafka 的复制和可用性时看到的那样。 ? 只有当主题中的分区数不变时,键到分区的映射才是一致的。因此,只要分区数保持不变,就可以确保,例如,有关用户045189的记录将始终写入分区 34。这允许在从分区读取数据时进行各种优化。但是,当您向主题添加新分区时,这不再得到保证 - 旧记录将保留在分区 34 中,而新记录将写入其他分区。当分区键很重要时,最简单的解决方案是创建具有足够分区的主题(第 2 章包括有关如何确定大量分区的建议),并且永远不要添加分区。

6.1 实施自定义分区策略

到目前为止,我们已经讨论了默认分区程序的特征,这是最常用的特征。但是,Kafka 并不限制您只对分区进行哈希处理,有时有充分的理由以不同的方式对数据进行分区。例如,假设您是一家 B2B 供应商,而您最大的客户是一家生产名为 Bananas 的手持设备的公司。假设您与客户“Banana”有如此多的业务往来,以至于您每天超过10%的交易都是与该客户进行的。如果您使用默认的哈希分区,Banana财务会计软件的记录将被分配到与其他账户相同的分区,导致一个分区大约是其他分区的两倍。这可能会导致服务器空间不足、处理速度变慢等。我们真正想要的是给Banana财务会计软件一个自己的分区,然后使用哈希分区将其余的账户映射到分区。

下面是自定义分区程序的示例:

?import org.apache.kafka.clients.producer.Partitioner;

?import org.apache.kafka.common.Cluster;

?import org.apache.kafka.common.PartitionInfo;

?import org.apache.kafka.common.record.InvalidRecordException;

?import org.apache.kafka.common.utils.Utils;

?public class BananaPartitioner implements Partitioner {

? ? ? ? ? public void configure(Map<String, ?> configs) {} ? ? ? (1)

? ? ? ? ? public int partition(String topic, Object key, byte[] keyBytes,

? ? ? ? ? Object value, byte[] valueBytes,

? ? ? ? ? Cluster cluster) {

? ? ? ? ? ? ? ? ? List<PartitionInfo> partitions =

? ? ? ? ? ? ? ? ? cluster.partitionsForTopic(topic);

? ? ? ? ? ? ? ? ? int numPartitions = partitions.size();

? ? ? ? ? ? ? ? ? if ((keyBytes == null) || (!(key instanceOf String))) ? (2)

? ? ? ? ? ? ? ? ? throw new InvalidRecordException("We expect all messages to have customer name as key")

? ? ? ? ? ? ? ? ? if (((String) key).equals("Banana"))

? ? ? ? ? ? ? ? ? ? ? ? ? ?return numPartitions; // Banana will always go to last partition

? ? ? ? ? ? ? ? ? ? ? ? ? ? ?// Other records will get hashed to the rest of the partitions

? ? ? ? ? ? ? ? ? return (Math.abs(Utils.murmur2(keyBytes)) % (numPartitions - 1))

? }

? public void close() {}

?}

(1) 分区程序接口包括 configure、partition 和 close 方法。在这里,我们只实现了分区,尽管我们确实应该通过配置传递特殊的客户名称,而不是在分区中对其进行硬编码。

(2) 我们只需要 String 键,因此如果不是这种情况,我们会抛出异常。

7.旧生产者 API

在本章中,我们讨论了 Java 创建者客户端,它是 org.apache.kafka.clients 包的一部分。但是,Apache Kafka 仍然有两个用 Scala 编写的旧客户端,它们是 kafka.producer 包和核心 Kafka 模块的一部分。这些生产者称为 SyncProducer(根据 acks 参数的值,它可能会等待服务器在发送其他消息之前确认每条消息或一批消息)和 AsyncProducer(在后台批处理消息,在单独的线程中发送消息,并且不向客户端提供有关成功的反馈)。

由于当前的生产者支持这两种行为,并为开发人员提供了更高的可靠性和控制力,因此我们不会讨论较旧的 API。如果您有兴趣使用它们,请三思而后行,然后参考 Apache Kafka 文档以了解更多信息。

8.总结

本章的开头是一个简单的生产者示例,只需 10 行代码即可将事件发送到 Kafka。我们通过添加错误处理和试验同步和异步生产来增加简单示例。然后,我们探索了最重要的生产者配置参数,并了解了它们如何修改生产者的行为。我们讨论了序列化器,它让我们可以控制写入 Kafka 的事件的格式。我们深入研究了 Avro,这是序列化事件的众多方法之一,但也是 Kafka 非常常用的方法之一。在本章的最后,我们讨论了 Kafka 中的分区,并举例说明了高级自定义分区技术。

现在我们知道了如何将事件写入 Kafka,在第 4 章中,我们将学习有关从 Kafka 使用事件的所有信息.

第四章 Kafka 使用者:从 Kafka 读取数据

需要从 Kafka 读取数据的应用程序使用 KafkaConsumer 订阅 Kafka 主题并接收来自这些主题的消息。从 Kafka 读取数据与从其他消息传递系统读取数据略有不同,并且涉及的独特概念和想法很少。如果不首先了解这些概念,就很难理解如何使用消费者 API。我们将首先解释一些重要概念,然后我们将通过一些示例来展示使用者 API 可用于实现具有不同需求的应用程序的不同方式。

4.1 Kafka 消费者概念

为了了解如何从 Kafka 读取数据,首先需要了解它的消费者和消费者群体。以下各节将介绍这些概念。

4.1.1 消费者和消费者群体

假设您有一个应用程序,需要从 Kafka 主题读取消息,对它们运行一些验证,并将结果写入另一个数据存储。在这种情况下,您的应用程序将创建一个使用者对象,订阅相应的主题,然后开始接收消息、验证消息并写入结果。这可能在一段时间内效果很好,但是如果生产者向主题写入消息的速率超过了应用程序可以验证它们的速率,该怎么办?如果仅限于单个使用者读取和处理数据,则应用程序可能会越来越落后,无法跟上传入消息的速率。显然,有必要从主题中扩大消费规模。就像多个生产者可以写入同一个主题一样,我们需要允许多个消费者从同一个主题中读取数据,并在它们之间拆分数据。

Kafka 使用者通常是使用者组的一部分。当多个消费者订阅一个主题并属于同一个消费组时,该组中的每个消费者都会收到来自该主题中不同分区子集的消息。

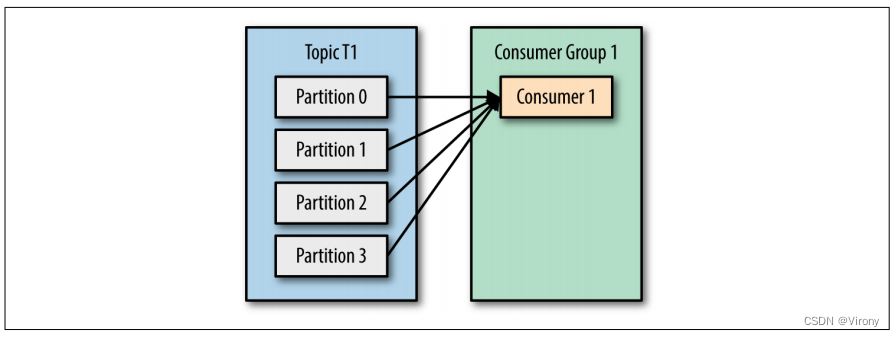

让我们以具有四个分区的主题 T1 为例。现在假设我们创建了一个新的消费者 C1,它是组 G1 中唯一的消费者,并使用它来订阅主题 T1。使用者 C1 将从所有四个 t1 分区获取所有消息。请参见图 4-1。

????????????????????????????????????????????????????????图4-1 一个具有四个分区的消费者组

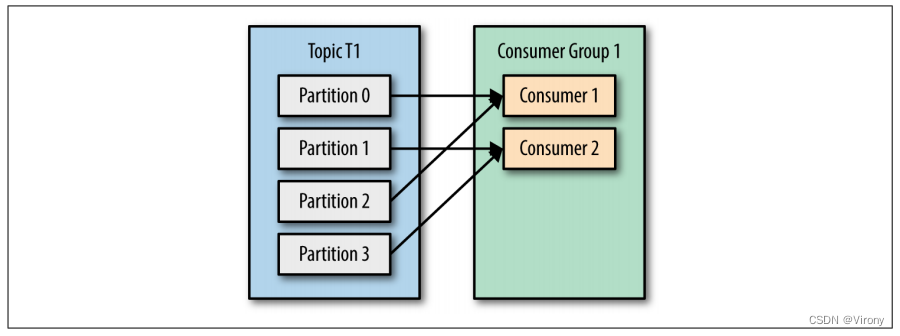

如果我们将另一个消费者 C2 添加到组 G1,则每个消费者将只能从两个分区获取消息。也许来自分区 0 和 2 的消息会转到 C1,而来自分区 1 和 3 的消息会转到使用者 C2。请参见图 4-2。

????????????????????????????????????????????????图4-2 四个分区拆分为两个使用者组

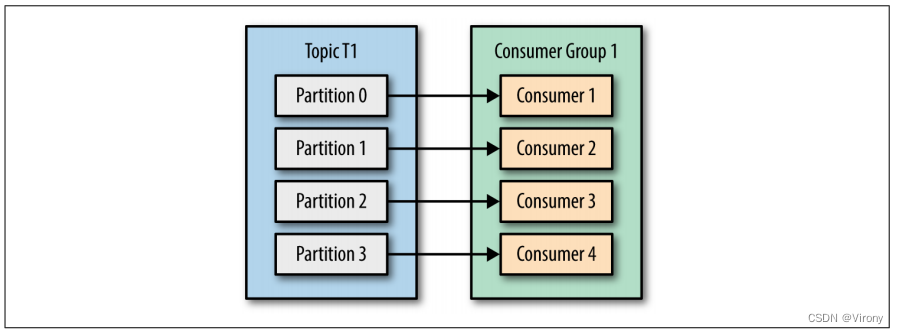

如果 G1 有 4 个使用者,则每个使用者都将从单个分区读取消息。请参见图 4-3。

????????????????????????????????????????????????????????图4-3 四个使用者组,每个使用者组一个分区

如果我们向具有单个主题的单个组添加的消费者多于分区,则某些消费者将处于空闲状态,根本得不到任何消息。请参见图 4-4。

????????????????????????????????????????????????????????????????图4-4 消费者组多于分区意味着错过的消息

我们从 Kafka 主题扩展数据使用的主要方法是向使用者组添加更多使用者。Kafka 使用者通常会执行高延迟操作,例如写入数据库或对数据进行耗时的计算。 在这些情况下,单个使用者不可能跟上数据流入主题的速率,通过让每个使用者只拥有分区和消息的子集来添加更多分担负载的使用者是我们的主要扩展方法。这是创建具有大量分区的主题的一个很好的理由 - 它允许在负载增加时添加更多使用者。请记住,在主题中添加的消费者数量超过分区数量是没有意义的,因为某些消费者只是处于空闲状态。第 2 章包括一些关于如何在主题中选择分区数的建议。

除了添加使用者以扩展单个应用程序之外,有多个应用程序需要从同一主题读取数据是很常见的。事实上,Kafka 的主要设计目标之一是使 Kafka 主题生成的数据可用于整个组织的许多用例。在这些情况下,我们希望每个应用程序都能获取所有消息,而不仅仅是一个子集。要确保应用程序获取主题中的所有消息,请确保应用程序具有自己的使用者组。与许多传统的消息传递系统不同,Kafka 可以在不降低性能的情况下扩展到大量使用者和使用者组。

在前面的示例中,如果我们添加一个新的消费者组 G2 和单个消费者,则该消费者将获得主题 T1 中的所有消息,而与 G1 正在执行的操作无关。G2 可以有多个消费者,在这种情况下,它们将获得一个分区的子集,就像我们在 G1 中显示的那样,但 G2 作为一个整体仍将获得所有消息,而不管其他消费者组如何。请参见图 4-5。

???????????????????????????????????????????????????????图4-5 添加新的使用者组可确保不会丢失任何消息

总而言之,您需要为每个应用程序创建一个新的使用者组,该应用程序需要来自一个或多个主题的所有消息。将使用者添加到现有使用者组以扩展从主题读取和处理消息,因此组中的每个额外使用者将仅获得消息的子集。

4.1.2 使用者组和分区重新平衡

正如我们在上一节中看到的,使用者组中的使用者共享他们订阅的主题中分区的所有权。当我们将新的使用者添加到组中时,它开始使用以前由另一个使用者使用的分区中的消息。当消费者关闭或崩溃时,也会发生同样的事情;它离开该组,它过去使用的分区将由剩余的使用者之一使用。当使用者组正在使用的主题被修改时(例如,如果管理员添加新分区),也会将分区重新分配给使用者。

将分区所有权从一个使用者转移到另一个使用者称为重新平衡。重新平衡很重要,因为它们为消费者组提供了高可用性和可伸缩性(允许我们轻松安全地添加和删除消费者),但在正常事件过程中,它们是相当不可取的。在重新平衡期间,消费者不能使用消息,因此重新平衡基本上是整个消费者组不可用的短暂窗口。此外,当分区从一个使用者移动到另一个使用者时,使用者将失去其当前状态;如果它正在缓存任何数据,它将需要刷新其缓存,从而减慢应用程序的速度,直到使用者再次设置其状态。在本章中,我们将讨论如何安全地处理再平衡以及如何避免不必要的再平衡。

使用者维护使用者组中的成员身份和分配给它们的分区的所有权的方式是将检测信号发送到指定为组协调器的 Kafka 代理(对于不同的使用者组,此代理可能不同)。只要使用者定期发送检测信号,就假定它处于活动状态,并且正在处理来自其分区的消息。当使用者轮询(即检索记录)并提交已使用的记录时,将发送检测信号。

如果使用者停止发送检测信号的时间足够长,则其会话将超时,组协调器将认为它已死并触发重新平衡。如果使用者崩溃并停止处理消息,则组协调器将需要几秒钟的时间(没有心跳)才能确定它已死并触发重新平衡。在这几秒钟内,不会处理来自死使用者拥有的分区的任何消息。当干净地关闭一个消费者时,消费者会通知组协调员它要离开了,组协调员会立即触发再平衡,减少处理中的差距。在本章的后面部分,我们将讨论控制检测信号频率和会话超时的配置选项,以及如何设置这些选项以满足您的要求。

-

最新 Kafka 版本中检测信号行为的更改

在 0.10.1 版本中,Kafka 社区引入了一个单独的心跳线程,该线程也将在轮询之间发送心跳。这允许您将检测信号频率(以及消费者组检测到消费者崩溃且不再发送检测信号所需的时间)与轮询频率(由处理从代理返回的数据所需的时间决定)分开。使用较新版本的 Kafka,您可以配置应用程序在离开组并触发重新平衡之前可以在不轮询的情况下运行多长时间。此配置用于防止实时锁定,即应用程序未崩溃,但由于某种原因无法取得进展。此配置独立于 session.time out.ms,后者控制检测使用者崩溃和停止发送检测信号所需的时间。

本章的其余部分将讨论旧行为的一些挑战,以及程序员如何处理这些挑战。本章讨论如何处理处理记录所需的时间较长的应用程序。这与运行 Apache Kafka 0.10.1 或更高版本的读者不太相关。如果您使用的是新版本,并且需要处理需要更长时间才能处理的记录,则只需调整 max.poll.interval.ms 以便它能够处理轮询新记录之间的更长延迟。

4.2 创建 Kafka 消费者

开始消费记录的第一步是创建一个 KafkaConsumer 实例。创建 KafkaConsumer 与创建 KafkaProducer 非常相似,即使用要传递给使用者的属性创建一个 Java Properties 实例。我们将在本章后面深入讨论所有属性。首先,我们只需要使用三个必需的属性:bootstrap.servers、key.deserializer 和 value.deserializer。

第一个属性 bootstrap.servers 是 Kafka 群集的连接字符串。它的使用方式与 KafkaProducer 中的使用方式完全相同(有关如何定义它的详细信息,您可以参考第 3 章)。另外两个属性 key.deserializer 和 value.deserializer 与为生产者定义的序列化程序类似,但您需要指定可以接受字节数组并将其转换为 Java 对象的类,而不是指定将 Java 对象转换为字节数组的类。

还有第四个属性,它不是严格强制性的,但现在我们将假装它是强制性的。该属性为 group.id,它指定 KafkaConsumer 实例所属的使用者组。虽然可以创建不属于任何消费者组的消费者,但这种情况并不常见,因此在本章的大部分时间里,我们将假设消费者是组的一部分。

以下代码片段演示如何创建 KafkaConsumer:

?Properties props = new Properties();

?props.put("bootstrap.servers", "broker1:9092,broker2:9092");

?props.put("group.id", "CountryCounter");

?props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

?props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

?KafkaConsumer<String, String> consumer = new KafkaConsumer<String, ?String>(props);

如果你读过关于创建生产者的第 3 章,你在这里看到的大部分内容应该很熟悉。我们假设我们使用的记录将具有 String 对象作为记录的键和值。此处唯一的新属性是 group.id,这是此使用者所属的使用者组的名称。

4.3 订阅主题

创建消费者后,下一步是订阅一个或多个主题。subcribe() 方法将主题列表作为参数,因此使用起来非常简单:

?consumer.subscribe(Collections.singletonList("customerCountries"));

(1) 在这里,我们只需创建一个包含单个元素的列表:主题名称 customerCountries。

也可以使用正则表达式调用 subscribe。该表达式可以匹配多个主题名称,如果有人使用匹配的名称创建新主题,则几乎会立即发生重新平衡,消费者将开始从新主题消费。这对于需要从多个主题使用的应用程序非常有用,并且可以处理主题将包含的不同类型的数据。使用正则表达式订阅多个主题最常用于在 Kafka 和其他系统之间复制数据的应用程序。

要订阅所有测试主题,我们可以调用:

?consumer.subscribe("test.*");

4.4 轮询循环

使用者 API 的核心是一个简单的循环,用于轮询服务器以获取更多数据。一旦消费者订阅了主题,轮询循环就会处理协调、分区重新平衡、检测信号和数据获取的所有细节,从而为开发人员留下一个干净的 API,该 API 只需从分配的分区返回可用数据。消费者的主体如下所示:

?try {

? ? ? ? ? while (true) { ? (1)

? ? ? ? ? ConsumerRecords<String, String> records = consumer.poll(100); ? ? ? (2)

? ? ? ? ? for (ConsumerRecord<String, String> record : records) ? ? ? (3)

? ? ? ? ? {

? ? ? ? ? ? ? ? ? log.debug("topic = %s, partition = %s, offset = %d,

? ? ? ? ? ? ? ? ? customer = %s, country = %s\n",

? ? ? ? ? ? ? ? ? record.topic(), record.partition(), record.offset(),

? ? ? ? ? ? ? ? ? record.key(), record.value());

? ? ? ? ? ? ? ? ? int updatedCount = 1;

? ? ? ? ? ? ? ? ? if (custCountryMap.countainsValue(record.value())) {

? ? ? ? ? ? ? ? ? updatedCount = custCountryMap.get(record.value()) + 1;

? ? ? ? ? ? ? ? }

? ? ? ? ? ? ? custCountryMap.put(record.value(), updatedCount)

? ? ? ? ? ? ? JSONObject json = new JSONObject(custCountryMap);

? ? ? ? ? ? ? System.out.println(json.toString(4)) ? (4)

? ? ? ? ? }

? }

? } finally {

? ? ?consumer.close(); ? (5)

?}

(1)这确实是一个无限循环。使用者通常是长时间运行的应用程序,它们会不断轮询 Kafka 以获取更多数据。在本章的后面,我们将展示如何干净利落地退出循环并关闭消费者。

(2)这是本章中最重要的一行。就像鲨鱼必须继续移动或死亡一样,消费者必须继续轮询 Kafka,否则它们将被视为死亡,它们正在消耗的分区将交给组中的另一个消费者继续消费。我们传递的参数 poll() 是一个超时间隔,用于控制 poll() 在消费者缓冲区中没有数据时阻塞多长时间。如果设置为 0,poll() 将立即返回;否则,它将等待指定的毫秒数,以便数据从代理到达。

(3) poll() 返回记录列表。每条记录都包含记录来自的主题和分区、分区内记录的偏移量,当然还有记录的键和值。通常,我们希望循环访问列表并单独处理记录。poll() 方法采用超时参数。这指定了轮询返回所需的时间,无论是否包含数据。该值通常由应用程序对快速响应的需求驱动,即您希望以多快的速度将控制权返回给执行轮询的线程?

(4)处理通常以在数据存储中写入结果或更新存储的记录而告终。在这里,目标是保持每个县的客户的运行计数,因此我们更新了一个哈希表并将结果打印为 JSON。一个更实际的例子是将更新结果存储在数据存储中。

(5)在退出之前,务必关闭消费者()。这将关闭网络连接和套接字。它还将立即触发重新平衡,而不是等待组协调器发现使用者停止发送检测信号并且可能已死亡,这将花费更长的时间,因此会导致使用者无法使用来自分区子集的消息的时间更长。

轮询循环的作用不仅仅是获取数据。第一次使用新使用者调用 poll() 时,它负责查找 GroupCoordinator、加入使用者组并接收分区分配。如果触发了再平衡,它也将在轮询循环中处理。当然,让消费者保持活力的心跳是从投票循环中发送的。出于这个原因,我们试图确保我们在迭代之间所做的任何处理都是快速和高效的。

-

线程安全

不能在一个线程中拥有属于同一组的多个使用者,也不能让多个线程安全地使用同一个使用者。每个线程一个使用者是规则。若要在一个应用程序中运行同一组中的多个使用者,需要在自己的线程中运行每个使用者。将消费者逻辑包装在自己的对象中,然后使用 Java 的 ExecutorService 启动多个线程,每个线程都有自己的消费者,这很有用。Confluent 博客有一个教程,展示了如何做到这一点。

4.5 配置使用者

到目前为止,我们专注于学习消费者 API,但我们只查看了几个配置属性——只有必需的 bootstrap.servers、group.id、key.deserializer 和 value.deserializer。所有使用者配置都记录在 Apache Kafka 文档中。大多数参数具有合理的默认值,不需要修改,但有些参数会影响使用者的性能和可用性。让我们来看看一些更重要的属性。

-

fetch.min.bytes

此属性允许使用者指定在提取记录时希望从代理接收的最小数据量。如果代理收到来自使用者的记录请求,但新记录的字节数少于 min.fetch.bytes,则代理将等到有更多消息可用后再将记录发送回使用者。这减少了使用者和代理的负载,因为在主题没有太多新活动(或一天中的较低活动时间)的情况下,他们必须处理较少的来回消息。如果使用者在可用数据不多时使用过多的 CPU,则需要将此参数设置为高于默认值,或者在有大量使用者时减少代理上的负载。

-

fetch.max.wait.ms

通过设置 fetch.min.bytes,您可以告诉 Kafka 等到它有足够的数据要发送后再响应使用者。fetch.max.wait.ms 可让您控制等待多长时间。默认情况下,Kafka 将等待长达 500 毫秒。这会导致长达 500 毫秒的额外延迟,以防没有足够的数据流向 Kafka 主题来满足要返回的最小数据量。如果要限制潜在的延迟(通常是由于 SLA 控制应用程序的最大延迟),可以将 fetch.max.wait.ms 设置为较低的值。如果将 fetch.max.wait.ms 设置为 100 毫秒,将 fetch.min.bytes 设置为 1 MB,则 Kafka 将收到来自消费者的提取请求,并在有 1 MB 数据返回时或 100 毫秒后(以先发生者为准)响应数据。

-

max.partition.fetch.bytes

此属性控制服务器将返回每个分区的最大字节数。默认值为 1 MB,这意味着当 KafkaConsumer.poll() 返回 ConsumerRecords 时,记录对象将最多使用分配给使用者的每个分区的 max.partition.fetch.bytes。因此,如果一个主题有 20 个分区,而您有 5 个使用者,则每个使用者需要有 4 MB 的内存可用于使用者记录。在实践中,如果组中的其他使用者 fail.max.partition.fetch.bytes 必须大于代理将接受的最大消息(由代理配置中的 max.message.size 属性确定),或者代理可能具有使用者无法使用的消息,则每个使用者将需要处理更多分区,因此您需要分配更多内存。 在这种情况下,消费者将挂起试图阅读它们。设置 max.partition.fetch.bytes 时的另一个重要考虑因素是使用者处理数据所需的时间。正如您所记得的,使用者必须足够频繁地调用 poll(),以避免会话超时和随后的重新平衡。如果单个 poll() 返回的数据量非常大,则使用者可能需要更长的时间来处理,这意味着它将无法及时到达轮询循环的下一次迭代以避免会话超时。如果发生这种情况,两个选项是降低最大 partition.fetch.bytes 或增加会话超时。

-

session.timeout.ms

消费者在仍被视为活着的情况下与经纪人失去联系的时间默认为 3 秒。如果超过 session.timeout.ms 次使用者没有向组协调器发送检测信号,则认为它已死,组协调器将触发使用者组的重新平衡,以将分区从死使用者分配给组中的其他使用者。此属性与 heartbeat.interval.ms 密切相关。heartbeat.interval.ms 控制 KafkaConsumer poll() 方法向组协调器发送检测信号的频率,而 session.timeout.ms 控制使用者可以在多长时间内不发送检测信号。因此,这两个属性通常一起修改,heatbeat.interval.ms 必须低于 session.timeout.ms,并且通常设置为超时值的三分之一。因此,如果 session.timeout.ms 是 3 秒,heartbeat.interval.ms 应该是 1 秒。将 session.timeout.ms 设置为低于默认值将允许使用者组更快地检测故障并从故障中恢复,但也可能导致不必要的重新平衡,因为使用者需要更长的时间来完成轮询循环或垃圾回收。将 session.timeout.ms 设置得更高将减少意外重新平衡的机会,但也意味着需要更长的时间才能检测到真正的故障。

-

auto.offset.reset

此属性控制使用者在开始读取没有提交偏移量的分区时的行为,或者如果它具有的已提交偏移量无效(通常是因为使用者关闭的时间太长,以至于具有该偏移量的记录已经从代理中过期)。默认值为“latest”,这意味着在缺少有效偏移量的情况下,使用者将开始从最新记录(使用者开始运行后写入的记录)读取。另一种选择是“最早”,这意味着缺少有效的偏移量,使用者将从头开始读取分区中的所有数据。

-

enable.auto.commit

在本章前面,我们讨论了提交偏移量的不同选项。此参数控制使用者是否自动提交偏移量,默认值为 true。如果您希望控制何时提交偏移量,请将其设置为 false,这对于最大限度地减少重复项和避免丢失数据是必要的。如果将 enable.auto.commit 设置为 true,则可能还需要控制使用 auto.commit.interval.ms 提交偏移量的频率。

-

partition.assignment.strategy

我们了解到,分区是分配给使用者组中的使用者的。PartitionAssignor 是一个类,它给定使用者和订阅的主题,决定将哪些分区分配给哪个使用者。默认情况下,Kafka 有两种赋值策略:

-

Range

将它订阅的每个主题中的连续分区子集分配给每个使用者。因此,如果使用者 C1 和 C2 订阅了两个主题,即 T1 和 T2,并且每个主题都有三个分区,则将从主题 T1 和 T2 为 C1 分配分区 0 和 1,而 C2 将从这些主题分配分区 2。由于每个主题的分区数不均匀,并且每个主题的分配是独立完成的,因此第一个使用者最终比第二个使用者拥有更多的分区。每当使用范围分配并且使用者数量不会整齐地划分每个主题中的分区数时,就会发生这种情况。

-

RoundRobin

从所有订阅的主题中获取所有分区,并按顺序将它们逐个分配给使用者。如果 C1 和 C2 之前使用循环分配,则 C1 将具有来自主题 T1 的分区 0 和 2 以及来自主题 T2 的分区 1。C2 将具有来自主题 T1 的分区 1 和来自主题 T2 的分区 0 和 2。通常,如果所有使用者都订阅了相同的主题(一种非常常见的情况),则循环分配最终将导致所有使用者具有相同数量的分区(或最多 1 个分区差异)。

partition.assignment.strategy 允许您选择分区分配策略。默认值为 org.apache.kafka.clients.consumer.RangeAssignor,它实现了上述 Range 策略。您可以将其替换为 org.apache.kafka.clients.consumer.RoundRobinAssignor。更高级的选项是实现您自己的赋值策略,在这种情况下,partition.assignment.strategy 应指向您的类的名称。

-

-

client.id

这可以是任何字符串,代理将使用它来标识从客户端发送的消息。它用于日志记录和指标,以及配额。

-

max.poll.records

这控制了对 poll() 的单次调用将返回的最大记录数。这有助于控制应用程序在轮询循环中需要处理的数据量。

-

receive.buffer.bytes and send.buffer.bytes

这些是套接字在写入和读取数据时使用的 TCP 发送和接收缓冲区的大小。如果这些值设置为 -1,则将使用 OS 默认值。当生产者或使用者与不同数据中心的代理通信时,增加这些链接可能是一个好主意,因为这些网络链接通常具有更高的延迟和更低的带宽。

4.6 提交和偏移

每当我们调用 poll() 时,它都会返回写入 Kafka 的记录,而我们组中的消费者尚未读取。这意味着我们有一种方法可以跟踪组的消费者读取了哪些记录。如前所述,Kafka 的一个独特特性是它不像许多 JMS 队列那样跟踪来自消费者的确认。相反,它允许使用者使用 Kafka 来跟踪他们在每个分区中的位置(偏移量)。

我们将更新分区中当前位置的操作称为提交。

使用者如何提交偏移量?它向 Kafka 生成一条消息,发送到一个特殊的 __consumer_offsets 主题,其中包含每个分区的已提交偏移量。只要您的所有消费者都启动、运行并流失,这就不会产生任何影响。但是,如果消费者崩溃或新的消费者加入消费者组,这将触发重新平衡。重新平衡后,可能会为每个使用者分配一组新的分区,而不是之前处理的分区。为了知道从哪里开始工作,使用者将读取每个分区的最新提交偏移量,并从那里继续。

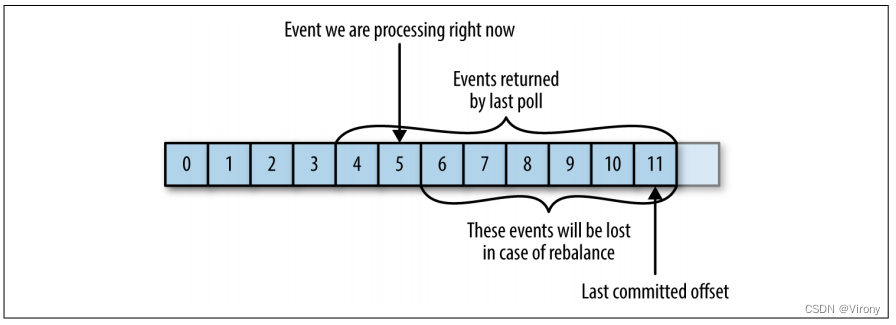

如果提交偏移量小于客户端处理的上一条消息的偏移量,则上次处理的偏移量和提交偏移量之间的消息将被处理两次。请参见图 4-6。

????????????????????????????????????????????????????????????????????????????????图4-6 重新处理的消息

如果提交偏移量大于客户端实际处理的最后一条消息的偏移量,则使用者组将丢失上次处理的偏移量和提交偏移量之间的所有消息。请参见图 4-7。

????????????????????????????????????????????????????????????????????????????????图4-7 偏移量之间的丢失消息

显然,管理偏移量对客户端应用程序有很大影响。KafkaConsumer API 提供了多种提交偏移量的方法:

4.6.1 自动提交

提交偏移量的最简单方法是允许使用者为您执行此操作。如果配置 enable.auto.commit=true,则使用者将每 5 秒提交一次客户端从 poll() 接收到的最大偏移量。五秒间隔是默认间隔,通过设置 auto.commit.interval.ms 进行控制。就像使用者中的其他所有内容一样,自动提交由轮询循环驱动。每当您轮询时,使用者都会检查是否该提交,如果该提交,它将提交上次轮询中返回的偏移量。

但是,在使用这个方便的选项之前,重要的是要了解后果。

请注意,默认情况下,自动提交每 5 秒发生一次。假设我们在最近一次提交后 3 秒,并触发了重新平衡。重新平衡后,所有消费者将从上次承诺的抵消量开始消费。在本例中,偏移量为 3 秒,因此在这 3 秒内到达的所有事件都将被处理两次。可以将提交间隔配置为更频繁地提交并减少复制记录的窗口,但不可能完全消除它们。

启用自动提交后,对轮询的调用将始终提交上一次轮询返回的最后一个偏移量。它不知道实际处理了哪些事件,因此在再次调用 poll() 之前始终处理 poll() 返回的所有事件至关重要。(就像 poll() 一样,close() 也会自动提交偏移量。这通常不是问题,但在处理异常或过早退出轮询循环时要注意。

自动提交很方便,但它们不能为开发人员提供足够的控制权来避免重复消息。

4.6.2 提交当前偏移

大多数开发人员对提交偏移量的时间进行更多控制,既可以消除丢失消息的可能性,也可以减少重新平衡期间重复的消息数。使用者 API 可以选择在对应用程序开发人员有意义的点提交当前偏移量,而不是基于计时器。

通过设置 auto.commit.offset=false,仅当应用程序明确选择这样做时,才会提交偏移量。最简单、最可靠的提交 API 是 commitSync()。此 API 将提交 poll() 返回的最新偏移量,并在提交偏移量后返回,如果由于某种原因提交失败,则抛出异常。

请务必记住,commitSync() 将提交 poll() 返回的最新偏移量,因此请确保在处理完集合中的所有记录后调用 commitSync(),否则可能会丢失如前所述的消息。触发重新平衡时,从最近一批开始到重新平衡的所有消息都将被处理两次。

以下是在处理完最新一批消息后,我们将如何使用 commitSync 提交偏移量:

?while (true) {

? ? ? ? ? ConsumerRecords<String, String> records = consumer.poll(100);

? ? ? ? ? for (ConsumerRecord<String, String> record : records)

? ? ? ? ? {

? ? ? ? ? ? ? ? ? System.out.printf("topic = %s, partition = %s, offset =

? ? ? ? ? ? ? ? ? %d, customer = %s, country = %s\n",

? ? ? ? ? ? ? ? ? record.topic(), record.partition(),

? ? ? ? ? ? ? ? ? record.offset(), record.key(), record.value()); ? ?(1)

? ? ? ? ? }

? ? ? ? ? try {

? ? ? ? ? ? ? ? ? consumer.commitSync(); ? (2)

? ? ? ? ? ? ? ? ? } catch (CommitFailedException e) {

? ? ? ? ? ? ? ? ? log.error("commit failed", e) ? (3)

? ? ? ? ? }

?}

(1)假设通过打印记录的内容,我们已经完成了对记录的处理。您的应用程序可能会对记录执行更多操作 - 修改记录、扩充记录、聚合记录、在仪表板上显示记录或通知用户重要事件。您应该根据用例确定何时“完成”记录。

(2)完成“处理”当前批处理中的所有记录后,我们调用 commitSync 来提交批处理中的最后一个偏移量,然后再轮询其他消息。

(3)commitSync 会重试提交,只要没有无法恢复的错误。如果发生这种情况,除了记录错误之外,我们无能为力。

4.6.3 异步提交

手动提交的一个缺点是,在代理响应提交请求之前,应用程序将被阻塞。这将限制应用程序的吞吐量。可以通过降低提交频率来提高吞吐量,但随后我们会增加重新平衡将创建的潜在重复项的数量。

另一种选择是异步提交 API。我们无需等待代理响应提交,只需发送请求并继续:

?while (true) {

? ? ? ? ? ConsumerRecords<String, String> records = consumer.poll(100);

? ? ? ? ? for (ConsumerRecord<String, String> record : records)

? ? ? ? ? {

? ? ? ? ? ? ? ? ? System.out.printf("topic = %s, partition = %s,

? ? ? ? ? ? ? ? ? offset = %d, customer = %s, country = %s\n",

? ? ? ? ? ? ? ? ? record.topic(), record.partition(), record.offset(),

? ? ? ? ? ? ? ? ? record.key(), record.value());

? ? ? ? ? }

? ? ? ? ? consumer.commitAsync(); ? ?(1)

?}

(1)提交最后一个偏移量并继续。

缺点是,虽然 commitSync() 将重试提交,直到成功或遇到不可重试的失败,但 commitAsync() 不会重试。它不重试的原因是,当 commitAsync() 收到来自服务器的响应时,可能已经有后来的提交成功了。想象一下,我们发送了一个提交偏移量 2000 的请求。存在暂时的通信问题,因此代理永远不会收到请求,因此从不响应。同时,我们处理了另一批,并成功提交了偏移量 3000。如果 commitA sync() 现在重试以前失败的提交,则在处理并提交偏移量 3000 后,它可能会成功提交偏移量 2000。在重新平衡的情况下,这将导致更多的重复。

我们提到了这种复杂性以及正确提交顺序的重要性,因为 commitAsync() 还为您提供了一个选项,用于传递将在代理响应时触发的回调。通常使用回调来记录提交错误或将其计入指标中,但如果要使用回调进行重试,则需要注意提交顺序的问题:

?while (true) {

? ? ? ? ? ConsumerRecords<String, String> records = consumer.poll(100);

? ? ? ? ? for (ConsumerRecord<String, String> record : records) {

? ? ? ? ? ? ? ? ? System.out.printf("topic = %s, partition = %s,

? ? ? ? ? ? ? ? ? offset = %d, customer = %s, country = %s\n",

? ? ? ? ? ? ? ? ? record.topic(), record.partition(), record.offset(),

? ? ? ? ? ? ? ? ? record.key(), record.value());

? ? ? ? ? }

? ? ? ? ? consumer.commitAsync(new OffsetCommitCallback() {

? ? ? ? ? ? ? ? ? public void onComplete(Map<TopicPartition,

? ? ? ? ? ? ? ? ? OffsetAndMetadata> offsets, Exception exception) {

? ? ? ? ? ? ? ? ? ? ? ? ? if (e != null)

? ? ? ? ? ? ? ? ? ? ? ? ? log.error("Commit failed for offsets {}", offsets, e);

? ? ? ? ? ? ? ? ? }

? ? ? ? ? }); ? ? (1)

?}

(1)我们发送提交并继续,但如果提交失败,则将记录失败和偏移量。

-

Retrying Async Commits

为异步重试获得正确的提交顺序的一个简单模式是使用单调递增的序列号。每次提交时增加序列号,并将提交时的序列号添加到 commitAsync 回调中。当您准备发送重试时,请检查回调获得的提交序列号是否等于实例变量;如果是,则没有更新的提交,重试是安全的。如果实例序列号更高,请不要重试,因为已发送了较新的提交。

4.6.4 结合同步和异步提交

通常,偶尔在不重试的情况下提交失败并不是一个大问题,因为如果问题是暂时的,那么接下来的提交就会成功。但是,如果我们知道这是关闭使用者或重新平衡之前的最后一次提交,我们希望额外确保提交成功。

因此,一种常见的模式是在关机前将 commitAsync() 与 commitSync() 组合在一起。以下是它的工作原理(当我们进入有关再平衡侦听器的部分时,我们将讨论如何在重新平衡之前提交):

?try {

? ? ? ? ? while (true) {

? ? ? ? ? ? ? ? ? ConsumerRecords<String, String> records = consumer.poll(100);

? ? ? ? ? ? ? ? ? for (ConsumerRecord<String, String> record : records) {

? ? ? ? ? ? ? ? ? ? ? ? ? ? ? System.out.printf("topic = %s, partition = %s, offset = %d,

? ? ? ? ? ? ? ? ? ? ? ? ? ? ? customer = %s, country = %s\n",

? ? ? ? ? ? ? ? ? ? ? ? ? ? ? record.topic(), record.partition(),

? ? ? ? ? ? ? ? ? ? ? ? ? ? ? record.offset(), record.key(), record.value());

? ? ? ? ? ? ? ? ? }

? ? ? ? ? consumer.commitAsync(); ?(1)

? ? ? ? ? }

?} catch (Exception e) {

? ? ? ? ? log.error("Unexpected error", e);

?} finally {

? ? ? ? ? try {

? ? ? ? ? consumer.commitSync(); ? ?(2)

? ? ? ? ? } finally {

? ? ? ? ? consumer.close();

? ? ? ? ? }

?}

(1)虽然一切都很好,但我们使用 commitAsync。速度更快,如果一次提交失败,下一次提交将作为重试。

(2)但是,如果我们要关闭,则没有“下一次提交”。我们调用 commitSync(),因为它将重试,直到成功或遭受不可恢复的失败。

4.6.5 提交指定偏移量

提交最新偏移量仅允许您在完成批处理后提交。但是,如果您想更频繁地提交呢?如果 poll() 返回一个巨大的批处理,并且您希望在批处理的中间提交偏移量,以避免在发生重新平衡时必须再次处理所有这些行,该怎么办?您不能只调用 commitSync() 或 commitAsync() — 这将提交返回的最后一个偏移量,您尚未处理该偏移量。

幸运的是,使用者 API 允许您调用 commitSync() 和 commitAsync() 并传递您希望提交的分区和偏移量的映射。如果您正在处理一批记录,并且从主题“customers”中的分区 3 收到的最后一条消息偏移量为 5000,则可以调用 commitSync() 为主题“customers”中的分区 3 提交偏移量 5000。由于使用者可能使用多个分区,因此需要跟踪所有分区的偏移量,这会增加代码的复杂性。

下面是特定偏移量的提交的样子:

?private Map<TopicPartition, OffsetAndMetadata> currentOffsets = new HashMap<>(); ? (1)

?int count = 0;

?....

?while (true) {

? ? ? ? ? ConsumerRecords<String, String> records = consumer.poll(100);

? ? ? ? ? for (ConsumerRecord<String, String> record : records)

? ? ? ? ? {

? ? ? ? ? ? ? ? ? System.out.printf("topic = %s, partition = %s, offset = %d,

? ? ? ? ? ? ? ? ? customer = %s, country = %s\n",

? ? ? ? ? ? ? ? ? record.topic(), record.partition(), record.offset(),

? ? ? ? ? ? ? ? ? record.key(), record.value()); ? ? (2)

? ? ? ? ? ? ? ? ? currentOffsets.put(new TopicPartition(record.topic(),

? ? ? ? ? ? ? ? ? record.partition()), new

? ? ? ? ? ? ? ? ? OffsetAndMetadata(record.offset()+1, "no metadata")); ? ?(3)

? ? ? ? ? ? ? ? ? if (count % 1000 == 0) ? ? (4)

? ? ? ? ? ? ? ? ? consumer.commitAsync(currentOffsets, null); ? ?(5)

? ? ? ? ? ? ? ? ? count++;

? ? ? ? ? }

?}

(1)这是我们将用于手动跟踪偏移量的映射。

(2)请记住,println 是您对使用的记录进行的任何处理的替代。

(3)读取每条记录后,我们使用预期要处理的下一条消息的偏移量更新偏移量映射。这是我们下次开始阅读的地方。

(4)在这里,我们决定每 1,000 条记录提交一次电流偏移量。在应用程序中,您可以根据时间或记录内容提交。

(5)我选择调用commitAsync(),但commitSync()在这里也是完全有效的。当然,在提交特定偏移量时,您仍然需要执行我们在前几节中看到的所有错误处理。

4.7 重新平衡侦听器

正如我们在上一节中提到的关于提交偏移量,使用者希望在退出之前以及分区重新平衡之前做一些清理工作。

如果你知道你的使用者即将失去对分区的所有权,你将需要提交你处理的最后一个事件的偏移量。如果你的使用者维护了一个缓冲区,其中包含它只是偶尔处理的事件(例如,我们在解释 pause() 功能时使用的 currentRecords 映射),你将需要在失去分区所有权之前处理你积累的事件。也许您还需要关闭文件句柄、数据库连接等。

使用者 API 允许您在使用者中添加或删除分区时运行自己的代码。为此,您可以在调用我们之前讨论的 subscribe() 方法时传递 ConsumerRebalanceListener。ConsumerRebalance Listener 有两种方法可以实现:

-

public void onPartitionsRevoked(Collection<TopicPartition> partition

在重新平衡开始之前和使用者停止使用消息之后调用。这是您要提交偏移量的地方,因此下一个获得此分区的人将知道从哪里开始。

-

public void onPartitionsAssigned(Collection<TopicPartition> partition

在将分区重新分配给代理之后,但在使用者开始使用消息之前调用。

此示例将展示如何使用 onPartitionsRevoked() 在失去分区所有权之前提交偏移量。在下一节中,我们将展示一个更复杂的示例,该示例还演示了 onPartitionsAssigned() 的使用:

?private Map<TopicPartition, OffsetAndMetadata> currentOffsets = ?new HashMap<>();

?private class HandleRebalance implements ConsumerRebalanceListener { ? ?(1)

? public void onPartitionsAssigned(Collection<TopicPartition>

? partitions) { ? ?(2)

? }

? public void onPartitionsRevoked(Collection<TopicPartition>

? partitions) {

? System.out.println("Lost partitions in rebalance.

? Committing current

? offsets:" + currentOffsets);

? consumer.commitSync(currentOffsets); ? ?(3)

? }

?}

?try {

? ? ?consumer.subscribe(topics, new HandleRebalance()); ? ?(4)

? while (true) {

? ConsumerRecords<String, String> records =

? consumer.poll(100);

? ? ? ? ? ? ? for (ConsumerRecord<String, String> record : records)

? ? ? ? ? ? ? {

? ? ? ? ? ? ? ? ? System.out.printf("topic = %s, partition = %s, offset = %d,

? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? customer = %s, country = %s\n",

? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? record.topic(), record.partition(), record.offset(),

? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? record.key(), record.value());

? ? ? ? ? ? ? ? ? currentOffsets.put(new TopicPartition(record.topic(),

? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? record.partition()), new

? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ?OffsetAndMetadata(record.offset()+1, "no metadata"));

? ? ? ? ? ? ? }

? ? ? ? ? ? ?consumer.commitAsync(currentOffsets, null);

? ? ? ? ? }

?} catch (WakeupException e) {

? // ignore, we're closing

?} catch (Exception e) {

? log.error("Unexpected error", e);

?} finally {

? ? ? try {

? ? ? consumer.commitSync(currentOffsets);

? ? ? } finally {

? ? ? ? ? ? ? consumer.close();

? ? ? ? ? ? ? System.out.println("Closed consumer and we are done");

? ? ? }

? }

(1)我们首先实现一个 ConsumerRebalanceListener。

(2)在这个例子中,当我们得到一个新分区时,我们不需要做任何事情;我们将开始使用消息。

(3)但是,当我们即将因重新平衡而丢失分区时,我们需要提交偏移量。请注意,我们提交的是已处理的最新偏移量,而不是仍在处理的批处理中的最新偏移量。这是因为当我们仍处于批处理的中间时,分区可能会被撤销。我们正在为所有分区提交偏移量,而不仅仅是我们将要丢失的分区 - 因为偏移量是针对已经处理的事件的,所以这没有什么坏处。 我们使用 commitSync() 来确保在重新平衡进行之前提交偏移量。

(4)最重要的部分:将 ConsumerRebalanceListener 传递给 subscribe() 方法,以便消费者调用它。

4.8 使用具有特定偏移量的记录

到目前为止,我们已经了解了如何使用 poll() 开始使用每个分区中最后一个提交偏移量的消息,并继续按顺序处理所有消息。但是,有时您希望从不同的偏移量开始读取。

如果要从分区的开头开始读取所有消息,或者想要一直跳到分区末尾并开始仅使用新消息,则可以使用专门用于此的 API:seekToBeginning(TopicPartition tp) 和 seekToEnd(TopicPartition tp)。

但是,Kafka API 还允许您查找特定的偏移量。这种能力可以以多种方式使用;例如,要返回几条消息或跳过几条消息(也许落后的时间敏感应用程序会希望跳过到更相关的消息)。此功能最令人兴奋的用例是当偏移量存储在 Kafka 以外的系统中时。

想想这个常见的场景:你的应用程序正在从 Kafka 读取事件(可能是网站中用户的点击流),处理数据(可能删除指示来自自动化程序而不是用户的点击的记录),然后将结果存储在数据库、NoSQL 存储或 Hadoop 中。假设我们真的不想丢失任何数据,也不想在数据库中存储相同的结果两次。

在这些情况下,使用者循环可能如下所示:

?while (true) {

? ? ? ? ? ConsumerRecords<String, String> records = consumer.poll(100);

? ? ? ? ? for (ConsumerRecord<String, String> record : records)

? ? ? ? ? {

? ? ? ? ? ? ? ? ? currentOffsets.put(new TopicPartition(record.topic(),

? ? ? ? ? ? ? ? ? record.partition()),

? ? ? ? ? ? ? ? ? record.offset());

? ? ? ? ? ? ? ? ? processRecord(record);

? ? ? ? ? ? ? ? ? storeRecordInDB(record);

? ? ? ? ? ? ? ? ? consumer.commitAsync(currentOffsets);

? ? ? ? ? }

?}

在此示例中,我们非常偏执,因此我们在处理每条记录后提交偏移量。但是,在记录存储在数据库中之后,但在我们提交偏移量之前,我们的应用程序仍有可能崩溃,从而导致再次处理记录并且数据库包含重复项。

如果有一种方法可以将记录和偏移量都存储在一个原子操作中,则可以避免这种情况。要么同时提交记录和偏移量,要么两者都不提交。只要将记录写入数据库,将偏移量写入 Kafka,这是不可能的。

但是,如果我们在一个事务中同时将记录和偏移量写入数据库,那会怎样?然后,我们将知道,要么我们完成了记录并提交了偏移量,要么我们还没有完成,并且将重新处理记录。

现在唯一的问题是,如果记录存储在数据库中而不是 Kafka 中,那么当记录被分配分区时,我们的消费者如何知道从哪里开始读取?这正是 seek() 的用途。当使用者启动或分配新分区时,它可以在数据库中查找偏移量并 seek() 到该位置。

下面是一个框架示例,说明其工作原理。我们使用 ConsumerRebalanceLister 和 seek() 来确保我们从存储在数据库中的偏移量开始处理:

?public class SaveOffsetsOnRebalance implements

? ? ? ConsumerRebalanceListener {

? ? ? ? ? public void onPartitionsRevoked(Collection<TopicPartition>

? ? ? ? ? partitions) {

? ? ? ? ? commitDBTransaction(); ? (1)

? ? ? ? ? }

? ? ? ? ? public void onPartitionsAssigned(Collection<TopicPartition>

? ? ? ? ? partitions) {

? ? ? ? ? ? ? for(TopicPartition partition: partitions)

? ? ? ? ? ? ? consumer.seek(partition, getOffsetFromDB(partition)); ? (2)

? ? ? ? ? }

? ? ? }

?}

? consumer.subscribe(topics, new SaveOffsetOnRebalance(consumer));

? consumer.poll(0);

? for (TopicPartition partition: consumer.assignment())

? consumer.seek(partition, getOffsetFromDB(partition)); ? (3)

? while (true) {

? ? ? ConsumerRecords<String, String> records =

? ? ? consumer.poll(100);

? ? ? for (ConsumerRecord<String, String> record : records)

? ? ? {

? ? ? ? ? processRecord(record);

? ? ? ? ? storeRecordInDB(record);

? ? ? ? ? storeOffsetInDB(record.topic(), record.partition(),

? ? ? ? ? record.offset()); ? ? (4)

? ? ? }

? ? ? commitDBTransaction();

? }

(1) 我们在这里使用一个虚构的方法在数据库中提交事务。这里的想法是,当我们处理记录时,数据库记录和偏移量将入到数据库中,我们只需要在即将丢失分区时提交事务,以确保这些信息被持久化。

(2) 我们还有一个假想的方法来从数据库中获取偏移量,然后在获得新分区的所有权时,我们寻找()到这些记录。

(3) 当消费者第一次启动时,在我们订阅主题后,我们调用一次 poll() 以确保我们加入一个消费者组并获得分配的分区,然后我们立即在分配给我们的分区中寻找正确的偏移量。请记住,seek() 只更新我们消费的位置,因此下一个 poll() 将获取正确的消息。如果 seek() 中存在错误(例如,偏移量不存在),则 poll() 将抛出异常。

(4) 另一种假想的方法:这次我们更新一个表,在数据库中存储偏移量。在这里,我们假设更新记录很快,因此我们对每条记录进行更新,但提交速度很慢,因此我们仅在批处理结束时提交。但是,这可以通过不同的方式进行优化。

有许多不同的方法可以通过在外部存储中存储偏移量和数据来实现精确一次语义,但所有这些方法都需要使用 ConsumerRebalance Listener 和 seek() 来确保偏移量及时存储,并且使用者从正确的位置开始读取消息。

4.9 但是我们如何退出

在本章的前面,当我们讨论轮询循环时,我告诉过你不要担心消费者在无限循环中轮询的事实,我们将讨论如何干净地退出循环。因此,让我们讨论一下如何干净利落地退出。

当您决定退出轮询循环时,您将需要另一个线程来调用 consumer.wakeup()。如果在主线程中运行使用者循环,则可以从 ShutdownHook 完成此操作。请注意,consumer.wakeup() 是唯一可以安全地从其他线程调用的使用者方法。调用 wakeup 将导致 poll() 退出并显示 WakeupException,或者如果在线程未等待轮询时调用了 consumer.wakeup(),则在下一次迭代调用 poll() 时将抛出异常。不需要处理 WakeupException,但在退出线程之前,必须调用 consumer.close()。如果需要,关闭使用者将提交偏移量,并将向组协调器发送一条消息,表明使用者将离开组。使用者协调器将立即触发重新平衡,您无需等待会话超时,即可将要关闭的使用者的分区分配给组中的另一个使用者。

下面是使用者在主应用程序线程中运行时退出代码的样子。此示例有点截断,但您可以在 http://bit.ly/2u47e9A 查看完整示例。

?Runtime.getRuntime().addShutdownHook(new Thread() {

? ? ? ? ? ? ?public void run() {

? ? ? ? ? ? ? ? ? ? ?System.out.println("Starting exit...");

? ? ? ? ? ? ? ? ? ? ?consumer.wakeup();

? ? ? ? ? ? ? ? ? ? ?try {

? ? ? ? ? ? ? ? ? ? ? ? ?mainThread.join();

? ? ? ? ? ? ? ? ? ? } catch (InterruptedException e) {

? ? ? ? ? ? ? ? ? ? ? ? ?e.printStackTrace();

? ? ? ? ? ? ? ? ? ? }

? ? ? ? ? ? ? ? }

? ? ? ? });

?...

?try {

? ? ? ? ? // looping until ctrl-c, the shutdown hook will

? ? ? ? ? cleanup on exit

? ? ? ? ? while (true) {

? ? ? ? ? ? ? ? ? ConsumerRecords<String, String> records =

? ? ? ? ? ? ? ? ? movingAvg.consumer.poll(1000);

? ? ? ? ? ? ? ? ? System.out.println(System.currentTimeMillis() + "

? ? ? ? ? ? ? ? ? -- waiting for data...");

? ? ? ? ? ? ? ? ? for (ConsumerRecord<String, String> record :records) {

? ? ? ? ? ? ? ? ? ? ? ? ? System.out.printf("offset = %d, key = %s,

? ? ? ? ? ? ? ? ? ? ? ? ? value = %s\n",

? ? ? ? ? ? ? ? ? ? ? ? ? record.offset(), record.key(),

? ? ? ? ? ? ? ? ? ? ? ? ? record.value());

? ? ? ? ? ? ? ? ? }

? ? ? ? ? ? ? ? ? for (TopicPartition tp: consumer.assignment())

? ? ? ? ? ? ? ? ? ? ? ? ? System.out.println("Committing offset at

? ? ? ? ? ? ? ? ? ? ? ? ? position:" +

? ? ? ? ? ? ? ? ? ? ? ? ? consumer.position(tp));

? ? ? ? ? ? ? ? ? movingAvg.consumer.commitSync();

? ? ? ? ? ? ? }

? ? ? ? ? } catch (WakeupException e) {

? ? ? ? ? // ignore for shutdown

? ? ? ? ? } finally {

? ? ? ? ? ? ? ? ? consumer.close();

? ? ? ? ? ? ? ? ? System.out.println("Closed consumer and we are done");

? ? ? ? ? }

? }

(1) ShutdownHook 在单独的线程中运行,因此我们可以采取的唯一安全操作是调用唤醒以打破轮询循环。

(2) 另一个调用唤醒的线程将导致轮询引发 WakeupException。您需要捕获异常以确保应用程序不会意外退出,但无需对其进行任何操作。

(3) 在退出使用器之前,请确保将其干净地关闭

4.10 解串器

如上一章所述,Kafka 生产者要求序列化程序将对象转换为字节数组,然后将其发送到 Kafka。同样,Kafka 使用者需要反序列化程序将从 Kafka 接收的字节数组转换为 Java 对象。在前面的示例中,我们只是假设每条消息的键和值都是字符串,我们在使用者配置中使用了默认的 StringDeserializer。

在关于 Kafka 生产者的第 3 章中,我们了解了如何序列化自定义类型,以及如何使用 Avro 和 AvroSerializers 从架构定义生成 Avro 对象,然后在向 Kafka 生成消息时序列化它们。现在,我们将了解如何为自己的对象创建自定义反序列化程序,以及如何使用 Avro 及其反序列化程序。

很明显,用于向 Kafka 生成事件的序列化程序必须与使用事件时将使用的反序列化程序匹配。使用 IntSerializer 进行序列化,然后使用 StringDeserializer 进行反序列化不会有好结果。这意味着,作为开发人员,您需要跟踪用于写入的序列化程序每个主题,并确保每个主题仅包含您使用的反序列化程序可以解释的数据。这是使用 Avro 和架构存储库进行序列化和反序列化的好处之一 - AvroSerializer 可以确保写入特定主题的所有数据都与主题的架构兼容,这意味着可以使用匹配的反序列化程序和架构对其进行反序列化。在生产者或使用者端,兼容性方面的任何错误都可以通过适当的错误消息轻松捕获,这意味着您无需尝试调试字节数组的序列化错误。

我们将首先快速演示如何编写自定义反序列化程序,尽管这是不太常见的方法,然后我们将继续介绍如何使用 Avro 反序列化消息键和值的示例。

-

自定义解串器

让我们采用我们在第 3 章中序列化的相同自定义对象,并为它编写一个反序列化程序:

?public class Customer { ? ? ? ? ? private int customerID; ? ? ? ? ? private String customerName; ? ? ? ? ? public Customer(int ID, String name) { ? ? ? ? ? ? ? ? ? this.customerID = ID; ? ? ? ? ? ? ? ? ? this.customerName = name; ? } ? ? ? public int getID() { ? ? ? return customerID; ? ? ? } ? ? ? public String getName() { ? ? ? return customerName; ? ? ? } ?}自定义反序列化程序将如下所示:

?import org.apache.kafka.common.errors.SerializationException; ?import java.nio.ByteBuffer; ?import java.util.Map; ?public class CustomerDeserializer implements ? Deserializer<Customer> { ? @Override ? ? ? public void configure(Map configs, boolean isKey) { ? ? ? // nothing to configure ? ? ? } ? ? ? @Override ? ? ? public Customer deserialize(String topic, byte[] data) { ? ? ? ? ? ? ? int id; ? ? ? ? ? ? ? int nameSize; ? ? ? ? ? ? ? String name; ? ? ? ? ? ? ? try { ? ? ? ? ? ? ? ? ? ? ? if (data == null) ? ? ? ? ? ? ? ? ? ? ? return null; ? ? ? ? ? ? ? ? ? ? ? if (data.length < 8) ? ? ? ? ? ? ? ? ? ? ? throw new SerializationException("Size of data received by IntegerDeserializer is shorter than expected"); ? ? ? ? ? ? ? ? ? ? ? ByteBuffer buffer = ByteBuffer.wrap(data); ? ? ? ? ? ? ? ? ? ? ?id = buffer.getInt(); ? ? ? ? ? ? ? ? ? ? ? String nameSize = buffer.getInt(); ? ? ? ? ? ? ? ? ? ? ? byte[] nameBytes = new Array[Byte](nameSize); ? ? ? ? ? ? ? ? ? ? ? buffer.get(nameBytes); ? ? ? ? ? ? ? ? ? ? ? name = new String(nameBytes, 'UTF-8'); ? ? ? ? ? ? ? ? ? ? ? return new Customer(id, name); ? ? ? ? ? ? ? } catch (Exception e) { ? ? ? ? ? ? ? ? ? ? ? throw new SerializationException("Error when serializing Customer to byte[] " + e); ? ? ? ? } ? ? ? } ? @Override ? public void close() { ? // nothing to close ? } ?}(1) 使用者还需要实现 Customer 类,并且该类和序列化程序都需要在生产和使用应用程序上匹配。在具有许多使用者和生产者共享数据访问权限的大型组织中,这可能变得具有挑战性。

(2) 我们只是在这里颠倒了序列化程序的逻辑 - 我们从字节数组中获取客户 ID 和名称,并使用它们来构造我们需要的对象。

使用此序列化程序的使用者代码将类似于以下示例: