人工智能发展简史第四章:平稳发展期-20世纪90年代

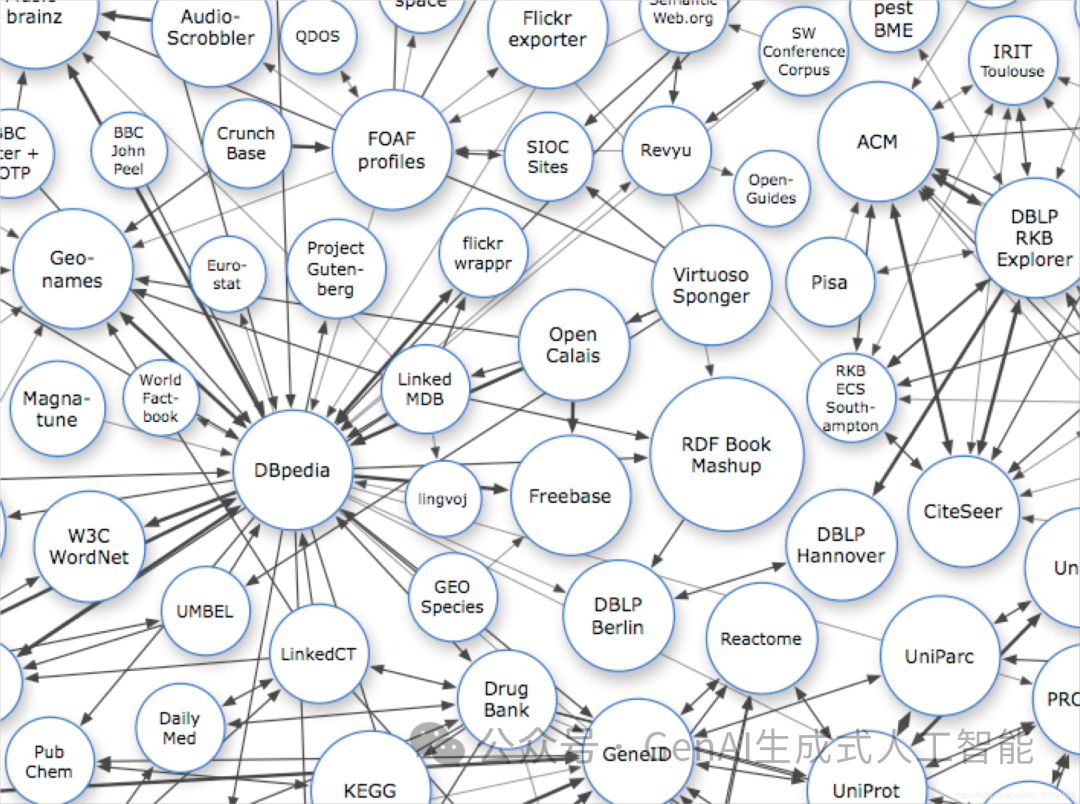

20世纪90年代,AI 出现了两个很重要的发展:一方面是蒂姆·伯纳斯·李(Tim Berners-Lee)在1998年提出的语义网,即以语义为基础的知识网或知识表示。后来又出现了 OWL 语言和其他一些相关知识描述语言,这为知识库的两个核心问题:知识表达和开放知识实体,给出了一个可能的解决方案(尽管这一思路在后来一直没有得到广泛认可,直到2012年谷歌提出知识图谱的概念,才让这一方向有了明确的发展思路)。

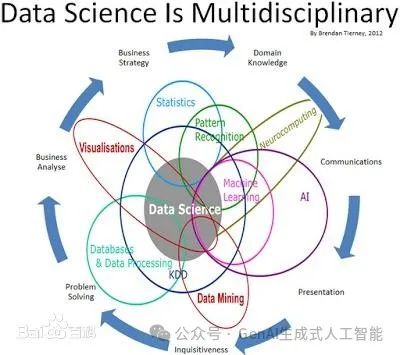

另一个重要的发展是统计机器学习理论,包括Vapnik Vladimir等人提出的支持向量机、John Lafferty等人的条件随机场以及David Blei和Michael Jordan等人的话题模型LDA。总的来讲这一时期的主旋律是AI平稳发展,人工智能相关的各个领域都取得长足进步。

4.1支持向量机(Support Vector Machine)

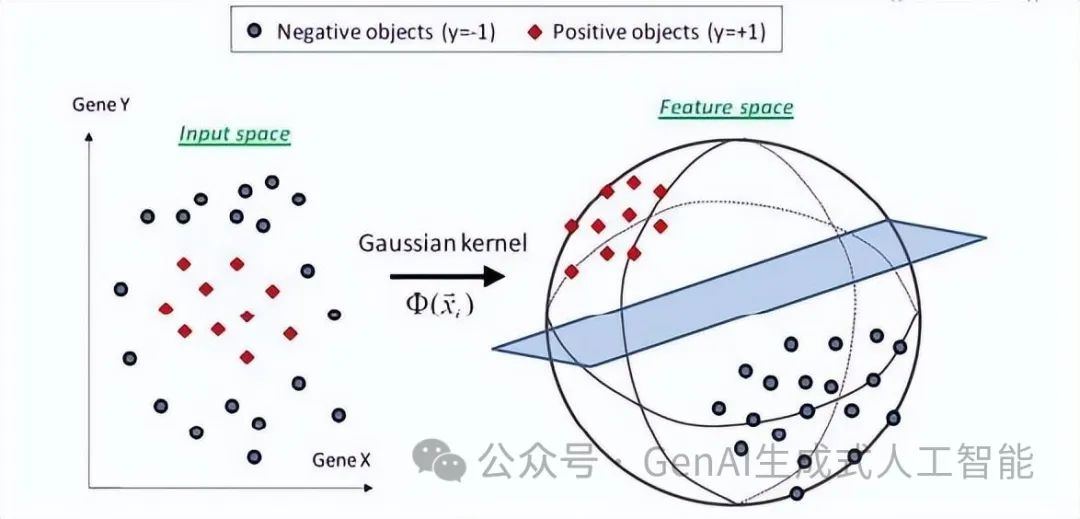

1995年,Cortes和Vapnik首次提出支持向量机(Support Vector Machine)的概念,它在解决小样本、非线性及高维模式识别中表现出许多特有的优势,并能够推广应用到函数拟合等其他机器学习问题中。

支持向量机(Support Vector Machine, SVM)是一类按监督学习(supervised learning)方式对数据进行二元分类的广义线性分类器(generalized linear classifier),其决策边界是对学习样本求解的最大边距超平面(maximum-margin hyperplane)。

同时,支持向量机方法是建立在统计学习理论的VC 维理论和结构风险最小原理基础上的,根据有限的样本信息在模型的复杂性(即对特定训练样本的学习精度,Accuracy)和学习能力(即无错误地识别任意样本的能力)之间寻求最佳折衷,以期获得最好的推广能力(或称泛化能力)。

4.2条件随机场(Conditional Random Fields)

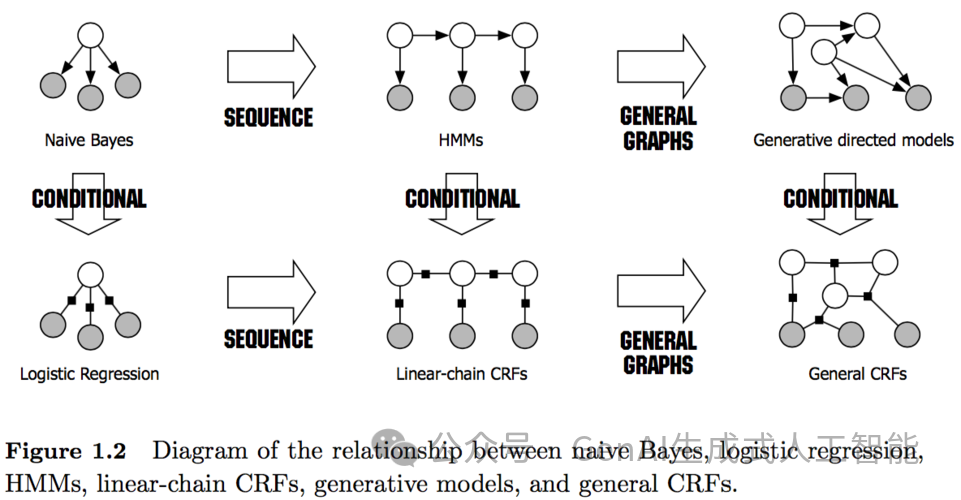

John Lafferty于2001年首次提出条件随机场模型,它是基于贝叶斯理论框架的判别式概率图模型,当时用于文本的分割和标注,同时在许多自然语言处理任务中比如分词、命名实体识别等表现尤为出色。CRF最早是针对序列数据分析提出的,现已成功应用于自然语言处理(NLP)、生物信息学、机器视觉及网络智能等领域。

简单地讲,随机场可以看成是一组随机变量的集合(这组随机变量对应同一个样本空间)。当给每一个位置按照某种分布随机赋予一个值之后,其全体就叫做随机场。当然,这些随机变量之间可能有依赖关系,一般来说,也只有当这些变量之间有依赖关系的时候,我们将其单独拿出来看成一个随机场才有实际意义。

设X与Y是随机变量,P(Y|X)是在给定X的条件下Y的条件概率分布,若随机变量Y构成一个由无向图G=(V,E)表示的马尔科夫随机场,即:对任意的结点v成立,则称条件概率分布P(Y|X)为条件随机场。

这个概念看起来挺抽象的涉及到了很多其他的概念,此时如果你回去再看一遍开头我们的定义部分,就会明白许多,所谓的条件随机场不过是一组随机变量X,Y形成的条件概率的集合,但是这个条件概率满足了马尔科夫独立性假设/概率无向图模型的条件,所以我们称之为条件随机场!上述定义的解释也很直观,那就是:所有不跟我直接相连的变量都跟我没关系!

4.3“深蓝”击败卡斯帕罗夫(Deep Blue Beats Kasparov)

1997年5月11日,举世瞩目的人与计算机大战在经过6场拼杀后终见伯仲。尽管人脑战胜电脑为民意所归——据美国有限电视网与《今日美国》日报的民意调查,82%的人希望人脑取胜;尽管棋王坚信世界上最好的棋手可以利用创造力和想象力战胜硅片——他认为:“在严肃而标准的国际象棋中,计算机在本世纪是不会得手的。”但事实胜于雄辩,IBM"深蓝"(Deep Blue)最终以3.5:2.5战胜了国际象棋大师卡斯帕罗夫(Kasparov),并成为纽约国际象棋人机赛110万美元奖金的最终赢家,同时成为首台打败了国际象棋世界冠军的电脑。其实正如IBM公司所说,无论鹿死谁手,人类都是最后赢家。

随后数年,人们对待机器的态度渐渐恢复理性。个人计算机的功能大幅增强,智能手机如今可以同时运行和深蓝一样强大的象棋引擎与其他应用。更重要的是,得益于人工智能的最新进展,机器现在可以自己学习和探索游戏。

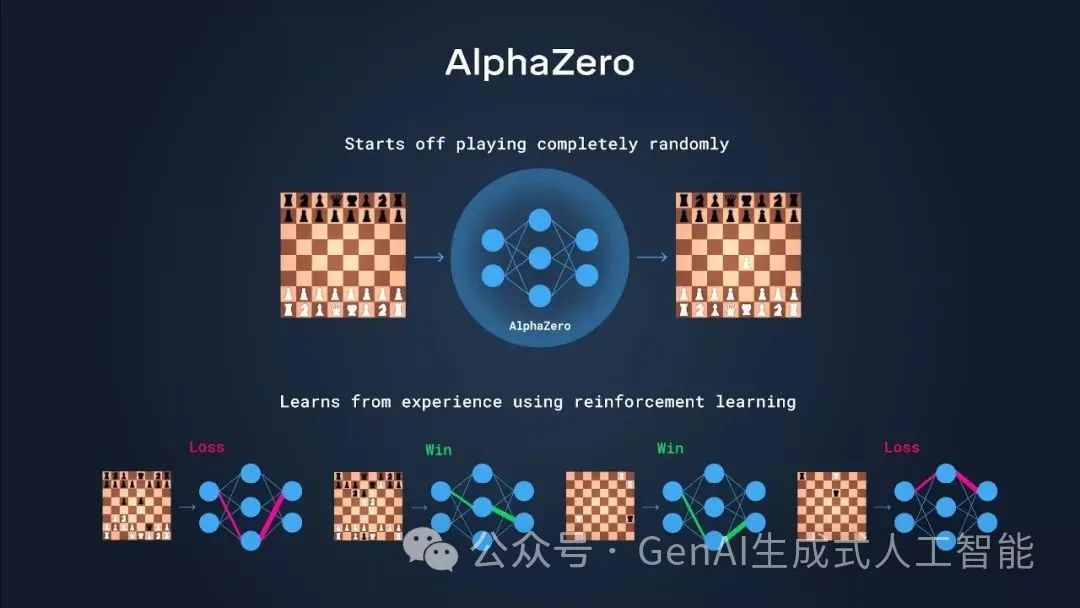

深蓝的背后仍旧是人类为国际象棋对弈而设计的代码规则。相比之下,Alphabet子公司DeepMind在2017年推出的程序AlphaZero,通过反复练习,可以自学成为大师级选手。甚至,AlphaZero还挖掘出一些新的策略,这些策略让国际象棋专家都自叹不如。

4.4语义网路径图(Semantic Web Road Map)

语义网(Semantic Web)是由万维网联盟的蒂姆·伯纳斯·李(Tim Berners-Lee)在1998年提出的的一个概念,它的核心是:通过给万维网上的文档(如HTML)添加能够被计算机所理解的语义(Meta data),从而使整个互联网成为一个通用的信息交换媒介),其最基本的元素就是语义链接(linked node)。

语义网是一个更官方的名称,也是该领域学者使用得最多的一个术语,同时,也用于指代其相关的技术标准。在万维网诞生之初,网络上的内容只是人类可读,而计算机无法理解和处理。比如,我们浏览一个网页,我们能够轻松理解网页上面的内容,而计算机只知道这是一个网页。网页里面有图片,有链接,但是计算机并不知道图片是关于什么的,也不清楚链接指向的页面和当前页面有何关系。语义网正是为了使得网络上的数据变得机器可读而提出的一个通用框架。“Semantic”就是用更丰富的方式来表达数据背后的含义,让机器能够理解数据。“Web”则是希望这些数据相互链接,组成一个庞大的信息网络,正如互联网中相互链接的网页,只不过基本单位变为粒度更小的数据。

4.5主题建模(Topic Modeling)

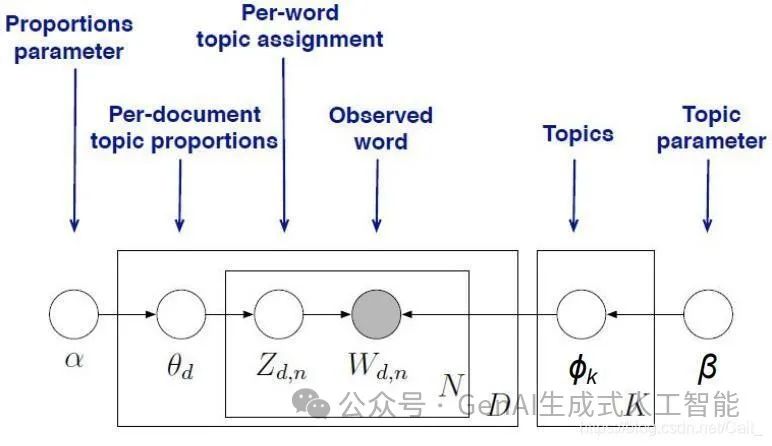

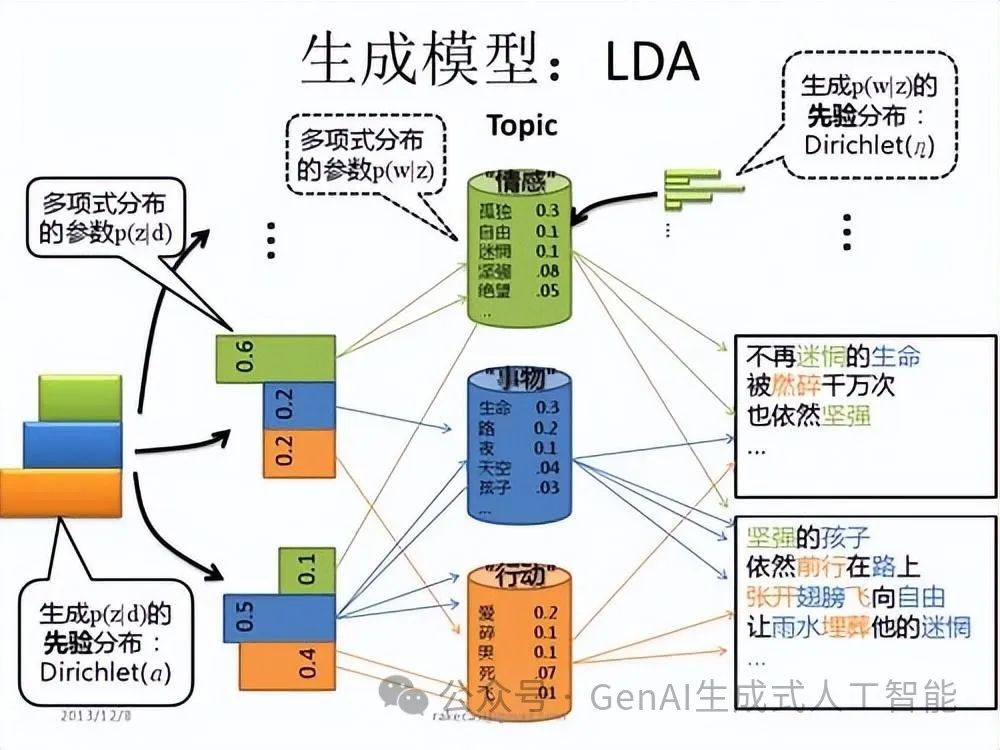

在机器学习领域,LDA是两个常用模型的简称:Linear Discriminant Analysis 和 Latent Dirichlet Allocation。本文的LDA仅指代Latent Dirichlet Allocation. LDA 在主题模型中占有非常重要的地位,常用来文本分类。

LDA由Blei、 David M.、Ng, Andrew Y.、Jordan于2003年提出,用来推测文档的主题分布。它可以将文档集中每篇文档的主题以概率分布的形式给出,从而通过分析一些文档抽取出它们的主题分布后,便可以根据主题分布进行主题聚类或文本分类。

LDA是一种非监督机器学习技术,可以用来识别大规模文档集(document collection)或语料库(corpus)中潜藏的主题信息。它采用了词袋(bag of words)的方法,这种方法将每一篇文档视为一个词频向量,从而将文本信息转化为了易于建模的数字信息。但是词袋方法没有考虑词与词之间的顺序,这简化了问题的复杂性,同时也为模型的改进提供了契机。每一篇文档代表了一些主题所构成的一个概率分布,而每一个主题又代表了很多单词所构成的一个概率分布。

2023年Openai的ChatGPT 4.0火爆出圈,这么好的东西却不对中国用户(包括港澳台)开放。我们希望通过自己的内容、技术和服务,些许的抹平差异,让中国用户,也能更方便、更便宜的了解和使用到全球最强大的对话式AI大模型。我们可以帮你订阅ChatGPT Plus,支付方式稳定、安全。所有ChatGPT账号,一人一号独享。详情请扫码了解

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 【Leetcode】计算器

- 力扣labuladong一刷day53天LFU 算法

- 197.【2023年华为OD机试真题(C卷)】执行时长(模拟题-Java&Python&C++&JS实现)

- 2024年第二届“华数杯”国际大学生数学建模竞赛 (A题 MCM)| 废水扩散分析 |数学建模完整代码+建模过程全解全析

- 全新SharePoint Premium介绍

- “华为杯”研究生数学建模竞赛2016年-【华为杯】C题:基于无线通信基站的预估-校正-自适应定位模型

- 查看centos版本

- 淘宝/天猫获取商品销量详情 API

- 轻松设置CentOS IP地址的最终指南:详细的分步说明

- 在java java.util.Date 已知逝去时间怎么求年月日