通义千问开源大模型部署教程-小白也能懂

发布时间:2024年01月12日

1、基础环境

? ? ? ? 1.1 python3安装

? ? ? ? ? ?准备好:python 3.10 (不要用3.8 ,有bug)? ? ? ? ? ?https://www.python.org/ftp/python/3.10.9/python-3.10.9-amd64.exe

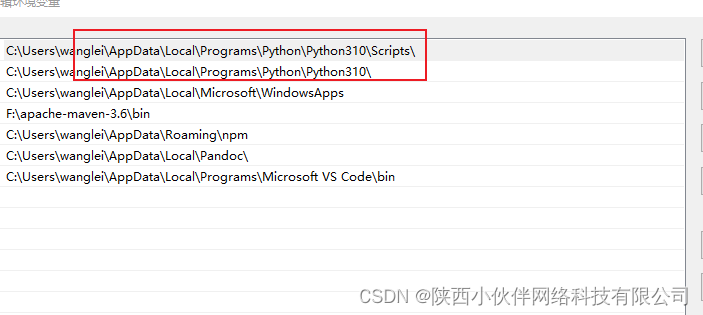

? ? ? ? ? ?安装完了之后,观察是否添加到path环境变量里了,如果安装的时候忘记勾选自动添加到环境变量,就自己加到path里。

? ? ? ? ? ??? ?

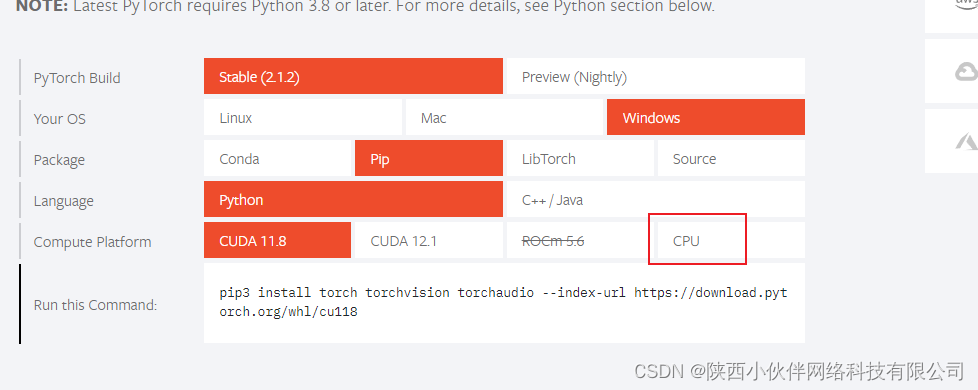

??1.2 pytorch?安装

? ? ? ?pytorch? 安装需要根据自己是否有显卡选择不同的命令安装,官网通过选择你的模式后,会自动生成命令,传送门:PyTorch

? ? ??

? ? 如果cpu玩的话,记得选择CPU,安装命令是不同的,执行安装命令就完了。

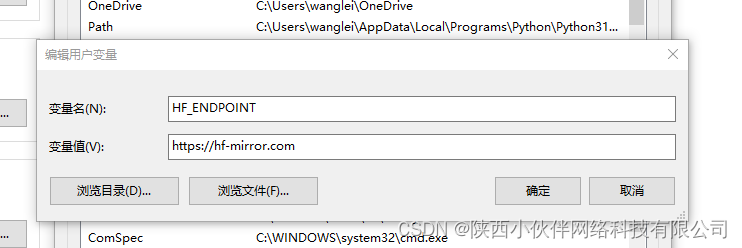

? 1.3 配置镜像

? ? 配置这个镜像:hf-mirror.com - Huggingface 镜像站??

? ? ?

pip install -U huggingface_hub? 然后配置环境变量,HF_ENDPOINT=https://hf-mirror.com

?

?1.4 安装transformers 32版本

? ? ?

pip install transformers==4.32.01.5 安装CUDA 11.4?

? ?我的显卡还没回来,等我回来了我补充这里。

2、通义千问部署

? ? ? ?git clone?https://github.com/QwenLM/Qwen

? ? ? 然后执行安装依赖的命令,

pip install -r requirements.txt? ? ? 上面的命令不会安装web页面所需要的依赖,如果需要web ui玩还需要执行下面这个

pip install -r requirements_web_demo.txt? ? ?最后运行

?

python cli_demo.py

//或者

python web_demo.py

? 如果是CPU跑模型,7B的肯定不行,要用1.8B的 需要修改模型名称

??

Qwen/Qwen-1_8B-Chat? 改成这个,不是Qwen/Qwen-1.8B-Chat哦,会提示找不到模型的。

?运行的时候多给个参数即可,web页面或者命令行都支持这个参数。

python cli_demo.py --cpu-only

文章来源:https://blog.csdn.net/shuaizai88/article/details/135548437

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- leetcode2809.使数组和小于等于x的最小时间

- 组件之间传值(vue的问题)

- 企业云安全能力建设的要点

- uni-app实现一键登录(企业版:因为获取手机号功能**目前针对非个人开发者**,所以个人开发者无法唤起获取手机号界面)

- 跟着pink老师前端入门教程-day09

- Flume实时读取本地/目录文件到HDFS

- 使用Locust进行接口性能测试:安装、命令参数解析与示例解读

- kafka之集群工作机制理解

- SQL连续

- python图片转灰度报错cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)