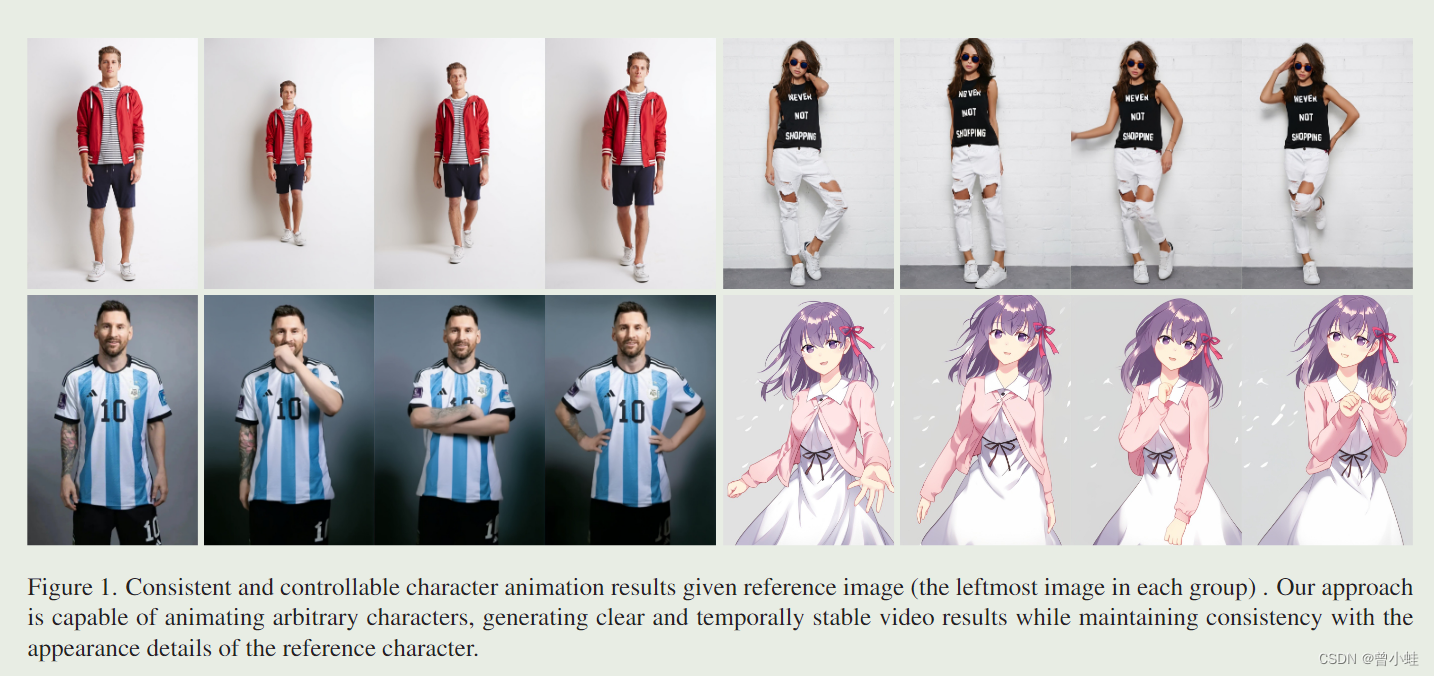

【论文+App试玩+图像到视频】2311.Animate-anyone:上传1张图片为任何人制作动画(用于角色动画的一致且可控的图像到视频合成)(暂未开源)

项目主页:https://humanaigc.github.io/animate-anyone/

论文: Animate Anyone: Consistent and Controllable Image-to-Video Synthesis for Character Animation

摩尔线程复现代码:https://github.com/MooreThreads/Moore-AnimateAnyone

原作者讲解(需要手机端看): https://mp.weixin.qq.com/s/bSV-dxA618LvN76tg4Z0kQ

其他教程视频: 用Comfy UI + Animate Anyone来一键制作抖音视频

demo:在通义前问app上可以试用 (可生成12秒)

文章目录

简介

角色动画(Character Animation)是指在通过驱动信号从静止图像中生成角色视频。

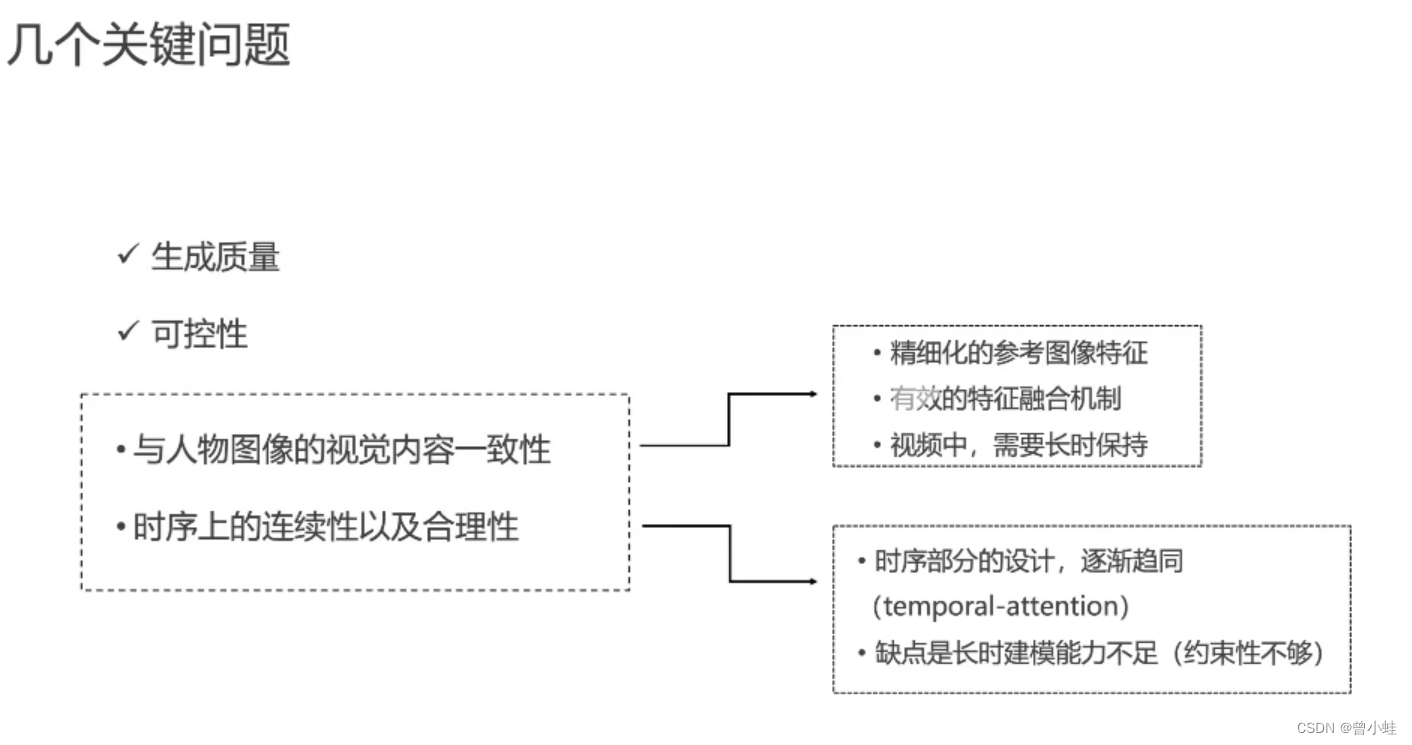

图片到视频的难点在于:保持角色详细信息的一致性(consistency)

实测: 鸣人跳兔子舞

相关研究

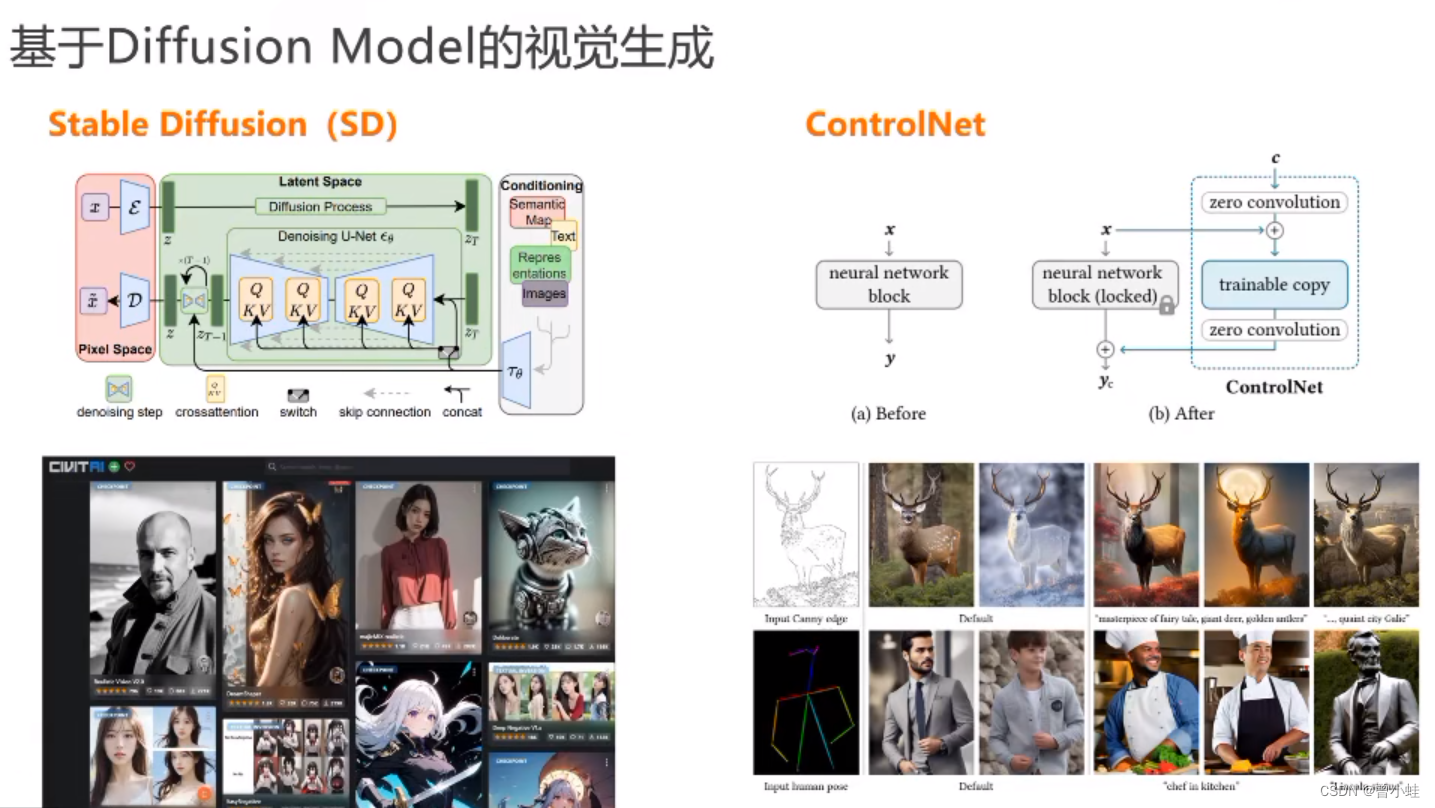

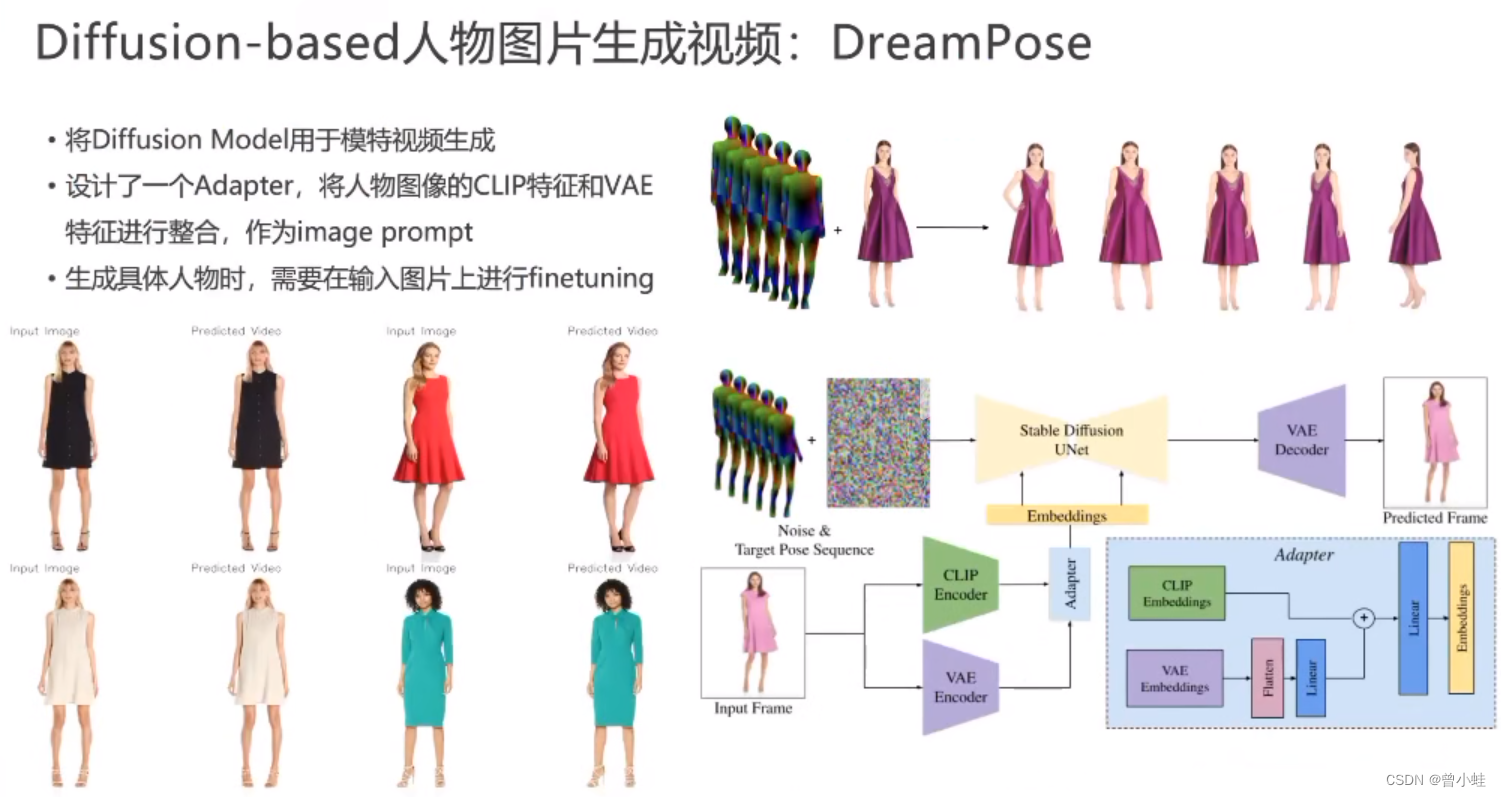

- DreamPose 专注于时尚图像到视频的合成,并提出了一个适应模块来融合图像中的CLIP和VAE特征。但是缺点是需要

微调模型来保持生成图片的一致性。 - DisCo : 探索人类的舞蹈生成,通过CLIP整合角色的特征(integrating character features),并通过ControlNet结合·背景特征·。然而,它在保留角色的细节方面存在缺陷,并且存在

帧间抖动问题。 AnimateDiff: Animate Your Personalized Text-to-Image Diffusion Models without Specific Tuning

能根据给的静态图片生成图片,未能从图像中捕获复杂的细节,提供更多的多样性,但缺乏精度,特别是在应用于角色动画时,导致角色外观的细粒度细节的时间变化ControlNet:Adding Conditional Control to Text-to-Image Diffusion Models 和T2I-Adapter

通过在stable diffusion上添加额外的编码层来生成视觉的可控性。促进各种条件下的受控生成,如姿势、蒙版、边缘和深度IP-Adapter: Text Compatible Image Prompt Adapter for Text-to-Image Diffusion Models

使扩散模型能够保持给定图像的特点,生成提示指定的内容的图像。TryOnDiffusion: A Tale of Two UNets

将扩散模型应用于虚拟服装试穿任务,并引入并行unet结构。

.

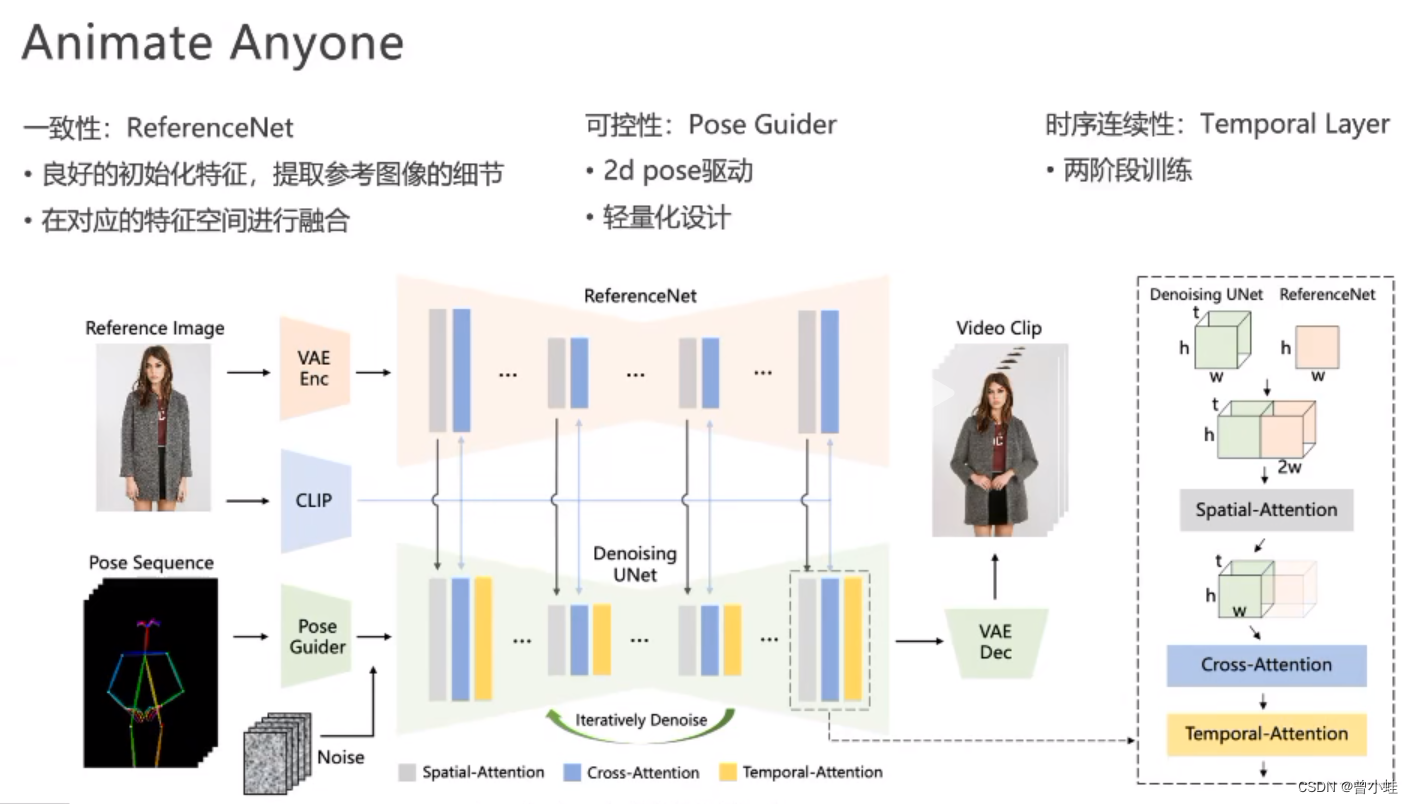

方法

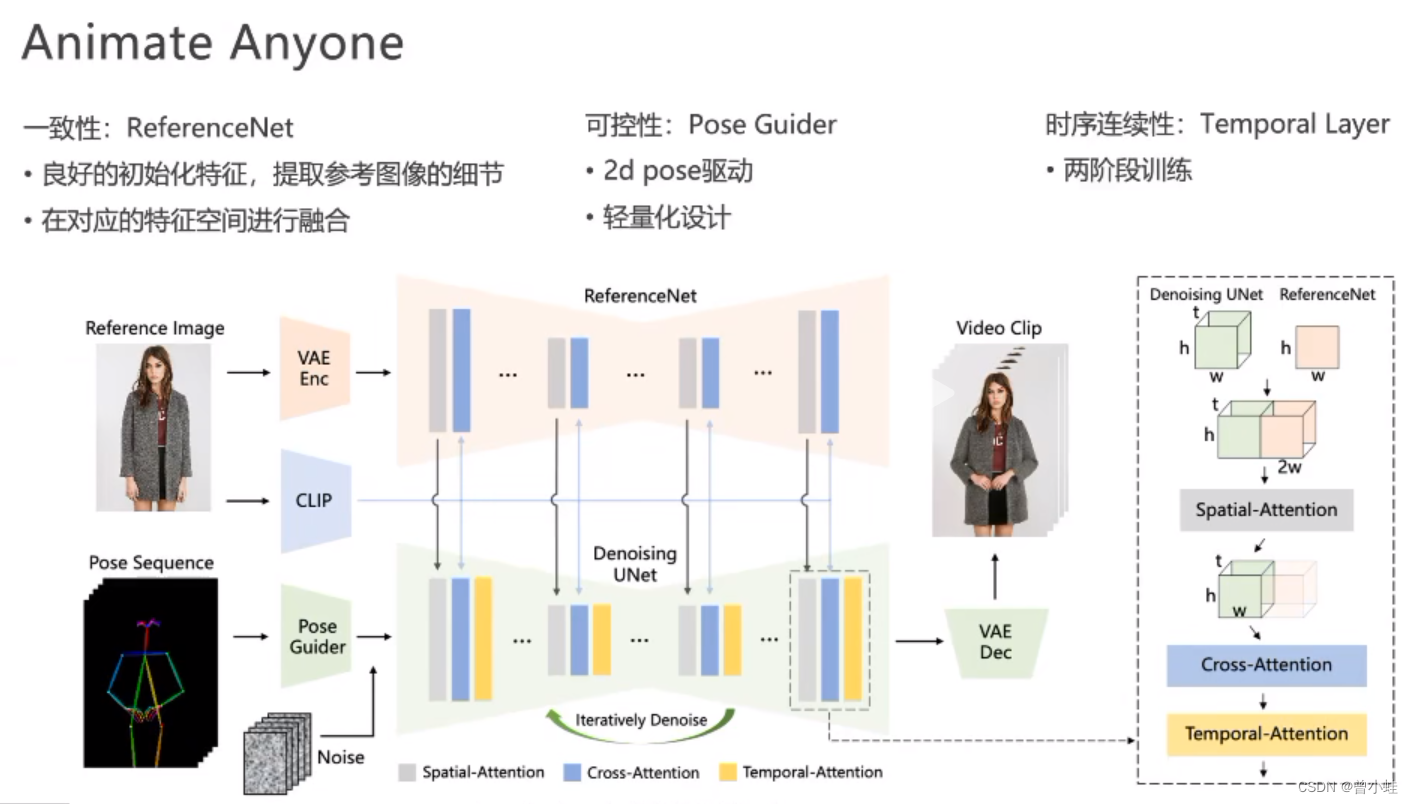

- 为了解决复杂的(intricate)外观特征的

一致性(appearance features),设计了ReferenceNet,并通过空间注意力模块(spatial attention)合并细节特征。

2.为了确保视频可控性和连续性(controllability and continuity),设计了姿态引导模块(pose guider)来指导角色的运动. - 为了确保视频帧之间的

平滑帧间转换(smooth inter-frame transitions),采用一种有效的时间建模(temporal modeling)方法

姿态序列(pose sequence)最初使用Pose Guider进行编码,并与多帧噪声融合,然后进行去噪UNet进行视频生成去噪过程。去噪UNet的计算块由空间注意、交叉注意和时间注意组成,如右边的虚线框所示。参考图像的集成涉及两个方面。首先,通过 ReferenceNet 提取详细的特征并用于 Spatial-Attention。其次,通过CLIP图像编码器提取语义特征进行交叉注意。时间注意在时间维度上运行。最后,VAE 解码器将结果解码为视频剪辑。

原作者胡立讲解

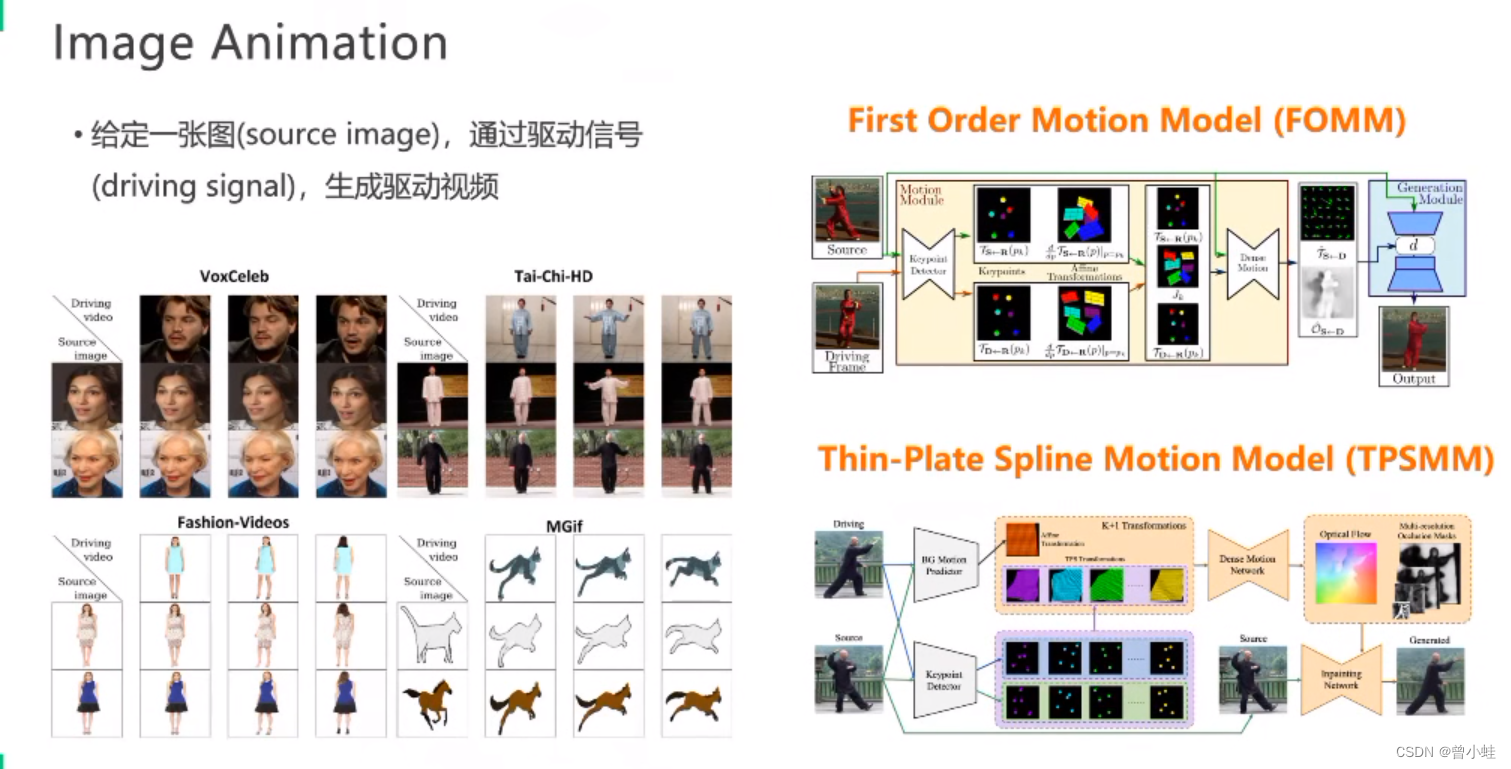

Image Animation

分析关键点、对运动过程建模、驱动

2019 FOMM

2022 TPSMM

基于diffusion的图片生成模型0

代表工作为 stable diffusion +ControlNet (可控)

基于diffusion的视频生成

(DreamPose )

输入tuning

主要还是模特、连续性不好

23.07 DicCo(跳舞)

驱动跳舞、视频不连续, 一致性不好

图像生成一致性改进:TryonDiffusion

生成的效果特别好

有效的图片特征

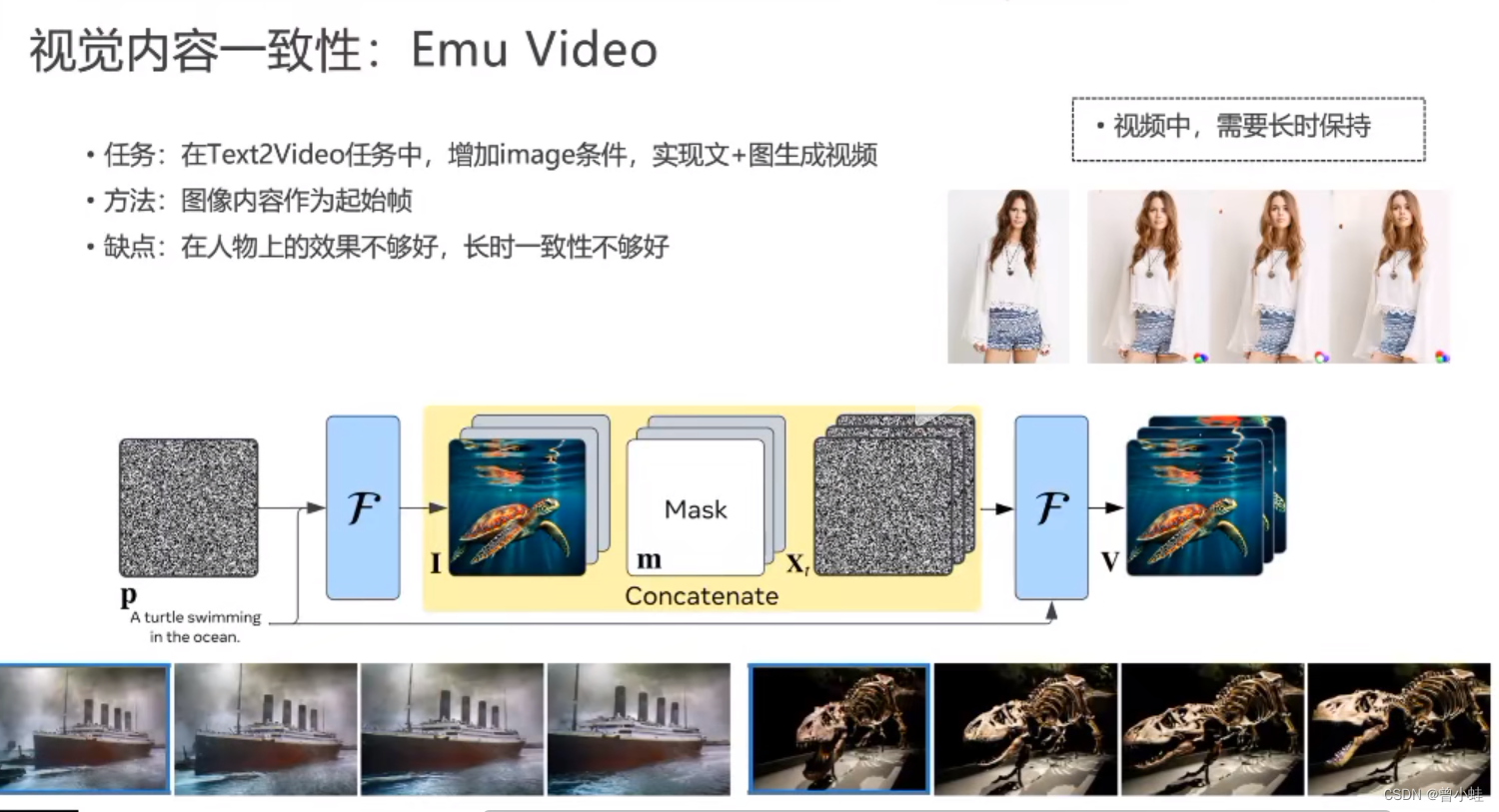

视觉内容一致性: Emu Video

人物效果一般,长时一致性不厚好

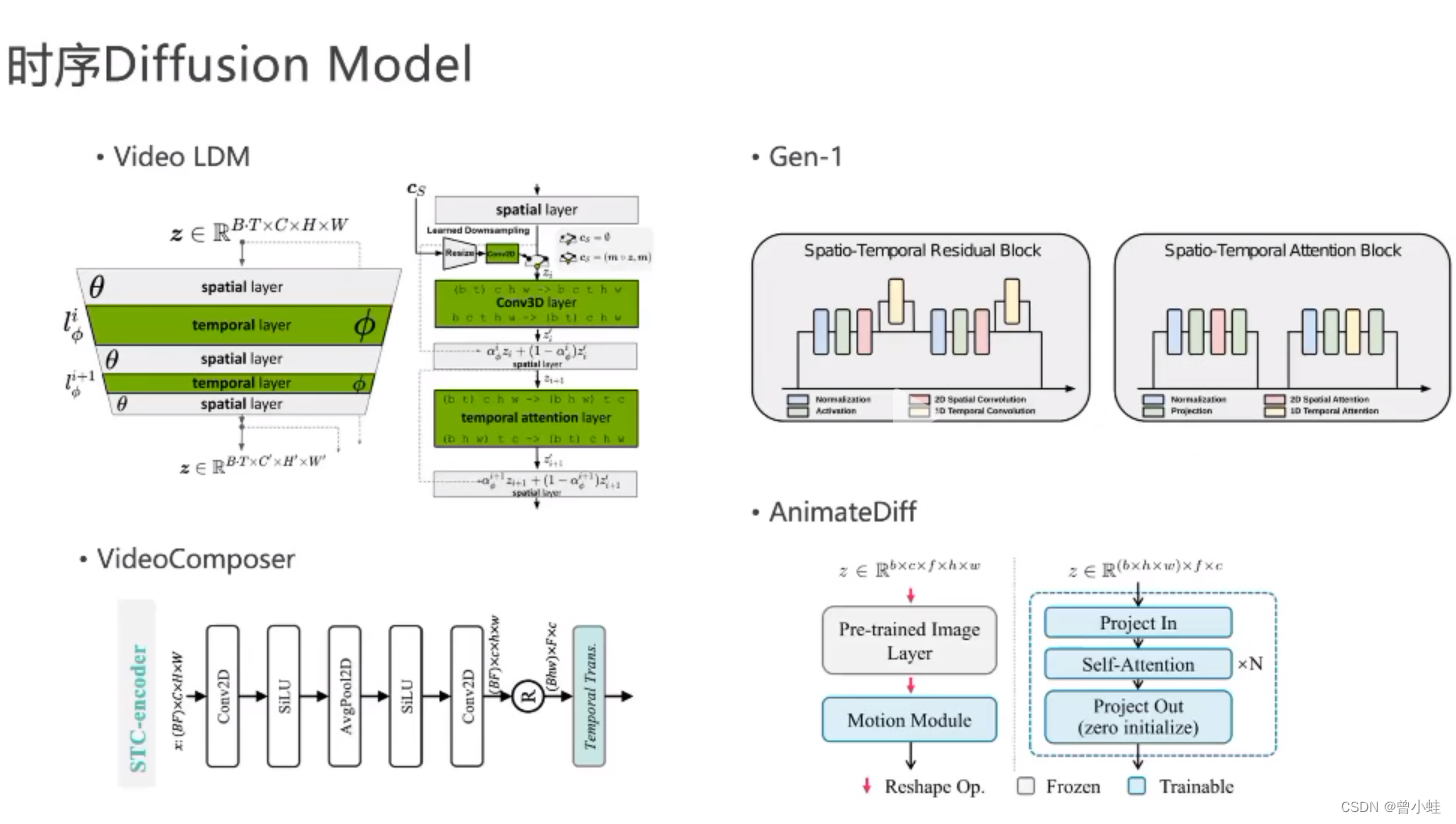

*时序的diffusion model (逐渐成熟)

video LDM

Gen-1

videoComposer

AnimateDiff

对上面方法总结

diffusion模型的生成与可控能力,但是之前的方法效果不稳定

Animate Anyone 算法原理

ReferenceNet 、PoseGuider 、Temporal Layer

输入:任务参考图片、驱动任务pose序列

denosing unet 就是stable diffusion的扩展

CLIP 提取图片语意特征、ReferenceNet 提取的是图像细节

问题:看不见地方,手部的精细度

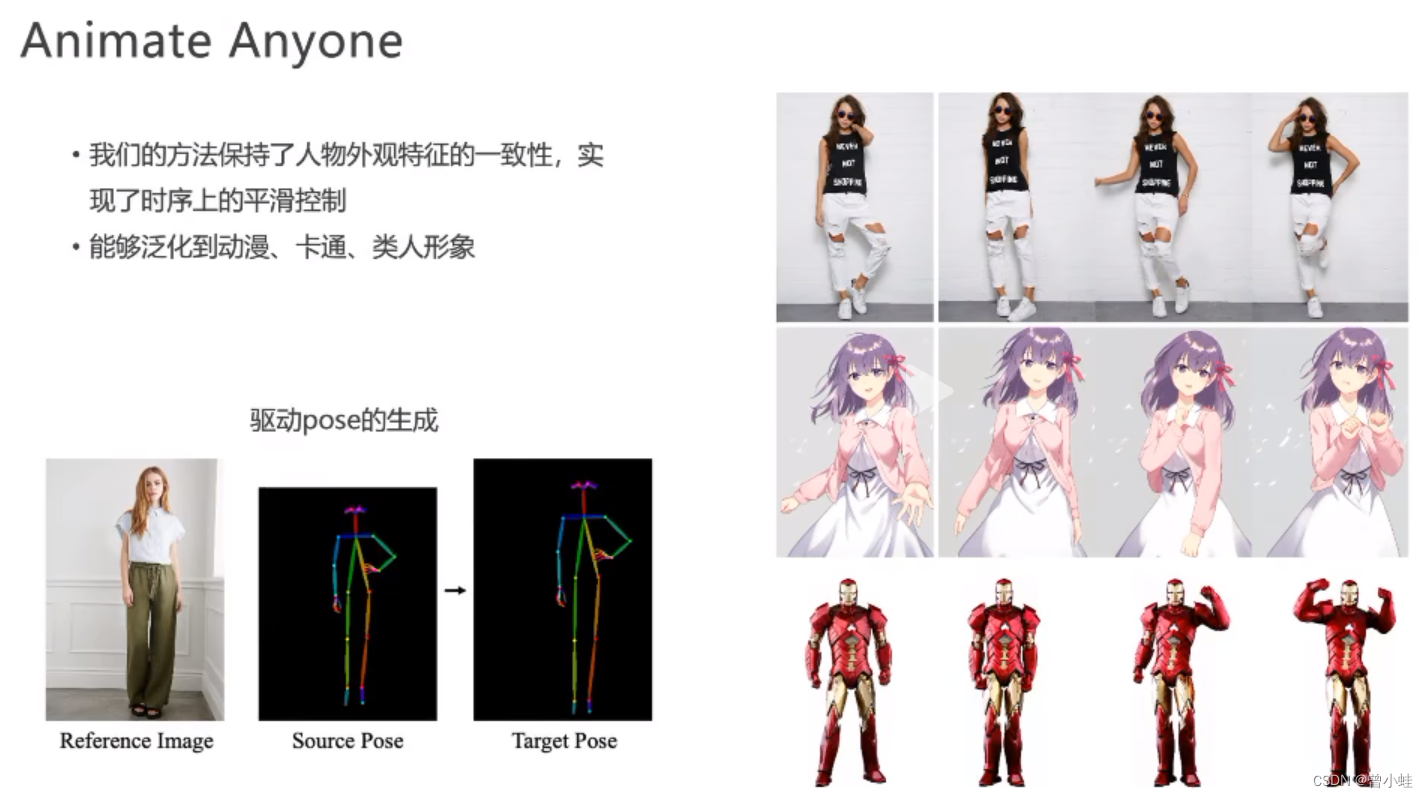

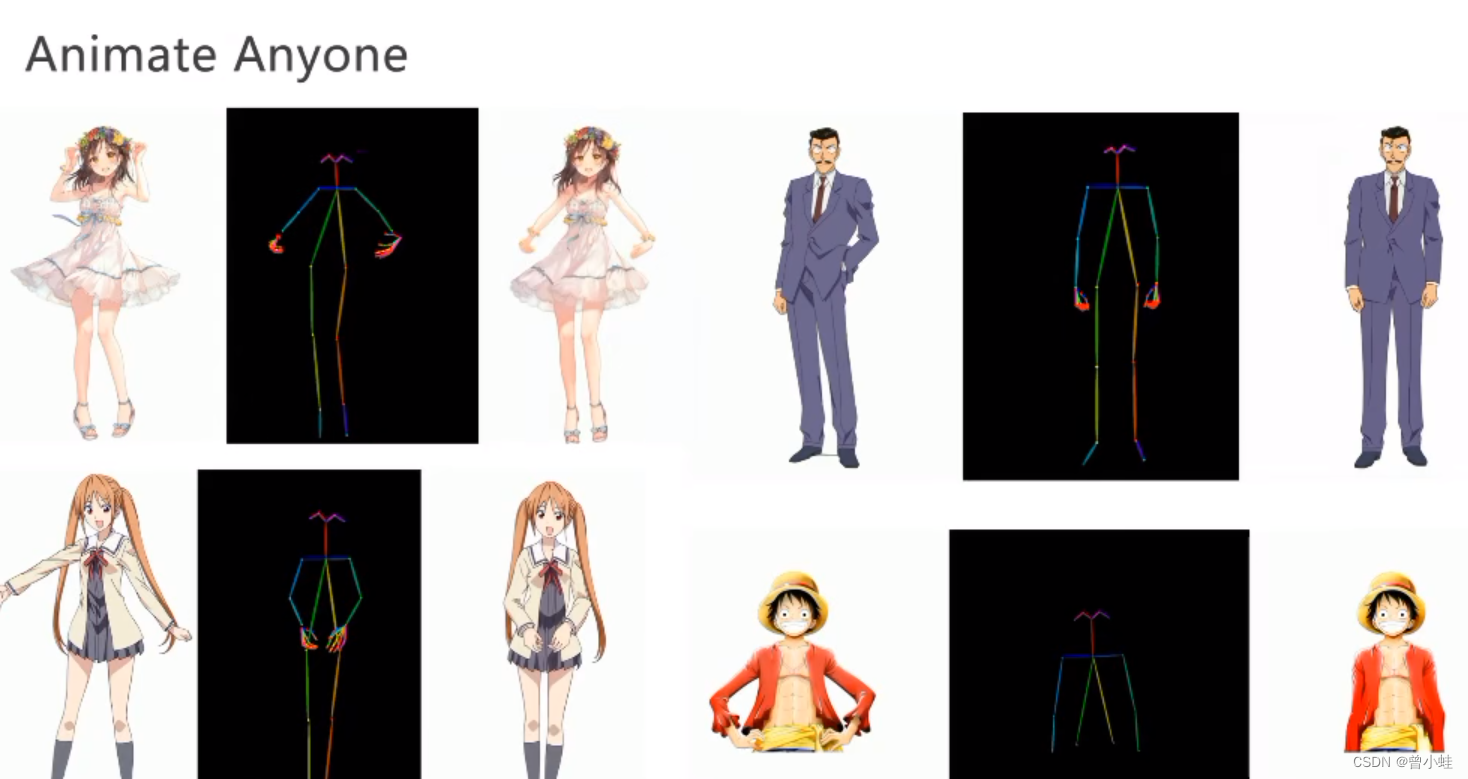

效果

驱动2次元受到用户欢迎

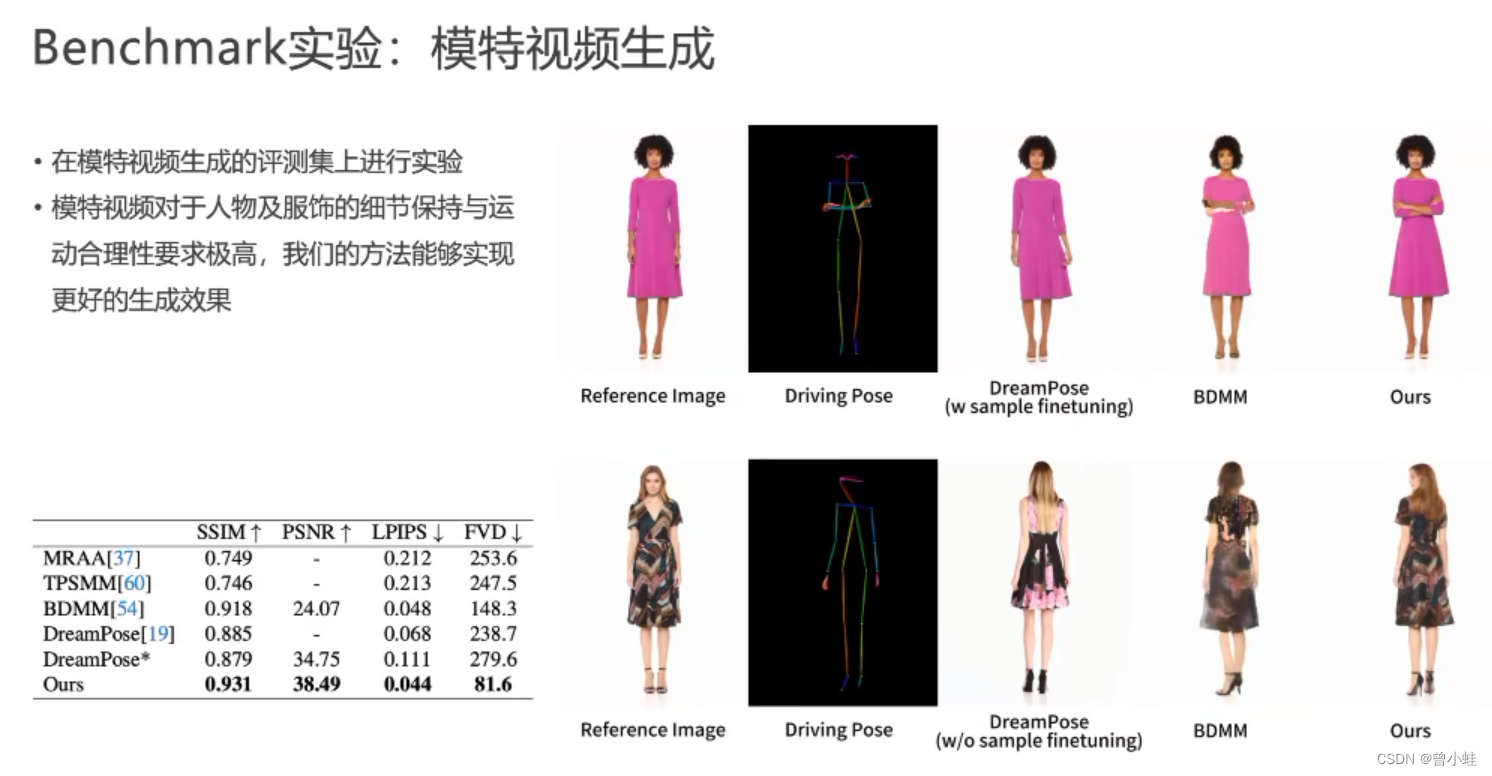

在量化的模特视频上

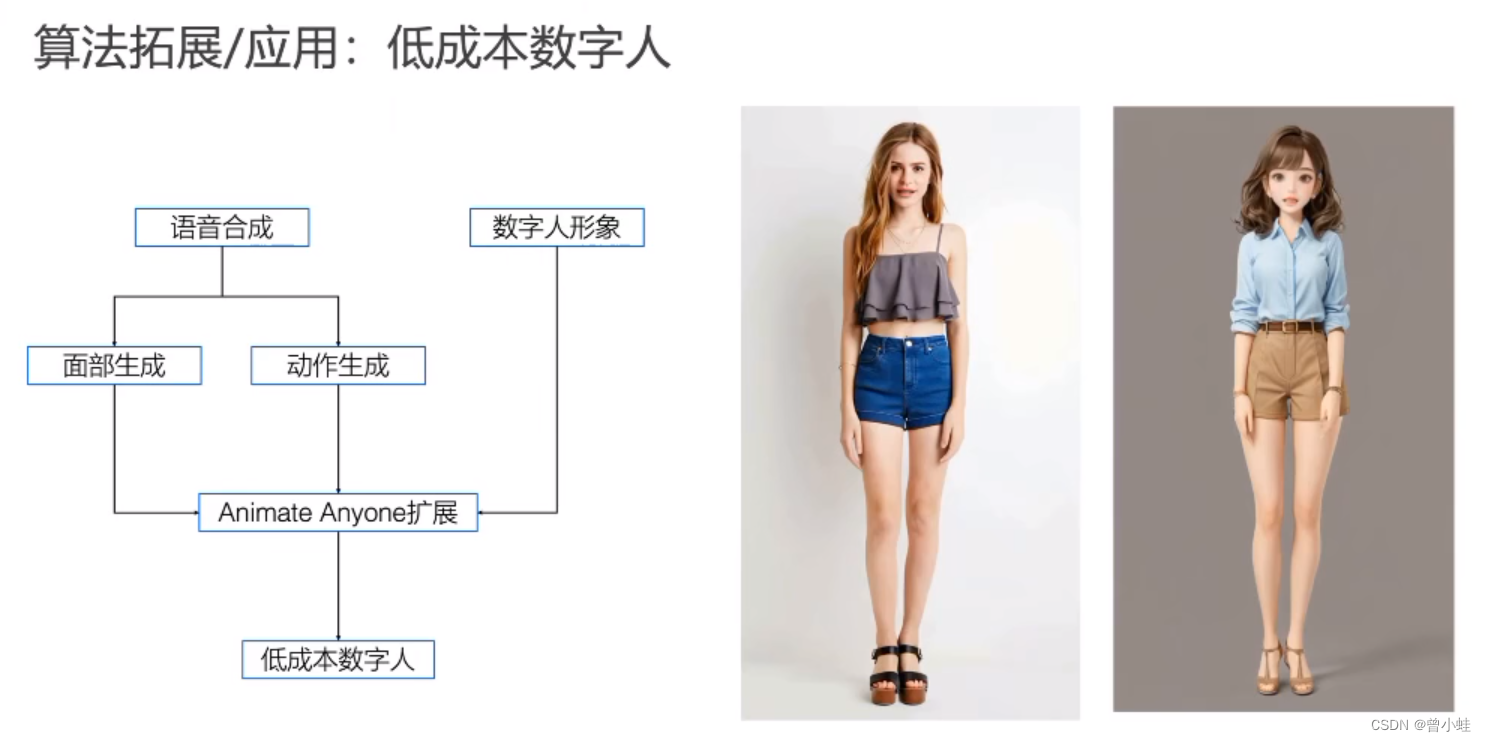

应用案例

结合换衣(outfit-anything),角色皮肤设计

试穿+电商

数字人相关

团队建设

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!