李宏毅LLM——ChatGPT原理剖析

发布时间:2024年01月16日

ChatGPT原理剖析

Chat-GPT引言

- 直观感受:结果有模有样、每次输出结果都不同、可以追问、幻想出的答案

- 误解:罐头回答、答案是网络搜索的结果

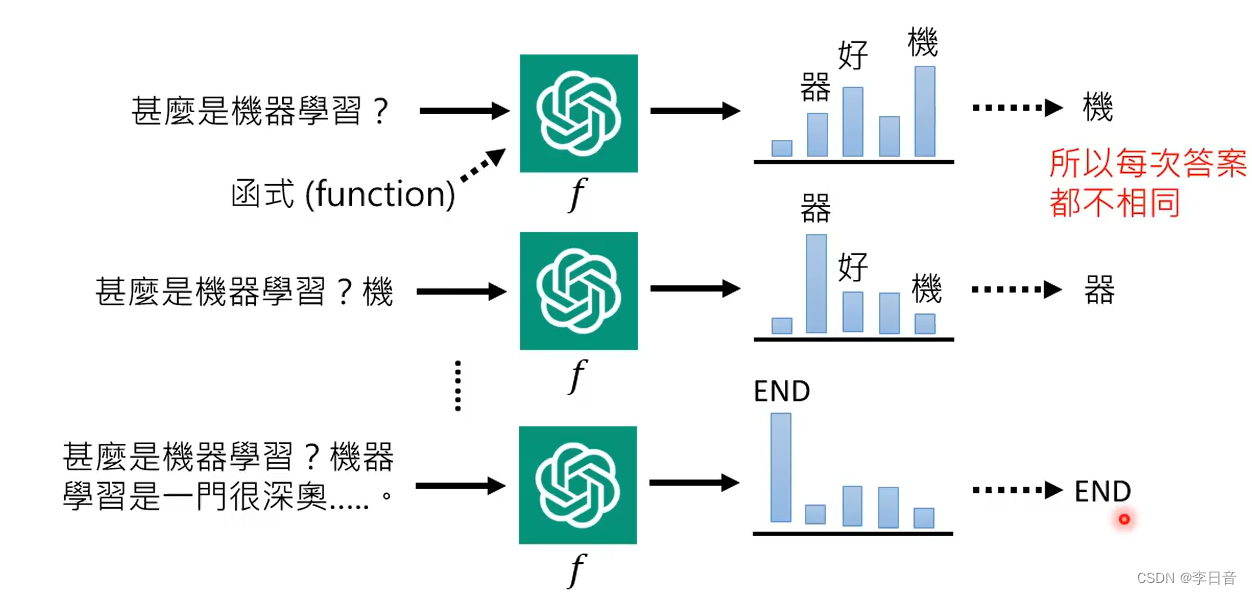

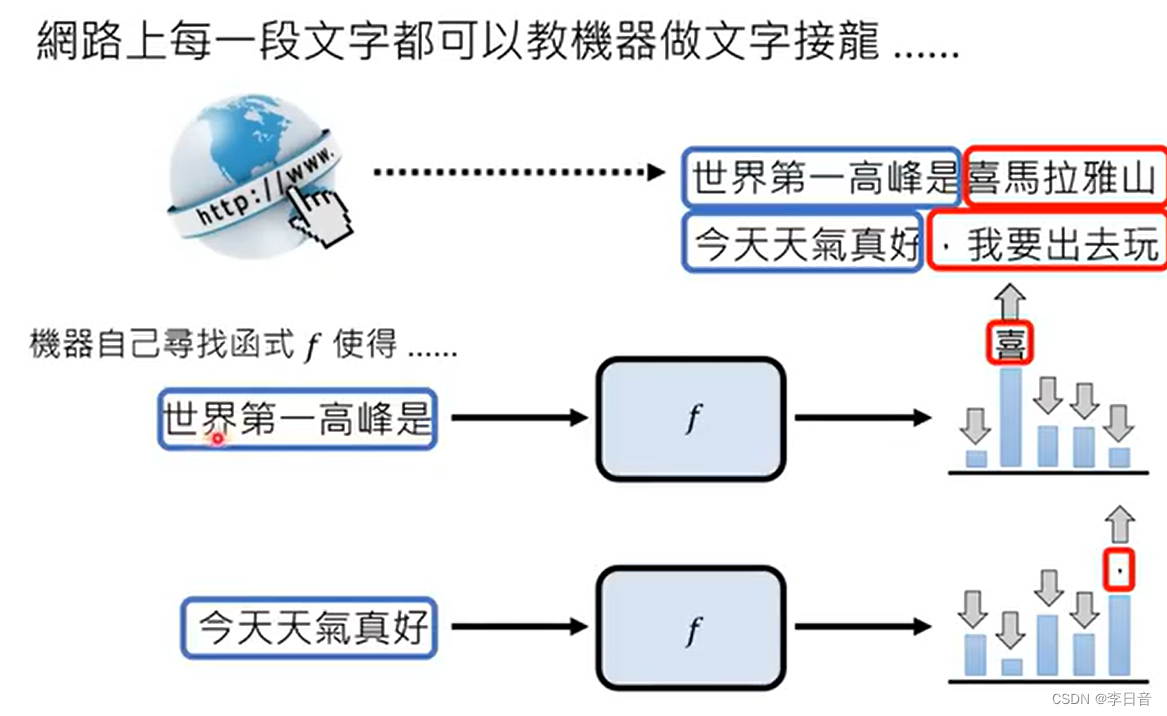

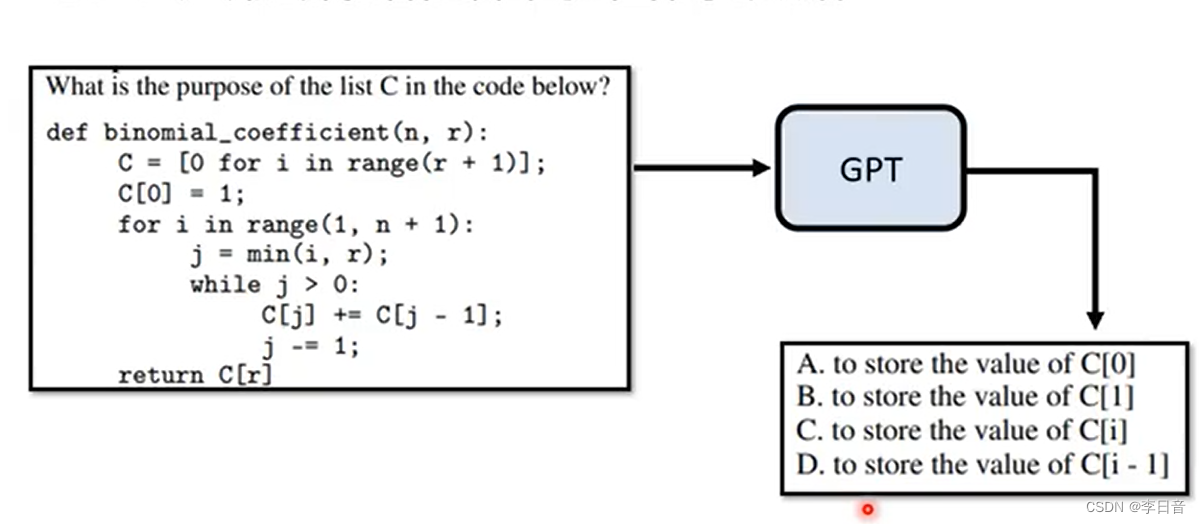

- 真正做的事:文字接龙,function,几率分布 -> 采样

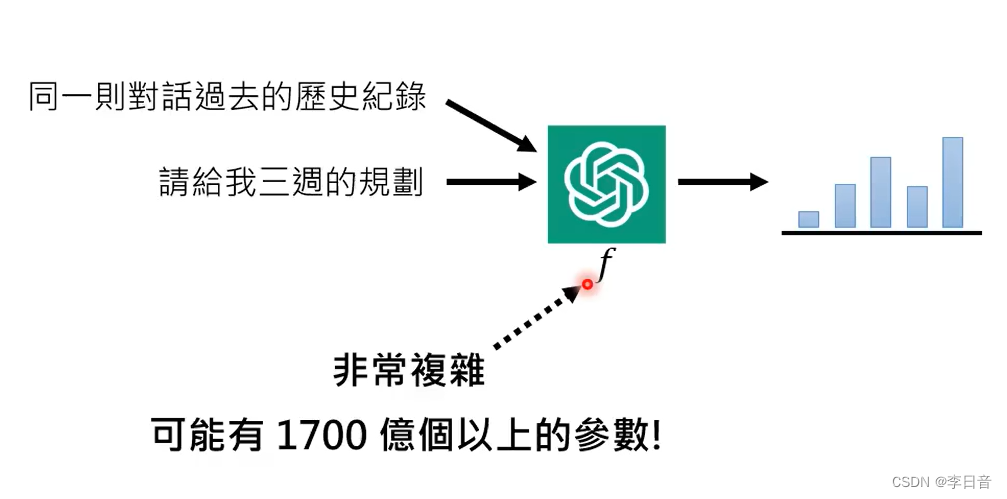

不仅包含现在的输入还有过去的输入,大语言模型 = 文字接龙

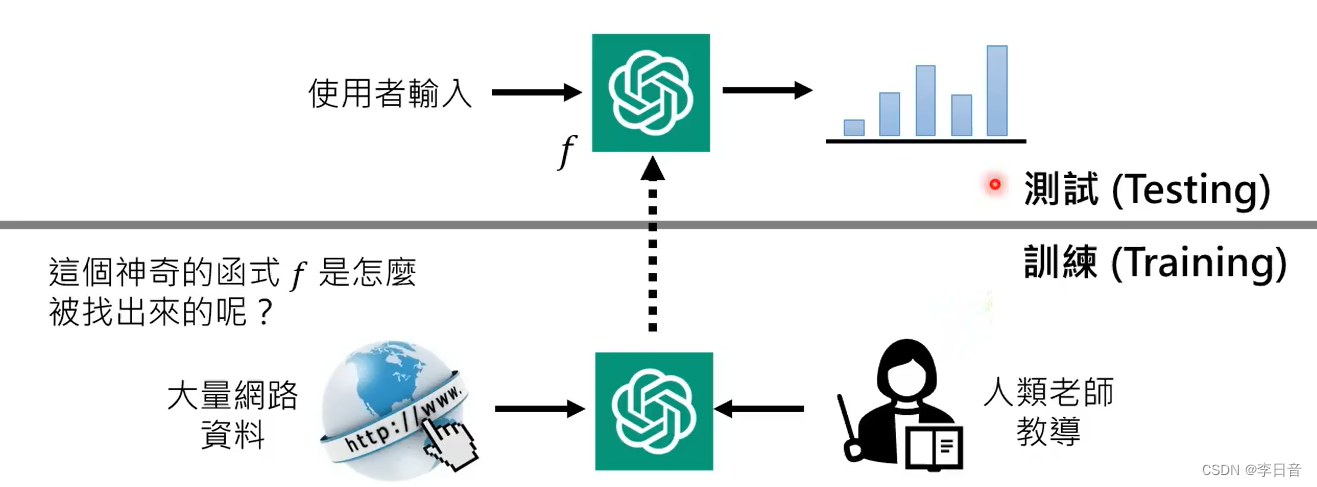

训练:寻找函数的过程,使用了网络资料

测试:没有联网

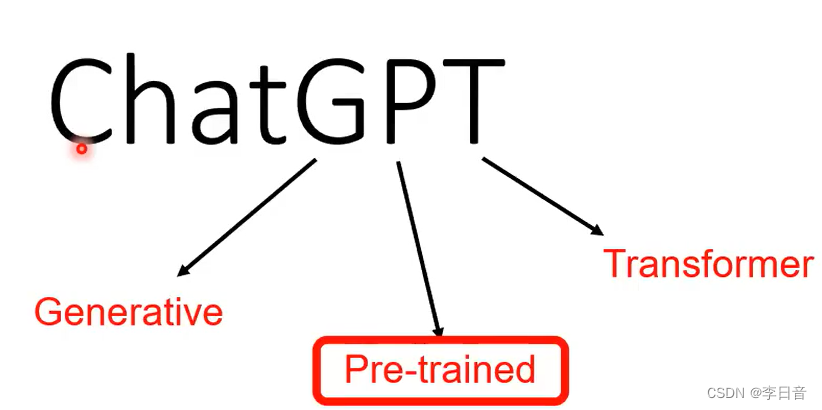

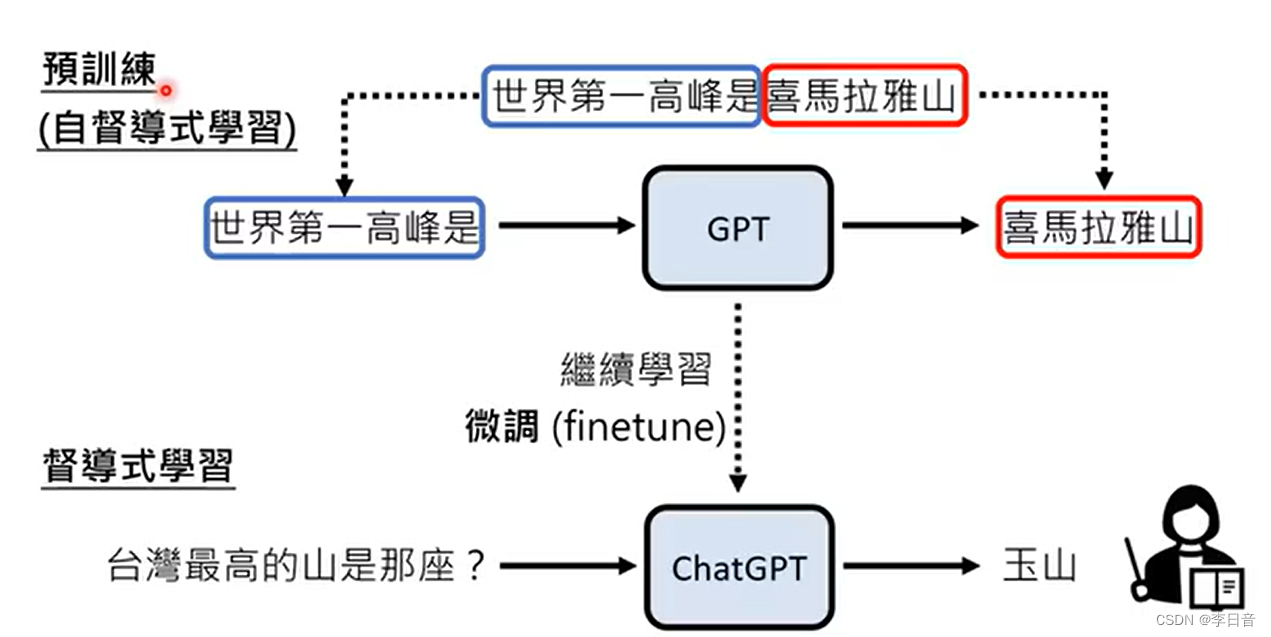

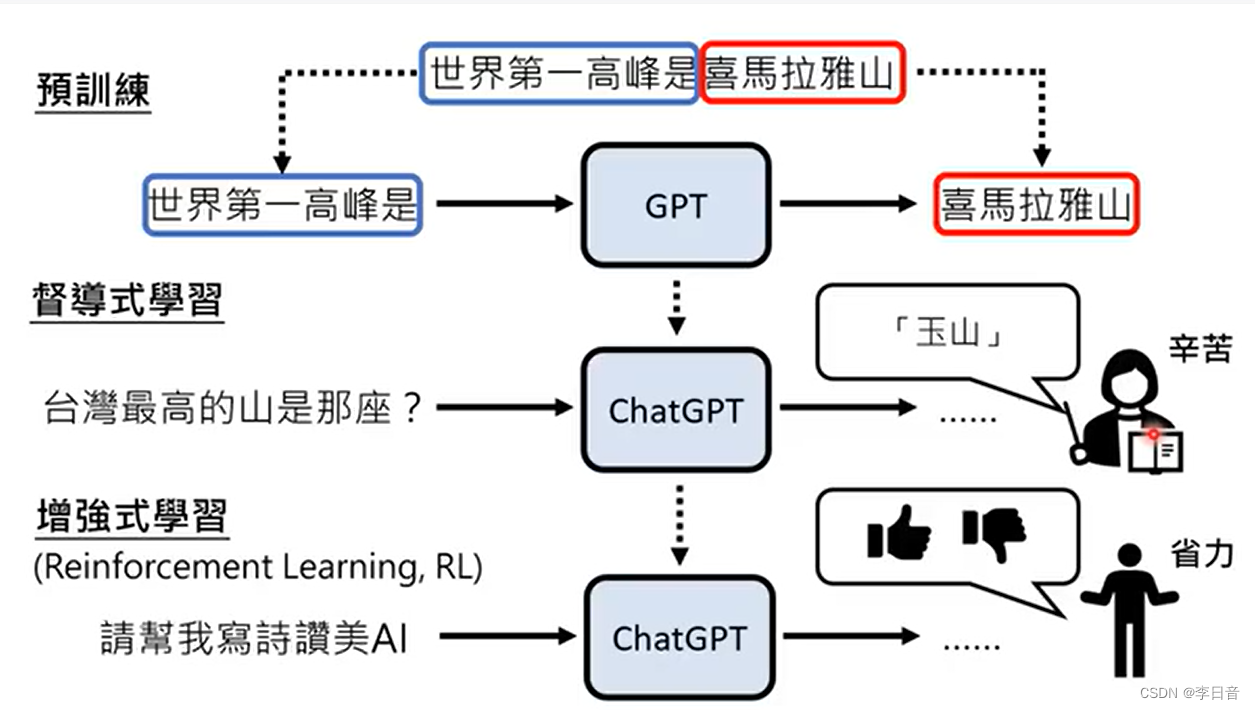

关键技术——预训练

一般的机器学习:

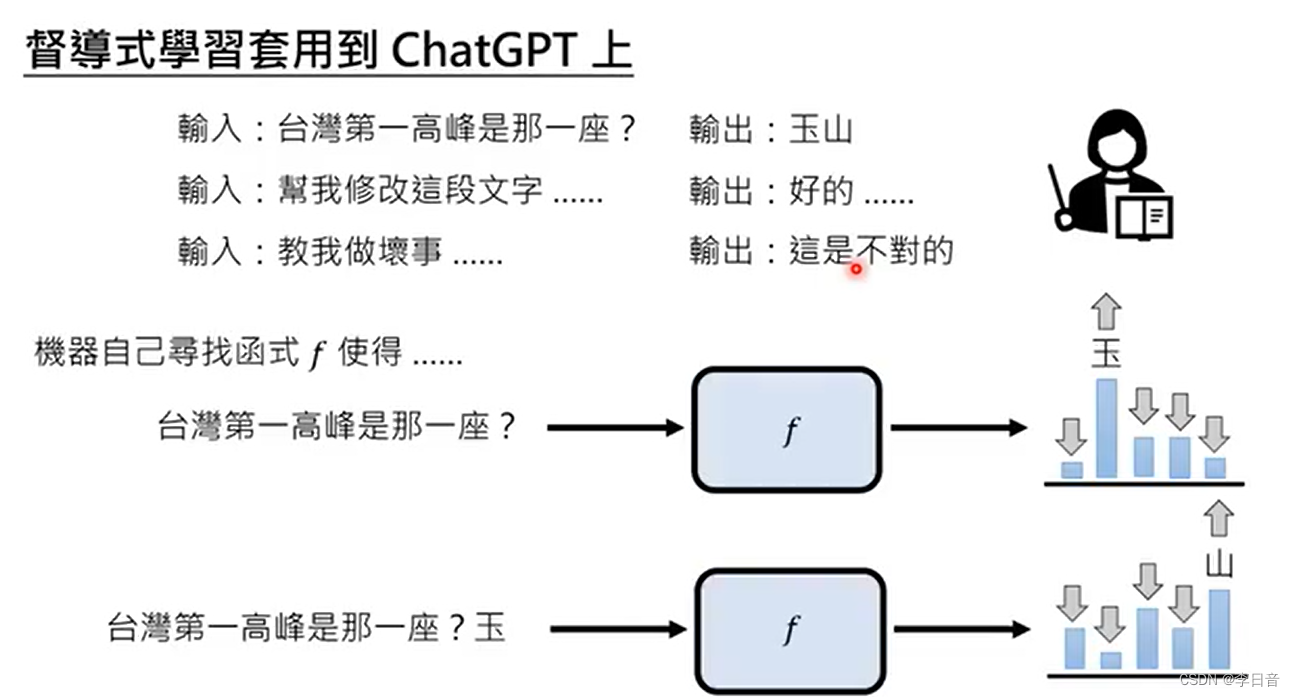

督导式学习

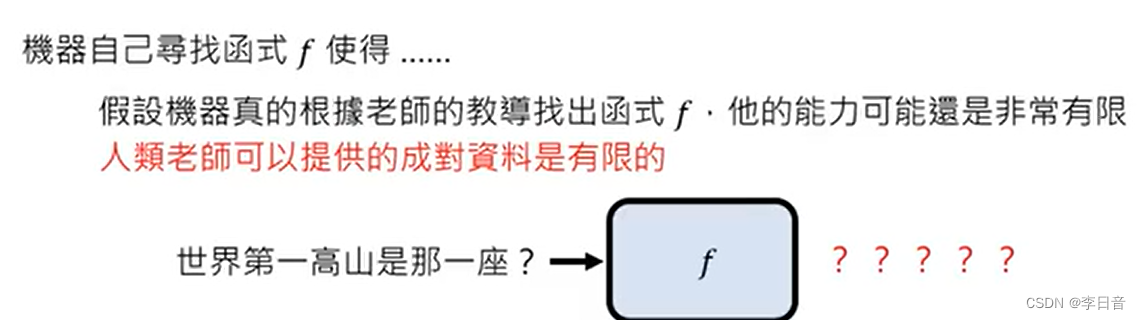

人类提供资料有限,GPT就无法回答

使用网络上的文字来教GPT学习

- GPT:2018年 117M模型,1G数据。单纯用网络资料学习

- GPT-2:2019年,1542M模型,40G数据。开始像模像样地瞎掰,可以回答问题

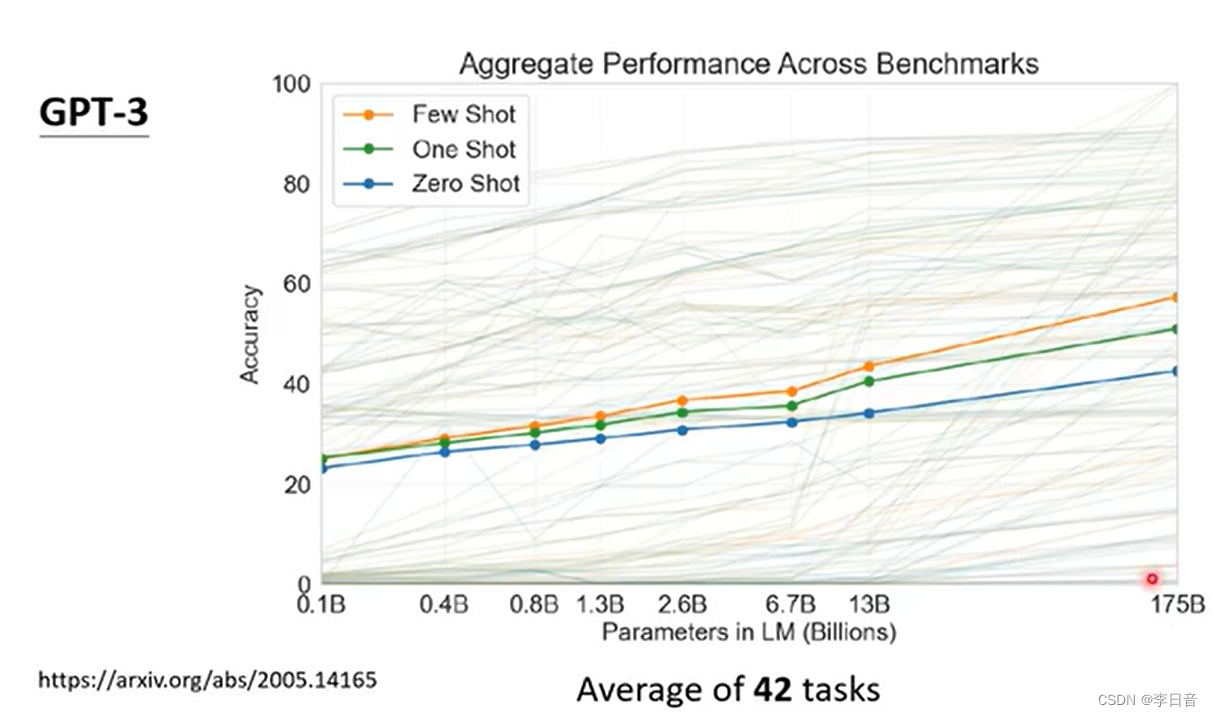

- GPT-3:2020年,175B模型,45T资料筛选出的570G数据(哈利波特全集的30w倍)。可以写程序了。

参数量越大,正确率越高,但似乎接近极限了

网络资料的缺陷:不受控

解决:督导式学习,微调

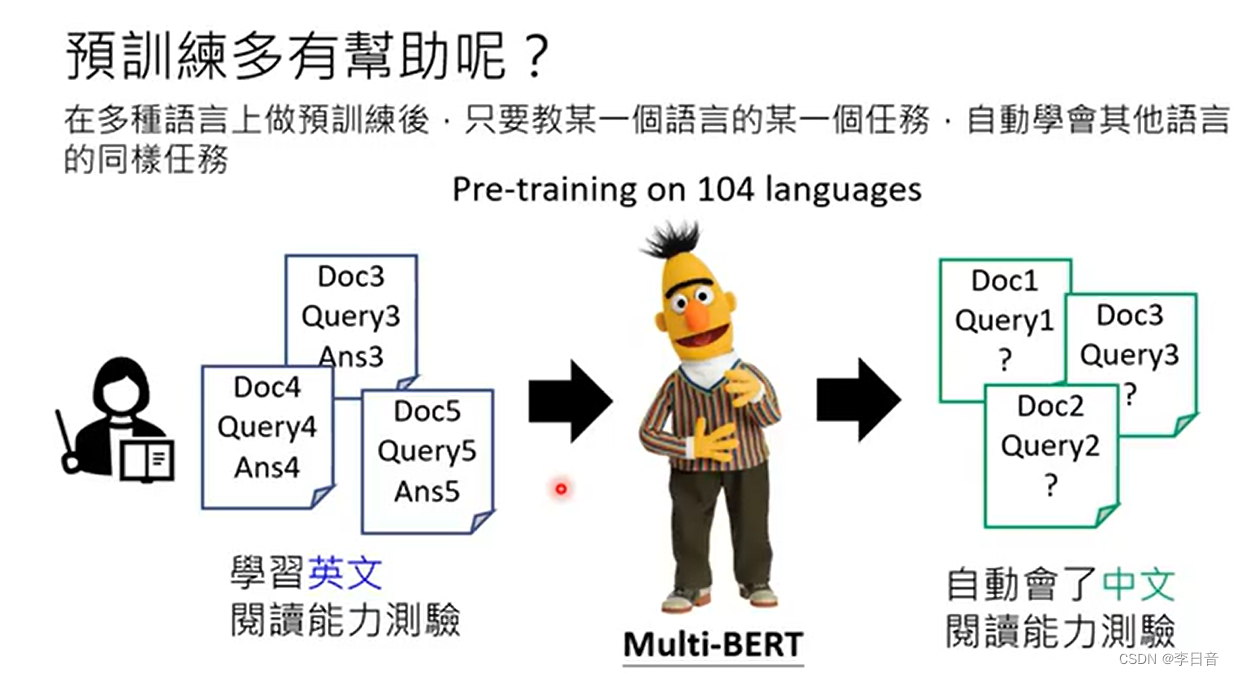

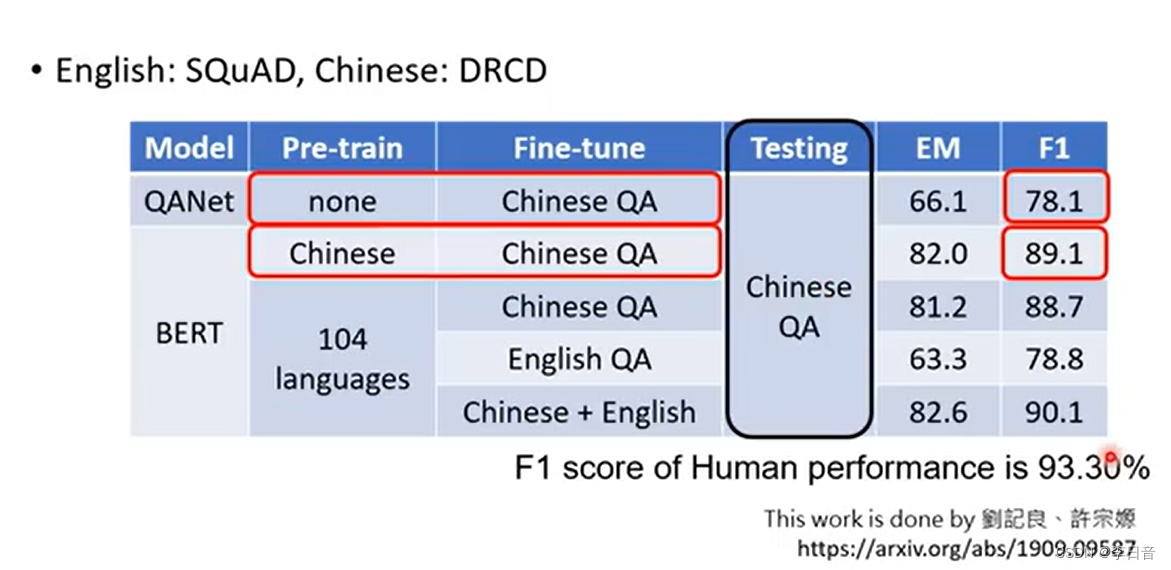

预训练的帮助:也许人类不需要教会GPT所有语言。只教会GPT某一个语言的某种任务,自动学会其他语言的相同任务

多种语言预训练,只在某种语言上微调

增强式学习只需要人判断答案好不好就行

研究问题

对NLP领域影响很大,也带来了新的研究方向。

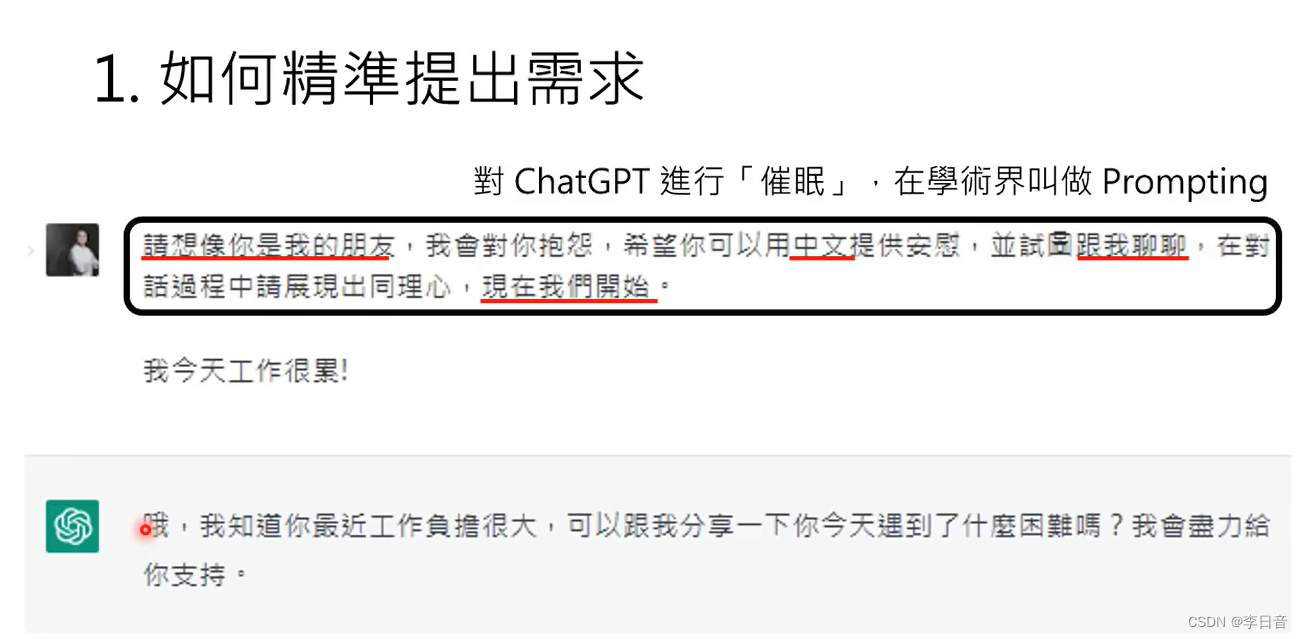

- 如何精准提升需求?催眠(Prompting)。有没有更好的方式找到prompting

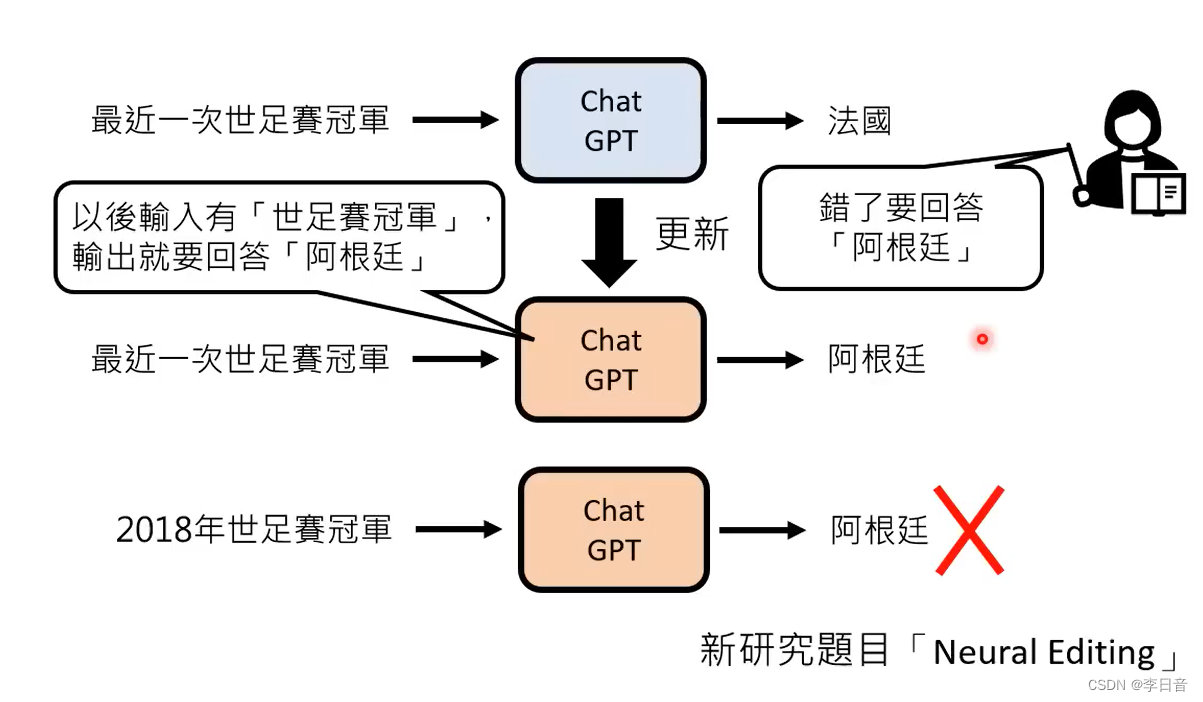

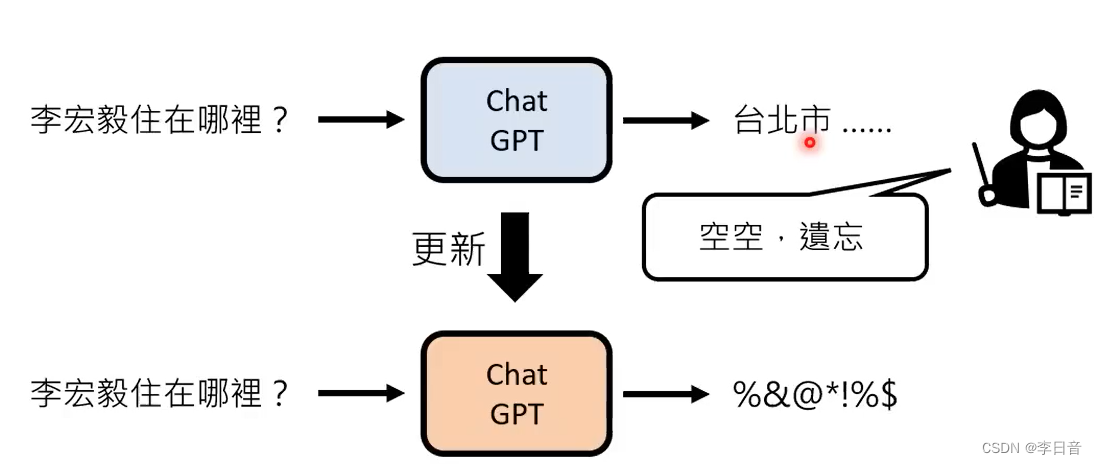

- 如何更正错误?把某一个答案弄对,弄错了更多答案

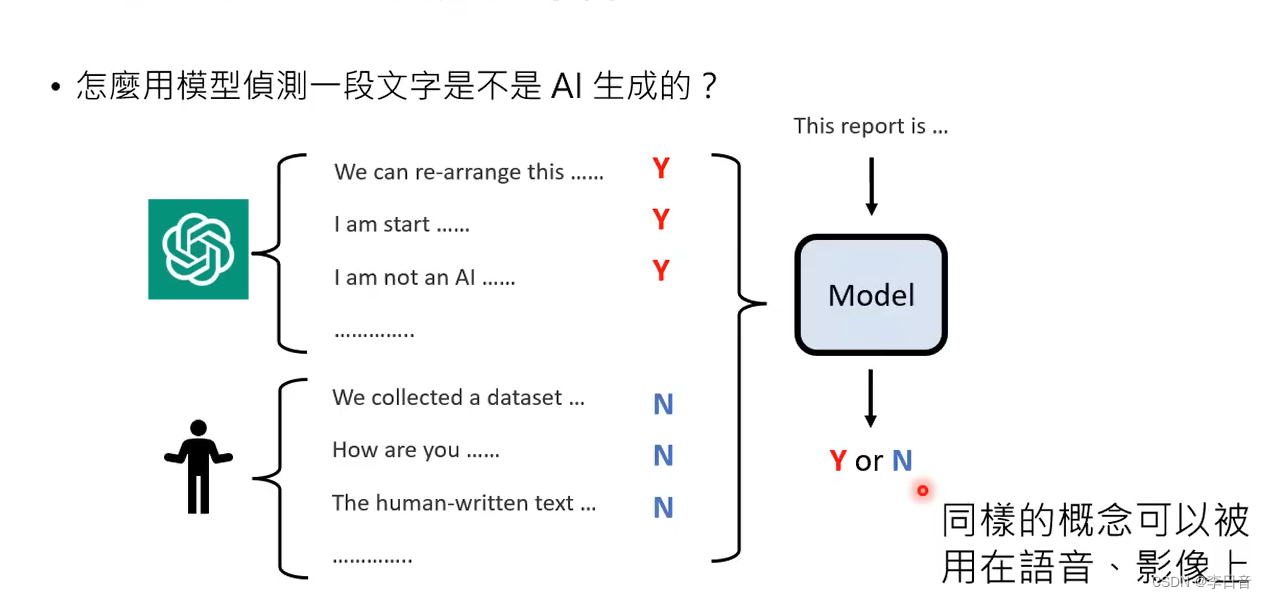

- 侦测AI生成的物件

- 不小心泄露人类秘密

machine unlearning

文章来源:https://blog.csdn.net/lalala12ll/article/details/135633011

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 第4章 【课后习题】(部分~)

- MySQL 设置商品乐观锁号示例

- git切换分支时,该分支的修改被带到另一个分支

- OpenCV实战 -- 维生素药片的检测记数

- AI:118-基于深度学习的法庭口译实时翻译

- Efinix - Hyperram Native 仿真波形记录

- 如何实现MapStruct自定义映射逻辑

- IntelliJ IDE 插件开发 | (三)消息通知与事件监听

- django《区块链技术与应用》课程案例信息资源系统(程序+开题报告)

- 安全防御之恶意代码与防护技术