nn.BCEWithLogitsLoss中weight参数和pos_weight参数的作用及用法

发布时间:2024年01月12日

nn.BCEWithLogitsLoss中weight参数和pos_weight参数的作用及用法

weight参数

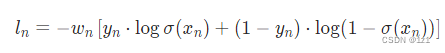

上式是nn.BCEWithLogitsLoss损失函数的计算公式,其中w_n对应weight参数。

如果我们在做多分类任务,有些类比较重要,有些类不太重要,想要模型更加关注重要的类别,那么只需将比较重要的类所对应的w权重设置大一点,不太重要的类所对应的w权重设置小一点。

下面是一个代码演示:

import torch

import torch.nn as nn

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

a = torch.tensor([[1.0, 2.0],[1.0,2.0]])

m = nn.Sigmoid()

b = torch.Tensor([[0, 1],[0,1]])

loss_function = nn.BCEWithLogitsLoss()

loss_function1 = nn.BCEWithLogitsLoss(weight=torch.tensor([0, 1.0]))

loss_function2 = nn.BCEWithLogitsLoss(weight=torch.tensor([1.0, 0]))

loss_function3 = nn.BCEWithLogitsLoss(weight=torch.tensor([1.0, 1.0]))

loss_function4 = nn.BCEWithLogitsLoss(weight=torch.tensor([1.0, 2.0]))

loss = loss_function(a, b)

loss1 = loss_function1(a, b)

loss2 = loss_function2(a, b)

loss3 = loss_function3(a, b)

loss4 = loss_function4(a, b)

print(loss, loss1, loss2, loss3, loss4)

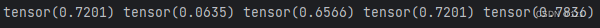

运行结果:

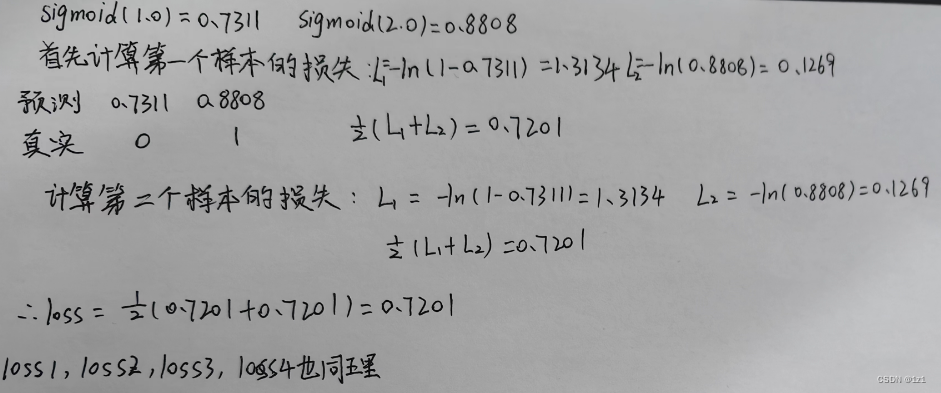

其中[1.0, 2.0]经过sigmoid层之后的值是[0.7311,0.8808]

对于loss的计算过程如下所示:

pos_weight参数

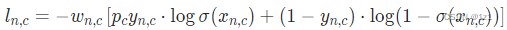

其中pos_weight对应上式公式中的p_c,这个参数是为了调节正负样本不均衡问题的,如果正负样本比是10:1,那么我们可以将p_c设置为1/10来平衡正负样本。

文章来源:https://blog.csdn.net/Zuobf_bk/article/details/135550345

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 第4章 | 安徽某高校《统计建模与R软件》期末复习

- jenkins 自由风格部署vue项目,参数化构建vue项目

- 分享7款创意性及实用性的前端动画特效(附在线预览)

- 【spring源码分析】@Bean的使用以及分析

- Spring 声明式事务讲解,和 @Transactional注解的用法

- 大模型入门0: 基础知识

- Kafka Avro序列化之一:使用自定义序列化

- windows环境下cmd找不到pip

- 算法训练第五十天|123. 买卖股票的最佳时机 III、188. 买卖股票的最佳时机 IV

- 如何限制 IP 多次重新访问