书生-浦路大模型全链路开源体系

发布时间:2024年01月04日

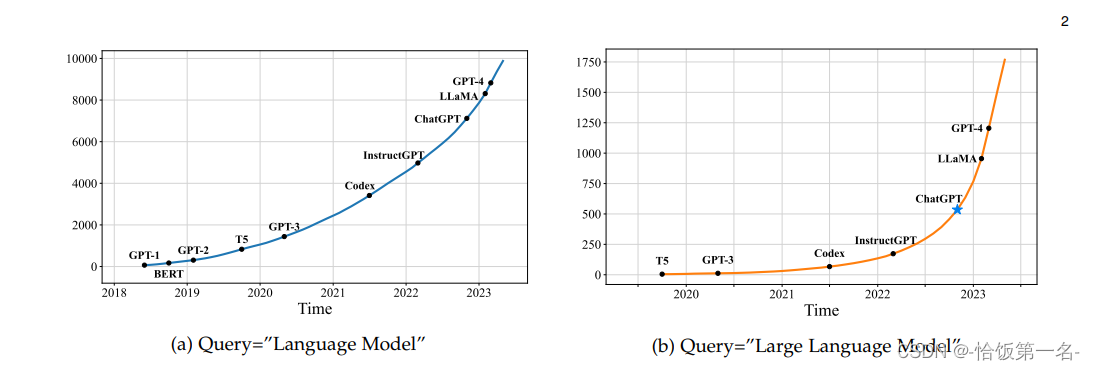

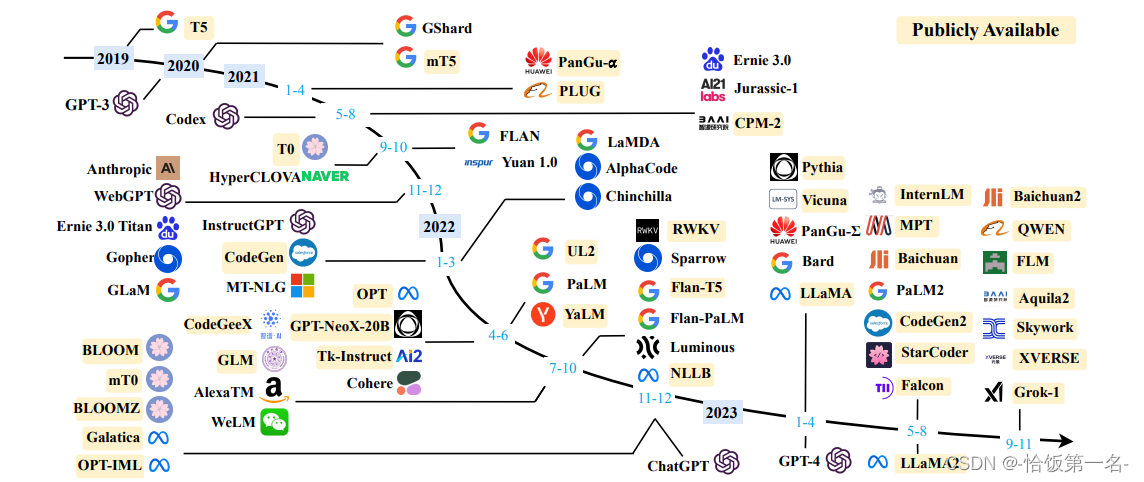

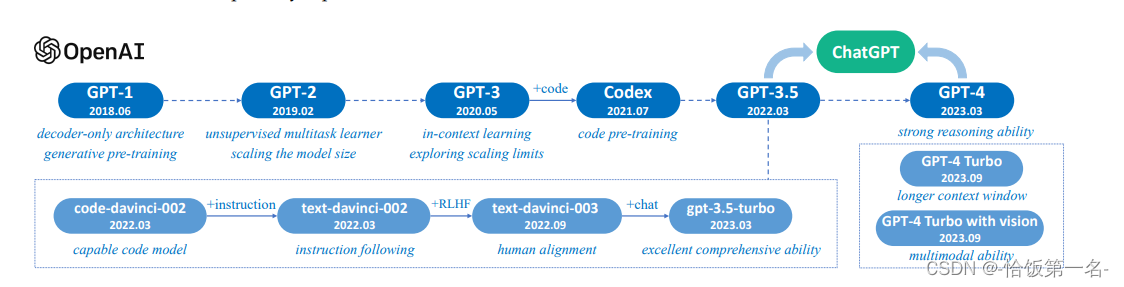

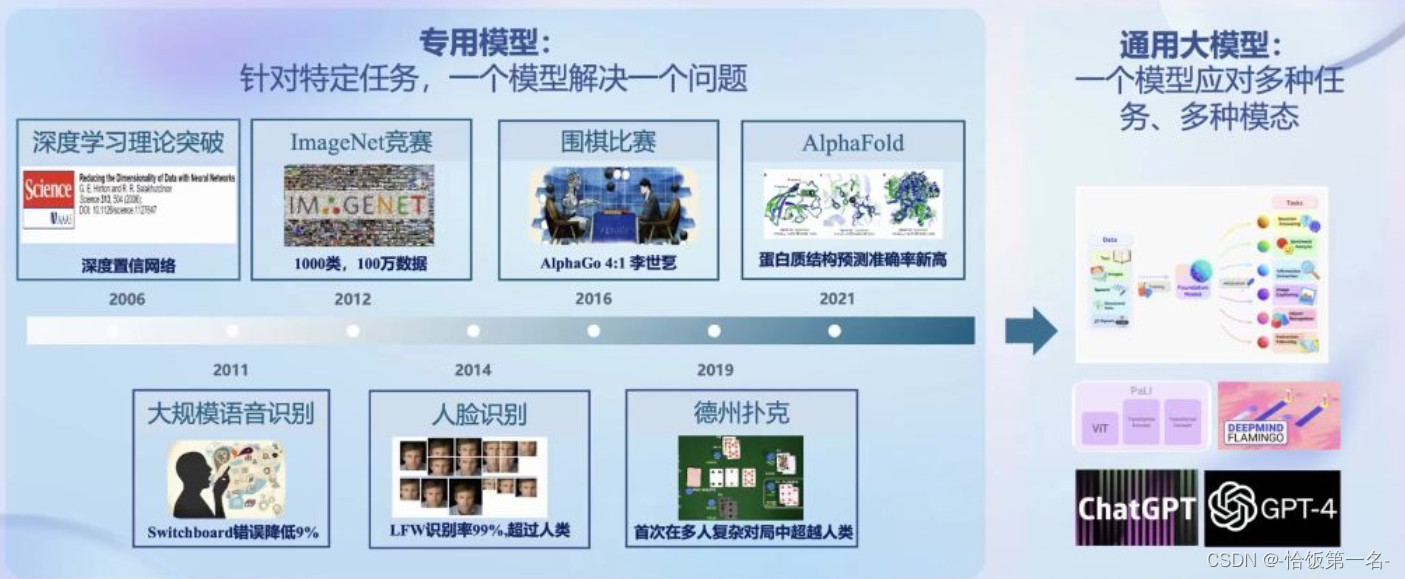

2023年,大模型成为热门关键词

大模型已经成为发展通用人工智能的重要途经

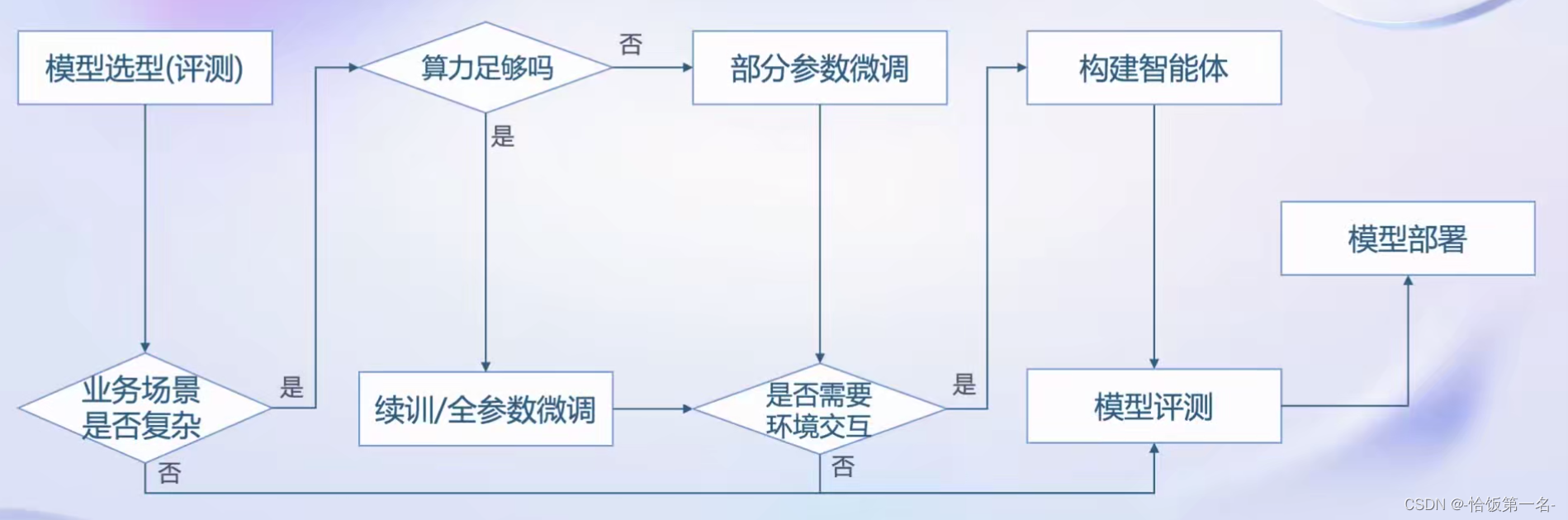

模型评测过程:从模型到应用

全链条开源开发体系 | 数据:

-

多模态融合

万卷包含文本、图像和视频等多模态数据,涵盖科技、文学、媒体、教育和法律等多个领域。该数据集对模型的知识内容、逻辑推理和泛化能力的提升有显著效果 -

精细化处理

万卷经过语言筛选、文本提取、格式标准化、数据过滤和清洗(基于规则和模型)、多尺度去重和数据质量评估等精细数据处理环节,能够很好地适应后续模型训练的要求。 -

价值观对齐

在万卷的构建过程中,研究人员注重将数据内容与主流中国价值观进行对齐,并通过算法和人工评估的结合提高语料库的纯净度

全链条开源开发体系 | 预处理:

高可扩展

支持从 8卡到 千卡训练 千卡 加速效率达 92%

极致性能优化

Hybrid Zero独特技术+极致优化,加速 50%

兼容主流

无缝接入 HuggingFace等技术生态,支持各类轻量化技术

开箱即用

支持多种规格语言模型,修改配置即可训练

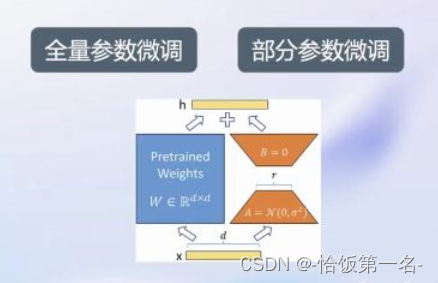

全链条开源开放体系 | 微调

大语言模型的下游应用中,增量续训和有监督微调是经常会用到两种方式

增量续训

使用场景:让基座模型学习到一些新知识,如某个垂类领域知识训练数据:文章、书籍、代码等

有监督微调

使用场景:让模型学会理解和遵循各种指令,或者注入少量领域知识训练数据:高质量的对话、问答数据

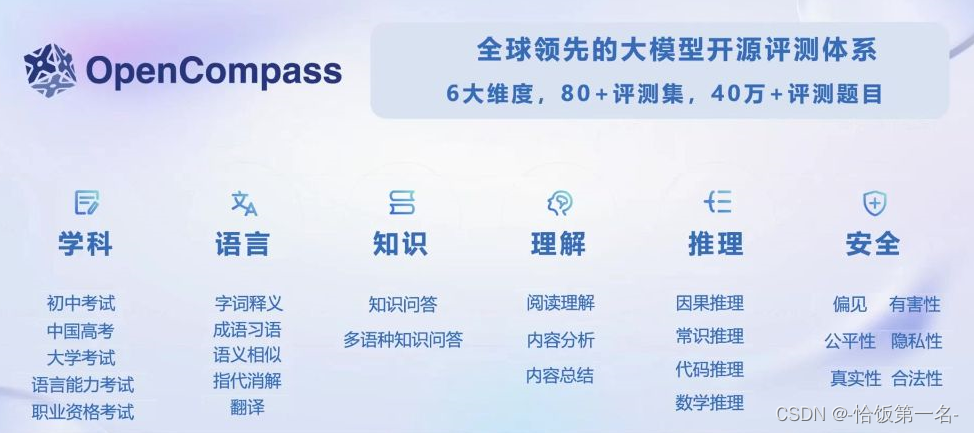

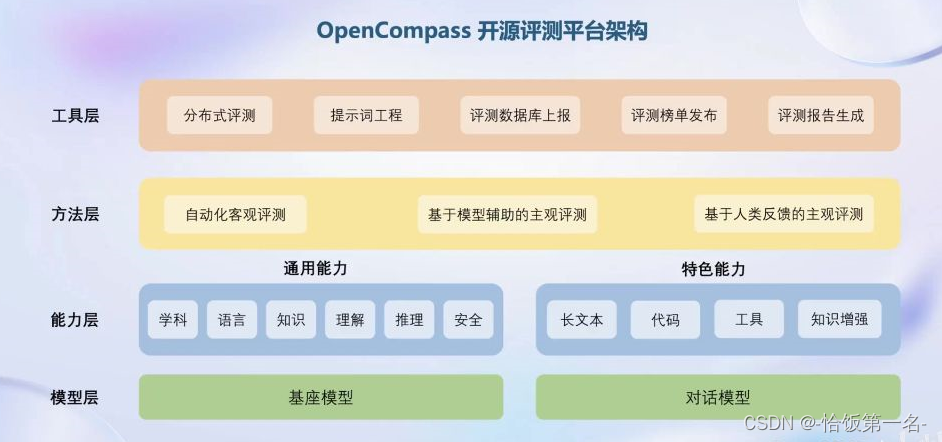

全链条开源开放体系|评测

全链条开源开放体系|部署

- 大语言模型特点

- 内存开销巨大

- 庞大的参数量

- 采用自回归生成token,需要缓存k/v

- 动态Shape

- 请求数不固定

- token逐个生成,且数量不定

- 模型结构相对简单

- transformer结构,大部分是decoder-only

- 技术挑战

- 设备

- 低存储设备(消费级显卡、移动端等)如何部署?

- 推理

- 如何加速token的生成速度.

- 如何解决动态shape,让推理可以不间断

- 如何有效管理和利用内存

- 服务

- 提升系统整体吞吐量.

- 降低请求的平均响应时间

- 部署方案

- 技术点

- 模型并行

- 低比特量化

- Attention优化

- 计算和访存优化

- Continuous Batching

全链条开源开放体系|智能体

大语言模型的局限性

- 最新信息和知识的获取

- 回复的可靠性

- 数学计算

- 工具使用和交互

多模态智能体工具箱AgentLego

- 丰富的工具集合,尤其是提供了大量视觉、多模态相关领域的前沿算法功能

- 支持多个主流智能体系统,如 LangChain,Transformers Agent,Lagent 等

- 灵活的多模态工具调用接口,可以轻松支持各类输入输出格式的工具函数

- 一键式远程工具部署,轻松使用和调试大模型智能体

文章来源:https://blog.csdn.net/weixin_46334272/article/details/135374581

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 图形图像处理车牌识别系统设计matlab

- PostgreSQL命令大全

- Python基础知识:整理19 -> Python 操作Mysql数据库

- 【开题报告】基于SpringBoot的餐饮店管理系统设计与实现

- 计算机网络——网络中要解决的问题

- yolo网络整理-网络结构原理与anchor

- GeoServe本地部署结合内网穿透实现远程访问Web管理界面

- 鸿蒙原生应用/元服务开发-Stage模型能力接口(六)

- Android 11.0 系统内存优化之修改dalvik虚拟机的内存参数

- [每周一更]-(第35期):为何要用ChatGPT?