尚硅谷大数据技术-数据湖Hudi视频教程-笔记01

大数据新风口:Hudi数据湖(尚硅谷&Apache Hudi联合出品)尚硅谷数据湖Hudi视频教程

- B站直达:https://www.bilibili.com/video/BV1ue4y1i7na

- 百度网盘:https://pan.baidu.com/s/1NkPku5Pp-l0gfgoo63hR-Q?pwd=yyds

- 阿里云盘:https://www.aliyundrive.com/s/uMCmjb8nGaC(教程配套资料请从百度网盘下载)

目录

第1章 Hudi概述

001

教程详细讲解了Hudi与当前最流行的三大大数据计算引擎:Spark、Flink和Hive的对接过程,内容包括环境准备、多种对接方式、重点配置参数分析、进阶调优手段讲解等,从入门到精通,学习后即可快速投入实际生产使用!

002

hudi

- .parquet:列式存储

- .avro:行式存储

003

1.3 Hudi特性

- 自动管理小文件,数据聚簇,压缩,清理。

004

1.4 使用场景

第2章 编译安装

005

maven修改为阿里镜像

(1)修改setting.xml,指定为阿里仓库地址

vim /opt/module/maven-3.6.1/conf/settings.xml

<!-- 添加阿里云镜像-->

<mirror>

??????? <id>nexus-aliyun</id>

??????? <mirrorOf>central</mirrorOf>

??????? <name>Nexus aliyun</name>

??????? <url>http://maven.aliyun.com/nexus/content/groups/public</url>

</mirror>

006

2.2.3 修改源码兼容hadoop3

007

2.2.4 手动安装Kafka依赖

008

2.2.5 解决spark模块依赖冲突

009

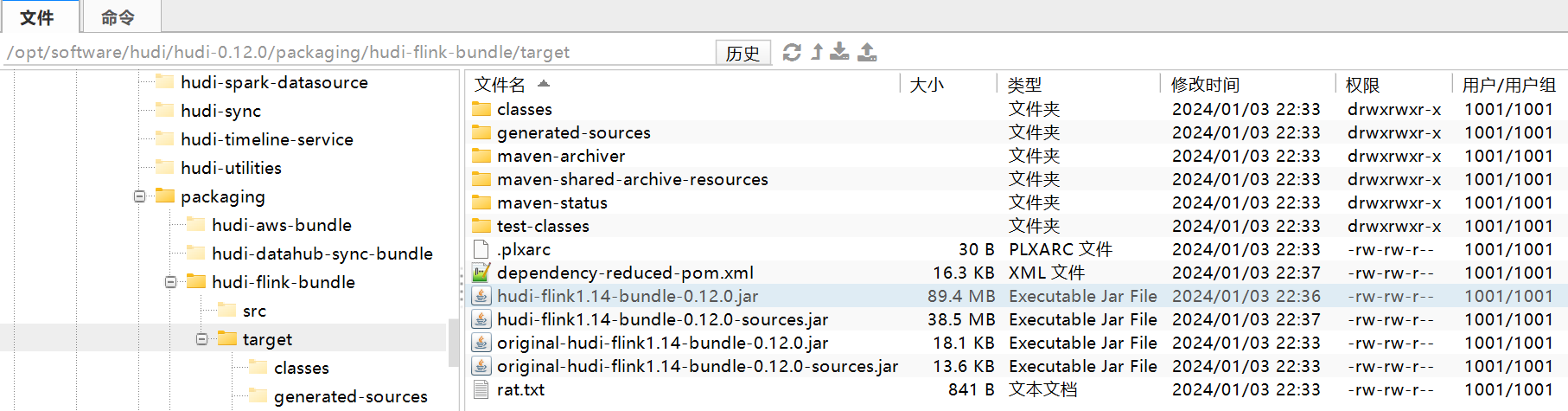

2.2.6 执行编译命令

mvn clean package -DskipTests -Dspark3.2 -Dflink1.13 -Dscala-2.12 -Dhadoop.version=3.1.3 -Pflink-bundle-shade-hive3

[atguigu@node001 hudi-0.12.0]$ mvn clean package -DskipTests -Dspark3.0 -Dflink1.17 -Dscala-2.12 -Dhadoop.version=3.1.3 -Pflink-bundle-shade-hive3

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- JS 高频面试题

- 广汽本田售后服务技术技能竞赛总决赛

- TensorRT部署--Linux(Ubuntu)环境配置

- 外包干了一个月,技术明显进步。。。。。

- 极限科技(INFINI labs)荣获中国信通院大数据“星河”标杆案例

- 电缆护层保护器维护方法详解

- 说说你对CSS预编语言的理解?sass、less、stylus有什么区别?

- 为什么要学习C语言

- ARM的一些基础知识

- 基于RS485/232的信捷XD5 PLC如何进行程序远程上下载与调试?