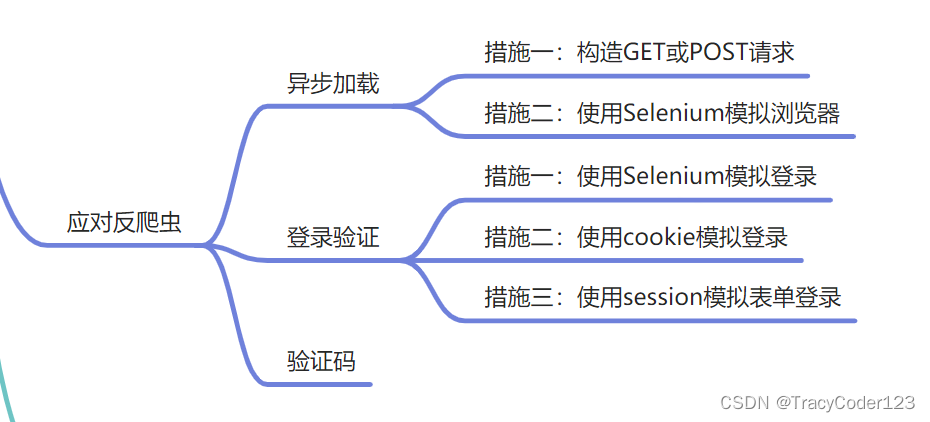

走近Python爬虫(二):常见反爬虫机制的应对措施

本文是Python爬虫系列博客的第二篇,内容概览如下:

一、应对—异步加载

1.一般措施

- AJAX技术介绍:

AJAX是Asynchronous JavaScript And XML的首字母缩写,意为异步JavaScript与XML。使用AJAX技术,可以在不刷新网页的情况下更新网页数据。使用AJAX技术的网页,一般会使用HTML编写网页的框架。在打开网页的时候,首先加载的是这个框架。剩下的部分将会在框架加载完成以后再通过JavaScript从后台加载。

网页上面存在的某些文字,在源代码中却不存在的情况,绝大部分都是使用了异步加载技术。

- 应对思路:

+++当我们发现某个接口获取数据的前提是向服务器发起GET或POST请求,然后在response中获取网页数据。我们可以使用Python模拟浏览器(使用浏览器的请求头和请求体)发送GET或POST请求。

+++有一些网页,显示在页面上的内容要经过多次异步请求才能得到。第1个AJAX请求返回的是第2个请求的参数,第2个请求的返回内容又是第3个请求的参数,只有得到了上一个请求里面的有用信息,才能发起下一个请求。像这种情况,解决思路也是通过构造一个又一个的请求来获取最终数据。不过在这个过程中需要有深厚的代码功底,否则难以看懂经过了混淆的源代码。

+++包括基于异步加载的简单登录,也可以通过这种方式来实现,从而获得相应的通过口令。

2.Selenium

虽然在网页的源代码中无法看到被异步加载的内容,但是在Chrome的开发者工具的“Elements”选项卡下却可以看到网页上的内容,这就说明Chrome开发者工具“Elements”选项卡里面的HTML代码和网页源代码中的HTML代码是不一样的。在开发者工具中,此时显示的内容是已经加载完成的内容。如果能够获得这个被加载的内容,那么就能绕过手动构造的过程,可以直接使用XPath来获得想要的内容。

这种情况下,就需要使用Selenium操作浏览器来解析JavaScript,再爬取被解析以后的代码。

- 安装:

pip install selenium

下载ChromeDriver,根据自己的系统选择合适的版本,并安装。

- 代码:

可以根据实际情况修改until条件。

from selenium import webdriver

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.common.by import By

from selenium.webdriver.support import expected_conditions as EC

driver = webdriver.Chrome('./chromedriver')

# 获取页面

try:

WebDriverWait(driver, 30).until(EC.presence_of_element_located((By.CLASS_NAME, "content")))

except Exception as _:

print(’网页加载太慢,不想等了。')

# 查找资源

print(driver.page_source)

comment = driver.find_element_by_xpath('//div[@class="content"]')

print(comment.text)

comment = driver.find_elements_by_xpath('//p[starts-with(@id, "content_")]')

for each in comment:

print(each.text)

二、应对—登录验证

1.使用Selenium模拟登录

优点是简单有效,缺点是它的速度太慢了,不适合用于大规模的爬虫开发。

(1)初始化ChromeDriver。

(2)打开知乎登录页面。

(3)找到用户名的输入框,输入用户名。

(4)找到密码输入框,输入用户名。

(5)手动单击验证码。

(6)按下Enter键。

- 示例代码:

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

import time

driver = webdriver.Chrome('./chromedriver') #填写你的chromedriver的路径

driver.get("https://www.zhihu.com/#signin")

elem = driver.find_element_by_name("account") #寻找账号输入框

elem.clear()

elem.send_keys("xxx@gmail.com") #输入账号

password = driver.find_element_by_name('password') #寻找密码输入框

password.clear()

password.send_keys("12345678") #输入密码

input(’请在网页上点击倒立的文字,完成以后回到这里按任意键继续。')

elem.send_keys(Keys.RETURN) #模拟键盘回车键

time.sleep(10)#这里可以直接sleep,也可以等待某个条件出现

print(driver.page_source)

driver.quit()

2.使用Cookies登录

为了不让用户每次访问网站都进行登录操作,浏览器会在用户第一次登录成功以后放一段加密的信息在Cookies中。下次用户访问,网站先检查Cookies有没有这个加密信息,如果有并且合法,那么就跳过登录操作,直接进入登录后的页面。通过已经登录的Cookies,可以让爬虫绕过登录过程,直接进入登录以后的页面。

使用Cookie来登录网页,不仅可以绕过登录步骤,还可以绕过网站的验证码。

3.使用Session模拟表单登录

因为某些网站的登录过程中涉及到了页面跳转,但是我们却无法感知到中间的某些跳转,因此仅仅是模拟一步GET/POST请求无法实现模拟登陆,可能需要分多步进行。

在这种情况下,使用python requests的Session模块来模拟这个登录。

- 代码示例:

import requests

login_url='xxx'

login_success='xxxx'

data={

'username':'111',

'password':'1111'

}

session=requests.Session()

# step1

session.post(login_url,data=data).text

# step2

after_login=session.get(login_success).text

print(after_login)

三、应对—验证码

对于一次登录就可以长时间使用的情况,只需要识别一次验证码即可。这种情况下,与其花时间开发一个自动识别验证码的程序,不如直接肉眼识别。

- 借助浏览器肉眼识别:

对于需要输入验证码才能进行登录的网站,可以手动在浏览器登录网站,并通过Chrome获取Cookies,然后使用Cookies来访问网站。这样就可以实现人工输入一次验证码,然后很长时间不再登录。有一些网站的验证码是通过单击或者拖动滑块来验证的。对于这种网站,目前最简单的办法就是使用Cookies来登录,其他方式都不好用。

- 借助代码Session肉眼识别:

(1)爬虫访问登录页面。

(2)分析网页源代码,获取验证码地址。

(3)下载验证码到本地。

(4)打开验证码,人眼读取内容。

(5)构造POST的数据,填入验证码。

(6)POST提交。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 如何在PHP中对接openAI接口,PHP创建AI会话思路以及代码讲解

- 建站为什么需要服务器?(Web服务器与计算机对比)

- 【华为OD】服务器连接方式包括直接相连,间接连接。 A和B直接连接,B和C直接 连接,则A和C间接连接

- Flutter如何实现与Android底层平台通信,调用底层Android原生方法

- 协议茶馆:TLV 格式及编码

- Python数据分析案例37——基于分位数神经网络(QRNN)的汇率预测

- 常见BUG如何在测试过程中分析定位

- 嵌入式Linux之Ubuntu学习笔记(文件连接)

- codeforces 1909B

- 制造行业定制软件解决方案——工业信息采集平台