【激活函数】深度学习中你必须了解的几种激活函数 Sigmoid、Tanh、ReLU、LeakyReLU 和 ELU 激活函数(2024最新整理)

发布时间:2024年01月05日

激活函数(activation function)的作用是对网络提取到的特征信息进行非线性映射,提供网络非线性建模的能力。常见的激活函数有 Sigmoid、Tanh、ReLU、LeakyReLU 和 ELU 等。

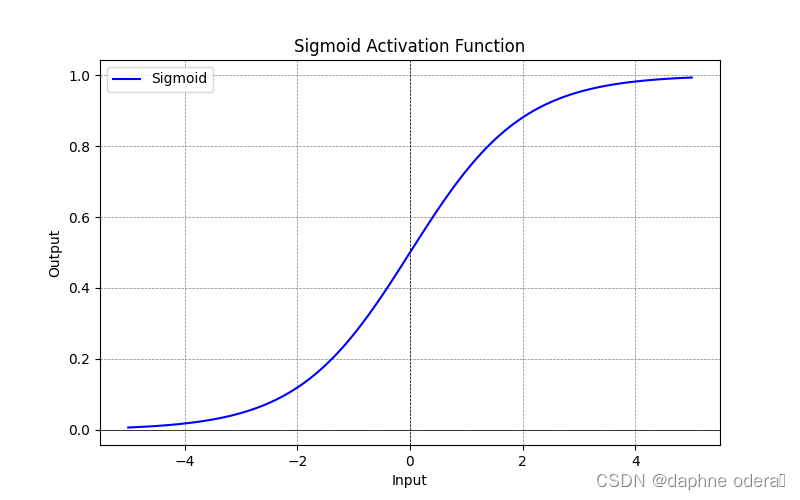

1. Sigmoid 激活函数

Sigmoid 是一种常见的非线性激活函数,输入实数值并将其压缩到 (0,1) 范围内。其缺点是当输入值较大和较小时,梯度会接近于0从而导致梯度消失问题,函数的输出也不是以0为中心,指数计算复杂度高也更加耗时。其计算公式如下所示:

Sigmoid 激活函数示意图:

2. Tanh 激活函数

文章来源:https://blog.csdn.net/Next_SummerAgain/article/details/134721177

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- [DM8] 达梦8配置兼容Oracle

- Fortran 编译后Dll依赖问题(libifcoremd.dll)

- 国产化之路加速前行,计通智能展现卓越适配能力

- AI:108-基于深度学习的通信干扰抑制技术研究

- 美易官方《美股一哥争夺战白热化:微软市值一度超越苹果》

- Qt动态连接库/静态连接库创建与使用,QLibrary动态加载库

- Verilog基础:强度建模(二)

- Python函数进阶与文件操作

- U-Boot 命令解析(一)

- 如何利用宝塔面板和docker快速部署网站