Transformer and Pretrain Language Models3-3

发布时间:2024年01月22日

insights of attention注意力机制的特点

我们引入的attention机制到底给端到端的模型带来了什么变化?

1、信息瓶颈问题:注意力机制的出发点首先就是为了解决信息瓶颈问题而存在的,这样我们通过注意力机制decoder端在每次生成的时候,都可以直接关注到encoder端所有位置的信息,信息瓶颈的问题就可以有效地解决了

2、注意力机制同样很有效地缓解了RNN中的梯度消失的问题,它通过在encoder和decoder之间提供了一种直接连接方式,防止了梯度在RNN中会传播过长,进而导致梯度消失

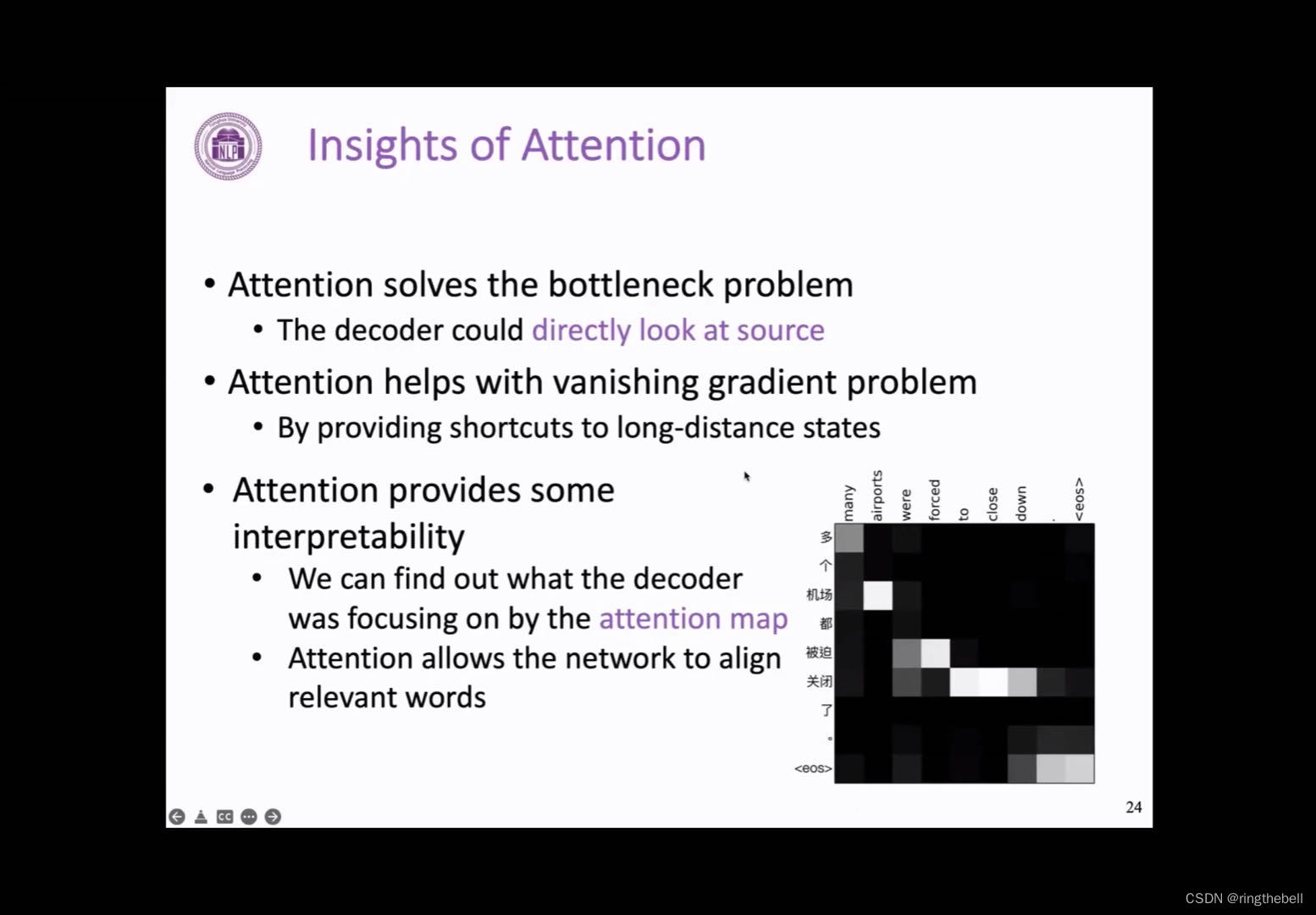

3、注意力机制也给神经网络这样一个黑匣子的模型,提供一定的可解释性,我们通过将decoder端每次的注意力分布可视化,我们可以画出右边这样的一个图,黑色表示注意力分数比较低,越接近白色,表示这个值越高。我们可以看到对于前面机器翻译的这样一个任务,注意力机制其实实现了一种短软对齐的策略,它翻译得到的英文单词会更加关注和表示相同含义的中文单词,比如这里的many更多和airport机场,这样的一个可视化,我们也可以发现模型在一定程度上,学习到这两个语言中一种语义的对齐关系,所以总体来看,注意力机制给RNN带来了很多有益的改变,而且极大地提高了RNN在不同的NLP任务上的表现

文章来源:https://blog.csdn.net/weixin_58810992/article/details/135732051

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- uni-table 固定表头与数据导出为xlsx

- 前端工程师常用的ChatGPT通用提示词模板

- 运维工程师要如何才能适应IT技术持续迭代更新

- 计算机毕业设计------企业ERP报销管理系统

- 官方教程:Stable Diffusion WebUI 绘画—GpuMall智算云

- 电脑数据删除了还能恢复吗?分享正确答案!

- 从CISC到RISC-V:揭开指令集的面纱

- 大模型微调总结1-总览

- 聚观早报 |长城汽车2023年销量;英特尔成立新AI软件公司

- 【Kimi帮我读论文】《LlaMaVAE: Guiding Large Language Model Generation via Continuous Latent Sentence Spaces》