CMU, UC Berkeley等团队结合神经辐射场的视触觉感知,用于手内操作

发布时间:2023年12月27日

为了实现人类水平的灵巧性,机器人必须从多模态感知到推理接触交互来推断空间意识。在手动操作新物体的过程中,这种空间意识涉及估计物体的姿势和形状。手部感知的现状主要采用视觉,并仅限于跟踪先验的已知物体。此外,在操作过程中,手头物体的视觉遮挡迫在眉睫,从而亟需操作触觉感知。

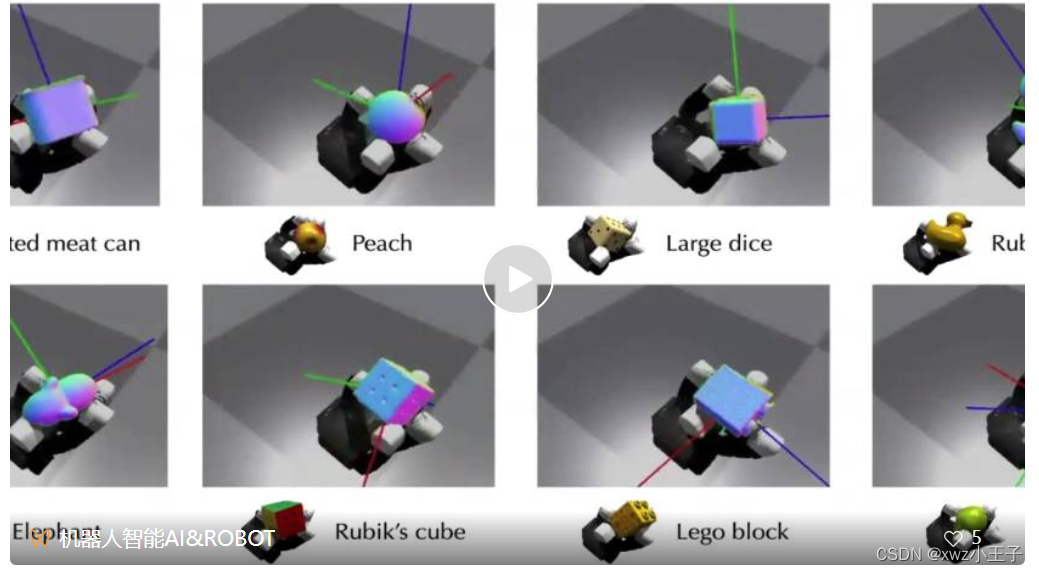

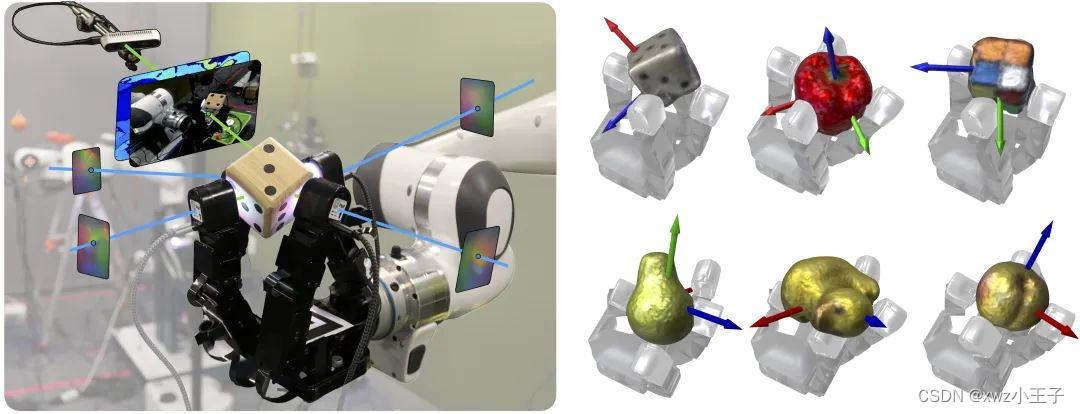

将视觉和触觉传感结合在多指手上,以估计物体在手操作过程中的姿势和形状。提出的方法 NeuralFeels 通过在线学习神经场对对象几何形状进行编码,并通过优化姿态图问题来共同跟踪它。

该论文研究了模拟和现实世界中的多模态手部感知,通过本体感觉驱动的策略与不同的物体进行交互。实验表明,最终重建分数81% 和平均姿态漂移4.7毫米,进一步简化为2.3毫米使用已知的 CAD 模型。

此外发现在严重的视觉遮挡下,与仅视觉方法相比跟踪改进可以达到94%。研究结果表明,触摸至少可以改善手部操作过程中的视觉估计,并且最好是消除视觉估计的歧义。该工作发布了包含 70 个实验的评估数据集 FeelSight,作为该领域基准测试的一步。由多模态传感驱动的神经表征可以作为提高机器人灵巧性的感知基础。

文章来源:https://blog.csdn.net/weixin_44887311/article/details/135239489

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 使用lwip的perf进行测速TCP会有较多的duplicate ack的原因分析

- 菜鸟导入导出assetbundle

- 为什么pmp证书只能对标cspm二级证书?

- 算法 - 二分搜索法 / 二分法(704)

- 计算机组成原理第6章-(计算机的运算方法)【上】

- Hive实战:统计总分与平均分

- 基于Java的救援物资管理系统(源码+开题)

- VR思政情景实训教学

- netty-daxin-4(http&websocket)

- 中国电子学会2020年9月份青少年软件编程Scratch图形化等级考试试卷B一级真题(含答案)