机器学习笔记二——强化学习

一、什么是强化学习

????????强化学习就是让智能体可以独立自主的完成某个任务。独立自主指的就是不需要人去指挥。

????????比如扫地机器人,打开开关就会自动去清理。自动驾驶的汽车,在定好目的地后,可以自动安全达到目的地。

????????强化学习的过程

????????Agent(智能体)——产生Action(行动)——Environment(环境)——产生new state(状态)以及reward(奖惩)——返给Agent

????????强化学习的本质:学习的是一种策略Policy,如何去选择行为,如何确定下一步的动作。

二、Action与Reward

????????Action就是具体的行为。比如扫地机器人可以向前、向后、向左、向右、吸尘等行为。

????????动作空间就是智能体能够做出的动作的数量。比如上面就是5个。

????????Reward智能体在某个state下完成某个action后环境给出的反馈。将这个效果反馈作为一个数值表达,就是奖惩。大于零鼓励,小于零惩罚。比如扫地机器人扫干净灰尘+1,撞到墙-1等。

????????以奖励为引导,期望智能体做出获得奖励更多的动作。奖励的设定是人为的,主观的,所以很多时候我们可以对奖励的方式进行一定的修正,去加速机器学习的过程。

三、分类

? ? ? ? model base——基于模型,这个模型是指上一刻的状态与下一刻的状态之间的概率分布关系

? ? ? ? model free——无模型(这种多)

四、马尔科夫链

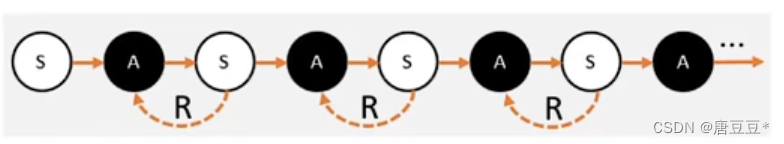

????????智能体在环境中观察到状态S——状态S被输入到智能体,智能体经过计算选择动作A——动作A使得智能体进入到另一个状态S',并返回奖励R给智能体——智能体根据返回,调整策略。重复以上步骤就可以创造马尔科夫链

? ? ? ? 这里有两个不确定性:

????????1.选择动作的过程,即智能体的策略Π,任务是找到一个策略,获得最多的奖励

? ? ? ? 2.环境的随机性,同一个action可能会反馈有不同的State或Reward

五、Q值和V值

????????很多问题中,并不能单纯通过R来衡量动作好坏,而需要用到长远的眼光,比如下围棋。所以需要把未来的Reward也计算到当前的状态下来,再进行决策。

????????为此需要用一种方法衡量智能体做出每一种选择的价值,这中间包括未来的价值。

? ? ? ? 评估动作的价值称为Q值。智能体选择这个动作后,一直到最终状态奖励总和的期望。

? ? ? ? 评估状态的价值称为V值。智能体在这个状态下,一直到最终状态的奖励总和的期望。

? ? ? ? 价值越高,从当前状态到最终状态能获得的平均奖励就会越高。则只需选择价值更高的动作就可以。

六、V值具体指什么,怎么算

要求某种状态S下得V值:

假定从状态S出发——按照策略Π选择不同的行为A,在按照不同的行为继续往下获得不同的状态——每条路径一直往下走到最终状态,可以获得所有的奖励总和——再得到奖励的平均值即为我们要求的V值。

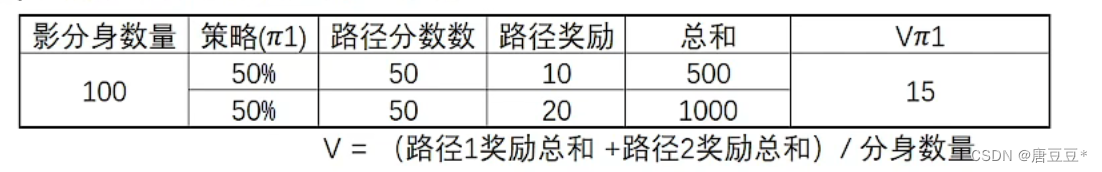

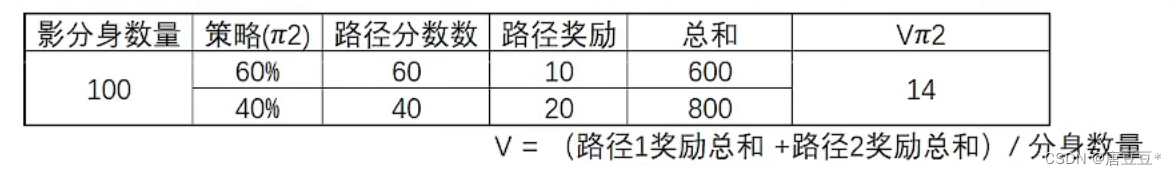

策略Π不同,V值会有所不同。

例如策略Π1对应的动作A1为50%,A2为50%,A1对应往下的路径奖励综合为10,A2对应往下的路径奖励总和为20,则相应的V值为15。

若策略Π2对应的动作A1为60%,A2为40%,A1对应往下的路径奖励综合为10,A2对应往下的路径奖励总和为20,则相应的V值为(10*60%+20*40%)=14。

七、Q值怎么算

V值和Q值都是指价值,不同的是V值指的是某状态节点的价值,Q值指的是某动作节点的价值。

即:某个状态下一个动作A的Q值——从某个状态选取动作A,走到最终状态很多次,最终获得奖励总和的平均值就是Q值。Q值与策略无直接相关,与环境的不确定性有关

八、V就是子节点的Q的期望,Q是子节点的V的期望

持续更新中~

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!