梯度消失是什么意思

发布时间:2024年01月23日

梯度

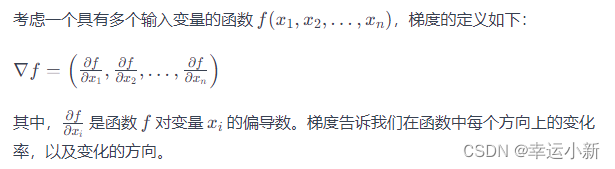

在数学和计算机科学中,梯度是一个向量,表示函数在某一点处的变化率和变化的方向。梯度是多变量函数的偏导数组成的向量。

在机器学习中,梯度也被称为损失函数对模型参数的偏导数。当我们训练一个模型时,通过梯度下降法或其变种,我们尝试最小化损失函数。梯度指示了在当前参数值下,损失函数增加最快的方向,因此我们沿着梯度的负方向更新参数,以逐步减小损失函数的值。

形象地说,梯度是一个指向最快上升的方向。通过在梯度的反方向上移动,我们可以寻找损失函数的局部最小值,这是优化过程的核心思想。

梯度消失

梯度消失是指在深度神经网络中,反向传播过程中梯度逐渐变得非常小,甚至趋近于零的现象。这会导致深层网络的参数难以更新,使得模型无法学到有效的表示,从而影响模型的性能。

在反向传播中,梯度是损失函数对于网络参数的偏导数。当梯度非常小的时候,参数更新的幅度也很小,这样网络学习的速度就会减缓,甚至停滞。如果梯度变得足够小,网络的权重就几乎不再更新,这被称为梯度消失。

梯度消失主要发生在深度神经网络中,其中包含多个层次(深度)。在传统的梯度下降优化算法中,梯度通过层层传递,而每一层的权重都需要根据其梯度进行更新。由于深层网络的复杂性,梯度可能在传递过程中逐渐变小,最终变得非常接近零。

梯度消失问题限制了神经网络的深度,因为随着层数增加,梯度消失的概率也会增加。为了缓解梯度消失,引入了一些技术,如残差连接(Residual Connection)、梯度裁剪(Gradient Clipping)、使用适当的激活函数等。这些方法旨在使梯度的传递更加稳定,从而允许更深层次的网络训练。

、

文章来源:https://blog.csdn.net/m0_72232218/article/details/135784649

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!