【书生·浦语大模型实战营05】《(5)LMDeploy 大模型量化部署实践》学习笔记

发布时间:2024年01月22日

《(5)LMDeploy 大模型量化部署实践》

课程文档:《LMDeploy 的量化和部署》

1、大模型部署背景

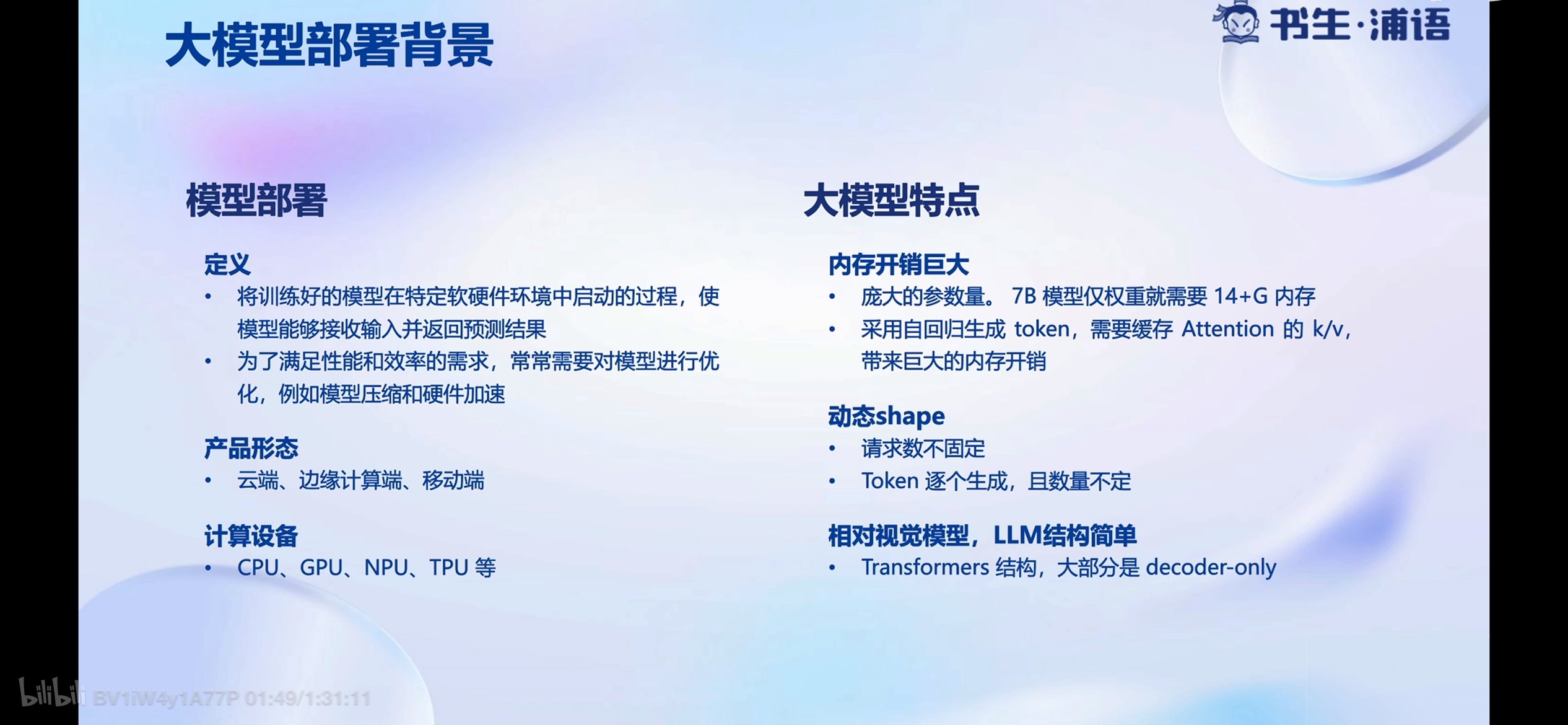

1.1 模型部署

定义

- 将训练好的模型在特定软硬件环境中启动的过程,使模型能够接收输入并返回预测结果

- 为了满足性能和效率的需求,常常需要对模型进行优化,例如模型压缩和硬件加速

产品形态

- 云端、边缘计算端、移动端

1.2 大模型特点

内存开销巨大

- 庞大的参数量。7B模型仅权重就需要14+G显存

- 采用自回归生成 token,需要缓存Attention的k/v,带来巨大的内存开销

1.3 大模型部署挑战

设备

- 如何应对巨大的存储问题?低存储设备(消费级显卡、手机等)如何部署?

推理

- 如何加速token的生成速度

- 如何解决动态shape,让推理可以不间断

- 如何有效管理和利用内存

2、LMDeploy简介

LMDeploy是LLM在英伟达设备上部署的全流程解决方案。包括模型轻量化、推理和服务。

LMDeploy是LLM在英伟达设备上部署的全流程解决方案。包括模型轻量化、推理和服务。

项目地址:https://github.com/InternLM/lmdeploy

1.1 接口

python & gRPC & RESTful

文章来源:https://blog.csdn.net/songyuc/article/details/135738212

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 云卷云舒:浅析云数据库架构的分层设计

- SpringBoot实用开发(四)-- RedisTemplate 常用API

- Win11桌面路径改为其他盘的简单教程

- 构建可扩展的网校平台:在线教育系统源码设计与架构最佳实践

- PACS源码,数字化影像信息系统源码,带三维影像后处理技术

- 在Vue表格里写入一个缩略图,并且点击缩略图时,弹出窗口会显示对应的大图

- rabbit MQ生产环境通过管理界面创建交换机踩坑记录

- 海外住宅IP代理的工作原理和应用场景分析,新手必看

- iPhone手机中备忘录如何改变字体颜色

- AUTOSAR StbM模块的配置以及代码实现