AI大模型开发架构设计(2)——AI绘画技术架构&应用实践

发布时间:2024年01月20日

1 AI绘画整体流程

- 第一步:输入 Prompt 提示词:

/mj 提示词 - 第二步:文生图(Text-to-Image)构图

- 第三步:图片渲染

- 第四步:图片展示

2 AI绘画技术架构

文生图核心算法原理

- 把人类创造的内容用一个高维的数学向量进行表示

- 如果内容到向量的“翻译”足够合理且能代表内容的特征,人类所有的创作内容都可以转化到空间里的向量。

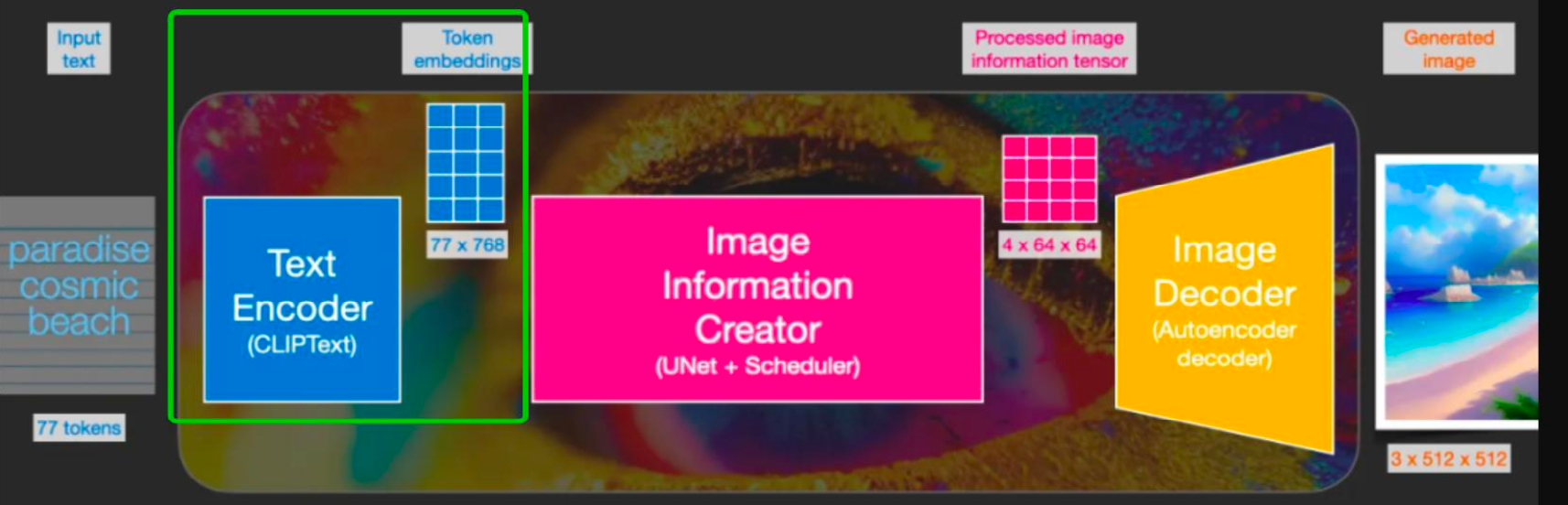

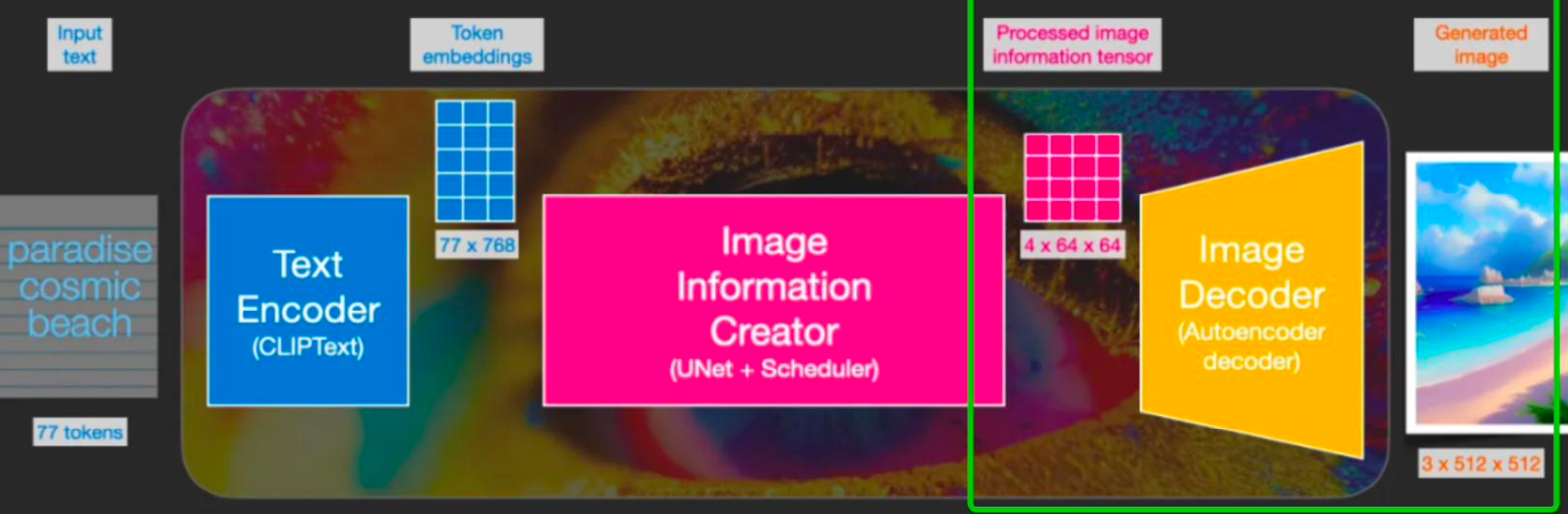

- 文生图整体可以分为三个部分:Language Model(语言模型)、Diffusion Model(扩散模型)、Decoder Model(解码模型)。

Language Model(语言模型)→Text Encoder(文本编码)

- Language Model 是将输入的 Prompt 文本提示词转化为可以输入到 Diffusion Model 使用的表示形式,通常使用 Embedding 加上一些 Radom Noise 输入到下一层。

Diffusion Model(扩散模型)→Image Information Creator

- 它是一个时间条件 U-Net(用于图像分割的深度学习架构),它将文本表示和一些高斯噪音作为模型输入,将对应的图像添加一些高斯噪音,得到一个有点噪点的图像,在时间上重复这个过程,重复几百次后就可以获得完全嘈杂的图像。

- 这么做的过程,记录每个步骤的图像版本,用训练的 NN 就可以将噪声较大的示例作为输入,预测输出新图像。

Decode Model(扩散模型)→放大 Diffusion Model 的输出到完整图像

- 它获得 Diffusion Model 的输出并放大到完整图像。

- 比如:扩散模型在 64 X 64 PX 上训练,解码模型将其提高到 512 X 512 PX。

训练Encoder模型

- 在训练过程中,还有一个 Encode Model,它是 Decoder Model 的对应部分,它的目标是将输入图像转化为具有高语义意义的缩减采样表示,会消除与图像不太相关的高频视觉噪声。

- Encoder Model 和 Diffusion Model 训练分开,采用 Encoder Model 后的图像作为 Diffusion Model 的输入,就可以在图像空间的训练比原始图像计算少64倍,大大节省了计算成本。

- 训练模型的训练&推理是计算最贵的部分。

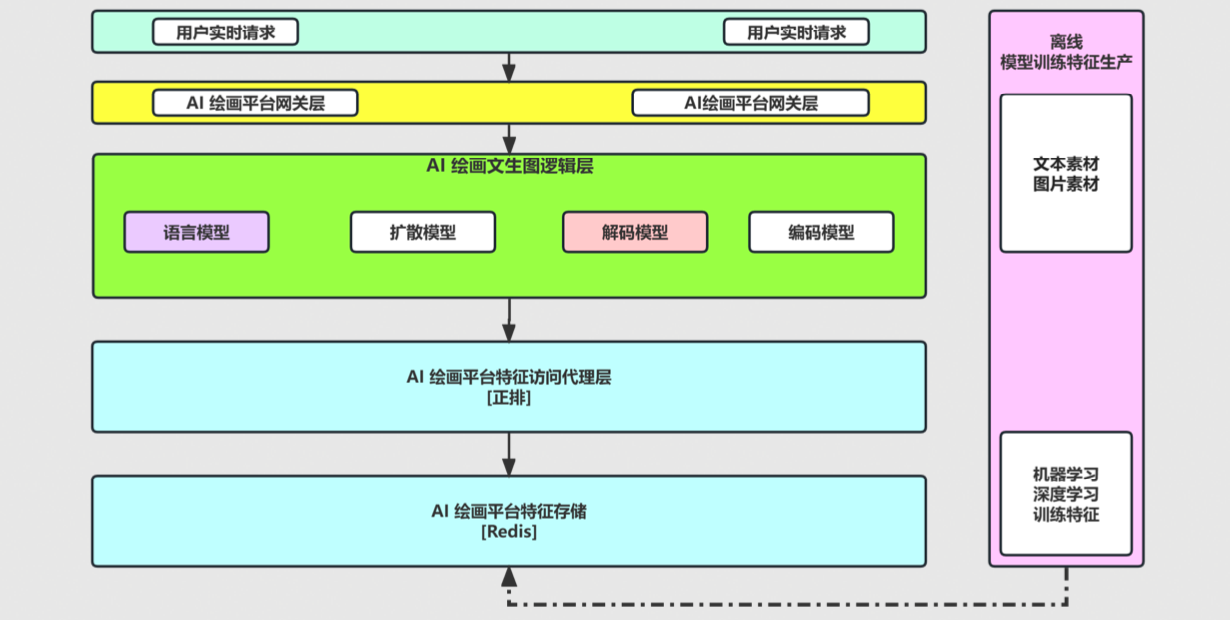

文生图工程架构

- 微服务 + 云原生实时弹性计算和扩容架构

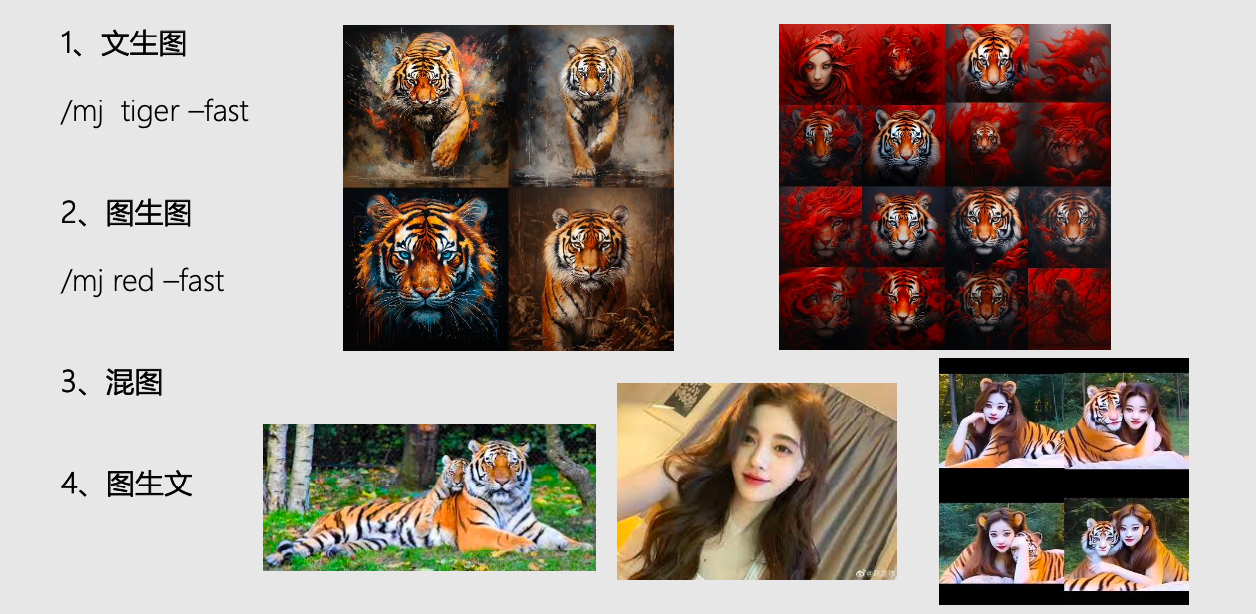

3 AI绘画的应用实践

- 多模态的支持能力:文生图 + 图生图 + 图生文

文章来源:https://blog.csdn.net/yangwei234/article/details/135712713

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!