以<SegVol>为模板研究一篇论文的写作模式及方法内容

Abstract

体积图像分割的意义(做这个事情的意义)。目前针对这个事情/方向的局限性,所以提出了自己的创新点<SegVol>,简单描述这个模型,并给出分割结果。

如果有比目前主流模型高的多的得分,可以在这个写上。最后给出github地址。

1 Introduction

阐述体积图像分割目前的应用领域及现有解决方案。阐述现有解决方案的局限性。克服局限性,引入了我们的模型,简要概括模型并给出模型的主要特性。

讲解对模型的验证(通过几个不同的数据集),给出评分(可添加一些实验比如烧蚀研究来验证放大放大机制的有效性)。

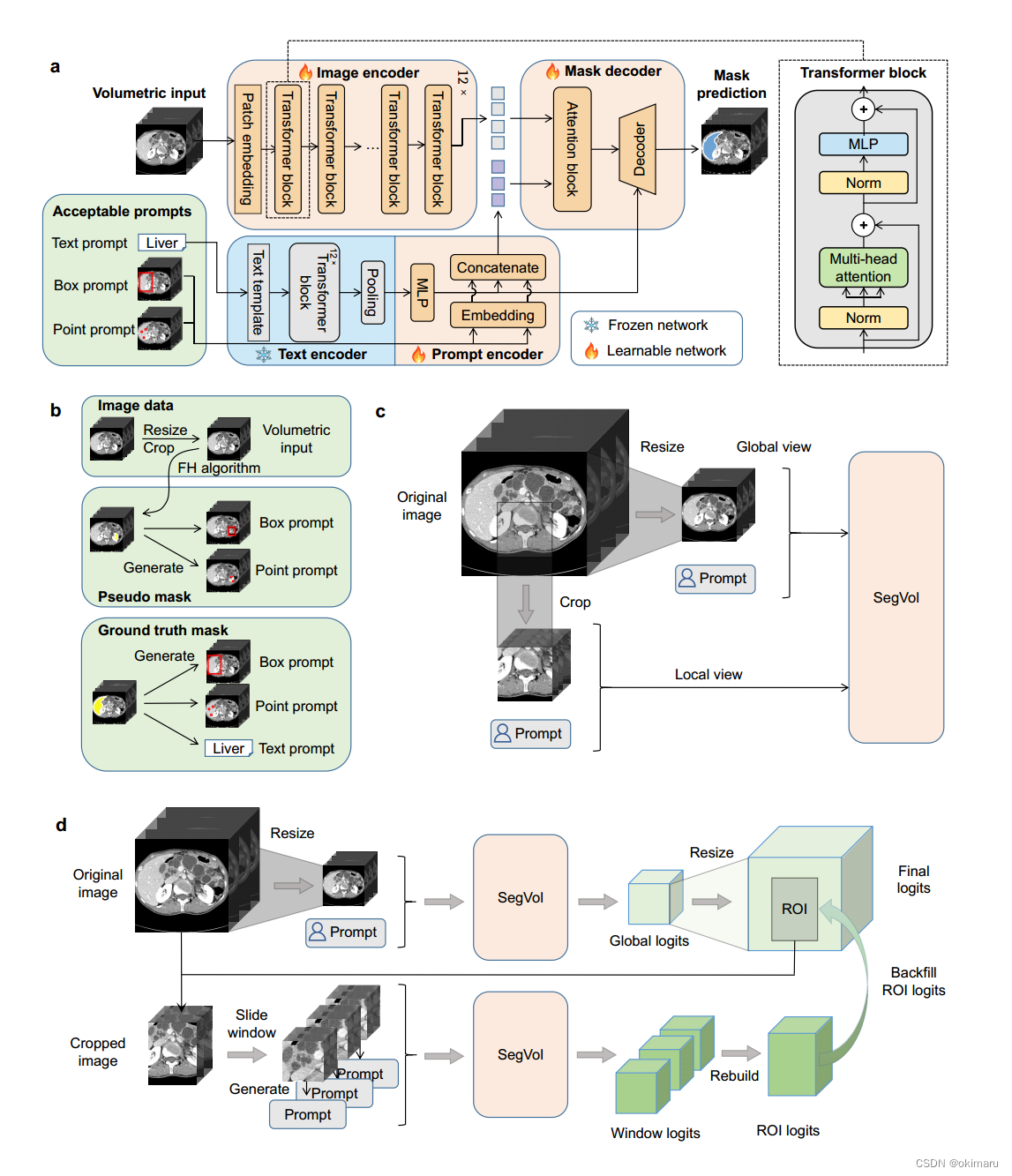

图1 模型架构(配文讲解)

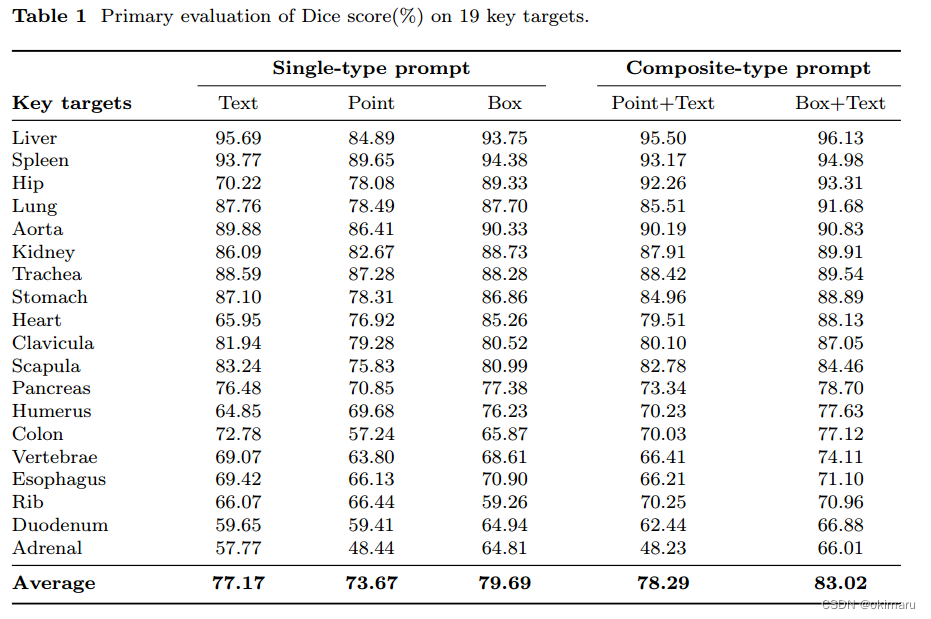

表1 对于19个数据集使用五种类型的标签进行分割,并得出最终平均准确率

2 Results

目前图像分割面临的挑战。提出<SegVol>这个模型,利用这个模型得到了xxx的结果,引入了xxx创新点,其中用到了xxx数据集来进行这个实验,对模型进行评估分析。

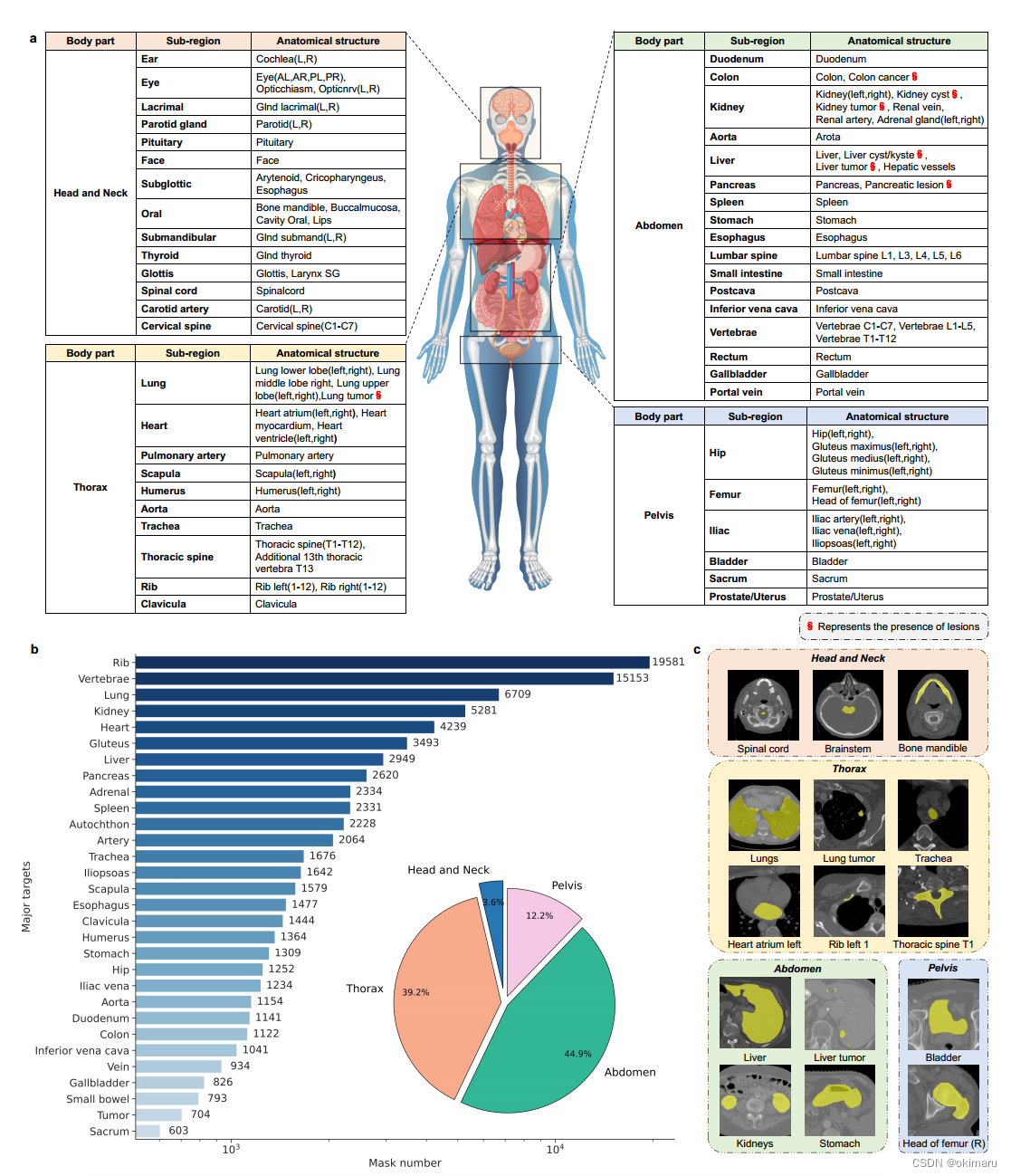

2.1 Dataset Exploration

解释数据集的来源,具体数量和内容。

在训练和测试中,我们使用了xxx数据集(具体数量),使用了xxx方法对数据集进行预处理,使用xxx方法进行模型的预训练。

具体分析数据集,包括mask标签。

详细解释在训练和测试的过程中,数据集和测试集的比例,使用Dice score作为度量标准。具体解释DSC。

图2 数据集在人体的分布、饼图以及数据集切片

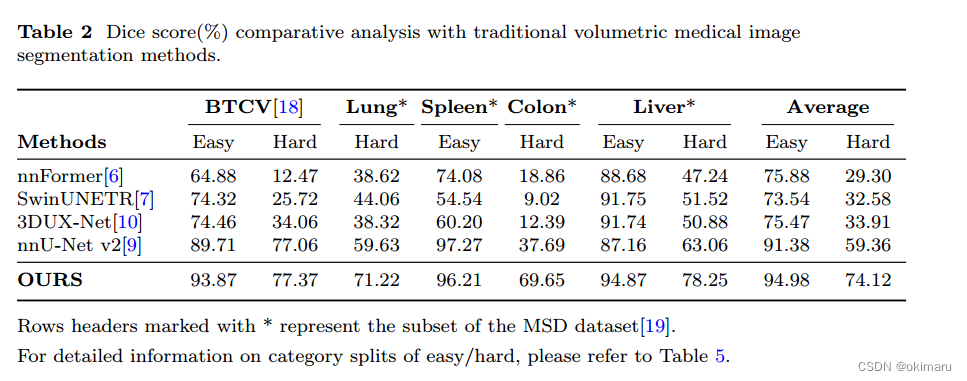

表2 【对比试验】使用不同模型在不同的器官上分割的dice score

2.2 Segmentation Results of Major Targets

对表2中的的数据进行分析

2.3 Performance Comparison with Baseline Models

需要一个基线模型进行对比。这篇文章使用nnU-net作为基线模型,该模型在传统的医学体素图像分割模型中表现出最强的分割能力。

SegVol分割这些具有挑战性的病变的能力明显优于nnU-net。

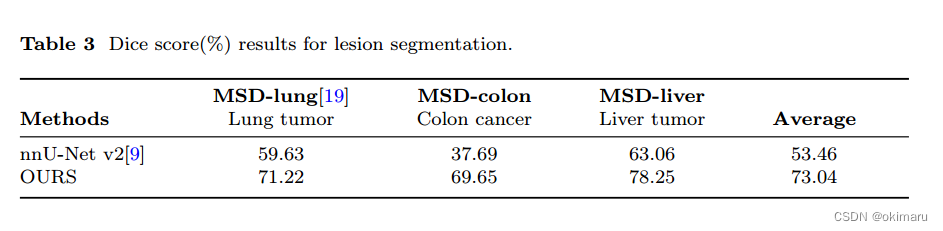

表3 三个病变数据集在基线模型和SegVol上的dice score

分析数据集分割结果,并给出使SegVol显著优于传统模型的因素。

2.4 Evaluating Lesion Segmentation Capability

评估病灶分割能力

病灶分割精准度的意义,以及针对性选择数据集作为评判标准的理由。

总之就是总结不同模型对数据集的分割结果和能力。

2.5 Ablation study

2.5.1 Zoom-out-zoom-in Mechanism

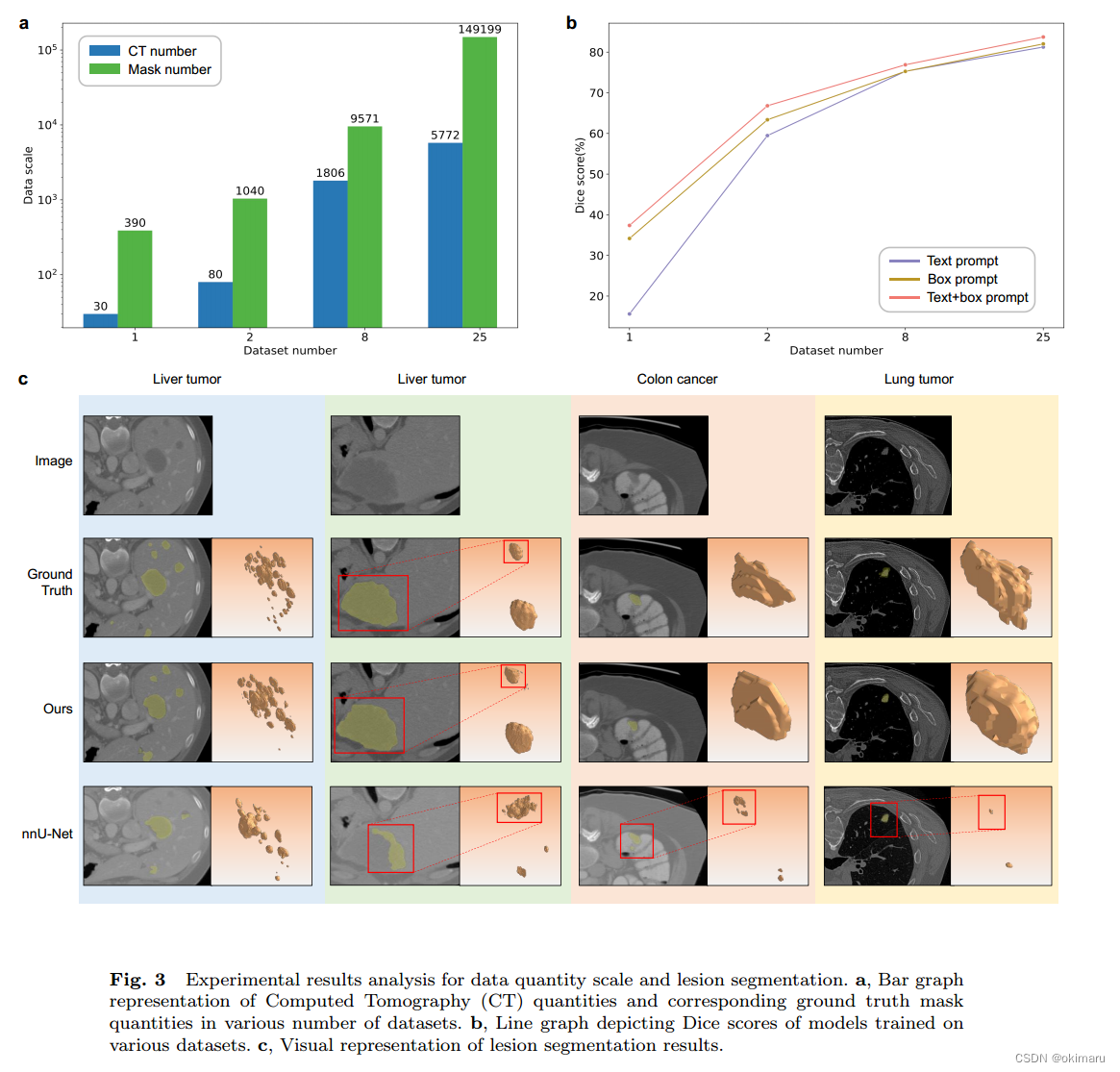

图(c)给出了一系列示例,展示了nnUnet和本文方法的病变分割性能,这些例子包括肝肿瘤、结肠癌和肺肿瘤<给出具体的数据集图片及分割后的结果>

使用了消融实验,并解释使用消融实验的好处

2.5.2 Dataset Scale

阐述数据集的数据规模大小,并说明数据规模对dice score造成的影响

3 Discussion

总结整篇文章,还是围绕SegVol这个模型,讲解该模型的优越性。

4 Method

4.1 Data Processing

4.1.1 Data Collection and Normalization

解释数据集的来源,以及为了标准化数据集做的操作和方法。

4.1.2 Pseudo Mask Generation and De-noising

伪掩码生成与降噪体分割数据集存在着严重的部分标签问题

问题现状,提出了解决方案<利用Felzenswalb-Huttenlocher (FH)[17]算法为每次CT扫描中的大多数物体生成伪掩码。>并说明FH算法

4.2 Model Architecture

传统模型对数据集分割的局限性,提出了SegVol模型,并详细解释其架构。

4.3 Training procedure

讲解训练过程,引入了创新点——点”提示,“框”提示和“文本”提示。

讲解使用到的loss function。

4.4 Zoom-out-zoom-in Mechanism

阐述使用该机制的理由

具体罗列使用了哪些方法

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 新品发布 | 多通道总线记录仪TLog1004,是你期待的吗?

- AIGC-无人直播系统技术源头

- 深入理解和运用C语言中的Break语句

- Qt之QByteArray大小写字母转化

- java IO流-处理流

- 【LeetCode-406】根据身高重建队列(贪心)

- Linux中关于rpm管理包命令详解

- elementui中的el-table,当使用fixed属性时,table主体会遮挡住滚动条的大半部分,导致很难选中。

- 云卷云舒:云原生业务应用成熟度模型

- (四)pytorch图像识别实战之用resnet18实现花朵分类(代码+详细注解)