多任务学习(Multi-task Learning)的详细过程和具体示例

发布时间:2023年12月19日

1.多任务学习的基本思想

多任务学习(Multi-task Learning)是一种机器学习的方法,它可以同时解决多个相关任务。

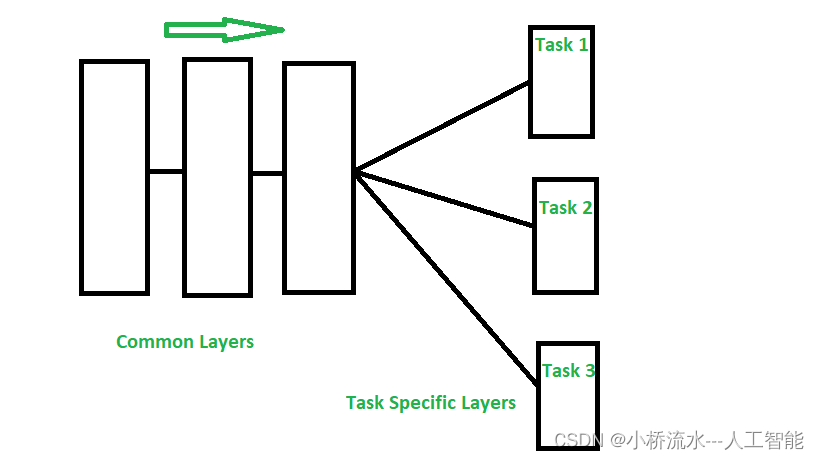

多任务学习的基本思想是:多个任务之间存在一定的相关性或公共特征,我们可以利用这些公共知识来提升各个任务的学习效果。

2. 多任务学习的过程包括:

-

定义多个相关任务。这些任务应该

存在一定程度的重合,比如使用相同的输入特征,或模型结构存在部分共享。 -

构建一个共享的模型,这个模型包含多个任务专用的输出层,以及底层的公共特征提取层。 -

同时为所有任务定义损失函数。损失函数衡量每个任务的预测结果与真实值的差异。 -

使用一个优化算法(如SGD、Adam等),来最小化所有任务的损失函数的总和。在此过程中,模型参数会根据所有任务的损失函数进行更新,从而同时学习多个任务。 -

训练结束后,

模型可以同时解决所有任务的预测问题。

3. 多任务学习的具体例子:

-

图像分类和检测:分类预测图像类别,检测预测边界框。共享卷积特征提取层,但输出层不同。 -

文本分类和摘要:分类预测标签,摘要生成文本。共享词向量层和RNN编码器,但分类使用FC层,摘要使用解码器。 -

语音识别和语言模型:识别预测字符,语言模型预测下一个字符。共享声学模型层,但输出层不同。 -

机器翻译和语言模型:翻译预测目标语词,语言模型预测下一个词。共享编码器,但解码器不同。

文章来源:https://blog.csdn.net/qlkaicx/article/details/135086170

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 迈入AI智能时代!ChatGPT国内版免费AI助手工具 peropure·AI正式上线 一个想法写一首歌?这事AI还真能干!

- 使用ArcMap进行实测数据处理

- 《系统架构设计师教程(第2版)》第4章-信息安全技术基础知识-04-信息安全的抗攻击技术

- 推荐5款提高工作效率和质量的软件

- python期刊稿件在线投稿系统q2ud0

- Node.js安装部署

- 【Py/Java/C++三种语言详解】LeetCode每日一题240122【贪心】LeetCode670、最大交换

- 【人工智能】之深入了解嵌入模型中的 Token:NLP 中的语义之旅(1)

- 十二:爬虫-Scrapy框架(上)

- Nginx 一个端口同时支持 http 和 https协议【详细步骤】