爬虫工作量由小到大的思维转变---<第三十三章 Scrapy Redis 23年8月5日后会遇到的bug)>

发布时间:2023年12月28日

前言:

收到回复评论说,按照我之前文章写的:

爬虫工作量由小到大的思维转变---<第三十一章 Scrapy Redis 初启动/conn说明书)>-CSDN博客

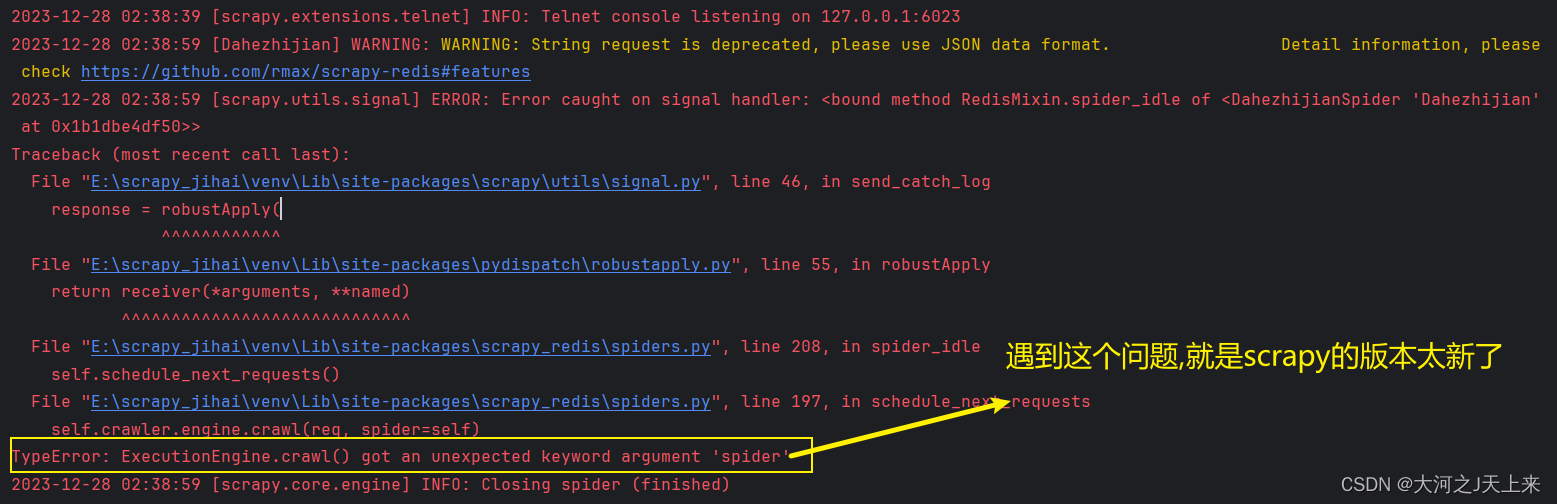

在启动scrapy-redis后,往redis丢入url网址的时候遇到:

TypeError: ExecutionEngine.crawl() got an unexpected keyword argument 'spider

整得人都崩溃了....

好嘛,来解决这个问题!

正文:

代码

__author__ = '大河之J天上来'

from scrapy import cmdline

from scrapy_redis.spiders import RedisSpider

class DahezhijianSpider(RedisSpider):

name = "Dahezhijian"

redis_key = 'da:he'

def parse(self, response):

print(response.text)

if __name__ == '__main__':

cmdline.execute(['scrapy','crawl','Dahezhijian'])还原问题(截图):

问题追溯:

1.查看版本:

我用的版本是:

也就是2023年12月28日的最新版~ 也会遇到这个问题!!!

2.追踪更新:

scrapy的最新版是2023.9.18 (真特么会挑日子! 918,我才看到! 以后我都不用这版本了...)

而scrapy_redis的最新版是:(2022年7月26日)

----相差了1年零2个月,我估计明年1到2月 redis要更新了的..

3.莫问别人,先管自己:

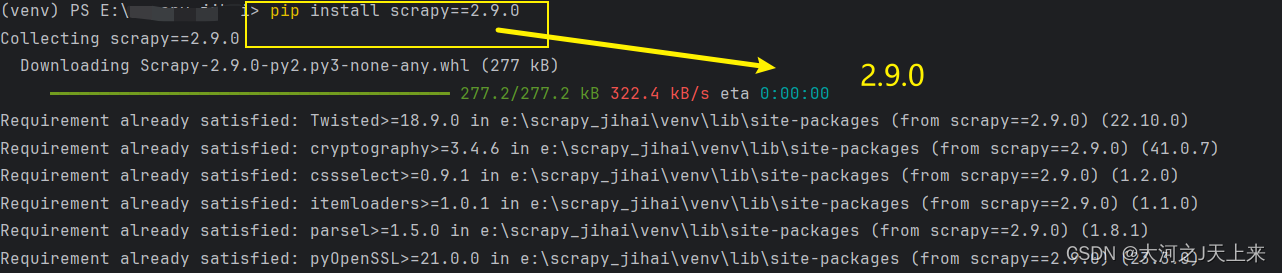

我帮大家测试过了,>=2.10.0现在都不兼容scrapy_redis;?

直接

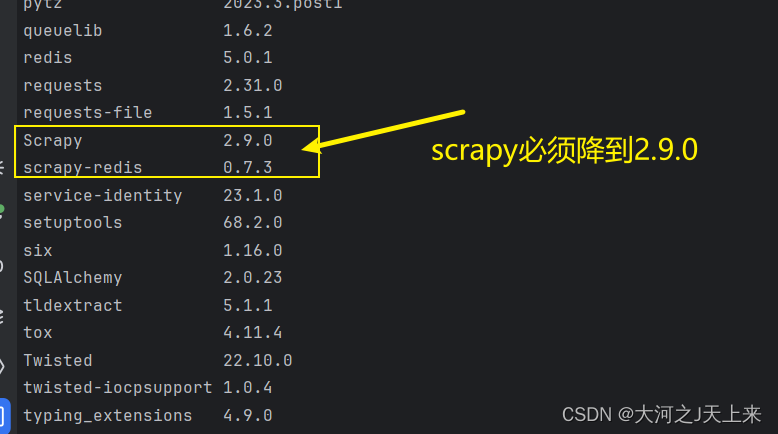

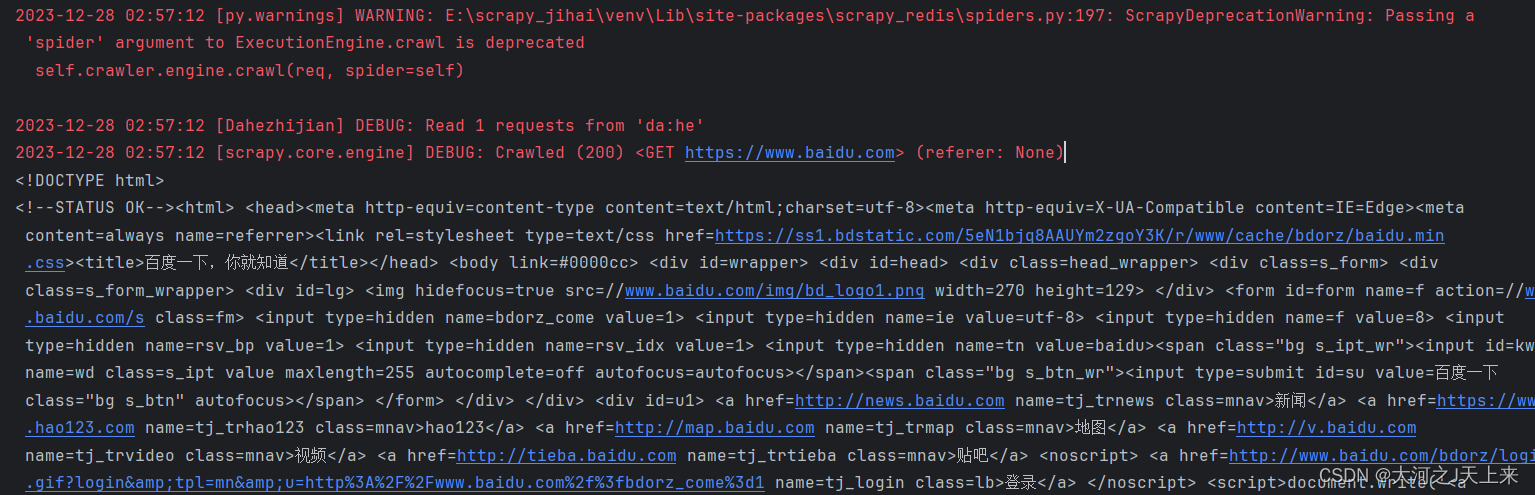

4.最终搭配:

成功!!!

文章来源:https://blog.csdn.net/m0_56758840/article/details/135259280

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- Vue2面试题:说一下对vuex的理解?

- 【Android】完美解决Cannot resolve method ‘subscribe(Observer<T>)‘

- 3D视觉-结构光测量法

- Springboot 全局时间格式化

- 【电子通识】各国电源插头标准和电压标准

- Unity中向量的点乘、叉乘区别和作用以及经典案例

- Flask 小程序菜品搜索

- POWER DRIVER FOR BLDC/PMSM MOTORS---TMC6200

- js面试题

- 如何在 Python 的文档中写测试 - doctest 指南