每天五分钟计算机视觉:网络中的网络(NiN)

发布时间:2023年12月18日

本文重点

前面的课程中我们学习了众多的经典网络模型,比如LeNet、AlexNet、VGG等等,这些网络模型都有共同的特点。

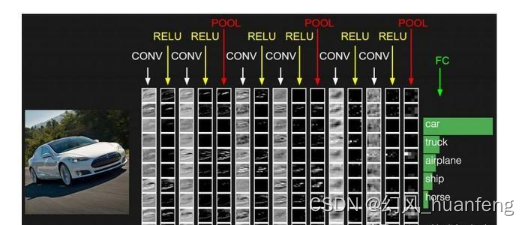

它们的特点是:先由卷积层构成的模块充分提取空间特征,然后再由全连接层构成的模块来输出分类结果。也就是说它们都是下面的这种效果,先卷积后全连接:

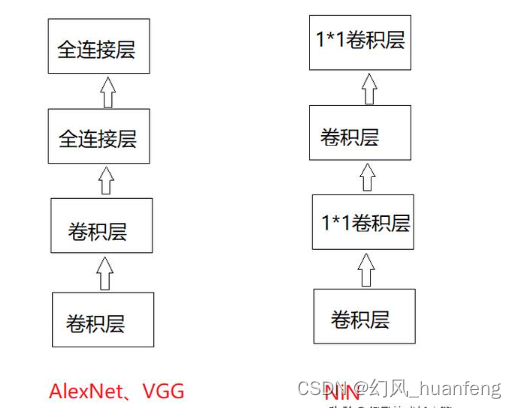

它们的不同在于对卷积层中卷积核的大小以及卷积层的层数进行了改变,其它的变化不大。而本文我们将学习另外一个思想的卷积神经网络,这个卷积神经网络就是NiN,它的思想是:串联多个由卷积层核全连接层构成的小网络来构成一个深层网络。

1*1卷积核的应用

卷积层的输入和输出的维度信息通常是(样本、通道、长、宽)。而全连接层的输入和输出通常是二维数组(样本,特征)。

所以维度不一样,就无法让全连接层之后连上卷积层,这里我们可以使用1*1的卷积层,前面我们学习过1*1的卷积层可以看成是全连接层,使用1*1的卷积层使得空间信息自然的传递到后面的层中去。

NiN模型

不用怎么来介绍这两个模型的不同,只需要看这个图就可以看出二者的不同。

AlexNet和NiN

NiN和AlexNet比较相似,它是在AlexNet之后被提出来的,这里我们对二者做一个简单的区别:

NiN去掉了AlexNet最后的3个全连接层,它使用了输出通道数与分类类别数相等的NiN块,然后使用全局平均池化层对每个通道中的所有元素求平均并直接用于分类。这样可以有效的减少模型的参数尺寸,从而缓解过拟合问题,当然坏处就是会增加模型的训练时间。

文章来源:https://blog.csdn.net/huanfeng_AI/article/details/135052642

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 利用Pandas进行高效网络数据获取

- 2024 Python开发者转型Go开发

- 本科生自学PYTHON路线

- 每日一题:实现一个类,其实例可以链式调用,他有一个sleep方法,可以sleep一段时间后再后续调用

- 【C++初阶】第二站:类与对象(上) -- 下部分

- python+pytest接口自动化测试之参数关联

- 排序之快速排序

- 企业怎么传输大容量视频?

- 私域2.0大变革:构建用户亲密关系,让你的品牌脱颖而出!

- uni-app 中使用定时器和取消定时器