第八章 常见Linux命令

第八章 常见Linux命令

学习目标

1 熟练文件目录类命令

2 熟悉用户管理命令

3 熟悉组管理命令

4 熟练文件权限命令

5 熟悉搜索查找类命令

6 熟练压缩和解压缩命令

7 熟练进程线程类命令

8 了解磁盘分区类命令

第一节 文件目录类命令

(1)pwd(print working directory )打印当前目录的绝对路径

-

基本语法

- pwd (功能描述:显示当前工作目录的绝对路径)

-

案例实操

- 显示当前工作目录的绝对路径

[root@hadoop101 ~]# pwd /rootls

(2)ls(list) 列出目录内容

-

基本语法

- ls [选项] [目录或是文件]

-

选项说明

选项 功能 -a (all) 全部的文件,连同隐藏档( 开头为 . 的文件) 一起列出来(常用) -l (long) 长数据串列出,包含文件的属性与权限等等数据;(常用) -

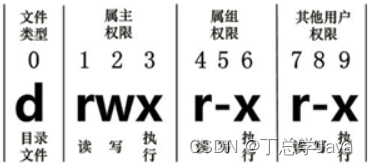

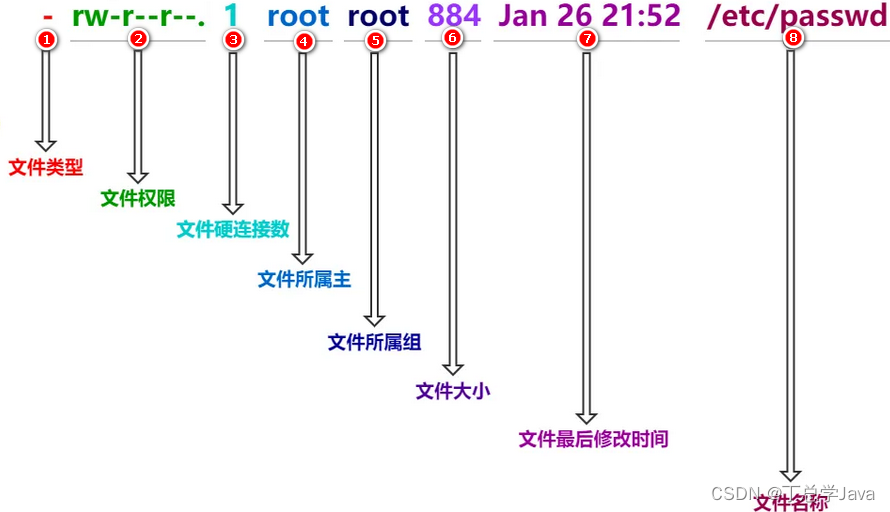

显示说明

每行列出的信息依次是: 文件类型与权限 链接数 文件属主 文件属组 文件大小用byte来表示 建立或最近修改的时间 名字

-

实操案例

- 查看当前目录的所有内容信息

[atguigu@hadoop101 ~]$ ls -al 总用量 44 drwx------. 5 atguigu atguigu 4096 5月 27 15:15 . drwxr-xr-x. 3 root root 4096 5月 27 14:03 .. drwxrwxrwx. 2 root root 4096 5月 27 14:14 hello -rwxrw-r--. 1 atguigu atguigu 34 5月 27 14:20 test.txt

(3)cd(Change Directory)切换路径

-

基本语法

- cd [参数]

-

参数说明

参数 功能 cd /绝对路径 切换路径 cd相对路径 切换路径 cd ~或者cd 回到自己的家目录 cd - 回到上一次所在目录 cd … 回到当前目录的上一级目录 cd -P (PathName) 跳转到实际物理路径,而非快捷方式路径 cd / 回到系统根目录 -

实操案例

- 使用绝对路径切换到root目录

[root@hadoop101 ~]# cd /root/- 使用相对路径切换到“公共的”目录

[root@hadoop101 ~]# cd 公共的/- 表示回到自己的家目录,亦即是 /root 这个目录

[root@hadoop101 公共的]# cd ~- cd- 回到上一次所在目录

[root@hadoop101 ~]# cd -- 表示回到当前目录的上一级目录,亦即是 “/root/公共的”的上一级目录的意思;

[root@hadoop101 公共的]# cd ..

(4)mkdir(Make directory) 建立目录

-

基本语法

- mkdir [选项] 要创建的目录

-

选项说明

选项 功能 -p(parents) 创建多层目录 -

实操案例

- 创建一个目录

[root@hadoop101 ~]# mkdir xiyou [root@hadoop101 ~]# mkdir xiyou/mingjie- 创建一个多级目录

[root@hadoop101 ~]# mkdir -p xiyou/dssz/meihouwang

(5)rmdir(Remove directory) 删除目录

-

基本语法

- rmdir 要删除的空目录

-

实操案例

- 删除一个空的文件夹

[root@hadoop101 ~]# rmdir xiyou/dssz/meihouwang

(6)touch 创建空文件

-

基本语法

- touch 文件名称

-

实操案例

[root@hadoop101 ~]# touch xiyou/dssz/sunwukong.txt -

注意事项

vim也可以创建文件,vim atguigu.txt 进入编辑模式,然后输入内容保存退出即可,但是如果不输出内容直接空文件下退出,则不会创建文件

(7)cp (copy) 复制文件或目录

-

基本语法

- cp [选项] source dest (功能描述:复制source文件到dest)

-

选项说明

选项 功能 -r(recursive) 递归复制整个文件夹 -

参数说明

参数 功能 source 源文件 dest(destination) 目标文件 -

实操案例

- 复制文件

[root@hadoop101 ~]# cp xiyou/dssz/suwukong.txt xiyou/mingjie/- 递归复制整个文件夹

[root@hadoop101 ~]# cp -r a/b/ ./

(8)rm (remove) 移除文件或者目录

-

基本语法

- rm [选项] deleteFile

-

选项说明

选项 功能 -r(recursive) 递归删除目录所有内容 -f(force) 强制删除,不提示用户进行确认 -rf(recursive force) 递归地删除指定的目录及其所有子目录和文件,而不会询问用户是否确认删除 -v(verbose) 显示指令的详细执行过程 -

实操案例

- 删除目录中的内容

[root@hadoop101 ~]# rm xiyou/mingjie/sunwukong.txt- 递归删除目录中所有内容

[root@hadoop101 ~]# rm -rf dssz/

(9)mv(move)移动文件与目录或重命名

-

基本语法

- 重命名

mv oldNameFile newNameFile- 移动文件

mv /temp/movefile /targetFolder -

实操案例

- 重命名

[root@hadoop101 ~]# mv xiyou/dssz/suwukong.txt xiyou/dssz/houge.txt- 移动文件

[root@hadoop101 ~]# mv xiyou/dssz/houge.txt ./

(10)cat(concatenate)查看文件内容

-

基本语法

- cat [选项] 文件 查看文件内容,从第一行开始显示

-

选项说明

选项 功能描述 - n (numbers) 显示所有行的行号,包括空行 -

经验技巧

一般查看比较小的文件,一屏幕能显示全的 -

实操案例

- 查看文件内容并显示行号

[atguigu@hadoop101 ~]$ cat -n houge.txt

(11)more 文件分屏查看器

-

基本语法

more 要查看的文件 more display 更多显示more指令是一个基于VI编辑器的文本过滤器,它以全屏幕的方式按页显示文本文件的内容。more指令中内置了若干快捷键,详见操作说明。 -

操作说明

操作 功能说明 空白键 (space) 代表向下翻一页; Enter 代表向下翻『一行』; q (quit) 代表立刻离开 more ,不再显示该文件内容。 Ctrl+F (Forward) 向下滚动一屏 Ctrl+B (Backward) 返回上一屏 = 输出当前行的行号 :f (file format文件格式) 输出文件名和当前行的行号 -

实操案例

- (1)采用more查看文件

[root@hadoop101 ~]# more smartd.conf

(12)less 分屏显示文件内容

-

基本语法

less指令用来分屏查看文件内容,它的功能与more指令类似,但是比more指令更加强大,支持各种显示终端。less指令在显示文件内容时,并不是一次将整个文件加载之后才显示,而是根据显示需要加载内容,对于显示大型文件具有较高的效率。 less 要查看的文件 -

操作说明

操作 功能说明 空白键 向下翻动一页; [pagedown] 向下翻动一页 [pageup] 向上翻动一页; /字串 向下搜寻『字串』的功能;n:向下查找;N:向上查找; ?字串 向上搜寻『字串』的功能;n:向上查找;N:向下查找; q (quit) 离开 less 这个程序; -

实操案例

- (1)采用less查看文件

[root@hadoop101 ~]# less smartd.conf

(13)head显示文件头部内容

-

基本语法

head用于显示文件的开头部分内容,默认情况下head指令显示文件的前10行内容。 head 文件 (功能描述:查看文件头10行内容) head -n 5 文件 (功能描述:查看文件头5行内容,5可以是任意行数) -

选项说明

选项 功能 -n(number) <行数> 指定显示头部内容的行数 -

实操案例

- (1)查看文件的头2行

[root@hadoop101 ~]# head -n 2 smartd.conf

(14)tail 输出文件尾部内容

-

基本语法

tail用于输出文件中尾部的内容,默认情况下tail指令显示文件的后10行内容。 (1)tail 文件 (功能描述:查看文件后10行内容) (2)tail -n 5 文件 (功能描述:查看文件后5行内容,5可以是任意行数) (3)tail -f 文件 (功能描述:实时追踪该文档的所有更新) -

选项说明

选项 功能 -n(number)<行数> 输出文件尾部n行内容 -f (follow) 显示文件最新追加的内容,监视文件变化 -

实操案例

- (1)查看文件头1行内容

[root@hadoop101 ~]# tail -n 1 smartd.conf- (2)实时追踪该档的所有更新

[root@hadoop101 ~]# tail -f houge.txt

(15)echo 打印信息

-

基本语法

echo输出内容到控制台 System.out.println(); echo [选项] [输出内容] -

选项说明

选项 功能 -e 支持反斜线控制的字符转换 控制字符 作用 \\ 输出\本身 \n 换行符 \t 制表符,也就是Tab键 -

实操案例

- (1) 打印文字信息

[atguigu@hadoop101 ~]$ echo "hello\tworld" hello\tworld [atguigu@hadoop101 ~]$ echo -e "hello\tworld" hello world- (2) 打印环境变量

[atguigu@hadoop101 ~]$ echo $PATH

(16)> 覆盖和>>追加

-

基本语法

(1)ll >文件 (功能描述:列表的内容写入文件a.txt中(**覆盖写**)) (2)ll >>文件 (功能描述:列表的内容**追加**到文件aa.txt的末尾) (3)cat 文件1 > 文件2 (功能描述:将文件1的内容覆盖到文件2) (4)echo “内容” >> 文件 -

实操案例

- (1)将ls查看信息写入到文件中

[root@hadoop101 ~]# ls -l>houge.txt- (2)将ls查看信息追加到文件中

[root@hadoop101 ~]# ls -l>>houge.txt- (3)采用echo将hello单词追加到文件中

[root@hadoop101 ~]# echo hello>>houge.txt

(17)ln(link)创建链接和软连接

-

基本语法

链接表示目标资源的另外的访问方式,表示一种路径 软链接也称为符号链接,类似于windows里的快捷方式,有自己的数据块,主要存放了链接其他文件的路径。 ln [-s] [原文件或目录] [链接名] (功能描述:给原文件创建一个链接) -

选项说明

选项 功能 -s(symbolic) 创建的链接为 软连接 -

经验技巧

删除软链接: rm -rf 软链接名,而不是rm -rf 软链接名/ 查询:通过ll就可以查看,列表属性第1位是l,尾部会有位置指向。 -

实操案例

- (1)创建软连接

[root@hadoop101 ~]# mv houge.txt xiyou/dssz/ [root@hadoop101 ~]# ln -s xiyou/dssz/houge.txt houzi [root@hadoop101 ~]# ll lrwxrwxrwx. 1 root root 20 6月 17 12:56 houzi -> xiyou/dssz/houge.txt- (2)删除软连接

[root@hadoop101 ~]# rm -rf houzi- (3)进入软连接实际物理路径

[root@hadoop101 ~]# ln -s xiyou/dssz/ ./dssz [root@hadoop101 ~]# cd -P dssz/

(18)history查看历史命令

-

基本语法

history (功能描述:查看已经执行过历史命令) -

实操案例

- (1)查看已经执行过的历史命令

[root@hadoop101 test1]# history- (2) /root/.bash_history文件中也是历史命令

less /root/.bash_history

第二节 用户管理命令

useradd添加新用户

useradd -g(group id)

-

基本语法

useradd 用户名 (功能描述:添加新用户) ?useradd -g 组名 用户名 (功能描述:添加新用户到某个组) -

实操案例

- (1)添加一个用户

[root@hadoop101 ~]# useradd tangseng [root@hadoop101 ~]#ll /home/

passwd设置用户密码

-

基本语法

passwd 用户名 (功能描述:设置用户密码) -

实操案例

- (1)设置用户的密码

[root@hadoop101 ~]# passwd tangseng

id查看用户是否存在

-

基本语法

id 用户名 -

实操案例

- (1)查看用户是否存在

[root@hadoop101 ~]#id tangseng

cat /etc/passwd 查看创建的所有用户

-

实操案例

- (1) 查看创建的所有用户

[root@hadoop101 ~]# cat /etc/passwd

su(switch user )切换用户

-

基本语法

su 用户名称 (功能描述:切换用户,只能获得用户的执行权限,不能获得环境变量) su - 用户名称 (功能描述:切换到用户并获得该用户的环境变量及执行权限) -

实操案例

- (1)切换用户

[root@hadoop101 ~]#su tangseng [root@hadoop101 ~]#echo $PATH /usr/lib64/qt-3.3/bin:/usr/local/sbin:/usr/local/bin:/sbin:/bin:/usr/sbin:/usr/bin:/root/bin [root@hadoop101 ~]#exit [root@hadoop101 ~]#su - tangseng [root@hadoop101 ~]#echo $PATH /usr/lib64/qt-3.3/bin:/usr/local/bin:/bin:/usr/bin:/usr/local/sbin:/usr/sbin:/sbin:/home/tangseng/bin- (2) exit 回退到上一个用户

[root@hadoop101 ~]#exit

userdel删除用户

-

基本语法

(1)userdel 用户名 (功能描述:删除用户但保存用户主目录) ?(2)userdel -r 用户名 (功能描述:用户和用户主目录,都删除) -

选项说明

选项 功能 -r(remove) 删除用户的同时,删除与用户相关的所有文件。 -

实操案例

- (1)删除用户但保存用户主目录

[root@hadoop101 ~]#userdel tangseng [root@hadoop101 ~]#ll /home/- (2)删除用户和用户主目录,都删除

[root@hadoop101 ~]#useradd zhubajie [root@hadoop101 ~]#ll /home/ [root@hadoop101 ~]#userdel -r zhubajie [root@hadoop101 ~]#ll /home/

who 查看登录用户信息

-

基本语法

(1)whoami (功能描述:显示自身用户名称) ?(2)who am i (功能描述:显示登录用户的用户名) -

案例实操

- (1)显示自身用户名称

[root@hadoop101 opt]# whoami- (2)显示登录用户的用户名

[root@hadoop101 opt]# who am i

sudo(superuser do)超级用户操作, 设置普通用户具有root权限

-

基本语法

sudo 命令 -

实操案例

- (1) 添加atguigu用户,并对其设置密码

[root@hadoop101 ~]#useradd atguigu [root@hadoop101 ~]#passwd atguigu- (2)修改配置文件

[root@hadoop101 ~]#vi /etc/sudoers修改 /etc/sudoers 文件,找到下面一行(91行),在root下面添加一行,如下 \## Allow root to run any commands anywhere root ALL=(ALL) ALL atguigu ALL=(ALL) ALL或者配置成采用sudo命令时,不需要输入密码 \## Allow root to run any commands anywhere root ALL=(ALL) ALL atguigu ALL=(ALL) NOPASSWD:ALL 修改完毕,现在可以用atguigu帐号登录,然后用命令 sudo ,即可获得root权限进行操作。- (3)用普通用户在/opt目录下创建一个文件夹

[atguigu@hadoop101 opt]$ sudo mkdir module

usermod(user modify)修改用户

-

基本语法

usermod -g 用户组 用户名 -

选项说明

选项 功能 -g (group) 修改用户的初始登录组,给定的组必须存在 -

实操案例

- (1)将用户加入到用户组

[root@hadoop101 opt]#usermod -g root zhubajie

第三节 组管理类命令

每个用户都有一个用户组,系统可以对一个用户组中的所有用户进行集中管理。不同Linux 系统对用户组的规定有所不同,如Linux下的用户属于与它同名的用户组,这个用户组在创建用户时同时创建。用户组的管理涉及用户组的添加、删除和修改。组的增加、删除和修改实际上就是对/etc/group文件的更新。

groupadd新增组

-

基本语法

groupadd 组名 -

实操案例

- (1)添加一个xitianqujing组

[root@hadoop101 opt]#groupadd xitianqujing

groupdel删除组

-

基本语法

groupdel 组名 -

实操案例

- (1)删除xitianqujing组

[root@hadoop101 opt]# groupdel xitianqujing

查看创建了那些组

-

实操案例

[root@hadoop101 atguigu]# cat /etc/group

第四节 文件权限类命令

文件属性信息解读

-

文件类型和权限的表示

-

(1) 0首位表示类型 在Linux中第一个字符代表这个文件是目录、文件或链接文件等等

符号 对应文件类型 - 代表文件 d(directory) d 代表目录 l (link) 链接文档(link file); -

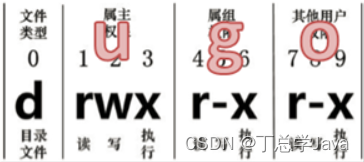

(2)第1-3位确定属主(该文件的所有者)拥有该文件的权限。U →User

-

(3)第4-6位确定属组(所有者的同组用户)拥有该文件的权限,G→Group

-

(4)第7-9位确定其他用户拥有该文件的权限 , O →Other

-

-

rwx作用到目录和文件的不同含义

- 作用到文件

[ r ]代表可读(read): 可以读取,查看 ?[ w ]代表可写(write): 可以修改,但是不能删除该文件,对该文件所在的目录有写权限,才能删除. ?[ x ]代表可执行(execute):可以被系统执行- 作用到目录

[ r ]代表可读(read): 可以读取,ls查看目录内容 ?[ w ]代表可写(write): 可以修改,目录内创建+删除+重命名目录 [ x ]代表可执行(execute):可以进入该目录 -

实操案例

- (1)查看文件权限信息

[root@hadoop101 ~]# ll 总用量 104 -rw-------. 1 root root 1248 1月 8 17:36 anaconda-ks.cfg drwxr-xr-x. 2 root root 4096 1月 12 14:02 dssz lrwxrwxrwx. 1 root root 20 1月 12 14:32 houzi -> xiyou/dssz/houge.tx- (2)文件属性介绍

ls -l

** 如果查看到是文件:链接数指的是硬链接个数**

** 如果查看的是文件夹:链接数指的是子文件夹个数 **?

chmod(change mode 改变模式)改变文件权限

-

基本语法

- 第一种方式变更权限

chmod [{ugoa}{+-=}{rwx}] 文件或目录- 第二种方式变更权限

chmod [mode=421 ] [文件或目录] -

经验技巧

u:所有者 g:所有组 o:其他人 a:所有人(u、g、o的总和) ?r=4 w=2 x=1 rwx=4+2+1=7 -

实操案例

- (1)修改文件使其所属主用户具有执行权限

[root@hadoop101 ~]# cp xiyou/dssz/houge.txt ./ [root@hadoop101 ~]# chmod u+x houge.txt- (2)修改文件使其所属组用户具有执行权限

[root@hadoop101 ~]# chmod g+x houge.txt- (3)修改文件所属主用户执行权限,并使其他用户具有执行权限

[root@hadoop101 ~]# chmod u-x,o+x houge.txt- (4)采用数字的方式,设置文件所有者、所属组、其他用户都具有可读可写可执行权限。

[root@hadoop101 ~]# chmod 777 houge.txt- (5)修改整个文件夹里面的所有文件的所有者、所属组、其他用户都具有可读写执行权限。

[root@hadoop101 ~]# chmod -R 777 xiyou/

chown (change owner 改变所有者)改变所有者

-

基本语法

chown [选项] [最终用户] [文件或目录] (功能描述:改变文件或者目录的所有者) -

选项说明

选项 功能 -R(recursion) 递归操作 -

实操案例

- (1)修改文件所有者

[root@hadoop101 ~]# chown atguigu houge.txt [root@hadoop101 ~]# ls -al -rwxrwxrwx. 1 atguigu root 551 5月 23 13:02 houge.txt- (2)递归改变文件所有者和所有组

[root@hadoop101 xiyou]# ll drwxrwxrwx. 2 root root 4096 9月 3 21:20 xiyou [root@hadoop101 xiyou]# chown -R atguigu:atguigu xiyou/ [root@hadoop101 xiyou]# ll drwxrwxrwx. 2 atguigu atguigu 4096 9月 3 21:20 xiyou

chgrp(change group)改变所属组

-

基本语法

chgrp [最终用户组] [文件或目录] (功能描述:改变文件或者目录的所属组) -

实操案例

- (1)修改文件的所属组

[root@hadoop101 ~]# chgrp root houge.txt [root@hadoop101 ~]# ls -al -rwxrwxrwx. 1 atguigu root 551 5月 23 13:02 houge.txt

第五节 搜索查找类命令

find 查找文件或者目录

-

基本语法

find指令将从指定目录向下递归地遍历其各个子目录,将满足条件的文件显示在终端。 find [搜索范围] [选项] -

选项说明

选项 功能 -name<查询方式> 按照指定的文件名查找模式查找文件 -user<用户名> 查找属于指定用户名所有文件 -size<文件大小> 按照指定的文件大小查找文件。 -

实操案例

- (1)按文件名:根据名称查找/目录下的filename.txt文件。

[root@hadoop101 ~]# find xiyou/ -name “*.txt”- (2)按拥有者:查找/opt目录下,用户名称为-user的文件

[root@hadoop101 ~]# find opt/ -user atguigu- (3)按文件大小:在/home目录下查找大于200m的文件(+n 大于 -n小于 n等于)

[root@hadoop101 ~]find /home -size +204800

grep(global regular expression print 全局正则表达式打印) 过滤查找及“|”管道符

-

基本语法

管道符,“|”,表示将前一个命令的处理结果输出传递给后面的命令处理 grep 选项 查找内容 源文件 select * from emp where ename like '%a%' -

选项说明

选项 功能 -n (number) 显示匹配及行号 -

实操案例

- (1)查找某文件在第几行

[root@hadoop101 ~]# ls | grep -n test

第六节 压缩和解压缩命令

gzip / gunzip 压缩

gzip的英文全称是 “GNU zip”。这是由理查德·斯托曼在1989年创建的一种压缩和解压缩的工具。

GNU代表GNU项目。GNU是一个自由软件项目,旨在为Unix系统提供完整的类Unix环境。该项目由理查德·斯托曼于1983年发起,并开发了一系列自由软件工具和应用程序。其中,gzip是GNU项目的一部分,用于压缩和解压缩文件。因此,"GNU zip"中的GNU代表了该项目和该工具的来源。

-

基本语法

gzip 文件 (功能描述:压缩文件,只能将文件压缩为*.gz文件) gunzip 文件.gz (功能描述:解压缩文件命令) -

经验技巧

(1)只能压缩文件,不能压缩目录 (2)不保留原来的文件 -

实操案例

- (1)gzip压缩

[root@hadoop101 ~]# ls houge.txt [root@hadoop101 ~]# gzip houge.txt [root@hadoop101 ~]# ls houge.txt.gz- (2)gunzip解压缩文件

[root@hadoop101 ~]# gunzip houge.txt.gz [root@hadoop101 ~]# ls houge.txt

zip(zipper拉链) / unzip压缩

zip的英文全称是 “zipper”。这个名称来源于zipper这个词,意为拉链。zip文件格式是一种流行的数据压缩和文档储存的文件格式,原名Deflate,发明者为菲尔·卡茨(Phil Katz)。

-

基本语法

zip [选项] XXX.zip 将要压缩的内容 (功能描述:压缩文件和目录的命令) ?unzip [选项] XXX.zip (功能描述:解压缩文件) -

选项说明

zip选项 功能 -r(recursive递归的) 压缩目录 unzip选项 功能 -d(destination)<目录> 指定解压后文件的存放目录 -

经验技巧

zip 压缩命令在window/linux都通用,**可以压缩目录且保留源文件**。 -

实操案例

- (1)压缩 1.txt 和2.txt,压缩后的名称为mypackage.zip

[root@hadoop101 opt]# touch bailongma.txt [root@hadoop101 ~]# zip houma.zip houge.txt bailongma.txt adding: houge.txt (stored 0%) adding: bailongma.txt (stored 0%) [root@hadoop101 opt]# ls houge.txt bailongma.txt houma.zip- (2)解压 mypackage.zip

[root@hadoop101 ~]# unzip houma.zip Archive: houma.zip extracting: houge.txt extracting: bailongma.txt [root@hadoop101 ~]# ls houge.txt bailongma.txt houma.zip- (3)解压mypackage.zip到指定目录-d

[root@hadoop101 ~]# unzip houma.zip -d /opt [root@hadoop101 ~]# ls /opt/

tar(tape archive磁带归档)打包

因为在早期的计算机系统中,文件和数据通常被保存在磁带上。

-

基本语法

tar [选项] XXX.tar.gz 将要打包进去的内容 (功能描述:打包目录,压缩后的文件格式.tar.gz) -

选项说明

选项 功能 -z (gzip) 打包同时压缩,指示tar命令使用gzip算法进行压缩或解压缩操作 -c(create) 产生.tar打包文件,用于创建新的归档文件 -v(verbose) 显示详细信息 -f (file) 用于指定归档文件的名称。可以指定创建或处理的归档文件的名称,以便tar命令知道要操作哪个文件 -x(extract) 解包.tar文件,用于从归档文件中提取文件 -

实操案例

- (1)压缩多个文件

[root@hadoop101 opt]# tar -zcvf houma.tar.gz houge.txt bailongma.txt houge.txt bailongma.txt [root@hadoop101 opt]# ls houma.tar.gz houge.txt bailongma.txt- (2)压缩目录

[root@hadoop101 ~]# tar -zcvf xiyou.tar.gz xiyou/ xiyou/ xiyou/mingjie/ xiyou/dssz/ xiyou/dssz/houge.txt- (3)解压到当前目录

[root@hadoop101 ~]# tar -zxvf houma.tar.gz- (4)解压到指定目录,-C(change to directory切换到目录),用于指定解压文件的目标目录

[root@hadoop101 ~]# tar -zxvf xiyou.tar.gz -C /opt [root@hadoop101 ~]# ll /opt/

第七节 进程线程类命令

进程是正在执行的一个程序或命令,每一个进程都是一个运行的实体,都有自己的地址空间,并占用一定的系统资源。

ps (process status 进程状态)查看当前系统进程状态

-

基本语法

ps -aux | grep xxx (功能描述:查看系统中所有进程) ?ps -ef | grep xxx (功能描述:可以查看子父进程之间的关系)extended format扩展格式 -

选项说明

选项 功能 Process Status for All Users in a User-oriented format excluding terminals 所有用户进程状态,格式为面向用户,不包括终端 -a (all) 选择所有进程(all) -u (user) 显示所有用户的所有进程(user-oriented)面向用户的格式 -x(exclude) 显示没有终端的进程(exclude terminals)排除终端,也就是说不以终端机来区分进程 -e(extended) 显示所有进程 -f(full format) 显示完整的格式信息 -

功能说明

- (1)ps -aux显示信息说明

USER(user 用户):该进程是由哪个用户产生的 PID(process identifier 进程标识符):进程的ID号 ?%CPU(central processing unit 中央处理器):该进程占用CPU资源的百分比,占用越高,进程越耗费资源; ?%MEM(memory 内存):该进程占用物理内存的百分比,占用越高,进程越耗费资源; ?VSZ(virtual size):该进程占用虚拟内存的大小,单位KB; ?RSS(resident set size):该进程占用实际物理内存的大小,单位KB; ?TTY(teletype):该进程是在哪个终端中运行的。其中tty1-tty7代表本地控制台终端,tty1-tty6是本地的字符界面终端, tty7是图形终端。pts/0-255代表虚拟终端。 ?STAT(status):进程状态。常见的状态有:R:运行、S:睡眠、T:停止状态、s:包含子进程、+:位于后台 ?START(start):该进程的启动时间 ?TIME(time):该进程占用CPU的运算时间,注意不是系统时间 ?COMMAND(command):产生此进程的命令名- (2)ps -ef显示信息说明

UID(user identifier):用户ID ?PID(process identifier):进程ID ?PPID(parent process identifier):父进程ID ?C(cpu usage):CPU用于计算执行优先级的因子。数值越大,表明进程是CPU密集型运算,执行优先级会降低;数值越小,表明进程是I/O密集型运算,执行优先级会提高 ?STIME(start time):进程启动的时间 ?TTY(teletype):完整的终端名称 ?TIME(time):CPU时间,显示进程累计占用的CPU时间 ?CMD(command):启动进程所用的命令和参数 -

经验技巧

如果想查看进程的**CPU**占用率和内存占用率,可以使用aux; ?如果想查看**进程的父进程ID**可以使用ef; -

实操案例

[root@hadoop101 datas]# ps -auxUSER PID %CPU %MEM VSZ RSS TTY STAT START TIME COMMAND root 1 0.0 0.1 194032 7164 ? Ss 12:24 0:08 /usr/lib/systemd/systemd --switched-root - root 2 0.0 0.0 0 0 ? S 12:24 0:00 [kthreadd] root 3 0.0 0.0 0 0 ? S 12:24 0:00 [ksoftirqd/0] root 5 0.0 0.0 0 0 ? S< 12:24 0:00 [kworker/0:0H] root 7 0.0 0.0 0 0 ? S 12:24 0:00 [migration/0] root 8 0.0 0.0 0 0 ? S 12:24 0:00 [rcu_bh] root 9 0.0 0.0 0 0 ? S 12:24 0:04 [rcu_sched] root 10 0.0 0.0 0 0 ? S 12:24 0:00 [watchdog/0] root 11 0.0 0.0 0 0 ? S 12:24 0:00 [watchdog/1] root 12 0.0 0.0 0 0 ? S 12:24 0:00 [migration/1] root 13 0.0 0.0 0 0 ? S 12:24 0:00 [ksoftirqd/1] root 15 0.0 0.0 0 0 ? S< 12:24 0:00 [kworker/1:0H] root 16 0.0 0.0 0 0 ? S 12:24 0:00 [watchdog/2] root 17 0.0 0.0 0 0 ? S 12:24 0:00 [migration/2] root 18 0.0 0.0 0 0 ? S 12:24 0:00 [ksoftirqd/2] root 19 0.0 0.0 0 0 ? S 12:24 0:00 [kworker/2:0] root 20 0.0 0.0 0 0 ? S< 12:24 0:00 [kworker/2:0H][root@localhost ~]# ps -efUID PID PPID C STIME TTY TIME CMD root 1 0 0 12:24 ? 00:00:08 /usr/lib/systemd/systemd --switched-root --system --deseri root 2 0 0 12:24 ? 00:00:00 [kthreadd] root 3 2 0 12:24 ? 00:00:00 [ksoftirqd/0] root 5 2 0 12:24 ? 00:00:00 [kworker/0:0H] root 7 2 0 12:24 ? 00:00:00 [migration/0] root 8 2 0 12:24 ? 00:00:00 [rcu_bh] root 9 2 0 12:24 ? 00:00:04 [rcu_sched] root 10 2 0 12:24 ? 00:00:00 [watchdog/0] root 11 2 0 12:24 ? 00:00:00 [watchdog/1] root 12 2 0 12:24 ? 00:00:00 [migration/1] root 13 2 0 12:24 ? 00:00:00 [ksoftirqd/1] root 15 2 0 12:24 ? 00:00:00 [kworker/1:0H] root 16 2 0 12:24 ? 00:00:00 [watchdog/2] root 17 2 0 12:24 ? 00:00:00 [migration/2] root 18 2 0 12:24 ? 00:00:00 [ksoftirqd/2]

kill 终止进程

-

基本语法

kill [选项] 进程号 (功能描述:通过进程号杀死进程) ? killall 进程名称 (功能描述:通过进程名称杀死进程,也支持通配符) -

选项说明

选项 功能 -9 表示强迫进程立即停止 -

实操案例

- (1)杀死浏览器进程

[root@hadoop101 桌面]# kill -9 5102- (2)通过进程名称杀死进程

[root@hadoop101 桌面]# killall firefox

top(tool for processes 进程工具)命令

top命令是Linux下常用的性能分析工具,能够实时显示系统中各个进程的资源占用状况,类似于Windows的任务管理器。top命令可以动态显示进程的资源使用情况,即可以通过用户按键来不断刷新当前状态。如果在前台执行该命令,它将独占前台,直到用户终止该程序为止。比较准确的说,top命令提供了实时的对系统处理器的状态监视。它将显示系统中CPU最“敏感”的任务列表。该命令可以按CPU使用、内存使用和执行时间来对任务进行排序,而且该命令的很多特性都可以通过交互式命令或者在个人定制文件中进行设定。

[root@localhost ~]# top

top - 19:42:21 up 7:17, 6 users, load average: 0.00, 0.03, 0.05

Tasks: 241 total, 1 running, 238 sleeping, 2 stopped, 0 zombie

%Cpu(s): 0.1 us, 0.0 sy, 0.0 ni, 99.9 id, 0.0 wa, 0.0 hi, 0.0 si, 0.0 st

KiB Mem : 4030172 total, 366988 free, 1508000 used, 2155184 buff/cache

KiB Swap: 6291452 total, 6291452 free, 0 used. 2177824 avail Mem

PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND

1493 mysql 20 0 2251440 394044 15080 S 1.0 9.8 4:31.19 mysqld

810 root 20 0 305444 6324 4940 S 0.3 0.2 1:18.16 vmtoolsd

14799 root 20 0 157988 2376 1572 R 0.3 0.1 0:00.07 top

1 root 20 0 194032 7164 4084 S 0.0 0.2 0:08.81 systemd

2 root 20 0 0 0 0 S 0.0 0.0 0:00.04 kthreadd

3 root 20 0 0 0 0 S 0.0 0.0 0:00.03 ksoftirqd/0

5 root 0 -20 0 0 0 S 0.0 0.0 0:00.00 kworker/0:0H

7 root rt 0 0 0 0 S 0.0 0.0 0:00.08 migration/0

8 root 20 0 0 0 0 S 0.0 0.0 0:00.00 rcu_bh

9 root 20 0 0 0 0 S 0.0 0.0 0:04.73 rcu_sched

10 root rt 0 0 0 0 S 0.0 0.0 0:00.30 watchdog/0

11 root rt 0 0 0 0 S 0.0 0.0 0:00.30 watchdog/1

12 root rt 0 0 0 0 S 0.0 0.0 0:00.06 migration/1

13 root 20 0 0 0 0 S 0.0 0.0 0:00.01 ksoftirqd/1

15 root 0 -20 0 0 0 S 0.0 0.0 0:00.00 kworker/1:0H

16 root rt 0 0 0 0 S 0.0 0.0 0:00.34 watchdog/2

17 root rt 0 0 0 0 S 0.0 0.0 0:00.20 migration/2

18 root 20 0 0 0 0 S 0.0 0.0 0:00.14 ksoftirqd/2

19 root 20 0 0 0 0 S 0.0 0.0 0:00.91 kworker/2:0

20 root 0 -20 0 0 0 S 0.0 0.0 0:00.00 kworker/2:0H

21 root rt 0 0 0 0 S 0.0 0.0 0:00.55 watchdog/3

22 root rt 0 0 0 0 S 0.0 0.0 0:00.14 migration/3

23 root 20 0 0 0 0 S 0.0 0.0 0:00.10 ksoftirqd/3

25 root 0 -20 0 0 0 S 0.0 0.0 0:00.00 kworker/3:0H

26 root rt 0 0 0 0 S 0.0 0.0 0:00.28 watchdog/4

27 root rt 0 0 0 0 S 0.0 0.0 0:00.03 migration/4

28 root 20 0 0 0 0 S 0.0 0.0 0:00.07 ksoftirqd/4

第八节 磁盘分区类命令

df (disk free 空余硬盘)查看磁盘空间使用情况

-

基本语法

df 选项 (功能描述:列出文件系统的整体磁盘使用量,检查文件系统的磁盘空间占用情况) -

选项说明

选项 说明 -h 以人们较易阅读的 GBytes, MBytes, KBytes 等格式自行显示; -

实操案例

- (1)查看磁盘使用情况

[root@hadoop101 ~]# df -h Filesystem Size Used Avail Use% Mounted on /dev/sda2 15G 3.5G 11G 26% / tmpfs 939M 224K 939M 1% /dev/shm

fdisk 查看分区

-

基本语法

fdisk -l (功能描述:查看磁盘分区详情) -

选项说明

选项 功能 -l 显示所有硬盘的分区列表 -

经验技巧

- 该命令必须在root用户下才能使用

-

功能说明

- (1)Linux分区

Device:分区序列 ?Boot:引导 ?Start:从X磁柱开始 ?End:到Y磁柱结束 ?Blocks:容量 ?Id:分区类型ID ?System:分区类型 -

实操案例

- (1)查看系统分区情况

[root@hadoop101 /]# fdisk -l Disk /dev/sda: 21.5 GB, 21474836480 bytes 255 heads, 63 sectors/track, 2610 cylinders Units = cylinders of 16065 * 512 = 8225280 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disk identifier: 0x0005e654 Device Boot Start End Blocks Id System /dev/sda1 * 1 26 204800 83 Linux Partition 1 does not end on cylinder boundary. /dev/sda2 26 1332 10485760 83 Linux /dev/sda3 1332 1593 2097152 82 Linux swap / Solaris

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 2023年粤港澳大湾区人工智能产业大会圆满结束,英码科技荣获三大行业奖项!

- 分布式缓存Redis

- 第十章 SpringCloud Alibaba 实现Sleuth–链路追踪

- 教学/直播/会议触摸一体机定制_基于展锐T820安卓核心板方案

- gRPC-Go基础(4)metadata和超时设置

- 力扣(leetcode)第599题两个列表的最小索引总和(Python)

- 解释 Git 的基本概念和使用方式

- C++上位软件通过LibModbus开源库和西门子S7-1200/S7-1500/S7-200 PLC进行ModbusTcp 和ModbusRTU 通信

- 从数据洞察到市场变革:我们的 Web3 愿景

- 【德特森】电动截止阀打不开的故障原因有哪些?