【Python】Sigmoid和Hard Sigmoid激活函数对比总结及示例

发布时间:2024年01月11日

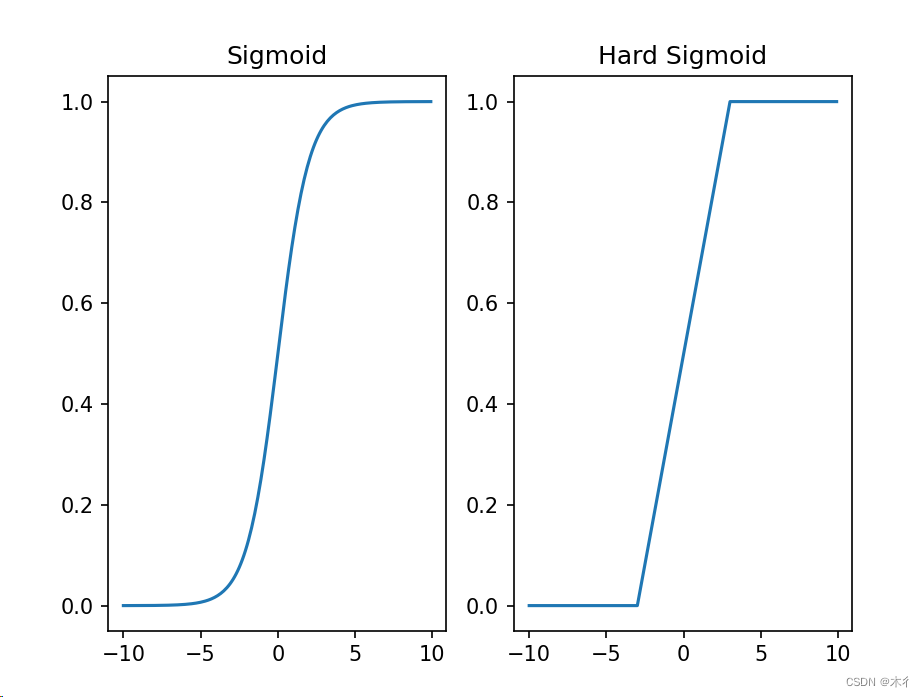

Sigmoid和Hard Sigmoid是两种常用的激活函数,它们在神经网络中起到非线性变换的作用。以下是它们之间的对比和优缺点总结:

Sigmoid激活函数:

优点:

- 输出范围是0到1之间,可以用于二分类问题。

- 函数形状相对平滑,有助于减小梯度消失问题。

缺点:

在输入非常大或非常小的值时,会出现梯度消失的情况,导致网络训练困难。

计算量大,因为需要计算指数函数。

输出不是以0为中心,有时会影响网络的训练。

Hard Sigmoid激活函数:

优点:

计算量较小,因为不需要计算指数函数。

输出是以0为中心的,有助于网络的训练。

输出范围是[0,1],可以用于二分类问题。

缺点:

相对于Sigmoid函数,其输出不是非常平滑,可能导致梯度消失问题。

在输入值接近于0时,其梯度接近于0,可能会影响网络的训练。

在处理多分类问题时,需要使用Softmax函数作为输出层,而Hard Sigmoid与Softmax的组合可能不如Sigmoid与Softmax的组合稳定。

总结:

选择激活函数需要根据具体的应用场景和需求来决定。如果需要处理二分类问题并且对计算量要求较高,可以考虑使用Hard Sigmoid。如果对网络的稳定性和平滑性要求较高,可以选择使用Sigmoid激活函数。

import torch

import torch.nn as nn

import matplotlib.pyplot as plt

# Sigmoid激活函数

sigmoid = nn.Sigmoid()

sigmoid_inputs = torch.arange(-10, 10, 0.1)

sigmoid_outputs = sigmoid(sigmoid_inputs)

print("Sigmoid Function Input :: {}".format(sigmoid_inputs))

print("Sigmoid Function Output :: {}".format(sigmoid_outputs))

plt.subplot(1, 2, 1)

plt.plot(sigmoid_inputs,sigmoid_outputs)

plt.title('Sigmoid')

# Hard Sigmoid激活函数

hard_sigmoid = nn.Hardsigmoid()

hard_sigmoid_inputs = torch.arange(-10, 10, 0.1)

hard_sigmoid_outputs = hard_sigmoid(hard_sigmoid_inputs)

print("Hard Sigmoid Function Input :: {}".format(hard_sigmoid_inputs))

print("Hard Sigmoid Function Output :: {}".format(hard_sigmoid_outputs))

plt.subplot(1, 2, 2)

plt.plot(hard_sigmoid_inputs,hard_sigmoid_outputs)

plt.title('Hard Sigmoid')

plt.show()

文章来源:https://blog.csdn.net/qq_22734027/article/details/135499054

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- ARP相关记录

- 服装店收银系统+品牌商城,助力实体店私域运营快速落地

- WebX代码和接口文档自动生成器

- 多臂老虎机 “Multi-armed Bandits”

- 基于MyCat2.0实现MySQL分库分表方案

- Linux-iptables,Centeros 防火墙

- 【前端设计】输入框

- git stash:协同开发中最常用的命令

- 基于SpringBoot+vue高校宿舍报修管理系统-计算机毕业设计源码83946

- LLM面面观之LLM上下文扩展方案