使用 EmbeddingBag 和 Embedding 完成词嵌入

发布时间:2024年01月12日

🍨 本文为[🔗365天深度学习训练营学习记录博客\n🍦 参考文章:365天深度学习训练营\n🍖 原作者:[K同学啊 | 接辅导、项目定制]\n🚀 文章来源:[K同学的学习圈子](https://www.yuque.com/mingtian-fkmxf/zxwb45)

使用 EmbeddingBag 和 Embedding 完成词嵌入,首先需要处理文档中的文本,将其转换为适合进行词嵌入的格式,涉及到以下步骤:

- 文本清洗:移除文档中的特殊字符和标点符号,将文本统一为小写(如果适用)。

- 分词:将文本分割成单词或标记(tokens)。

- 建立词汇表:从分词后的文本中创建一个词汇表,每个唯一的单词对应一个索引。

- 文本向量化:将文本转换为数字形式,以便进行嵌入处理。

第二步,使用 EmbeddingBag 和 Embedding 层进行词嵌入。EmbeddingBag 层适用于处理变长的文本,它会计算所有嵌入向量的平均值或和。而 Embedding 层适用于单个单词或固定长度的序列。

目标文件:

实现代码:?

from collections import Counter

import torch

import torch.nn as nn

import re

# 清洗文本并进行分词

def tokenize(text):

# 移除特殊字符和标点,并转换为小写

text = re.sub(r'[^\w\s]', '', text).lower()

# 分词

return text.split()

# 创建词汇表

def create_vocab(text_tokens):

vocab = Counter(text_tokens)

vocab = sorted(vocab, key=vocab.get, reverse=True)

vocab_to_int = {word: ii for ii, word in enumerate(vocab, 1)} # 索引从1开始

return vocab_to_int

# 将文本转换为数字形式

def text_to_int(tokens, vocab_to_int):

return [vocab_to_int[word] for word in tokens if word in vocab_to_int]

# 定义Embedding和EmbeddingBag层

def define_embedding_layers(vocab_size, embedding_dim=100):

embedding = nn.Embedding(num_embeddings=vocab_size, embedding_dim=embedding_dim)

embedding_bag = nn.EmbeddingBag(num_embeddings=vocab_size, embedding_dim=embedding_dim, mode='mean')

return embedding, embedding_bag

# 读取文件内容

file_path = 'D:/任务文件 (1).txt'

with open(file_path, 'r', encoding='utf-8') as file:

file_content = file.read()

# 文本清洗和分词

tokens = tokenize(file_content)

# 创建词汇表

vocab_to_int = create_vocab(tokens)

# 将文本转换为数字形式

int_text = text_to_int(tokens, vocab_to_int)

# 定义嵌入层参数

embedding_dim = 100

vocab_size = len(vocab_to_int) + 1

# 定义Embedding和EmbeddingBag层

embedding, embedding_bag = define_embedding_layers(vocab_size, embedding_dim)

# 转换为tensor以供嵌入层使用

input_tensor = torch.tensor([int_text], dtype=torch.long)

# 使用Embedding和EmbeddingBag进行词嵌入

embedded = embedding(input_tensor)

embedded_bag = embedding_bag(input_tensor)

# 打印结果

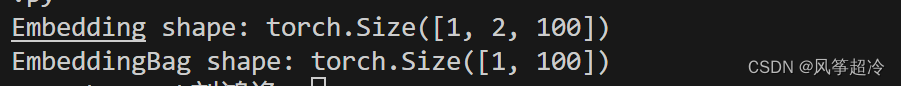

print("Embedding shape:", embedded.shape)

print("EmbeddingBag shape:", embedded_bag.shape)

文章来源:https://blog.csdn.net/qq_60245590/article/details/135559809

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 年终总结 | 开发者必备书籍、工具、资料汇总贴(2024)

- 【LeetCode刷题笔记(11-1)】【Python】【和为 K 的子数组】【前缀和】【中等】

- 三维重建(1)摄像机几何

- 项目经理必读书籍有哪些?抓紧收藏!

- Labview局部变量、全局变量、引用、属性节点、调用节点用法理解及精讲

- 根据方程组解,生成n个n元一次方程组

- 基于爬虫和Kettle的豆瓣电影的采集与预处理

- Linux添加一个指令代替指定指令

- 基于Redis限流(aop切面+redis实现“令牌桶算法”)

- 一文搞懂,Python网络爬虫