AIGC语言大模型涌现能力是幻觉吗?

在自然界中,涌现现象无处不在,从鸟群的和谐飞翔到生物细胞的精妙分化,例如大脑中的神经元通过简单的电化学信号相互作用,但整体上却能产生意识、思考和记忆等极其复杂的功能。这表明了从神经元到思维的过程是一种典型的涌现现象。

从化学反应中的神秘图案到大脑中思维的火花,比如贝纳德对流和利斯巴特反应。这些都是更复杂的结构和模式从简单的组成部分自然而然地产生的例子。这些现象启示我们,整体的行为和性质往往超出了单个组成部分的简单相加。在这种背景下,人工智能领域的一个重要问题浮现出来:在人工智能,特别是在自然语言处理领域中的大模型,如GPT-3和GPT—4 turbo,我们观察到的涌现能力,是否也是一种类似于自然界的涌现现象?

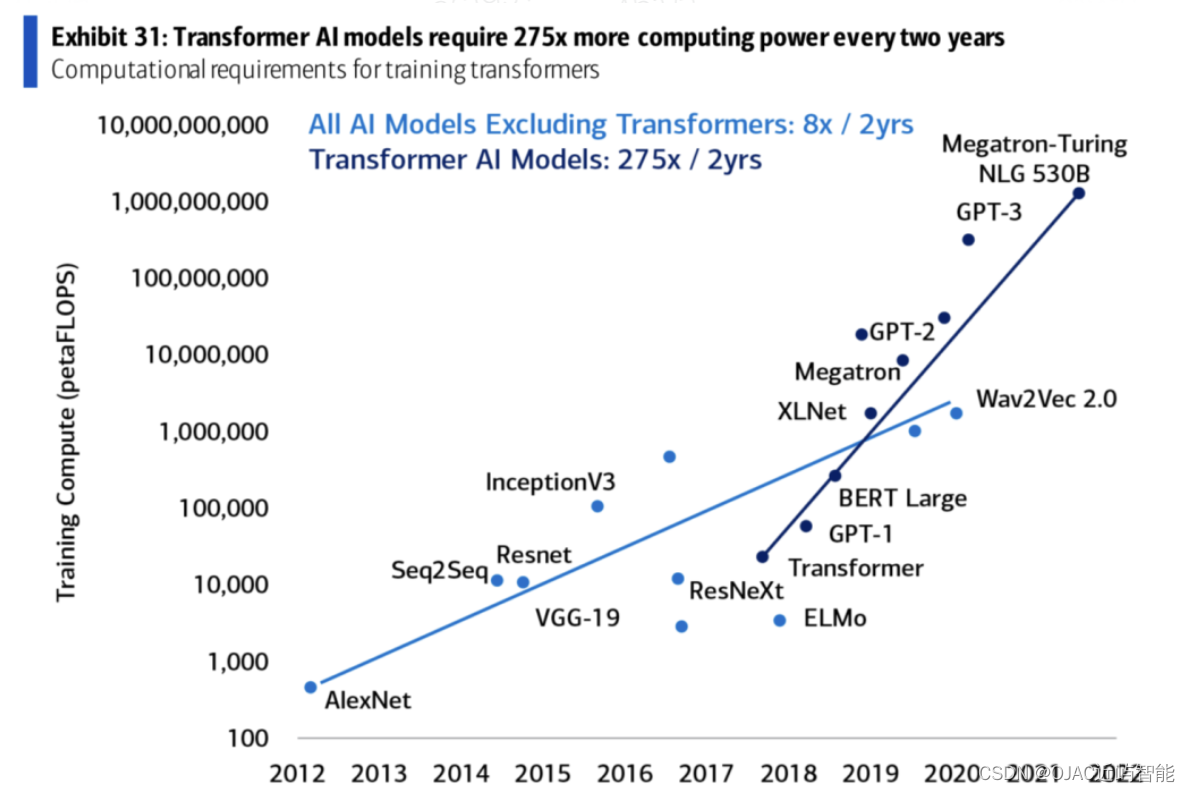

首先,要理解AI大模型中的涌现现象,我们需要探讨大语言模型(LLM)的数据规模和模型规模的增长是如何引起涌现的现象的。我们不得不提及一个核心概念:伸缩法则(Scaling Laws)。这一概念在理解LLM的涌现能力中扮演了枢纽角色,它揭示了模型性能与模型规模之间的定量关系,并指导着模型设计和训练的最优化路径。

伸缩法则(Scaling Laws)与模型规模

伸缩法则在大语言模型的研究中首次被系统性地探讨和验证。研究表明,随着模型规模的增长(包括参数数量、数据规模和计算量),模型的性能(如语言理解和生成的能力)通常会遵循特定的增长趋势。这一趋势表明,在一定范围内,增加模型的规模能够带来几乎预测性的性能提升。这一现象在GPT-3以及其他大型语言模型的开发和性能分析中得到了显著体现。

模型规模的增长对涌现能力的影响

参数数量的增加:

当模型的参数数量增加时,模型的表示能力和记忆容量显著提升。每个额外的参数提供了额外的维度来捕捉和编码语言的复杂性。这不仅意味着模型能够记住更多的事实,更重要的是,模型能够学习到更复杂的语言模式和结构。

数据规模的扩展:

伴随模型规模的增长,训练数据的规模也相应增大。这意味着模型被暴露在更加多样化和广泛的语言场景中,从而能学习到更加丰富的语言现象和细微的语言特征。这种多样性是涌现现象的重要来源之一。

计算量的增长:

随着参数数量和数据规模的增长,所需的计算量也随之增加。伸缩法则指出,在特定的范围内,更大的计算量能够有效地转化为模型性能的提升。这一点在模型的预训练阶段尤为重要,大量的计算资源使得模型能够在巨大的语料库上进行深入学习。

涌现现象的深层解释

伸缩法则为理解LLM的涌现能力提供了一个量化的框架。随着模型规模的增长,我们不仅观察到性能的增加,更重要的是,我们见证了新的能力的出现——这些能力在小模型中并未明显体现。例如,在特定的规模阈值后,模型开始展现出对复杂语义的理解,比如对比喻、隐喻的理解,甚至是创造性思维的迹象。这种现象超越了简单的性能提升,表明了一种质的变化——从简单的语言模式识别到深层次的语言理解和思维。

第二个具备涌现能力的是思维链(Chain of Thought,简称CoT),它展示了大语言模型在复杂推理任务上的涌现能力。这一能力的体现不仅在于模型能够生成答案,更在于模型能够展现出解决问题的逻辑推理过程。以下是CoT如何使大语言模型具备涌现能力的几个关键点:

模拟人类思维过程:

CoT的核心在于它模拟了人类解决问题的逻辑推理过程。当模型被提示以一种“思考”的方式逐步解决问题时,它不再是单纯地匹配问题与答案,而是开始尝试理解问题的各个部分以及它们之间的关系。这种模拟人类思维过程的方式使得模型能够处理更加复杂和抽象的问题。

增强模型的内在连接和推理能力:

通过CoT,模型被引导去构建内在的逻辑链,将问题的各个部分连接起来,并逐步推导出答案。这种方法强化了模型内部的连接和推理能力,使模型能够在解决问题时表现出类似于人类的思维模式。

提高模型的解释能力和透明度:

CoT不仅提高了模型解决问题的能力,还增加了模型的解释能力和透明度。通过展现解决问题的每个步骤,模型生成的答案不再是一个黑箱输出,而是一个可以追溯和理解的逻辑过程。这种解释能力对于增强模型的可信度和可靠性至关重要。

促进模型的自我学习和涌现能力:

CoT的实施不仅在于指导模型解决特定问题,更在于训练模型学会如何学习。通过这种方式,模型不仅学习到特定问题的答案,更重要的是学习了解决问题的方法和逻辑。这种自我学习的过程是模型涌现能力的重要体现,它使模型在面对新问题时能够运用已有的逻辑和方法来寻找解决方案。

推动模型能力的跨任务迁移:

CoT训练的模型在学习了一系列逻辑推理步骤后,其推理能力有可能被迁移到其他未见过的任务上。这种跨任务的迁移能力是涌现现象的一个重要标志,表明模型在学习过程中不仅积累了知识,还掌握了知识的应用和转化能力。

通过CoT,大语言模型展现了在适当引导下的涌现能力,不仅在于解决问题的能力,更在于模拟、学习、并展现人类思维的能力。这种涌现能力的展现突破了传统模型仅依赖输入输出匹配的限制,为模型的发展和应用打开了新的可能性。

综上所述,随着模型规模的持续增长,我们可以期待更多未知的涌现能力被揭示,同时也对这些大模型的内部运作机制和性能边界提出了新的疑问和挑战。

此外,"Grokking"顿悟这个概念也为我们理解大语言模型中的涌现现象提供了一个独特的视角。Grokking指的是模型在训练的某个点突然展现出对某类问题深刻理解的现象。这种现象表明,模型可能在内部形成了对数据和任务的深层次理解,这种理解超出了简单的模式匹配或统计相关性。这种深层次的理解和忽然的"领悟"是涌现现象在大模型中的又一体现。

在反思这些现象时,我们不禁要问:**AI大模型中的涌现能力,是否仅仅是一场幻觉,还是确有其实的、可观察和可解释的自然现象?**虽然这个问题可能还没有最终答案,但通过探索和理解自然界的涌现现象,以及在AI领域中类似现象的深入研究,我们或许能够逐渐揭开这一谜团。

关于大模型是如何涌现的原理的分析,我们近屿智能OJAC推出的《AIGC星辰大海:大模型工程师和产品专家深度训练营》就是学习这部分知识的最好选择。我们的课程是一场结合了线上与线下的双轨合流式学习体验。

别人教您使用AIGC产品,例如ChatGPT和MidJourney,我们教您增量预训练,精调大模型,和创造属于自己的AI产品!

您是否想利用AIGC为您打破职业与薪资的天花板?您是否想成为那个在行业里脱颖而出的AI专家?我们的培训计划,将是您实现这些梦想的起点。

让我带您了解一下近屿智能OJAC如何帮您开启AI的大门。

首先,为了让零基础的您也能轻松上手,我们特别设计了“Python强化双周学”这个先修课程。在两周的时间里,我们将通过在线强化学习,把大模型相关的Python编程技术娓娓道来。就算您现在对编程一窍不通,也不要担心,我们会带您一步步走进编程的世界。

然后,是我们的“AIGC星辰大海:大模型工程师与AIGC产品经理启航班”。这个课程包含6节精彩的直播课,不仅能让您深入了解ChatGPT等大模型的奥秘,还会带您领略至少20个来自全球的成功AIGC产品案例。想象一下,未来您同样有机会利用这些先进技术打造出热门AI产品!

更深层次的学习,则在“AIGC星辰大海:大模型工程师和产品专家深度训练营”中进行。这个深度训练营覆盖了从理论基础到实际操作的全过程,让您不仅学会理论,更能将知识应用到实际项目中。如果您想要深挖大模型的秘密?这里就是您的实验室!

如果您选择加入我们的OJAC标准会员,我们的"AI职场导航"项目,还将为您提供量身定制的职业机会,这些职位来自于我们广泛的行业网络,包括初创企业、中型企业以及全球知名公司。我们会根据您的技能、经验和职业发展愿景,为您筛选合适的机会。此外,我们也提供简历修改建议、面试准备指导和职业规划咨询,帮助您在竞争激烈的市场中脱颖而出。

同时您也可以享受到未来景观AI讲座暨每月技术洞见”系列讲座,获得最新的技术洞见。这不仅是一个学习的机会,更是一个与行业顶尖大咖直接交流的平台。

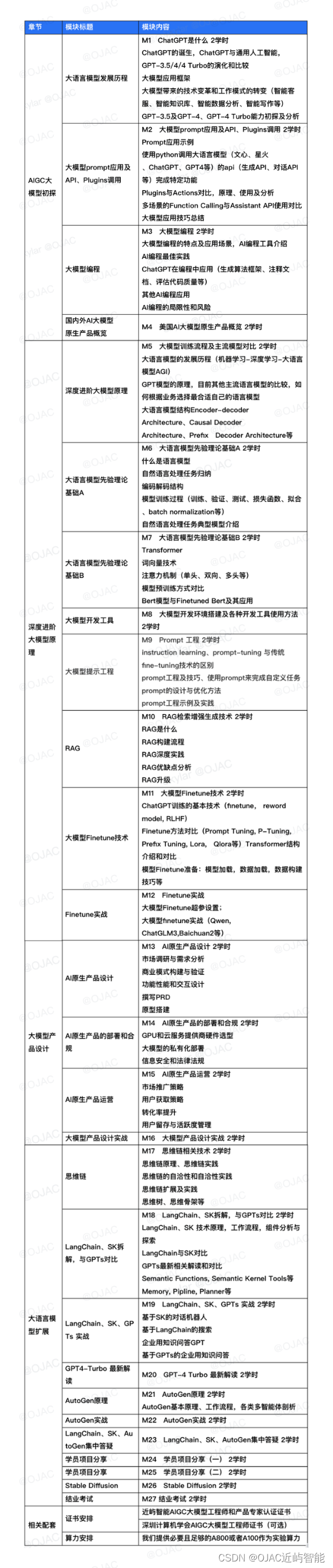

以下是我们大模型工程师和产品专家深度训练营的课程内容:

除此之外,现在报名我们即将开班的第六期AIGC星辰大海大模型工程师和产品经理训练营,您将可以参与到以下三个创新实战项目中的任意一个,这些项目不仅能够锻炼您的实战能力,还能让您在AIGC领域脱颖而出。

项目1:企业级知识问答GPT

这个项目将教您如何打造一个智能机器人,它能够接入企业内部的知识库,如技术文档、HR政策、销售指南等。您将学会如何使其具备强大的自然语言处理能力,进行复杂查询的理解和精确答案的提供。此外,该项目还包括教您如何让机器人保持对话上下文、支持多语言交流,并具备反馈学习机制,以不断提升服务质量。

项目2:行业级AI Agent

在这个项目中,您将学习如何为特定行业定制化AI Agent。您将被指导如何让它理解行业专有术语和工作流程,并训练它自动执行任务,如预约设置、数据输入和报告生成。这个项目不仅帮助您构建一个决策支持系统,还教您如何进行用户行为预测和性能监控与优化。

项目3:论文翻译

如果您对语言学习和学术研究有浓厚兴趣,这个项目将是您的理想选择。您将探索如何实现从英语到中文或其他目标语言的精准学术翻译,确保保留学术文献的深层含义。本项目还包括学术格式定制、专业词汇精确匹配以及广泛语言选项的训练,最后通过翻译效果评价系统,您将能够持续提升翻译质量。

无论您选择哪个项目,都将是您职业生涯中不可多得的实战经历。

我们诚邀您继续与我们携手前行。在未来的职业道路上,让我们共同探索AI的更多奥秘,共创辉煌。如果您还有任何疑问或者想要深入了解更多课程内容,请随时联系我们。我们期待着与您共同开启下一阶段的AI探索之旅。

加入我们的“AIGC星辰大海”训练营,让我们一起在AI的世界里创造不凡!立刻加入我们,开启您的AI大模型旅程,将梦想转变为现实。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- JavaScript实现六种网页图片轮播效果详解

- ubuntu下快速安装使用docker

- ROS:rosdep与ROS2的安装记录

- TS 36.306 V12.0.0

- Github Copilot 的使用方法和快捷键

- a.hashCode() 的用途是什么?它与 a.equals(b) 有什么关系

- 【洛谷 P1719】最大加权矩形 题解(前缀和+贪心+容斥原理)

- @NotNull、@NotEmpty 和 @NotBlank注解实体类校验

- 中国光伏展

- 边缘加密网关在工业物联网中的重要性