nn.Dropout(0.5), Dropout有什么功能,一般取值取多少!!

发布时间:2024年01月16日

Dropout

1. Dropout解释

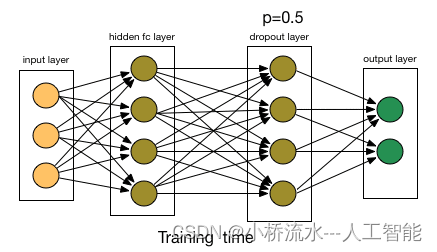

Dropout在神经网络中是一个常用的正则化技术。它的作用是在训练过程中随机断开一些神经元,从而避免过拟合。

2. Dropout取值

一般情况下,Dropout率的取值范围是0-0.5之间。取值越大,dropout的效果越强,但也可能导致模型收敛速度变慢。

具体来说:

-

0.1-0.3之间是经典的取值范围,可以很好地防止过拟合。

-

0.4-0.5的取值范围效果会更好,但训练也会更慢。

-

小于0.1的取值效果不明显,可能没有起到正则化的作用。

所以实际应用中,Dropout率通常取0.2左右,这是一个比较好的折中值。它可以很好地防止过拟合,同时也不会明显影响模型的训练速度。总的来说,Dropout是一种非常有效的正则化方法。合理设置其取值可以有效提升神经网络的泛化能力。

文章来源:https://blog.csdn.net/qlkaicx/article/details/135630174

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 第二证券:红利赛道联动 资金“攻守兼备”布局

- 使用blip2进行图片输入文本输出

- Nodejs 第二十三章(Markdown 转 html)

- FL Studio 中文汉化正式发布维护更新版本V21.2.2中文解锁版

- 扁平化菜单功能制作

- 多线程对全局Map做computeIfAbsent()引发的线程问题

- SpringBoot Starter机制 ——自动化配置

- 快速打通 Vue 3(一):基本介绍与组合式 API

- JAVA 导出报表 大数据量 sxssfworkbook的使用

- spring-cloud-starter-gateway-mvc的网关实现