自编码器的基本概念

发布时间:2023年12月26日

全连接自编码器

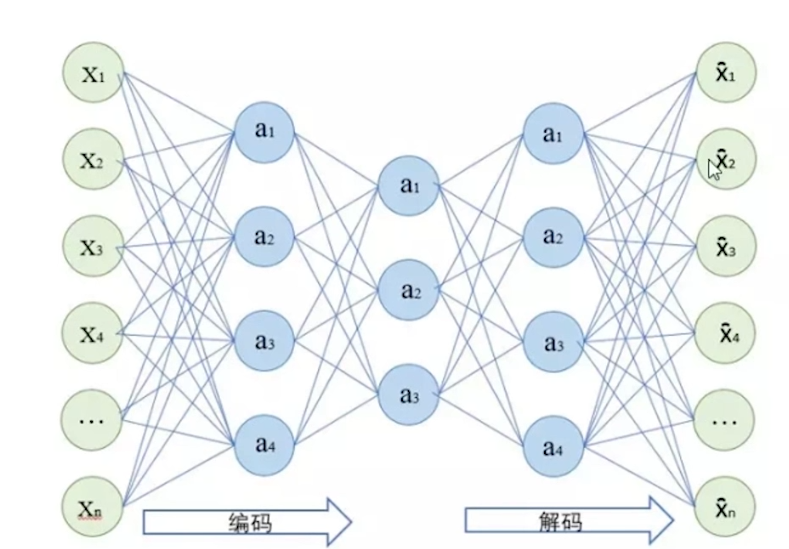

自编码器是一种无监督学习模型,其目标是学习数据的有效表示。它由两个主要部分组成:编码器(Encoder)和解码器(Decoder)。

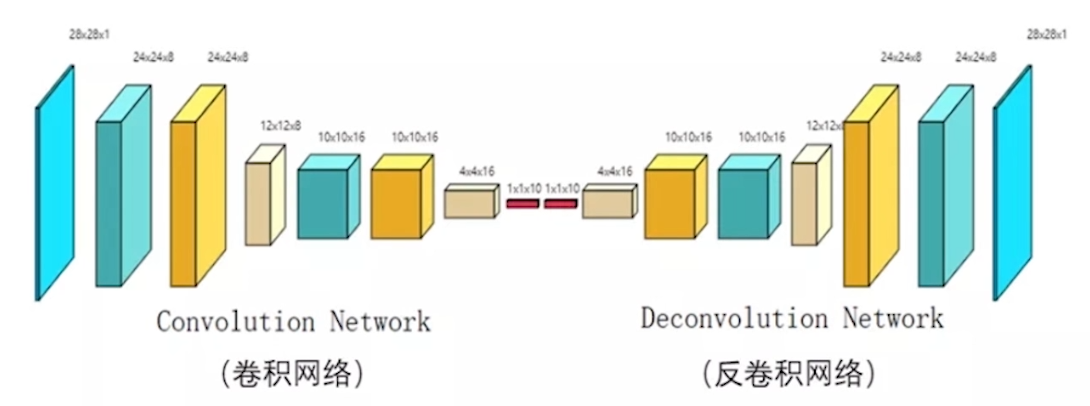

卷积自编码器

传统自编码器一般使用的是全连接层,对于一维信号并没有什么影响,但是对于二维图像或视频信号,全连接层会损失空间信息,而通过卷积操作,卷积自编码器能很好的保留二维信号的空间信息。

正则自编码器:

稀疏自编码器就是普通自编码器的隐藏层加一个L1正则项,也就是一个训练惩罚项,这样我们训练出的编码器(encoder)表征的特征更加的稀疏,从而能得到少且有用的特征项。这也是为啥用L1正则项而不用L2正则项的原因。

降噪自编码器:降噪自编码器就是输入换成了加噪的数据集,输出用原数据集去训练的自编码器,目的是习得降噪功能。

变分自编码器

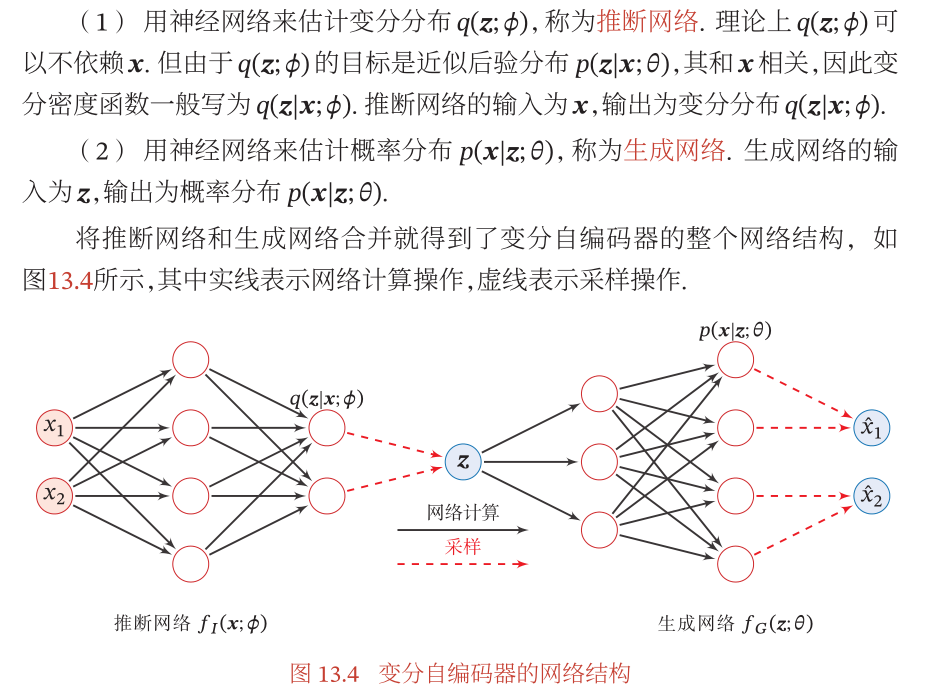

- 变分自编码器(VariationalAutoEncoder,VAE)[Kingmaetal., 2014] 是一种深度生成模型,其思想是利用神经网络来分别建模两个复杂的条件概率密度函数.

- 与传统的自编码器不同,VAE采用概率分布的观点对自编码器进行改进,使其更适用于生成样本。

变分自编码器(Variational Autoencoder,VAE)是一种生成模型,属于自编码器(Autoencoder)的一种。与传统的自编码器不同,VAE采用概率分布的观点对自编码器进行改进,使其更适用于生成样本。

以下是变分自编码器的一般介绍:

2. VAE的改进:

VAE引入了概率分布的概念,将潜在变量视为服从某种概率分布的随机变量。这使得VAE能够在潜在空间中生成新的样本,而不仅仅是还原已有的样本。

3. 关键概念:

- 潜在空间的概率分布: 假设潜在变量 z z z是从某个概率分布中抽样得到的,通常假设为高斯分布。

- 编码器: 将输入数据映射到潜在空间,并输出潜在变量的均值和方差。

- 重参数化技巧(Reparameterization Trick): 通过引入一个额外的噪声项,使得网络可以通过梯度下降进行训练。

- 解码器: 将潜在变量映射回原始数据空间。

4. 目标函数:

VAE的训练目标是最大化对数似然函数,即最大化生成的样本在原始数据分布上的似然。为了优化这一目标,还引入了一个正则化项,该项使得潜在空间的分布更接近于先验分布(通常是标准正态分布)。

5. 生成新样本:

由于VAE的潜在变量是从概率分布中采样得到的,因此可以在潜在空间中生成新的样本,这使得VAE成为一种强大的生成模型。

6. 应用领域:

VAE在生成图像、样本插值、数据去噪等任务上表现出色,并在生成模型领域取得了显著的成就。

总体而言,变分自编码器是一种强大的生成模型,通过引入概率分布和潜在变量的随机性,使得模型更能适应数据分布的复杂性,同时也提供了生成新样本的能力。

文章来源:https://blog.csdn.net/qq_45889056/article/details/135220623

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!