四、yolov8模型导出和查看

发布时间:2024年01月10日

yolv8模型导出

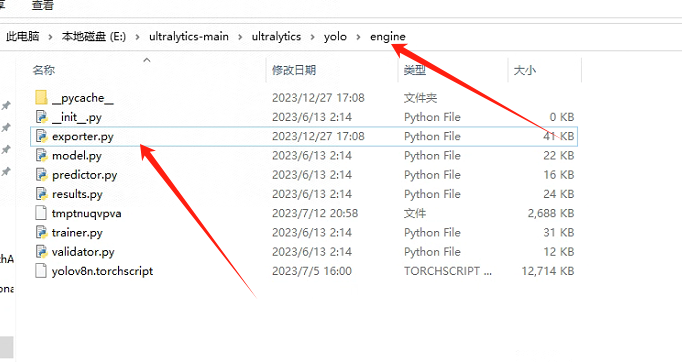

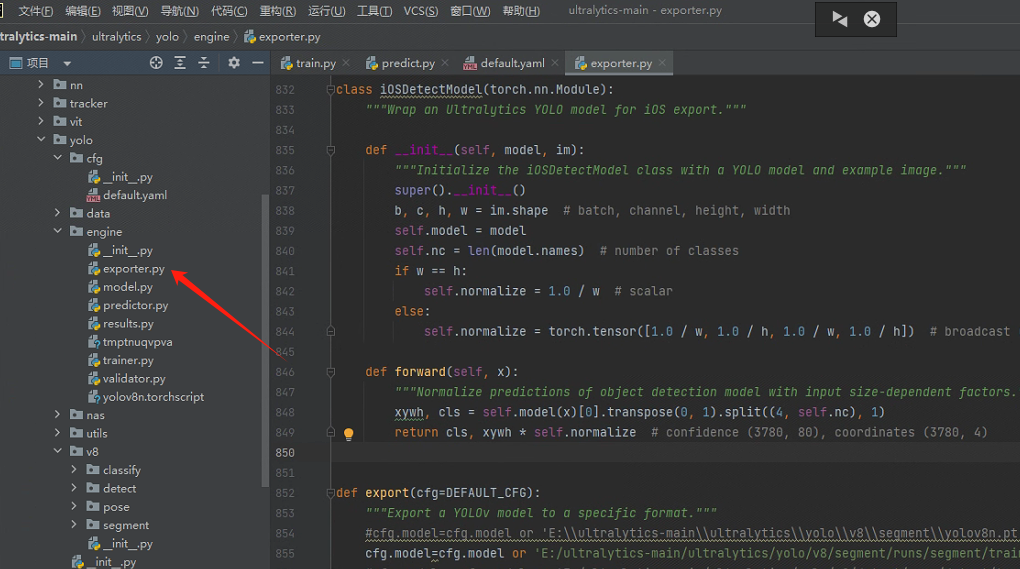

1、找到engine文件夹下的exporter.py文件。

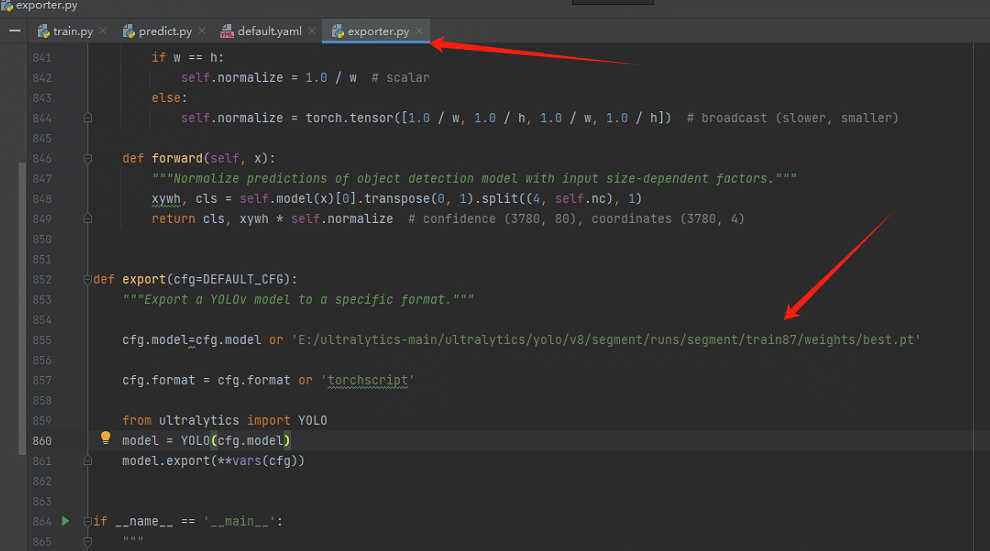

2、修改文件夹路径,改为我们训练结束后生成的文件夹。

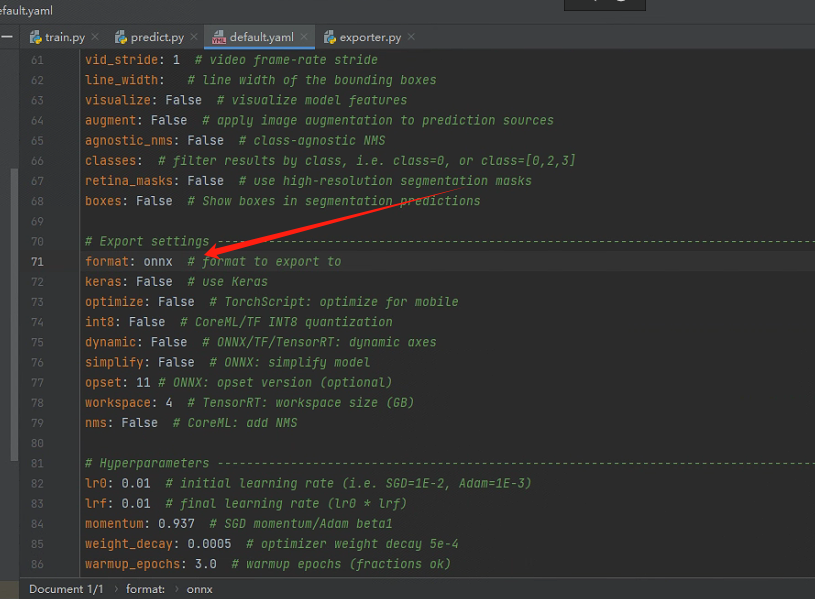

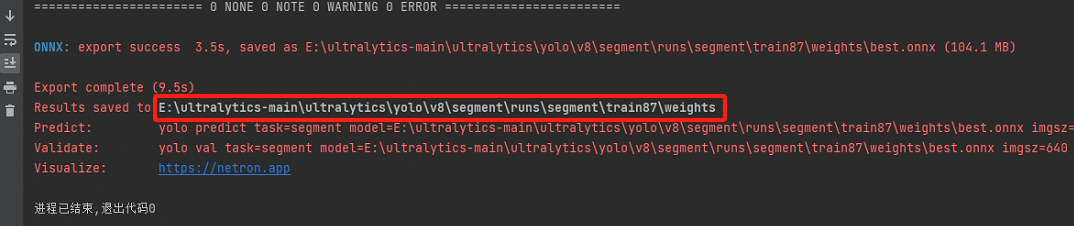

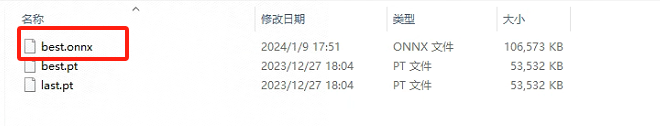

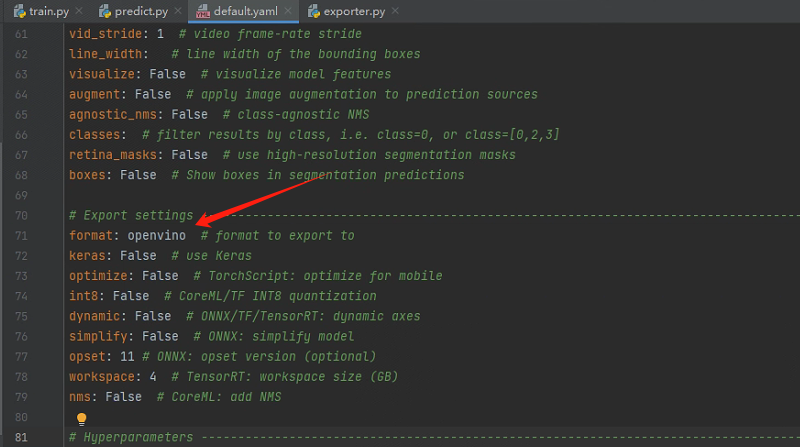

3、打开default.yaml文件夹,找到format参数,修改为onnx,找到batch改为1,然后返回exporter.py文件,运行,导出onnx模型,方便trt和onnxruntime部署。

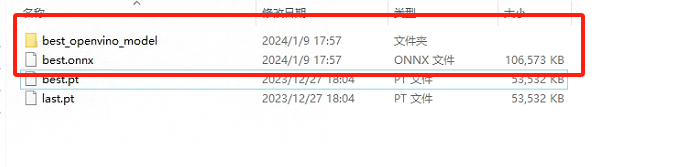

4、以上就是一个模型导出的完整流程;然而有人想要用openvino部署,需要导出vino模型。同样,打开default.yaml文件夹,找到batch改为1,找到format参数,修改为openvino;导出openvino可调用模型,

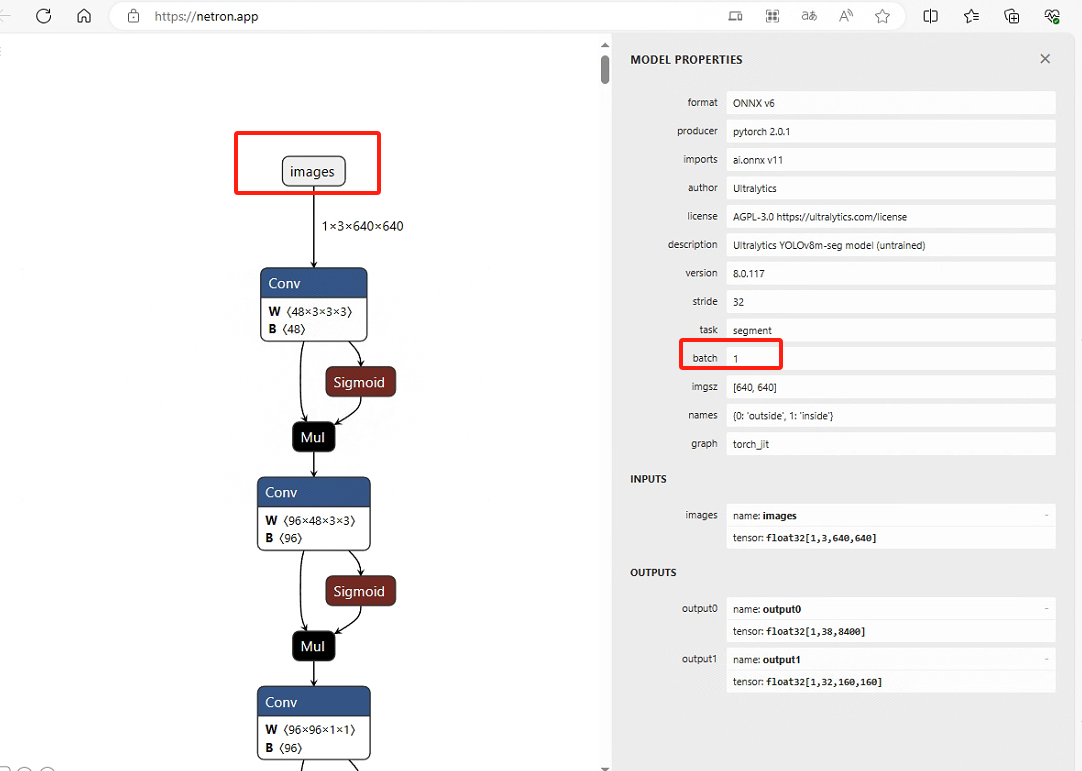

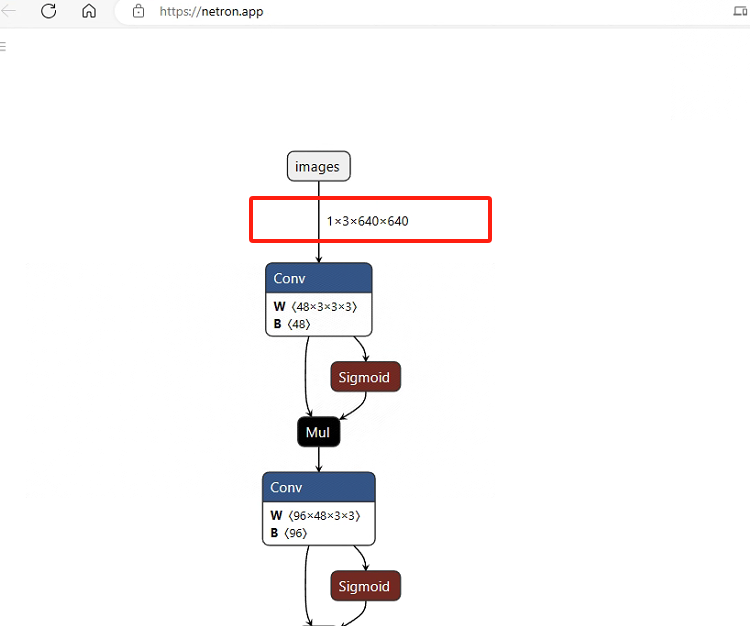

5、查看模型,通过网站https://netron.app/打开刚才生成的onnx,点击images,可以看到batch为1。

文章来源:https://blog.csdn.net/WDX4092410/article/details/135486137

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 1.1 Python高级编程-函数式编程

- 加密算法、分布式缓存与Hadoop

- Vue+OpenLayers7:OpenLayers7地图整合到Vue项目中的两种方式

- 互动直播 之 播放器管理类

- 微信小程序

- 支原体——隐形且最小的细菌病原体,还会诱发“肺外症状”

- QuPath病理流程学习 ③ IHC、H&E (WSI的处理)实战

- 洛谷 NOIP2014普及组 比例简化 + 洛谷 NOIP2015普及组 扫雷游戏

- 如何通过宝塔面板搭建一个MySQL数据库服务并实现无公网ip远程访问?

- window.open 跳转http自动重定向https问题