2023 英特尔On技术创新大会直播 |打造自己的聊天机器人

2023 英特尔On技术创新大会会议简介

2023 英特尔On技术创新大会是面向智算时代的开发者的一场技术大会,在世界很多地方有召开。2023年9月19日,2023英特尔on技术创新大会在美国加州圣何塞市开幕。2023年12月19日中国站正式开始。中国站的主题由帕特·基辛格开幕,并有多个中国专家深度讲解英特尔最新一代加速 AI 能力的计算平台,支持开放、多架构的软件方案和工具,塑造未来的技术和应用创新。

这场技术大会有很多的主题

内容丰富,挑选一个我感兴趣的主题进行记录分享。

主题-打造自己的聊天机器人

讲座目标

由于工作原因,我还是比较喜欢这个主题的,比较适合IT人员,这个主题是面向一个具体应用场景的,讲座由邓会鹏讲解,邓会鹏是英特尔AI解决方案架构师。

这不是第一次了解到邓老师,在今年(2023年)1024程序员节北京站的的活动上,邓老师就分享了《IA平台上优化GenAI开源工具》的主题,当时的主题内容如英特尔在基于量化加速的LLM推理部署中,基于CPU指令集,为大语言模型的量化以及高效推理设计的代码库BigDL-LLM优化方案。

本次讲座中,首先结合AI的流程,介绍了Intel AI 的软件产品组合。

然后提纲挈领的说明本次讲座的最终收获,

After this class, you will be able to:

本课程结束后,您将能够:

Successfully build a chatbot using Neural Chat within lntel Extension for Transformers

在Transformers的lntel扩展中使用神经聊天成功构建聊天机器人

Run LLM workflows for finetuning, quantization and inference deployment

运行LLM工作流以进行微调、量化和推理部署

还是主题明确,输出显著的,开始学习

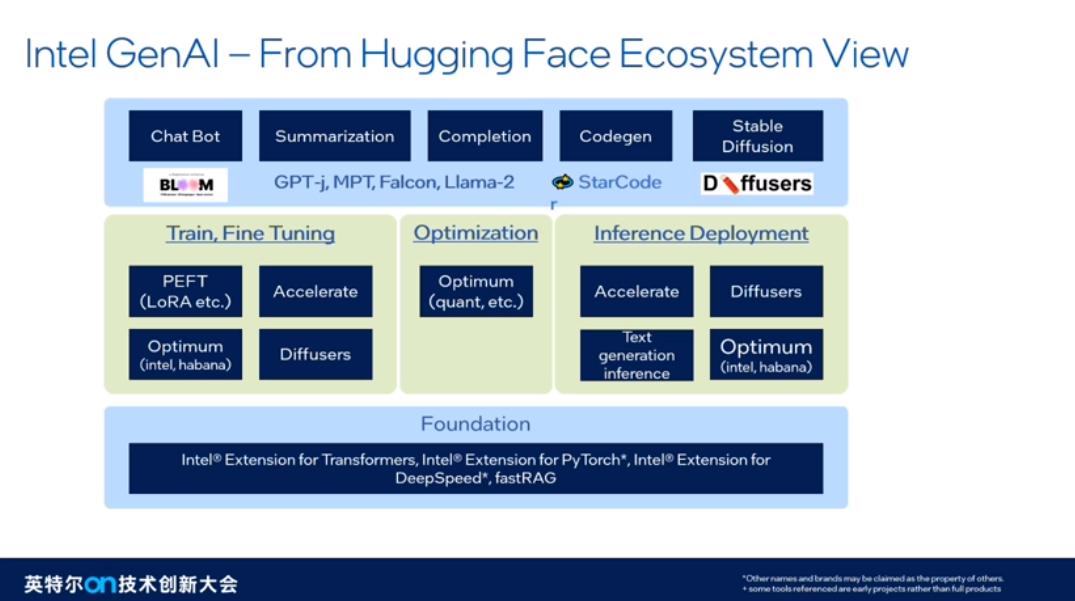

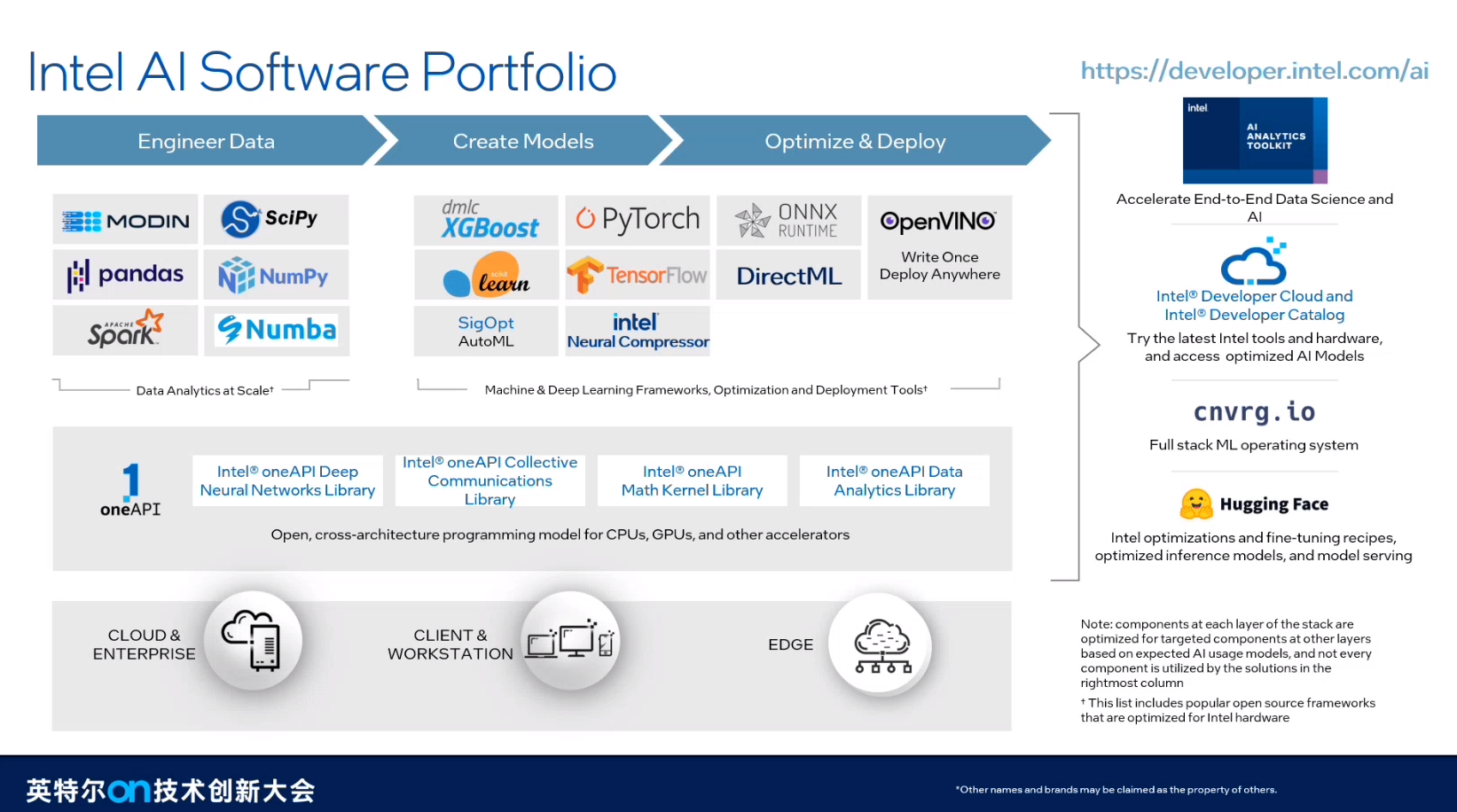

Intel AI Software Portfolio技术

由于数据处理,建模需要多种类库,Intel提供了OneAPI MKL等多个底层的支撑平台,加速深度学习的运算。对于使用者,还提供了在线平台和Hugging Face等。

在Hugging Face社区,提供了训练微调部署的全套优化组件,这些组件是基于Intel对transformers,pytorch,DeepSpeed等的拓展支撑。

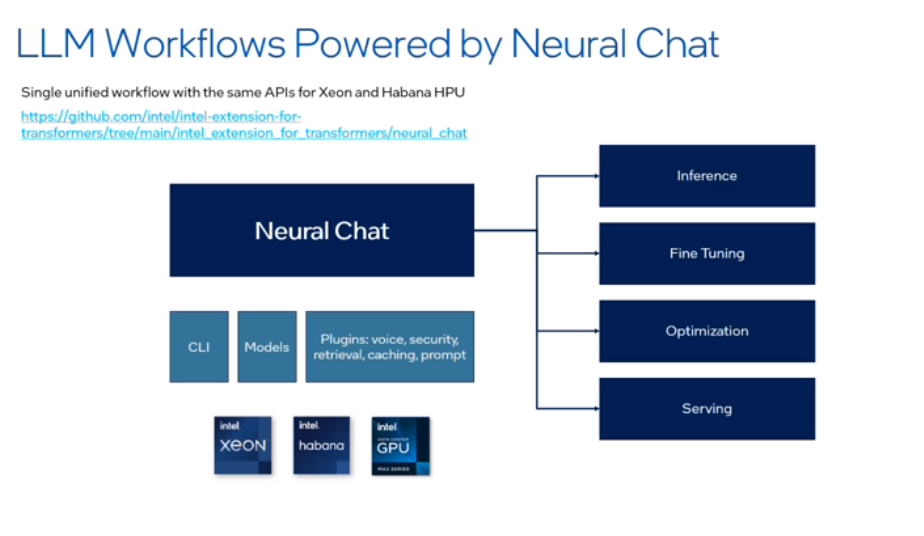

聊天 Neural chat的代码实现

英特尔的Neural chat对知识抽取,微调和提示工程有很好的支持,同时提供多种模型,可以在英特尔的多种设备上运行,适配较好。

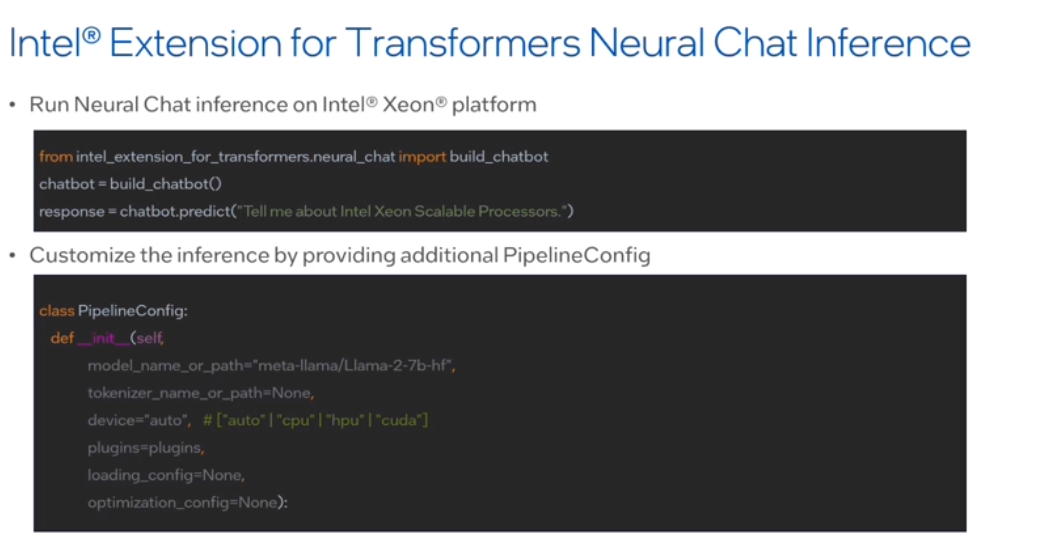

加载模型进行预测

这个功能的代码十分简介,便于快速入门,也可以自定义模型,是否使用CPU|GPU,是否需要语音支持等。

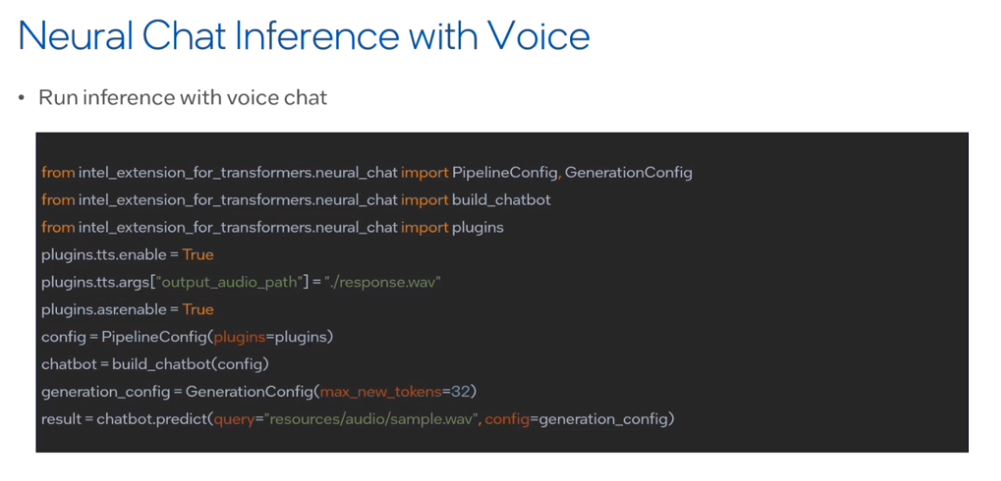

语言输入返回

ASR是自动语音识别,接下来把文本输入LLM,针对返回格式再用语音返回。

代码实现

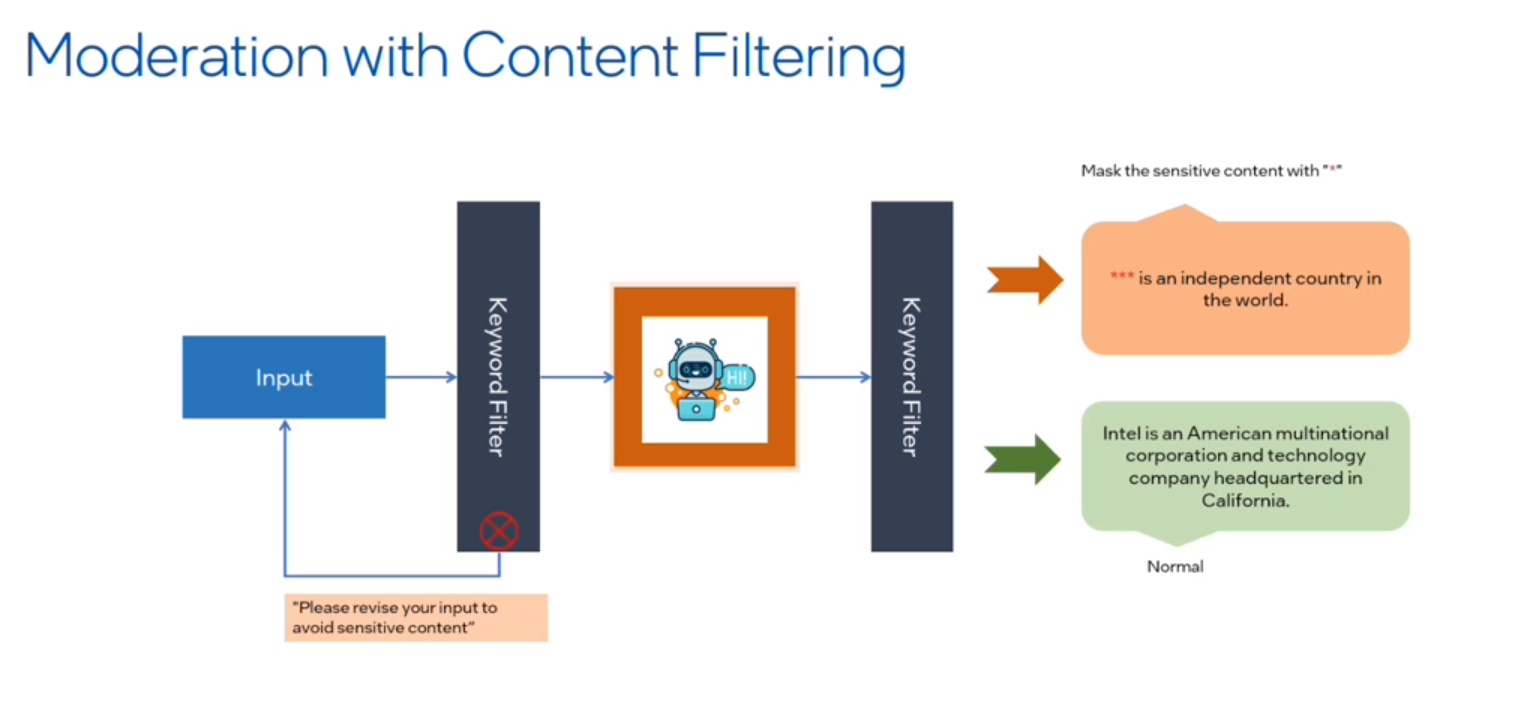

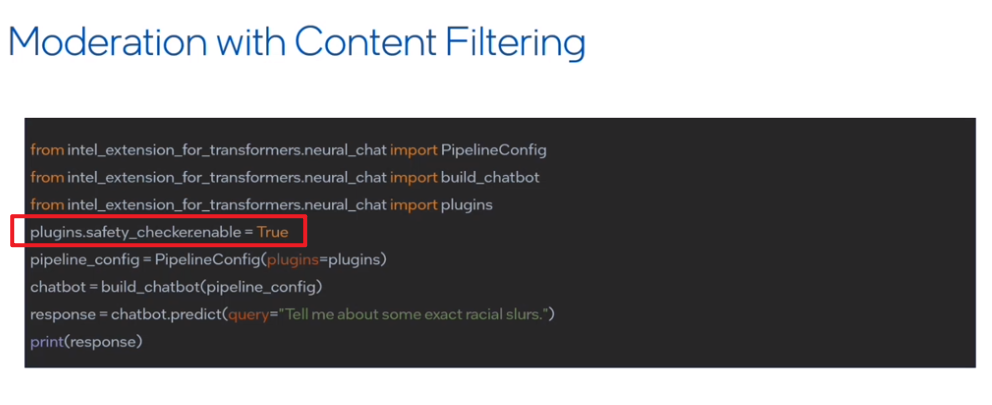

文本过滤

如果针对返回结果进行过滤呢,这里采用KV进行过滤,用星号进行过滤

代码实现

性能提升

采用提示词工程

检索增强

如何完成信息检索增强呢,当我们问what is IDM2.0 ,我们会把这行结果与知识库中的数据进行匹配,得到的结果智能会提高很多。

代码实现

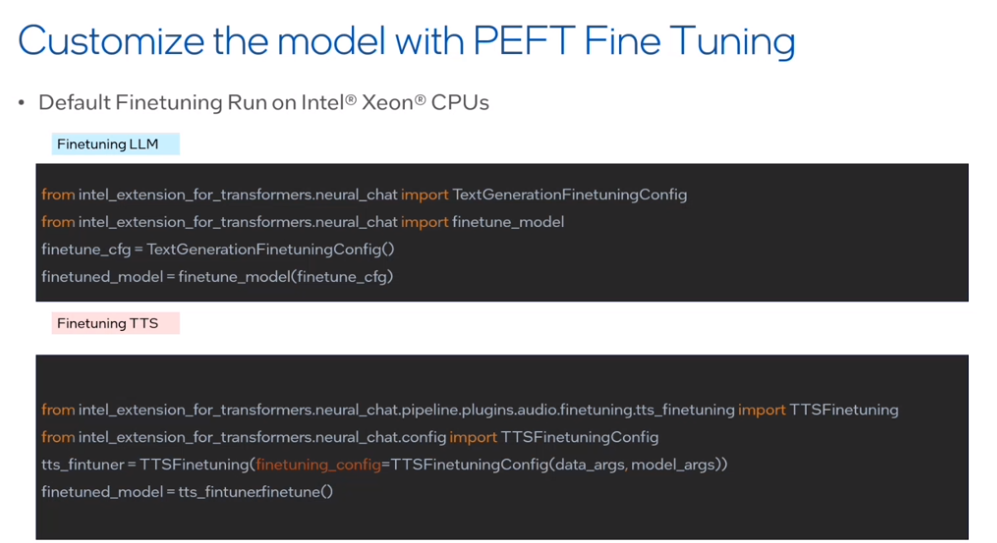

微调代码实现

添加对应组件

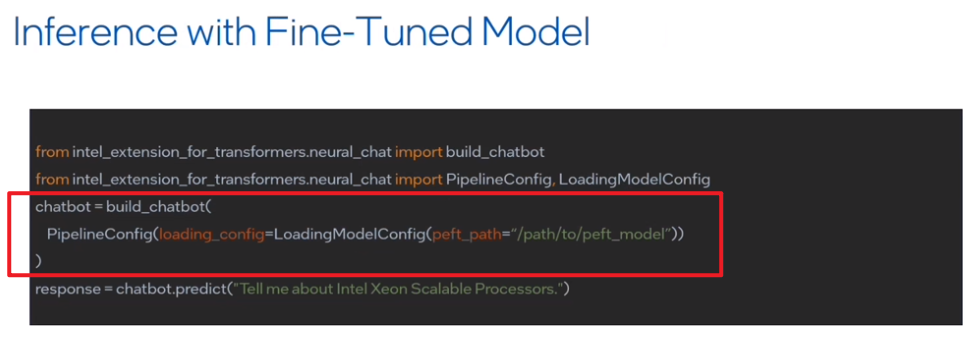

推理代码实现

只需要修改微调后的模型路径

量化实现

大模型为了节省计算时间,可以使用量化,量化就是把大模型的参数精度减少些,然后计算速度就会提示,也是一个很常见的推理性能提升手段

主题感悟

大模型与大多数人的使用越来越近了,基于英特尔的大模型的部署推理微调量化过程十分的便捷,可以说10行代码就可以部署推理本地的一个大模型,同时英特尔还提供了很多大模型以供选择。

基于英特尔的这系列组件还是挺友好的,封装了很多细节,也保留了一定的自由度,对于大模型的IT使用者来说,基于这些上层的API可以某种程度上提示大模型的部署推理量化速度,还是值得尝试的

大厂出品,必属精品💯

参考资源

Build LLM demo on Intel? Xeon? platform:

intel-extension-for-transformers/intel_extension_for_transformers/neural_chat at main · intel/intel-extension-for-transformers (github.com)

https://www.intel.com/content/www/us/en/developer/topic-technology/artificial-intelligence/overview.html

Get developer resources from Intel and Hugging Face:

https://www.intel.com/content/www/us/en/developer/ecosystem/hugging-face.html

Visit Neural Chat Github?:

https://github.com/intel/intel-extension-for-transformers/tree/main/intel_extension_for_transformers/neural_chat

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- bootstrap:bootstrapValidator校验数据是否可用(验证账户名是否重复)

- DDR3信号概念--入门1

- python 抓包拷贝数据转发

- <a>标签target=“_blank“ 焦点窃取漏洞

- 服务器数据恢复-服务器断电导致linux操作系统数据丢失的数据恢复案例

- redhat+ oracle 11.2.0.4 RAC 搭建 dataguard

- ntp校时服务器、ntp授时服务器、ntp时钟服务器

- 运动健身app开发常见问题,项目经理经手10个相关项目后的亲身总结

- 天下第一铭:以此文纪念汤晓鸥

- 【每日一题】从链表中移除节点