FaceChain-FACT:免训练的丝滑体验,秒级别的人像生成

FaceChain-FACT:免训练的丝滑体验,秒级别的人像生成

项目主页:FaceChain-fact:Face Adapter for Human AIGC

github项目:https://github.com/modelscope/facechain

1.介绍

作为AI人像写真开源项目的佼佼者,FaceChain凭借其丰富多样的风格模版和卓越的人像保真度,深受社区的喜爱并已在商业应用中得到了广泛的应用。近期,FaceChain团队推出了全新的版本——FaceChain FACT。这一创新版本摒弃了传统的人物模型训练过程,能够直接生成zero-shot目标人像,引领AI人像生成进入了无需训练的单阶段时代。

你是否曾经因为相册里只有寥寥几张照片而无法训练自己的数字形象而感到苦恼?或者因为需要等待20分钟左右的人物形象训练而感到焦急?目前市场上的AI写真大多采用“训练+生成”的两阶段模式,既需要庞大的形象数据支撑,也需要一定的训练时间。这种模式增加了用户的使用成本。面对这一问题,FaceChain给出了解决方案:无需大量数据,无需训练等待,甚至无需训练,只需要一张图片10秒钟即可立即生成AI写真!

2.原理

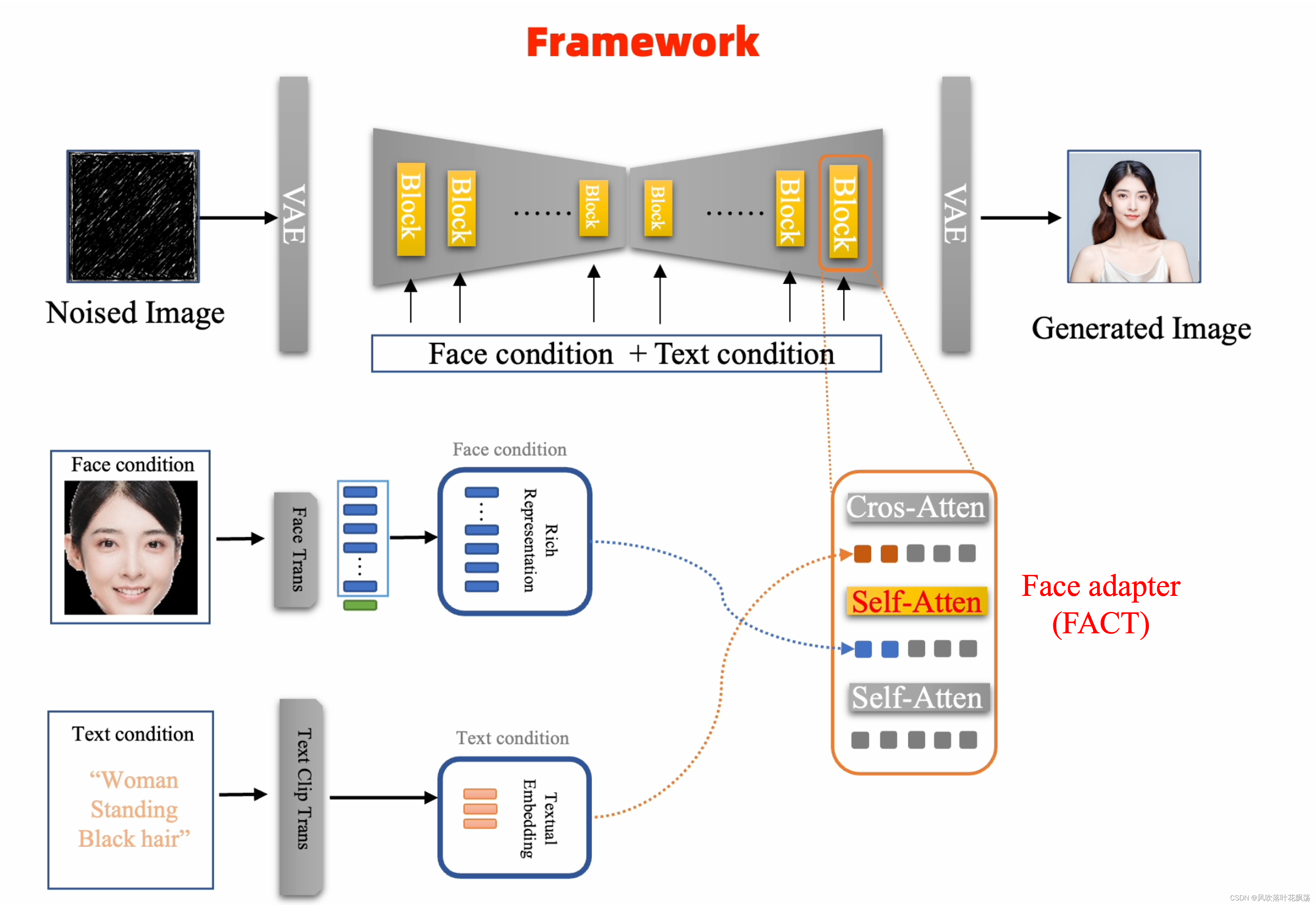

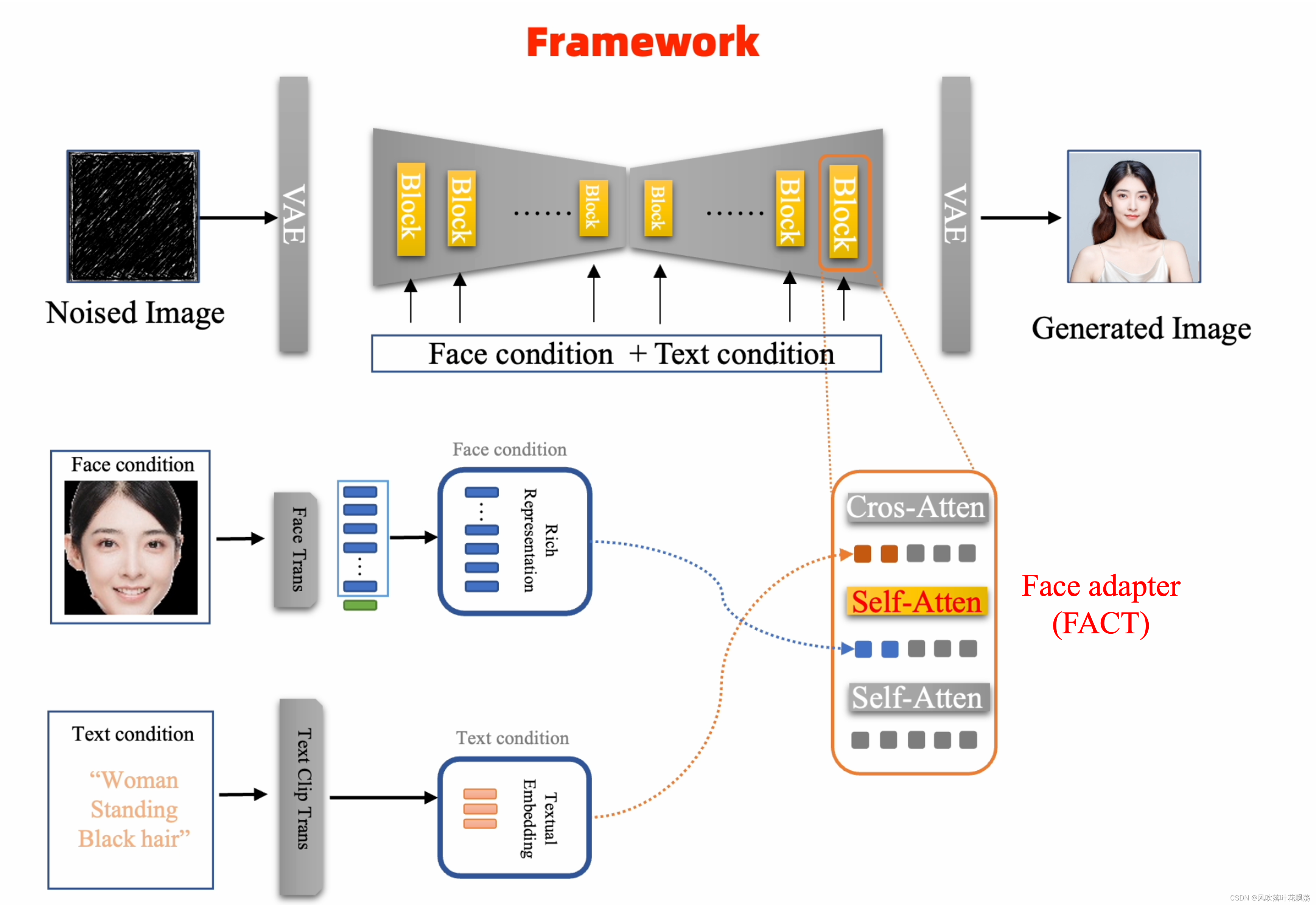

FaceChain FACT(Face Adapter)之所以能够跳过训练阶段,是因为它经过了百万级别的写真数据训练,从而使得Stable Diffusion具备了强大的人脸重建能力。与传统的双阶段人像生成方法不同,FaceChain FACT重新构建了Stable Diffusion模型的架构,使其能够将人脸信息作为独立分枝的条件,平行于文本信息一起送入模型中进行推理。通过这种方式,FaceChain FACT能够更高效地处理人脸重建任务,从而避免了繁琐的训练阶段。FACT整个框架如下图所示:

?

为了更全面地提取人脸的细节信息,FACT采用了在海量人脸数据上预训练的基于Transformer架构的人脸特征提取器。与CNN架构的特征不同,基于Transformer架构的特征能够更好的适应Stable Diffusion的结构。通过这种方式,FACT能够更精确地保留人脸的细节特征,从而实现高清的人脸重建。

?

为了确保Stable Diffusion的原有功能得到充分保留,FACT作为独立的adapter层被插入到原始Stable Diffusion的block中,并在训练时固定原始block参数,仅对adapter进行训练。此外,人脸特征与文本特征是相互独立的,平行送入block中,避免了彼此之间的干扰。通过调整人脸信号的权重,用户可以灵活地调节生成效果,从而在保持Stable Diffusion原有的文生图功能的同时,平衡人脸的保真度与泛化性。

3.效果

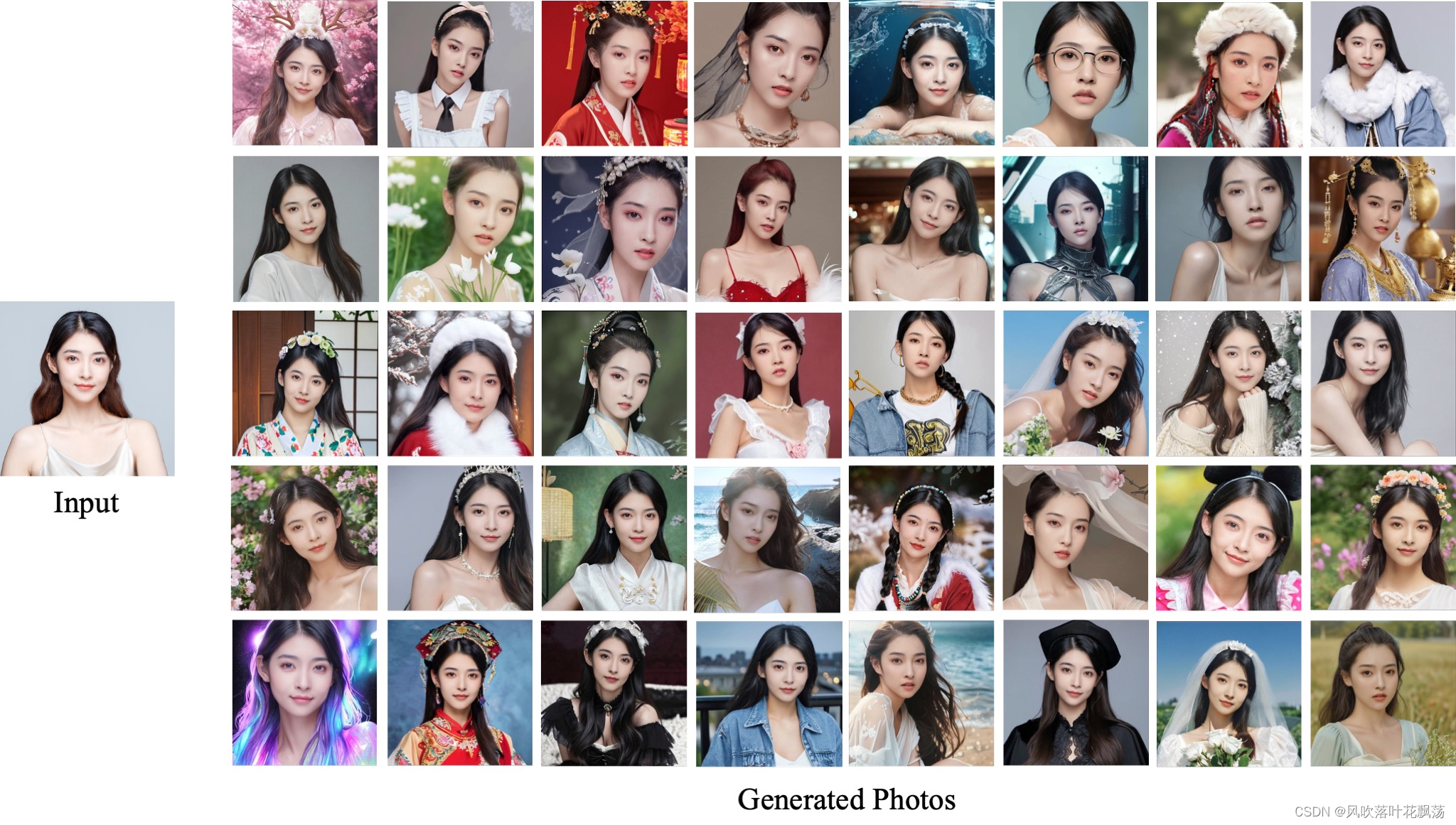

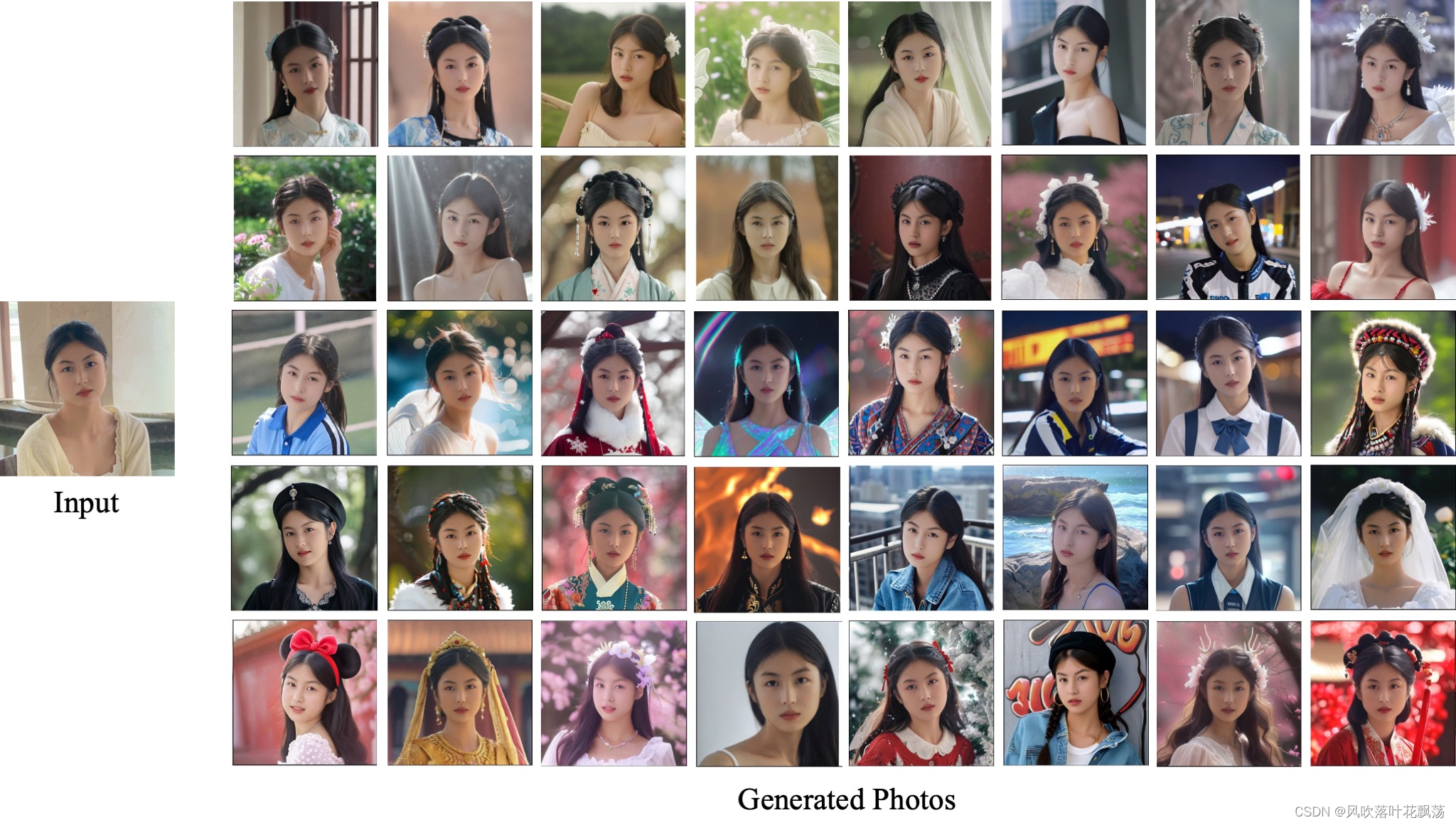

在FACT的加持下,FaceChain的人像生成体验又有了质的飞跃。

1.在生成速度方面,FaceChain-FACT成功摆脱了冗长繁琐的训练阶段,将定制人像的生成时间大幅缩短了百倍。现在,整个生成过程仅需10s左右,为用户带来了无比流畅的使用体验。

2.在生成效果方面,FaceChain-FACT成功提升了人脸的细腻程度,使其更加逼近真实的人像效果。通过高度保留的人脸细节信息,确保了生成写真效果既惊艳又自然。FaceChain海量的精美风格模版,又为生成的人像注入了艺术生命力。

?

?

?

FaceChain-FACT的诞生,将为用户开启前所未有的高质量AI写真体验。除了在生成速度与质量上的显著提升,FaceChain还提供丰富的API接口,让开发者可以根据自己的需求进行定制化开发。无论是想要创建自己的AI写真应用,还是在现有项目中集成FaceChain的功能,都可以轻松实现。我们深知创新与定制化的重要性,因此我们将不断探索和加入新的风格模版,以及更多有趣的功能。我们热忱欢迎对开源技术感兴趣的朋友们加入我们,共同引领AIGC文生图领域迈向崭新的时代!

4.参考

项目主页:FaceChain-fact:Face Adapter for Human AIGC

github项目:https://github.com/modelscope/facechain

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 【Python终端报错】“python.exe: can‘t open file”【及解决方法】

- SSL证书DV和OV的区别

- 无心剑中译卡明斯《从未游历之地》

- 从零开始:Crontab入门教程与实用技巧

- 3分钟了解Android中稳定性测试

- RabbitMQ 的基本概念

- 快速录制UI测试脚本,RunnerGo新上脚本录制器

- 锂电池SOC估计 | PatchTST时间序列模型锂电池SOC估计

- Pure Mathematics 4-Implicit Differentiation(隐函数求微分)

- 使用FFmpeg转换蓝光格式资源