深度学习14—注意力机制与自注意力机制

发布时间:2023年12月19日

注:以下均为个人学习笔记,发布只为方便学习阅读,若觉侵权,请联系删除!!?

1.李沐老师课堂学习理解笔记

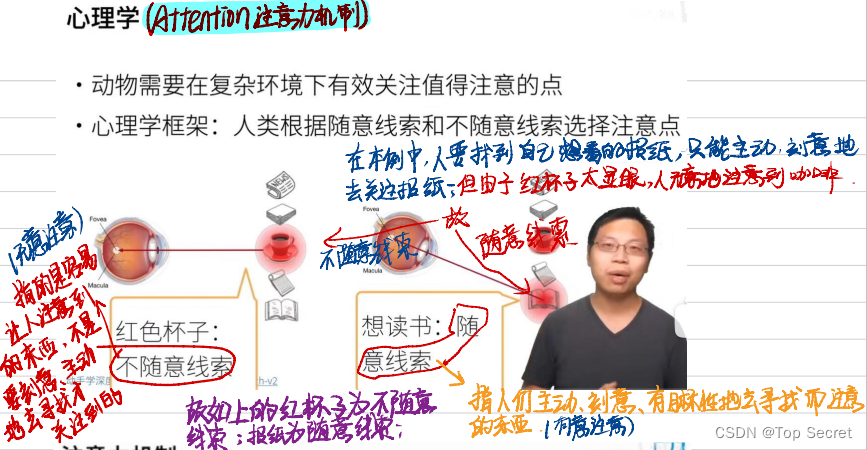

1.1 随意线索和不随意线索

1.2 注意力机制

通过注意力池化层来有偏向性的选择某些输入。

?

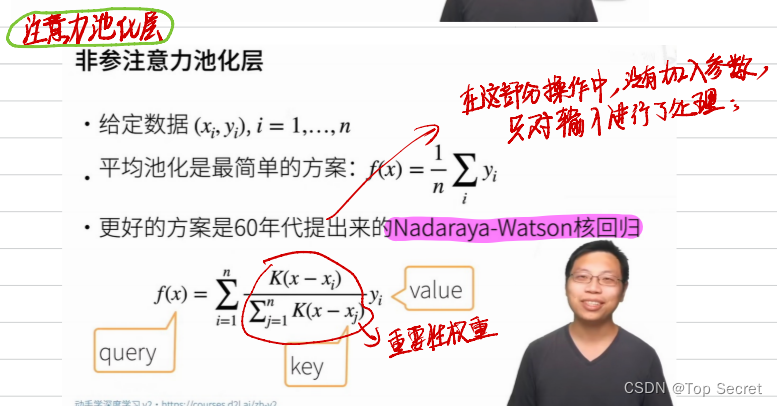

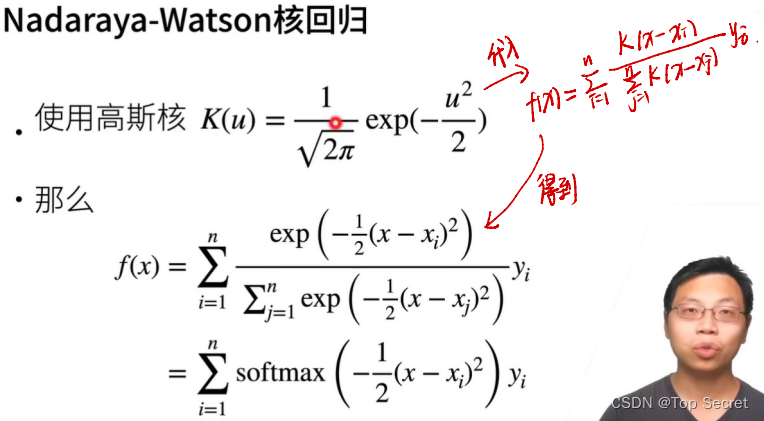

1.3 注意力池化层

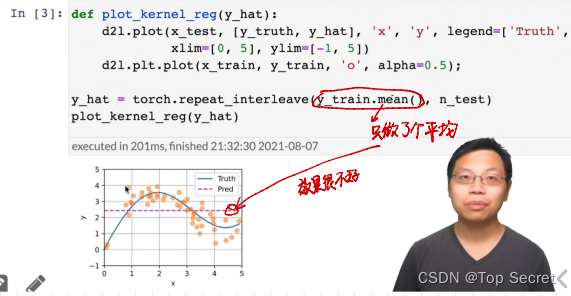

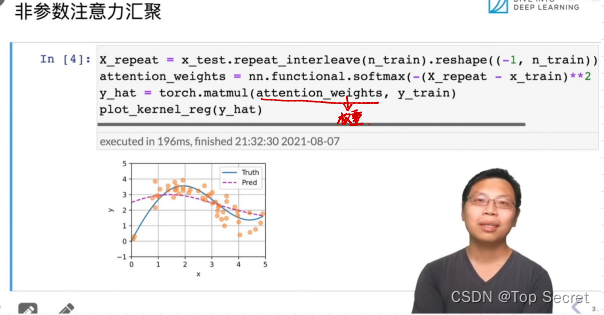

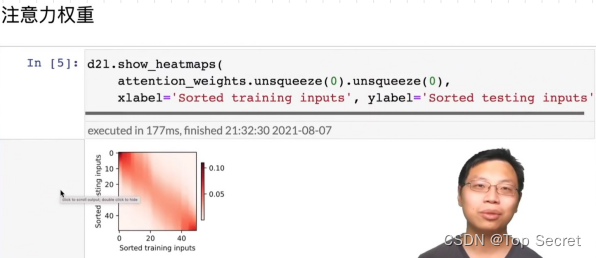

1.3.1 非参数化注意力机制

理解:Q(query)即为随意线索,可以通过对值V(value)做重要性加权得到。在这里,值V(value)和不随意线索K(key)是一个对。(对应关系)。

?

?

?

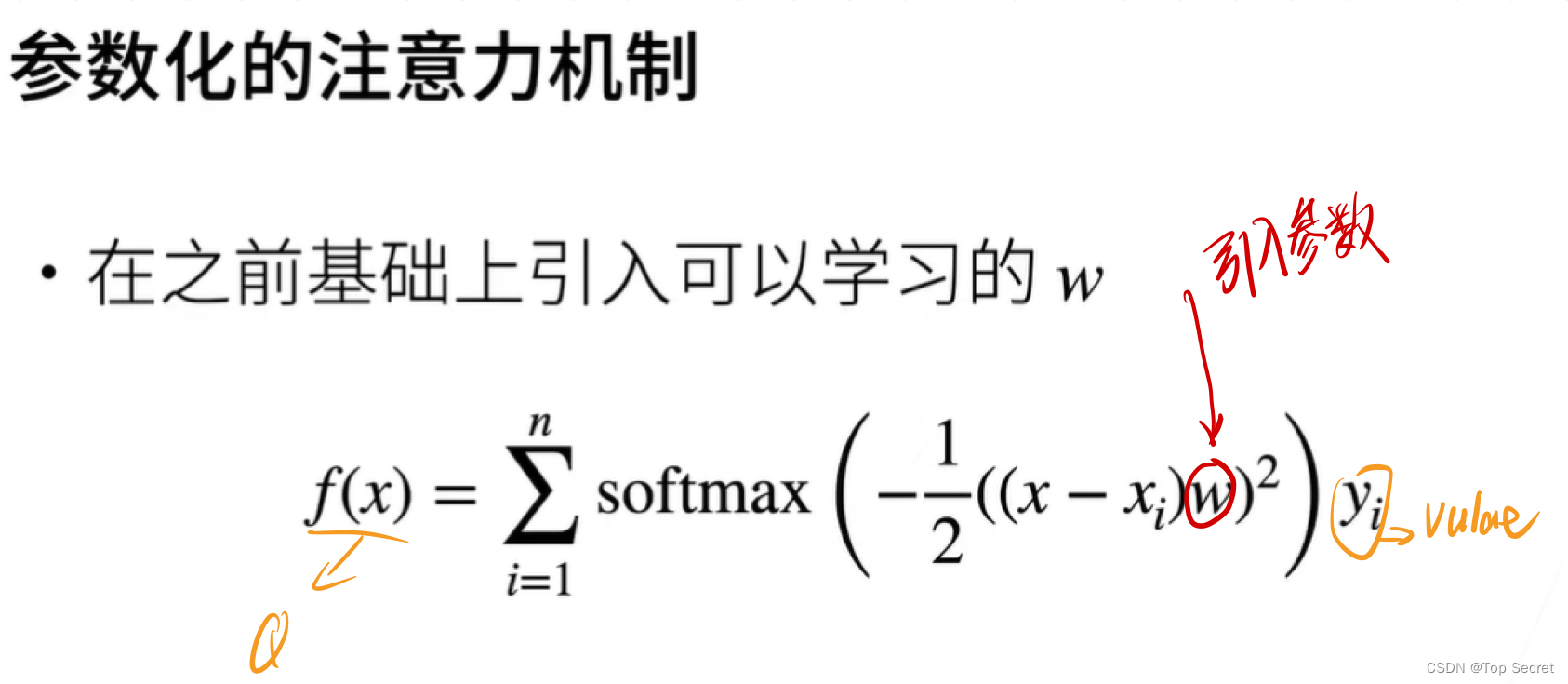

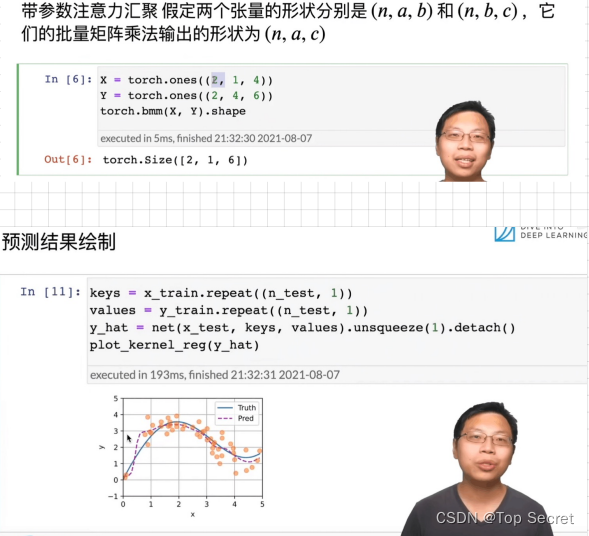

1.3.2 参数化的注意力机制

?1.4 总结

1.5 代码

?

?

?

?

?

?

?

?

?

?

?

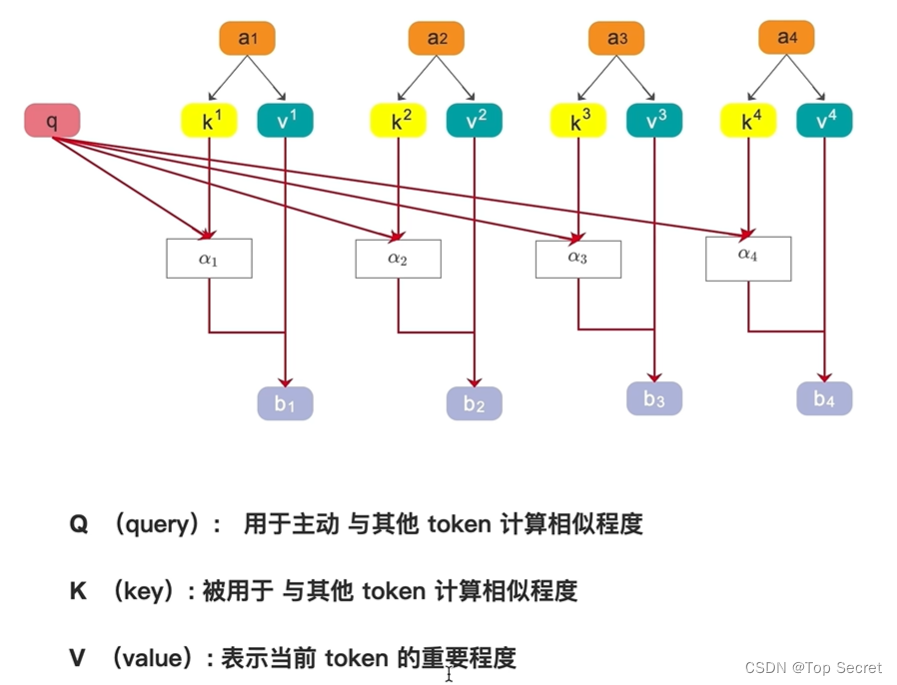

2.自注意机制(self-attention)?

2.1 Q,K,V的理解?

?

?

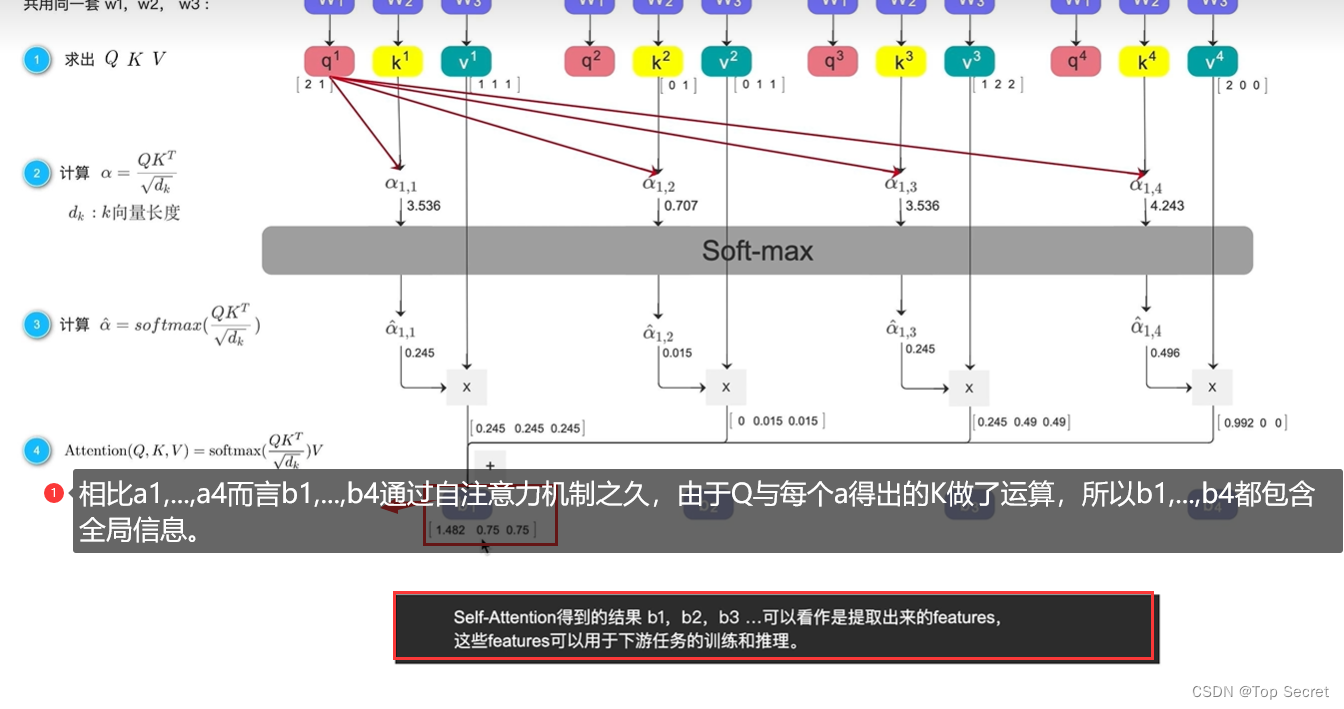

?2.2 Attention(Q,K,V)

?2.3 代码

?2.3 代码

?

?

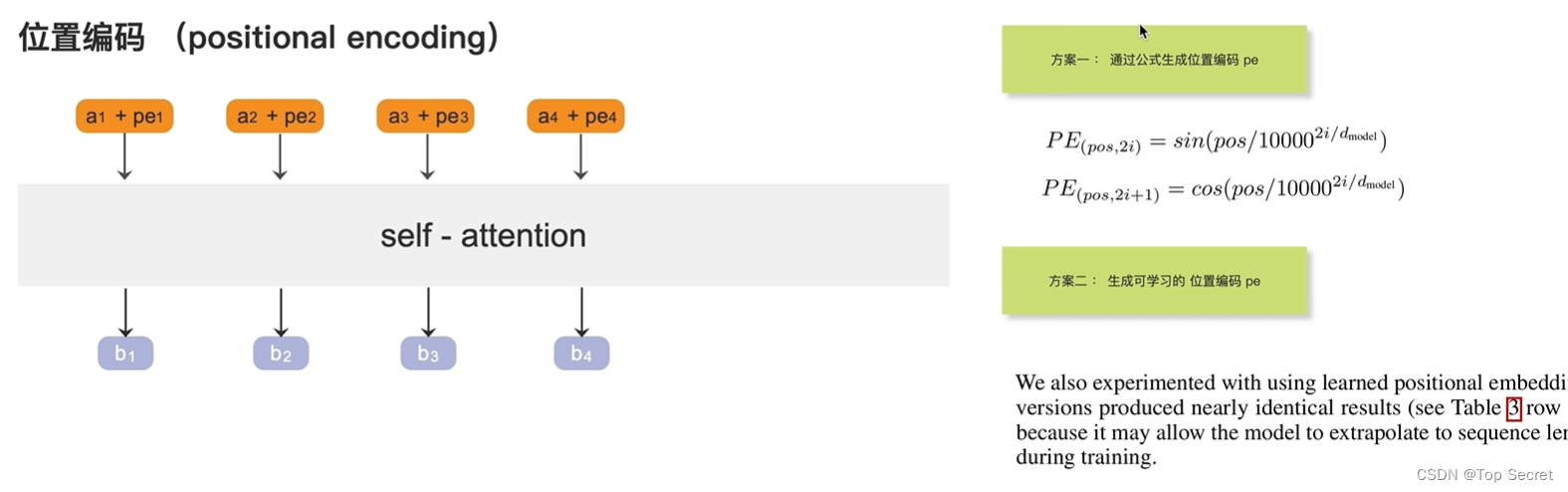

2.4 位置编码

?

?

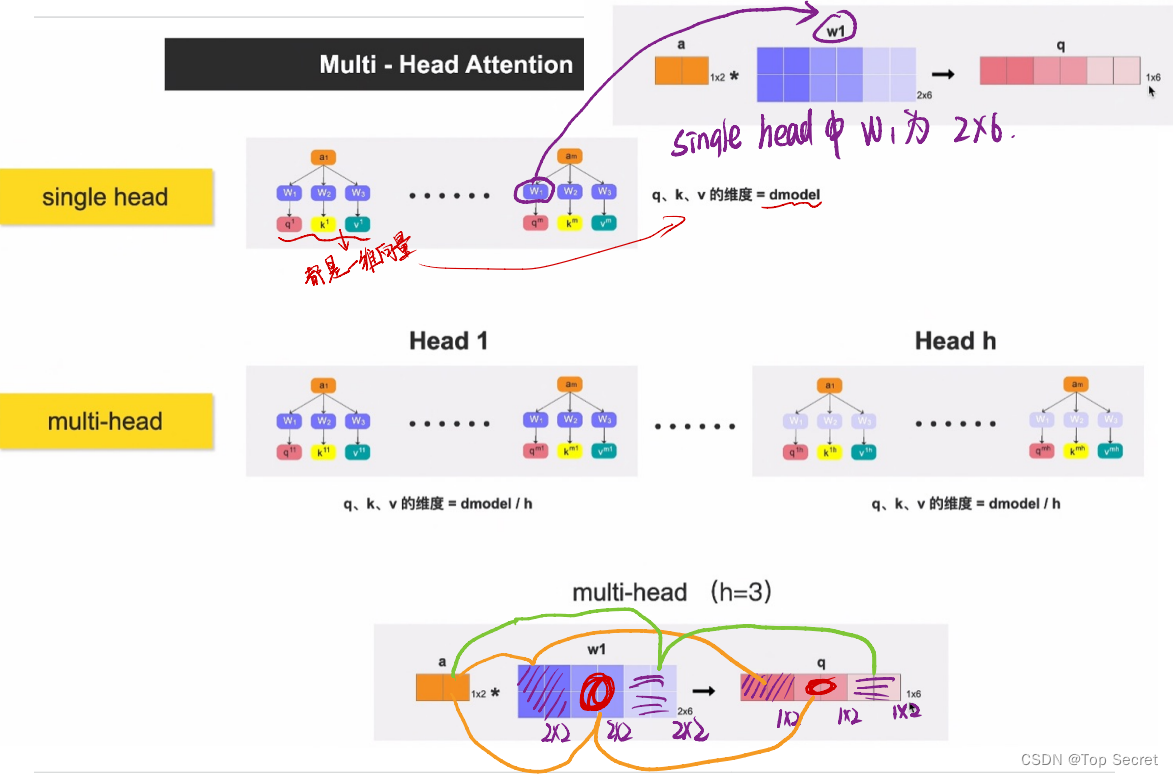

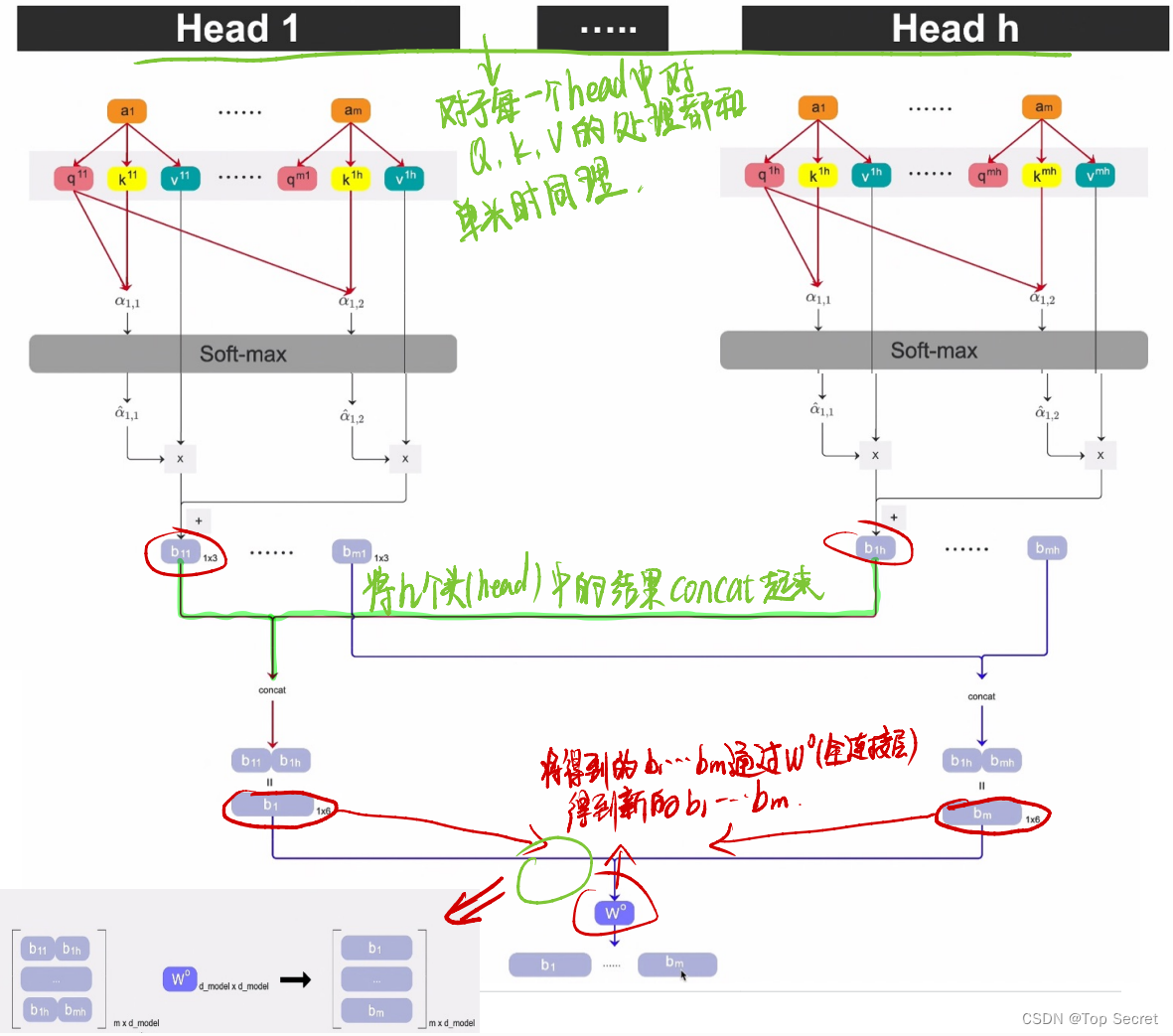

?2.5 多头注意力机制

?

?

文章来源:https://blog.csdn.net/m0_55196097/article/details/135054977

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章